文章目录

总览

| 数据集 | 发布年份 | 任务 | 数据模态 | 样本/场景数量 | 划分 (Train / Val / Test) | 说明 |

|---|---|---|---|---|---|---|

| KITTI Depth Completion | 2017 | 深度补全、单目深度预测 | RGB 图像 + 稀疏 LiDAR 深度 | 93 000 训练;1 000 验证;1 000 测试 | 93 000/1 000/1 000 | 将稀疏 LiDAR 投影生成半密集深度图,用于训练深度补全模型 |

| KITTI Stereo Evaluation 2015 | 2015 | 立体匹配、光流、场景流 | 校正双目图像 | 200 训练场景;200 测试场景 | 200/–/200 | 提供像素级视差和光流指标,以坏像素比评价算法性能 |

| Virtual KITTI 2 | 2020 | 跟踪、语义/实例分割、深度、光流 | 合成 RGB、深度、分割、光流、场景流 | 21 260 对双目立体图像 | 无固定划分 | 基于真实 KITTI 场景的合成克隆,支持多种天气和摄像机变体 |

| NYU-Depth V2 | 2012 | 室内场景分割、深度估计 | RGB + 深度(Kinect) | 1 449 标注对;407 024 未标注帧;464 场景 | 795/654/– | 使用 Kinect 捕获的室内视频序列,标注包含密集语义与实例标签 |

| Middlebury 2021 | 2021 | 立体匹配 | 高分辨率立体图像 | 11 场景 × 多视图 × 多光照/曝光(约20–22 对) | 无固定划分 | 实验室环境拍摄,提供结构光获取的精确真值视差 |

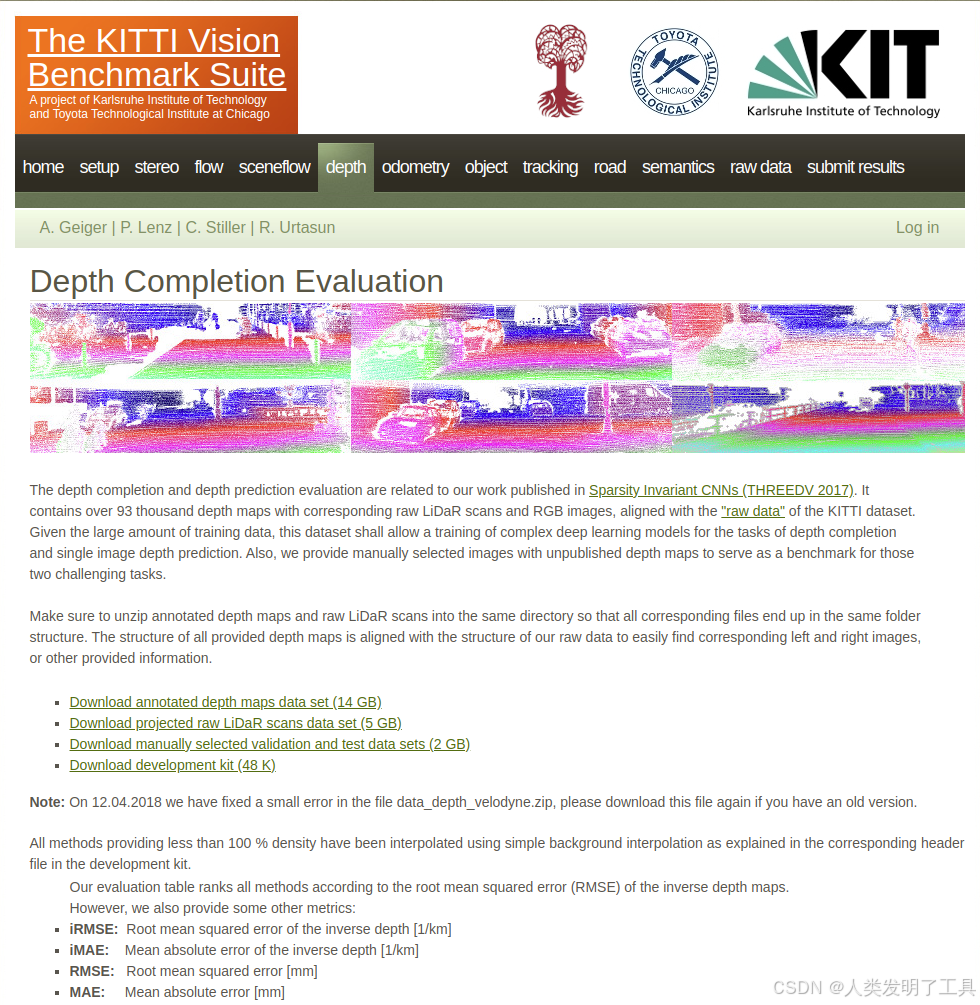

1. KITTI Depth Completion

1.1. 来源

由 Karlsruhe Institute of Technology 与 Toyota Technological Institute 发布于 KITTI Vision Benchmark Suite∶Depth Completion 基准

1.2. 采集场景

使用配备双目摄像头与 Velodyne HDL-64E 激光雷达的 Annieway 自动驾驶平台,在德国卡尔斯鲁厄市区街景中采集

1.3. 数据集内容

- 稀疏深度图:原始 LiDAR 点云投影到相机平面,约 5% 像素有深度值;

- RGB 图像:对应同步采集的高分辨率彩色图像。

数据格式如下(raw_data + annotated depth):

├── datasets

├── kitti_mono

├── 2011_09_26

├── 2011_09_26_drive_001_sync

├── image_00/ # 左前方灰度相机图像

│ ├── data/ # 图像文件(PNG 格式)

│ └── timestamps.txt # 每帧图像的时间戳

├── image_01/ # 右前方灰度相机图像

├── image_02/ # 左前方彩色相机图像

├── image_03/ # 右前方彩色相机图像

├── velodyne_points/ # 激光雷达点云数据

│ ├── data/ # 点云文件(.bin 格式)

│ └── timestamps.txt # 每帧点云的时间戳

├── oxts/ # GPS/IMU 数据

│ ├── data/ # 每帧的传感器数据(.txt 格式)

│ └── timestamps.txt # 每帧数据的时间戳

├── calib_cam_to_cam.txt # 相机之间的标定参数

├── calib_velo_to_cam.txt # 激光雷达到相机的标定参数

├── calib_imu_to_velo.txt # IMU 到激光雷达的标定参数

└── timestamps.txt # 整个序列的时间戳

├── train/ # 训练集

├── 2011_09_26_drive_0001_sync # 原始数据序列目录

├── proj_depth

├── groundtruth/ # 半稠密地面真实深度图

├── image_02/ # 左相机视角的深度图

└── image_03/ # 右相机视角的深度图

└── velodyne_raw/ # 从激光雷达投影的稀疏深度图

├── image_02/ # 左相机视角的稀疏深度图

└── image_03/ # 右相机视角的稀疏深度图

├── val

├── 2011_09_26_drive_0002_sync

├── proj_depth

├── groundtruth/

├── image_02/

└── image_03/

└── velodyne_raw/

├── image_02/

└── image_03/

| 内容 | 左前方 | 右前方 |

|---|---|---|

| 灰度相机图像 |  |  |

| 彩色相机图像 |  |  |

| 半稠密地面真实深度图 |  |  |

| 从激光雷达投影的稀疏深度图 |  |  |

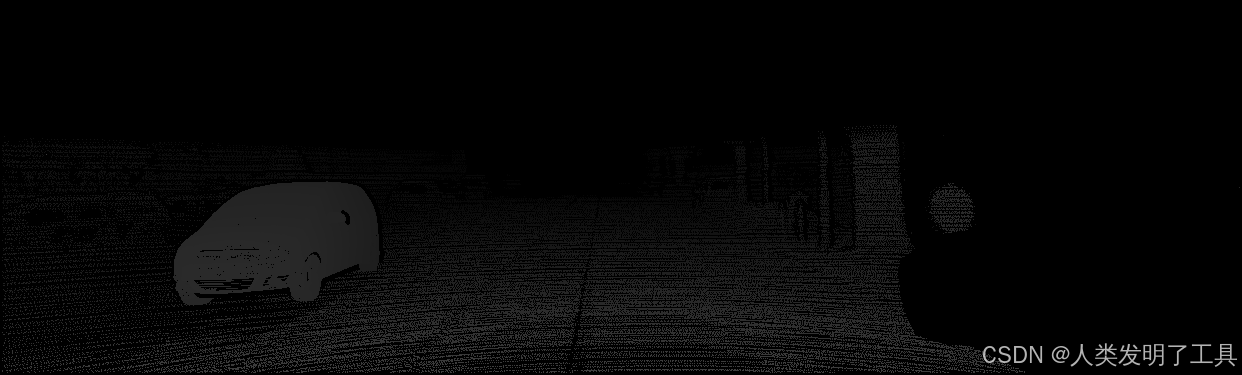

1.4. 标注内容

- 半密集深度:官方提供的注释深度图(annotated depth maps),对应于 LiDAR 与多张相机视图融合后生成的“半密集” ground truth。

其中一组数据的示例如下:

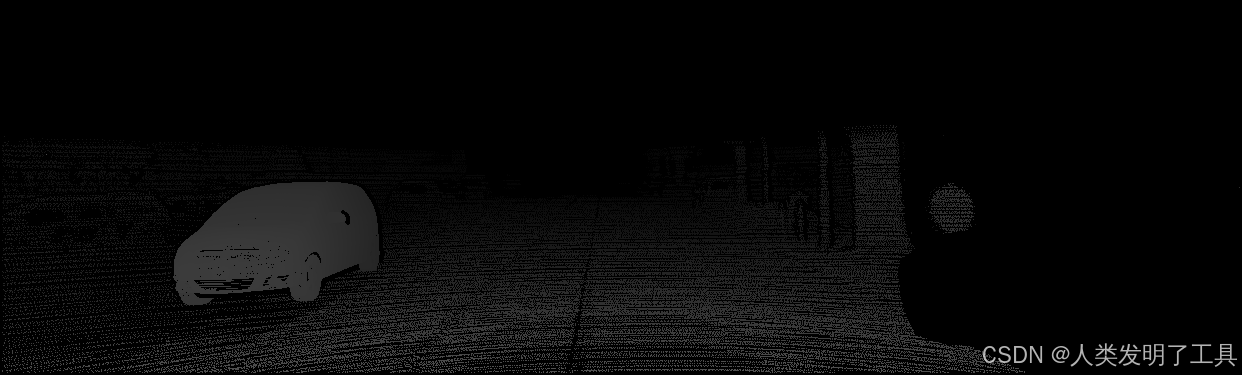

注释深度图(annotated depth maps):2011_09_26_drive_0001_sync/proj_depth/velodyne_raw/image_02/0000000005.png

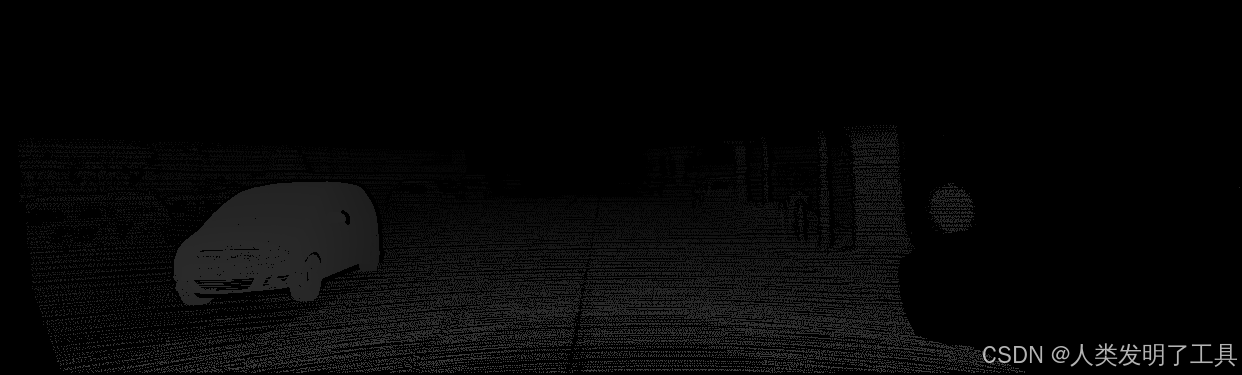

“半密集” ground truth:2011_09_26_drive_0001_sync/proj_depth/groundtruth/image_02/0000000005.png

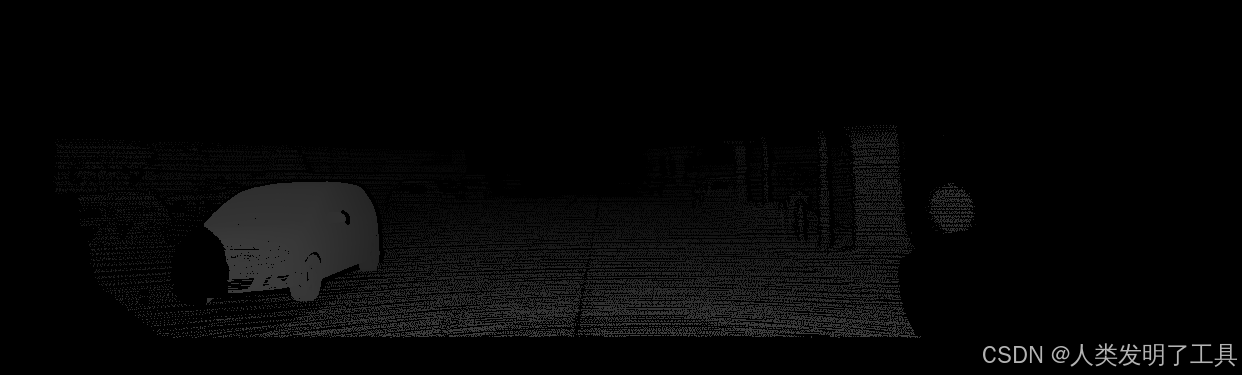

左前方RGB相机:2011_09_26/2011_09_26_drive_0001_sync/image_02/data/0000000005.png

1.5. 任务目标

- 深度补全(Depth Completion):从稀疏深度与(可选)RGB 引导图生成密集深度图;

- 单图深度预测(Depth Prediction):仅利用单张 RGB 图像预测深度。

1.6. 样本量

- 训练集:≈93 000 张;

- 验证集:1 000 张;

- 测试集:1 000 张。

1.7. 下载链接

- 官方基准主页:https://www.cvlibs.net/datasets/kitti/eval_depth.php?benchmark=depth_completion

- 深度标注数据在Depth Completion Evaluation界面的Download链接里下载;

- 原始的图像数据在Raw Data界面里使用官方提供的shell脚本下载,总共161个压缩包,总大小180+GB。

- 可以使用文章里的百度云链接下载

- 可以使用文章里的百度云链接下载

2. KITTI Stereo Evaluation 2015

2.1. 来源

同属 KITTI Vision Benchmark Suite 下的 Stereo / Flow / Scene Flow 2015 基准,由 Andreas Geiger 等人维护

2.2. 采集场景

与 Depth Completion 同平台采集,但专门选择含动态行人、车辆的街区路段,用于评测运动物体场景流

2.3. 数据集内容

- 图像对:200 个训练场景与 200 个测试场景,每场景 4 幅 PNG 无损图(左/右两帧×两时刻);

- 多帧扩展:可选 20 帧/场景的多视图扩展。

2.4. 标注内容

- 视差图:D1/D2 两时刻视差;

- 光流(Fl) 与 场景流(SF);

- 标定文件:内外参 calib.txt。

Kitti2015/

├── training/

│ ├── image_2/ # 左相机图像(左视图)

│ ├── image_3/ # 右相机图像(右视图)

│ ├── disp_occ_0/ # 左图视差图(包含遮挡区域)

│ ├── disp_occ_1/ # 右图视差图(包含遮挡区域)

│ ├── disp_noc_0/ # 左图视差图(不包含遮挡区域)

│ ├── disp_noc_1/ # 右图视差图(不包含遮挡区域)

│ ├── flow_occ/ # 光流图(包含遮挡区域)

│ ├── flow_noc/ # 光流图(不包含遮挡区域)

│ ├── calib/ # 相机标定文件

├── testing/

│ ├── image_2/ # 左相机图像(左视图)

│ ├── image_3/ # 右相机图像(右视图)

│ ├── calib/ # 相机标定文件

| 内容 | 左相机 | 右相机 |

|---|---|---|

| 图像 |  |  |

| 视差图(包含遮挡区域) |  |  |

| 视差图(不包含遮挡区域) |  |  |

| 光流图(包含遮挡区域) |  | - |

| 光流图(不包含遮挡区域) |  | - |

2.5. 任务目标

- 双目视差估计;

- 光流;

- 场景流联合评测(要求视差与光流精度同时满足阈值)。

2.6. 样本量

- 训练集:200 场景;

- 测试集:200 场景。

2.7. 下载链接

- 官方基准主页:https://www.cvlibs.net/datasets/kitti/eval_scene_flow.php?benchmark=stereo

- stereo、flow和sceneflow是同一个下载链接,在文章里面百度云链接有下载

- stereo、flow和sceneflow是同一个下载链接,在文章里面百度云链接有下载

3. Virtual KITTI2

3.1. 来源

由 Naver Labs Europe 提供的合成数据集 Virtual KITTI 2,基于 Unity 引擎重建 KITTI 跟踪序列

3.2. 采集场景

克隆 KITTI Tracking 基准的 5 条序列(Scene01、Scene02、Scene06、Scene18、Scene20),并引入不同天气(雾、雨)与相机旋转(±15°)变体

3.3. 数据集内容

- RGB 图像、深度图;

- 语义分割、实例分割;

- 光流、场景流;

- 相机参数 与 车辆位姿。

virtual_kitti2/

├── Scene01/ # 场景 01:拥挤的城市区域

│ ├── clone/ # 默认视角和天气的克隆版本

│ │ ├── frames/

│ │ │ ├── camera0/ # 左摄像头图像和标注

│ │ │ │ ├── rgb/ # RGB 图像(PNG 格式)

│ │ │ │ ├── depth/ # 深度图(PNG 格式)

│ │ │ │ ├── classSegmentation/ # 语义分割图(PNG 格式)

│ │ │ │ ├── instanceSegmentation/ # 实例分割图(PNG 格式)

│ │ │ │ ├── forwardFlow/ # 前向光流图(PNG 格式)

│ │ │ │ ├── backwardFlow/ # 后向光流图(PNG 格式)

│ │ │ │ ├── forwardSceneFlow/ # 前向场景流图(PNG 格式)

│ │ │ │ └── backwardSceneFlow/ # 后向场景流图(PNG 格式)

│ │ │ └── camera1/ # 右摄像头图像和标注

│ │ └── metadata/

│ │ ├── camera0.json # 左摄像头的相机参数和位姿信息

│ │ └── ... # 其他元数据文件

│ ├── fog/ # 雾天条件下的变体

│ │ └── ... # 结构同上

│ ├── morning/ # 清晨光照条件下的变体

│ │ └── ... # 结构同上

│ └── ... # 其他变体(如雨天、不同相机角度等)

├── Scene02/

│ └── ... # 结构同 Scene01

├── Scene06/

│ └── ... # 结构同 Scene01

├── Scene18/

│ └── ... # 结构同 Scene01

└── Scene20/

└── ... # 结构同 Scene01

| 内容 | 左相机 | 右相机 |

|---|---|---|

| RGB 图像 |  |  |

| 深度图 |  |  |

3.4. 标注内容

- 自动生成:所有标注通过模拟环境直接导出,精度高且无人工误差。

3.5. 任务目标

支持多种计算机视觉任务,如深度估计、目标检测、多目标跟踪、光流、场景流等

3.6. 样本量

- 基础序列:21 260 帧(与 VKITTI1 相当);

- 含变体:总帧数达 ∼100 000 级。

3.7. 下载链接

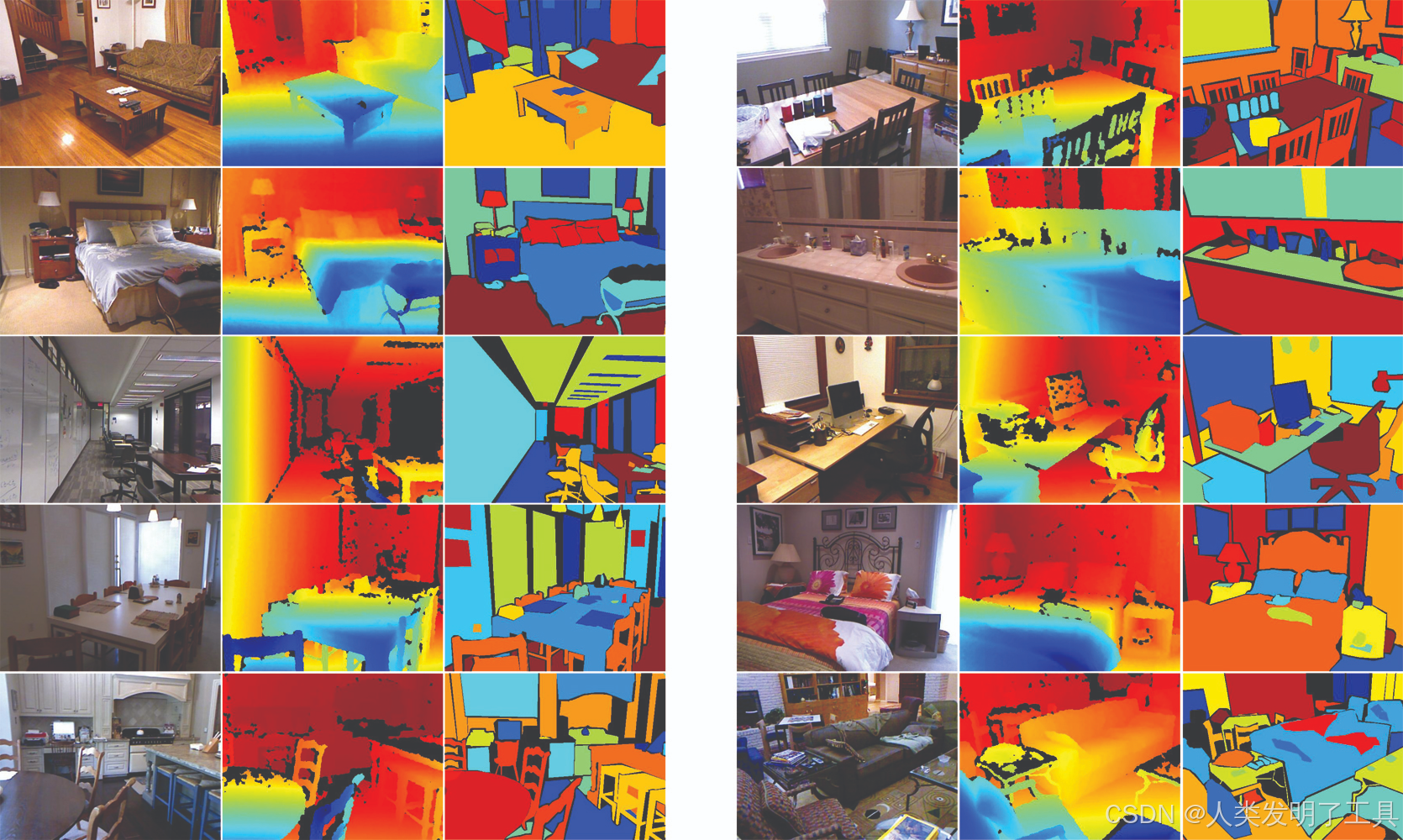

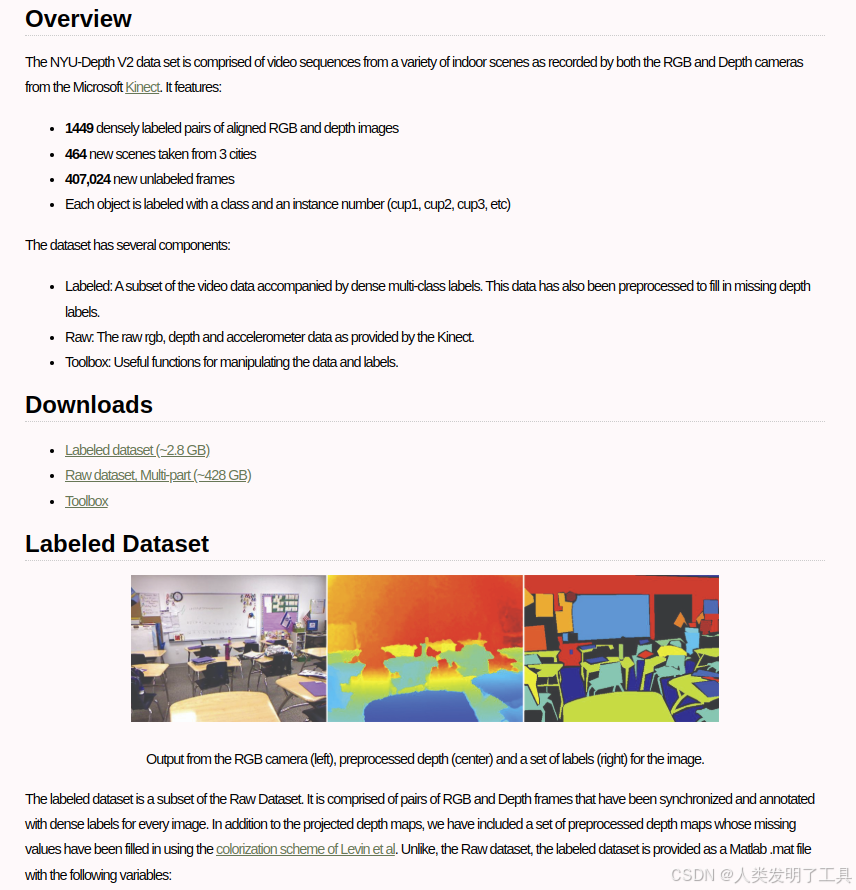

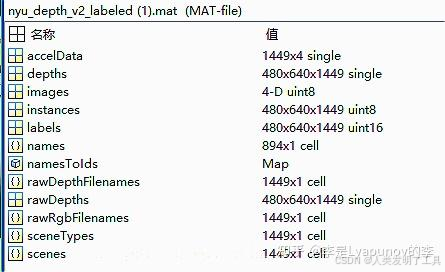

4. NYU Depth V2

4.1. 来源

由 NYU(Nathan Silberman 等)基于 Microsoft Kinect 发布的室内 RGB-D 数据集

4.2. 采集场景

同步采集自 3 个城市的 464 个不同室内场景(公寓、办公室、走廊等),20–30 FPS 视频序列。

4.3. 数据集内容

- 密集标注对:1 449 对对齐 RGB(640×480) 与深度图;

- 原始视频帧:407 024 未标注帧;

- 加速度计数据、时间戳。

nyu_depth_v2/

├── labeled/

│ ├── rgb/ # RGB 图像(PNG 格式)

│ ├── depth/ # 深度图(PNG 格式)

│ └── labels/ # 语义标签图(PNG 格式)

├── raw/ # 原始数据(未标注)

│ ├── rgb/ # RGB 图像

│ ├── depth/ # 深度图

│ └── accelerometer/ # 加速度计数据

└── toolbox/ # 数据处理工具箱

4.4. 标注内容

- 类别/实例标签:每个物体标注类别及实例编号(cup1、cup2…);

- 填补深度图:用色彩化方法修复丢失深度值。

参考文章:https://zhuanlan.zhihu.com/p/369079231

4.5. 任务目标

- 室内深度估计;

- 语义与实例分割;

- 场景理解与支持关系推理。

4.6. 样本量

-

Labeled Dataset(带标签的数据):

- 包含 1,449 对对齐的 RGB 图像和深度图。

- 每个图像都配有密集的多类别语义标签。

- 深度图经过预处理,填补了缺失的深度值。

- 每个对象被标注为特定类别和实例编号(例如:cup1、cup2 等)。

-

Raw Dataset(原始数据/未标注帧):

- 包含 407,024 帧未标注的 RGB、深度图和加速度计数据。

- 数据采集自 464 个不同的室内场景,涵盖 3 个城市。

- RGB 和深度摄像头的采样率在 20 至 30 FPS 之间。

-

Toolbox(工具箱):

- 提供用于处理数据和标签的实用函数。

4.7. 下载链接

- 官方主页:https://cs.nyu.edu/~fergus/datasets/nyu_depth_v2.html

- 下载的标注结果文件是mat格式,需要解析出图片和标注结果。

- 下载的标注结果文件是mat格式,需要解析出图片和标注结果。

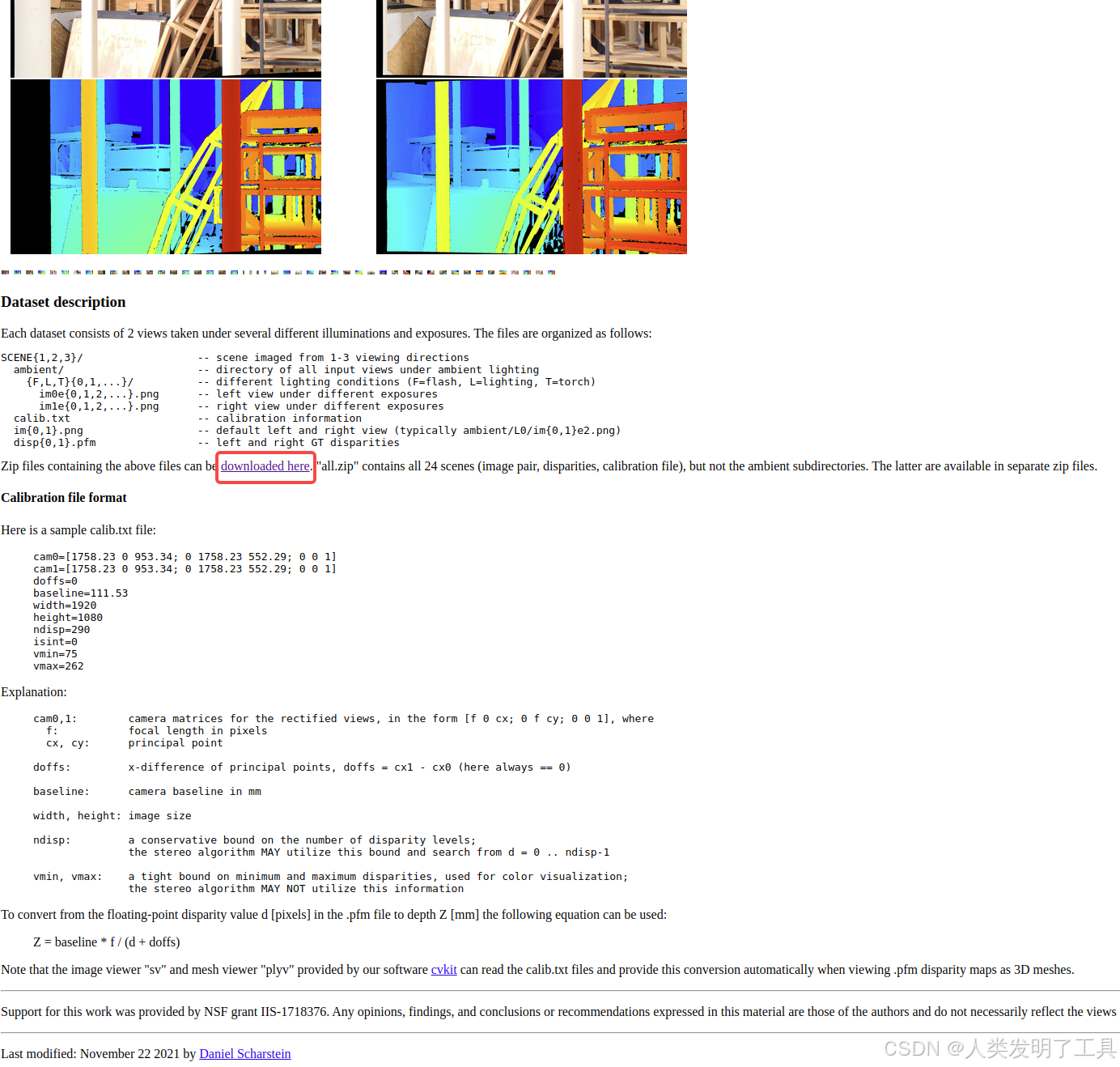

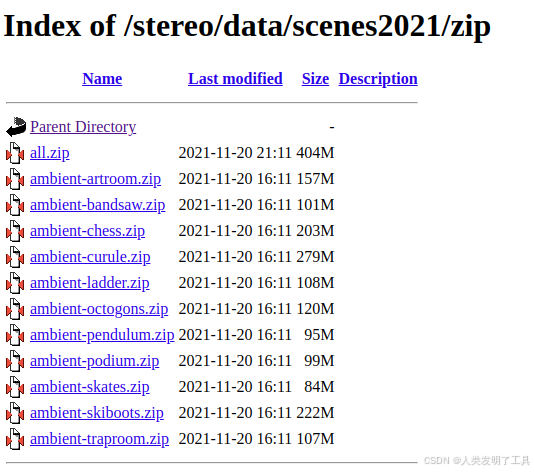

5. Middlebury Stereo 2021

5.1. 来源

由 Middlebury College Computer Vision Lab 发布的高精度立体匹配基准(Scenes2021)

5.2. 采集场景

11 个场景(Artroom、Bandsaw、Chess、Curule、Octogons、Pendulum、Skates、Skiboots、Traproom、Ladder、Podium),每场景 1–3 个视角;多种环境光照与曝光(Flash、Lighting、Torch)

5.3. 数据集内容

- 左右视图:多曝光下的 PNG 图像;

- 20% 分辨率预览及完整版多兆像素图;

- PFM 格式视差图 disp0.pfm/disp1.pfm。

5.4. 标注内容

- 亚像素级视差:由结构化光系统获取的高精度 ground truth;

- calib.txt:相机内外参标定。

5.5. 任务目标

立体匹配精度评测,重点考察复杂几何与光照条件下算法鲁棒性。

5.6. 样本量

- 场景数:11;

- 视角数:1–3;

- 曝光/光照条件:多种。

5.7. 下载链接

6. MS²(Multi-Spectral Stereo)

6.1. 来源

由韩国科学技术院(KAIST)的研究团队采集,并在 CVPR 2023 论文《Deep Depth Estimation from Thermal Image》中首次发布。

6.2 采集场景

数据采集于城市、住宅区、公路、校园和郊区等多种户外环境,涵盖清晨、白天和夜晚的不同时间段,以及晴天、多云和雨天等多种天气条件。

6.3. 数据集内容

MS2dataset/

├── sync_data/ # 同步的原始数据,包括图像、LiDAR、导航信息等

│ └── <Sequence Name>/ # 每个序列的文件夹

│ ├── rgb/ # 校正后的左/右 RGB 图像

│ ├── nir/ # 校正后的左/右 NIR 图像

│ ├── thr/ # 校正后的左/右热成像图像(uint16 原始值)

│ ├── lidar/ # 同步的 LiDAR 点云数据(.mat 格式)

│ ├── gps_imu/ # GPS/IMU 导航数据

│ ├── calib.npy # 所有传感器的内外参矩阵

│ └── readme.txt # 序列说明

├── proj_depth/ # 投影深度图

│ └── <Sequence Name>/

│ ├── rgb/

│ ├── nir/

│ └── thr/

│ ├── depth/ # 单帧 LiDAR 投影深度图(uint16)

│ ├── intensity/ # 单帧 LiDAR 投影强度图(uint8)

│ ├── depth_multi/ # 多帧合并的深度图(uint16)

│ ├── intensity_multi/ # 多帧合并的强度图(uint8)

│ └── depth_filtered/ # 滤波后的深度图(uint16)

└── odom/ # 里程计数据

└── <Sequence Name>/

├── rgb/

├── nir/

├── thr/

└── lidar/

└── poses.txt # 每帧的 [R|t] 3x4 位姿矩阵

6.4. 标注内容

-

图像数据:RGB、NIR 和热成像图像均为校正后的立体图像对,分辨率分别为 1224×384、1280×352 和 640×256。

-

深度图:通过将 LiDAR 点云投影到各个图像平面生成,单位为毫米,存储为 uint16 格式,需除以 256 以获得实际深度值。

-

里程计数据:提供每帧在各传感器坐标系下的位姿信息,格式为 3x4 的 [R|t] 矩阵。

6.5. 任务目标

- 深度估计

- 视觉里程计(Visual Odometry)

- 深度补全(Depth Completion)

- 热成像图像分割(Thermal Image Segmentation)

- 立体深度估计(Stereo Depth Estimation)

- 深度预测(Depth Prediction)

6.6. 样本量

MS² 数据集包含约 184,000 对同步的多模态数据

5699

5699

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?