使用Python爬取喜欢的小说后在本地存储为txt文件

最近在看小说时因为是在手机上在线观看,百度了半天也没找到可以下载的txt全集,实在没办法只好借助python来帮我完成需求!

准备爬取的小说名称 萧阳叶云舒

目标小说网站 https://www.ly990.com/

准备工具:pycharm

chrome 谷歌浏览器(其它浏览器亦可,谷歌最佳)

python3.7 环境

依赖第三方包: requests BeautifulSoup

如果没有requests包

pip install requests

pip install beautifulsoup4

第一步:先获取所有章节以及所有章节的链接

按F12即可出现开发者界面

第二步:刷新界面后,点击Network

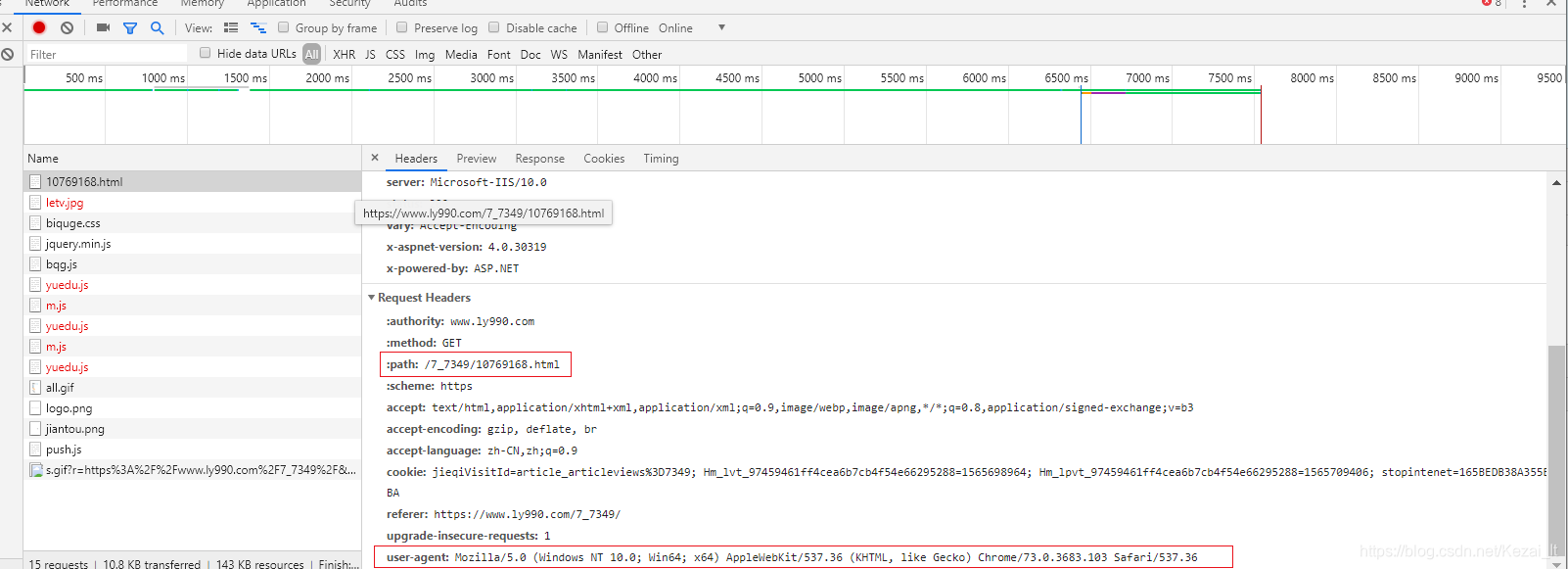

接下来整理思路 我们只要获取所有的章节以及所有章节的子链接,然后我们循环去请求每个章节(请求头中需要设置path,user-agent等),然后以追加的方式进行写入不就可以实现完整小说的爬取了么?

话不多收直接上代码

代码如下

# coding:utf-8

import re

import os

import time

import random

import requests

from bs4 import BeautifulSoup

def get_contents():

# 请求头

headers = {

'authority': 'www.ly990.com',

'method': 'GET',

'path': '/7_7349/',

'scheme': 'https',

'accept': 'text/html,application/xhtml+xml,application/xml;q=0.9,'

'image/webp,image/apng,*/*;q=0.8,application/signed-exchange;v=b3',

'accept-encoding': 'gzip, deflate, br',

'accept-language': 'zh-CN,zh;q=0.9',

'referer': 'https://www.ly990.com/7_7349/5975618.html',

'upgrade-insecure-requests': '1',

'user-agent': "Mozilla/5.0 (Windows NT 10.0; Win64; x64) "

"AppleWebKit/537.36 (KHTML, like Gecko) Chrome/73.0.3683.103 Safari/537.36"

本文介绍了使用Python爬虫从特定小说网站抓取小说内容,并将其保存为本地txt文件的步骤。详细讲解了如何获取章节链接、使用BeautifulSoup解析HTML以及设置请求头进行网络请求。最后展示了运行效果。

本文介绍了使用Python爬虫从特定小说网站抓取小说内容,并将其保存为本地txt文件的步骤。详细讲解了如何获取章节链接、使用BeautifulSoup解析HTML以及设置请求头进行网络请求。最后展示了运行效果。

最低0.47元/天 解锁文章

最低0.47元/天 解锁文章

9102

9102

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?