深度学习之NLP学习笔记(七)— Transformer复杂度分析

最新推荐文章于 2025-10-17 17:41:19 发布

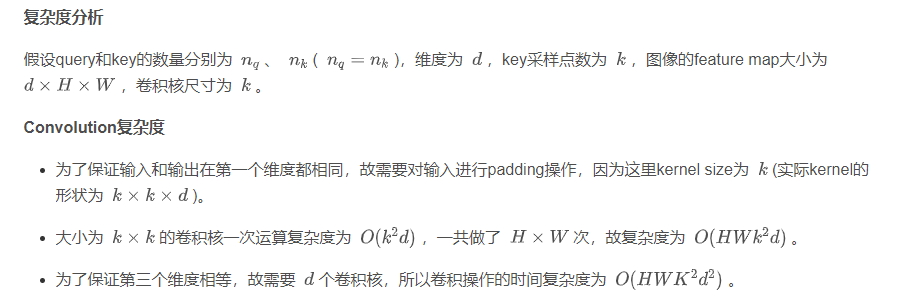

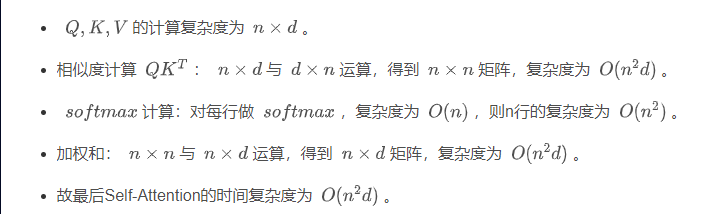

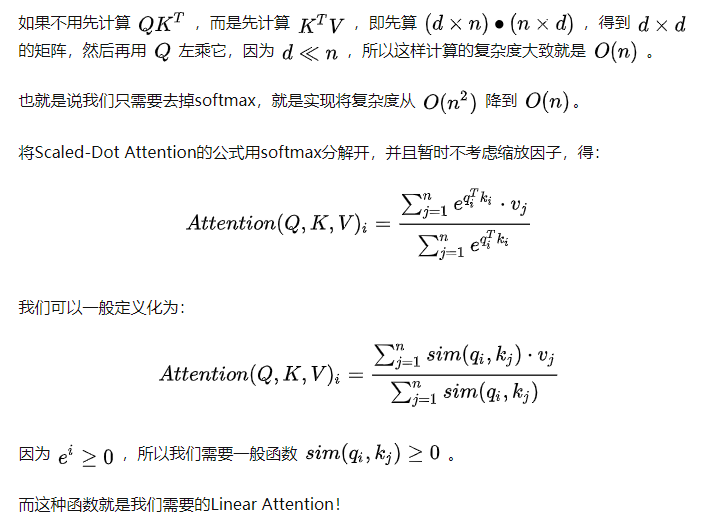

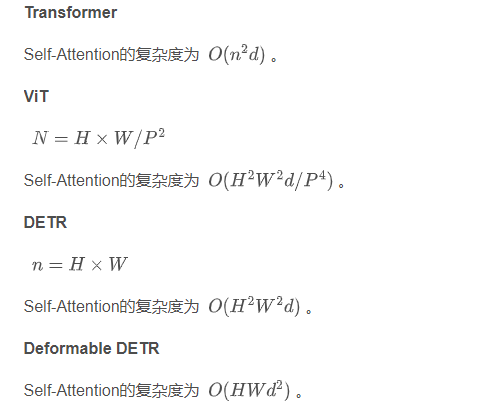

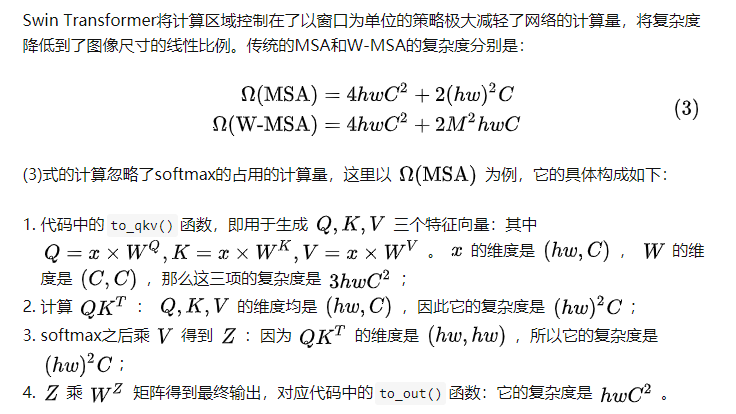

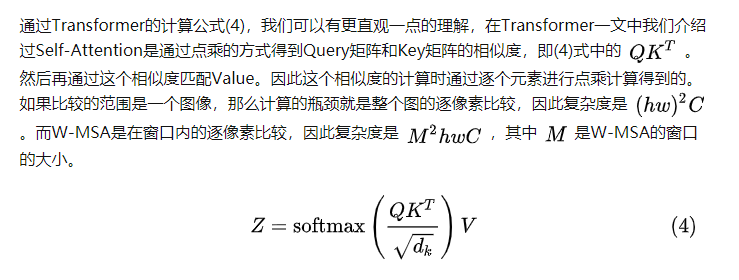

本文深入探讨了自注意力机制(Self-Attention)的复杂度,并介绍了线性注意力的概念及其在Transformer模型中的应用,包括多头自注意力(MSA)和窗口多头自注意力(W-MSA)等。

本文深入探讨了自注意力机制(Self-Attention)的复杂度,并介绍了线性注意力的概念及其在Transformer模型中的应用,包括多头自注意力(MSA)和窗口多头自注意力(W-MSA)等。

部署运行你感兴趣的模型镜像

您可能感兴趣的与本文相关的镜像

TensorFlow-v2.9

TensorFlow

TensorFlow 是由Google Brain 团队开发的开源机器学习框架,广泛应用于深度学习研究和生产环境。 它提供了一个灵活的平台,用于构建和训练各种机器学习模型

1565

1565

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?