MongoDB 数据库使用指南

MongoDB 是一款开源的 NoSQL 数据库,以其灵活性、高性能和可扩展性著称。它采用文档型数据模型(基于 BSON 格式),特别适合处理半结构化或动态变化的数据。本指南将逐步引导您从安装到基本查询操作,帮助您快速上手 MongoDB。参考站内资源,确保内容真实可靠。

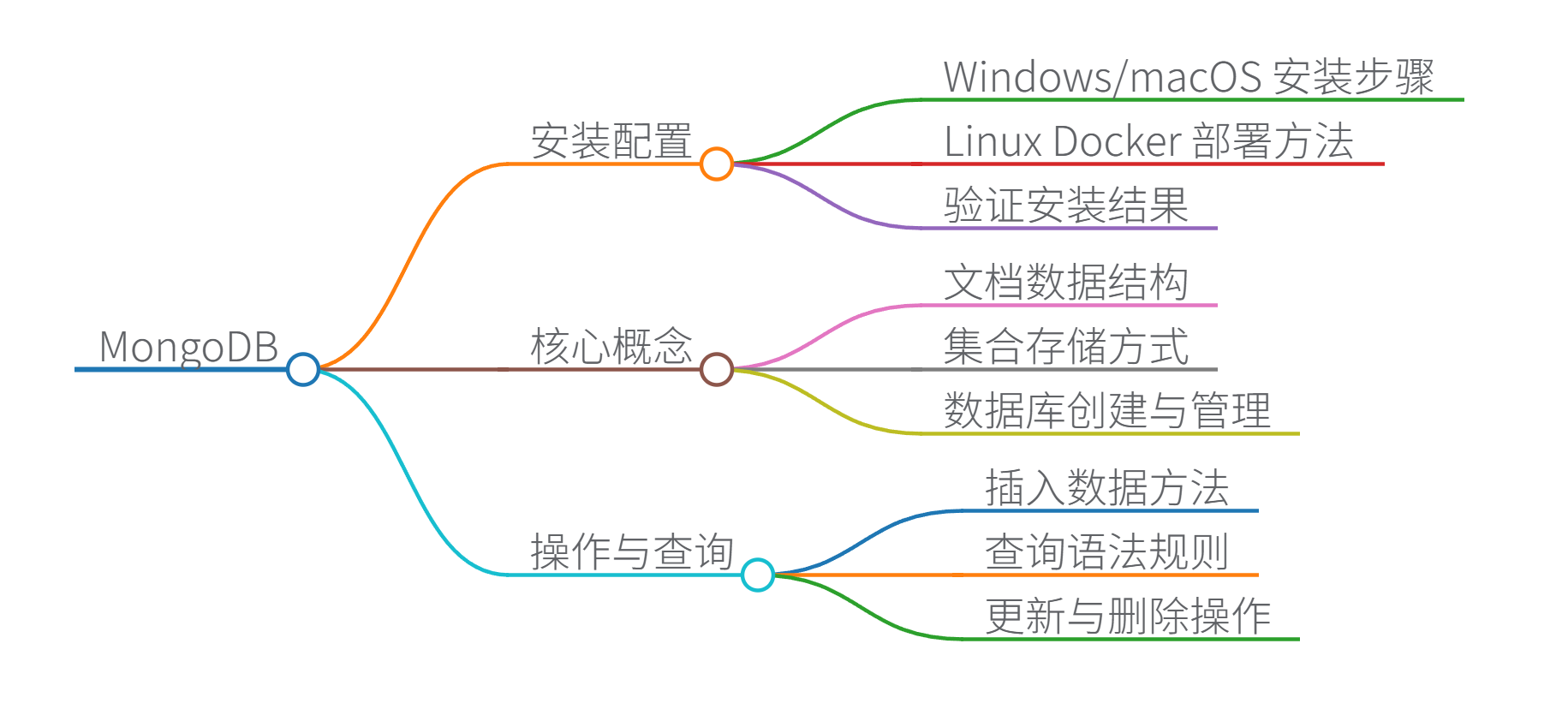

1. 安装 MongoDB

安装是使用 MongoDB 的第一步。以下是常见平台的安装方法:

-

Windows/macOS 安装:

- 访问 MongoDB 官网下载安装包。

- 运行安装程序,并设置环境变量。

- 启动 MongoDB 服务:在终端输入

mongod启动服务器,然后打开另一个终端输入mongo进入命令行界面。

参考快速搭建指南中的详细步骤。

-

Linux 使用 Docker 部署(推荐):

- 安装 Docker:运行

sudo apt-get install docker.io。 - 拉取 MongoDB 镜像:

docker pull mongo。 - 创建并启动容器:

docker run -d --name mongo-container -p 27017:27017 mongo。 - 本地测试连接:使用

mongo命令或 MongoDB Compass GUI 工具连接localhost:27017。

此方法简化了环境配置,支持快速远程访问设置。

- 安装 Docker:运行

安装完成后,验证:运行 mongo --version 查看版本信息。

2. 基本概念和设置

MongoDB 的核心是文档(Document)和集合(Collection),区别于传统关系型数据库的表结构:

- 文档:数据存储的基本单位,类似 JSON 对象,但使用 BSON(Binary JSON)格式存储,支持嵌套数据。例如:

{ "name": "张三", "age": 30, "address": { "city": "北京" } }。 - 集合:一组文档的容器,相当于表。一个数据库可包含多个集合。

- 数据库:创建新数据库:在 mongo shell 中运行

use mydb(如果 mydb 不存在,则首次插入数据时自动创建)。

参考基础指南,了解 MongoDB 的灵活数据模型设计。

3. 基本操作:CRUD 和查询

MongoDB 使用 JavaScript-like 语法进行操作。以下是在 mongo shell 中的常见命令:

- 插入数据:

db.users.insertOne({ name: "李四", age: 25 }); // 插入单个文档 db.users.insertMany([{ name: "王五" }, { name: "赵六" }]); // 插入多个文档 - 查询数据:

- 基本查询:使用

find()方法。db.users.find({ age: { $gt: 20 } }); // 查询年龄大于20的文档 - 投影(选择字段):

db.users.find({}, { name: 1 });// 只返回 name 字段。 - 条件运算符:如

$eq(等于)、$lt(小于)、$in(在列表中)。例如:db.users.find({ age: { $in: [25, 30] } });。

- 基本查询:使用

- 更新数据:

db.users.updateOne({ name: "李四" }, { $set: { age: 26 } }); // 更新单个文档 - 删除数据:

db.users.deleteOne({ name: "王五" }); // 删除匹配文档

查询是 MongoDB 的核心,支持高效过滤。参考学习指南中的聚合管道和地理空间查询等高级功能。

4. 高级查询和优化

- 聚合管道:用于复杂数据分析,如分组和统计。

db.users.aggregate([ { $match: { age: { $gt: 20 } } }, // 过滤 { $group: { _id: "$city", count: { $sum: 1 } } } // 按城市分组计数 ]); - 索引优化:加速查询。创建索引:

db.users.createIndex({ name: 1 });(1 表示升序)。 - 远程访问设置:在 Linux 中,使用内网穿透工具(如 frp)实现公网访问。参考部署指南中的步骤。

- 错误处理:如果数据库损坏,可使用修复命令

mongod --repair,或参考修复指南中的详细方法。

5. 最佳实践

- 安全性:启用身份验证:启动 mongod 时添加

--auth参数,并创建用户。 - 性能监控:使用

db.stats()查看数据库状态,或工具如 MongoDB Atlas 进行云管理。 - 备份和恢复:运行

mongodump备份数据,mongorestore恢复数据。

通过本指南,您已掌握 MongoDB 的安装、基本操作和查询核心。MongoDB 适用于博客数据存储、实时分析等场景,得益于其灵活架构。实践时,建议结合官方文档和社区资源深入学习。

思维导图

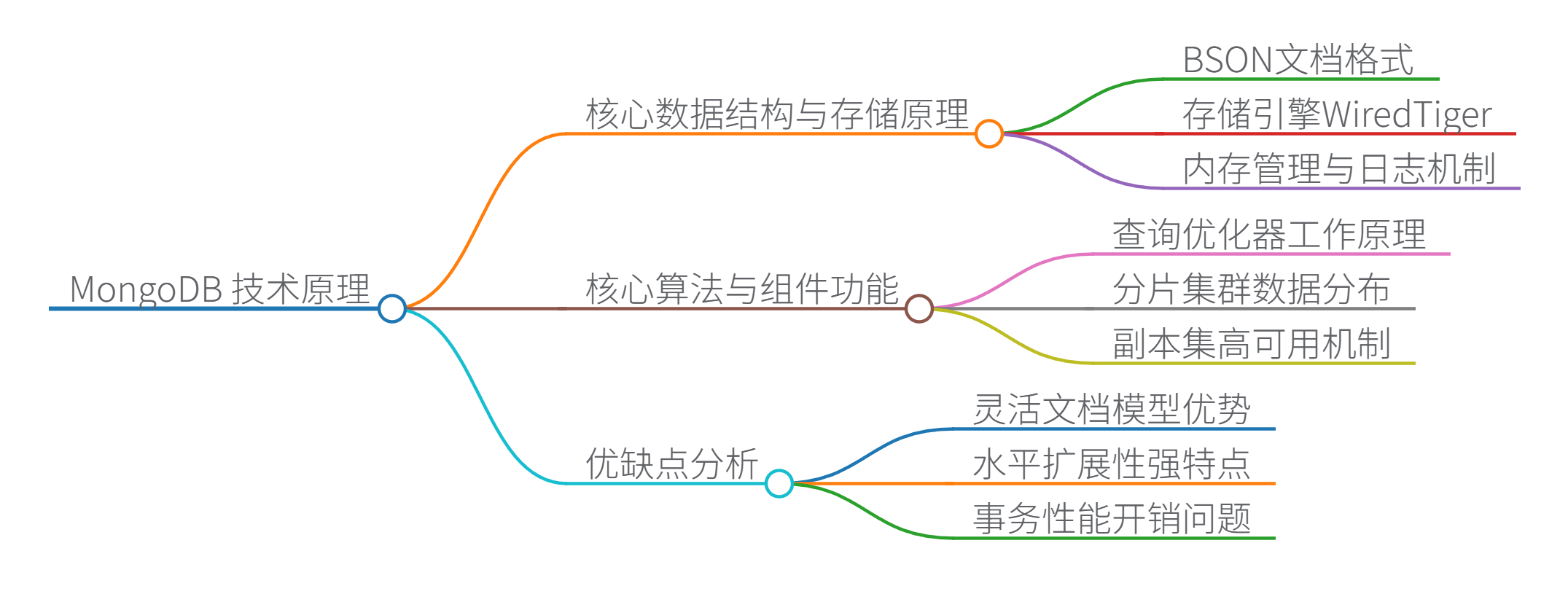

MongoDB 技术原理详解

一、核心数据结构与存储原理

-

BSON 文档格式

MongoDB 使用 BSON(Binary JSON) 作为基础数据结构,在 JSON 基础上扩展了二进制数据类型(如日期、二进制数据等)。- 数据结构示例:

{ _id: ObjectId("507f1f77bcf86cd799439011"), // 12字节唯一ID(时间戳+机器ID+进程ID+计数器) name: "张三", age: 30, address: { // 嵌套文档 city: "北京", geo: [116.40, 39.90] // 数组类型 } }

- 数据结构示例:

-

存储引擎(WiredTiger)

- 数据结构:使用 B+树 存储索引,叶子节点直接包含数据指针(默认配置)

- 索引键:

B+树键值→磁盘位置

- 索引键:

- 内存管理:

- 采用 MVCC(多版本并发控制),读写操作不互斥

- 使用 Snappy/Zlib 压缩 减少磁盘占用(可配置)

- 日志机制:预写日志(Write-Ahead Log)确保崩溃恢复

- 数据结构:使用 B+树 存储索引,叶子节点直接包含数据指针(默认配置)

二、核心算法与组件功能

| 组件 | 算法/功能 | 技术原理 |

|---|---|---|

| 查询优化器 | 基于代价的优化(CBO) | 生成多个候选查询计划,通过试运行选择最快路径(explain()可查看) |

| 分片集群 | 一致性哈希分片 | 数据按分片键(Shard Key)自动分布,mongos路由查询到目标分片 |

| 副本集 | Raft 选举协议 | 自动主节点选举(Primary),数据复制到 Secondary 节点(最终一致性) |

| 聚合管道 | 分阶段流式处理 | 管道操作符($match, $group, $sort)组合实现类 MapReduce 功能 |

三、关键技术原理

-

索引机制

- B+树索引:支持高效范围查询(时间复杂度 O(logn)O(\log n)O(logn))

- 多键索引:为数组字段的每个元素创建独立索引项

- 地理空间索引:使用 GeoHash 算法 将二维坐标转换为一维字符串

-

事务实现(ACID)

- 多文档事务(4.0+)基于 快照隔离(Snapshot Isolation)

- 两阶段提交(2PC)保证跨分片事务一致性

-

内存映射文件

- 将磁盘文件映射到内存,由操作系统管理页缓存(Page Cache)

- 高频访问数据常驻内存,提升读取性能

四、优缺点分析

| 优势 | 劣势 |

|---|---|

| ✅ 灵活文档模型(动态增减字段) | ❌ 多表关联查询弱(需应用层或$lookup实现) |

| ✅ 水平扩展性强(自动分片) | ❌ 事务性能开销较大(相比OLTP数据库) |

| ✅ 高性能读写(内存映射+压缩) | ❌ 内存消耗较高(建议预留50%内存) |

| ✅ 内置高可用(副本集自动故障转移) | ❌ 不支持SQL标准语法 |

五、Java 示例代码(含中文注释)

import com.mongodb.client.*;

import com.mongodb.client.model.*;

import org.bson.Document;

import java.util.Arrays;

public class MongoDBDemo {

public static void main(String[] args) {

// 1. 连接MongoDB(默认端口27017)

try (MongoClient client = MongoClients.create("mongodb://localhost:27017")) {

// 2. 获取数据库(不存在则自动创建)

MongoDatabase db = client.getDatabase("testDB");

// 3. 获取集合(类似SQL的表)

MongoCollection<Document> users = db.getCollection("users");

// 4. 插入文档(自动生成_id)

Document user1 = new Document("name", "张三")

.append("age", 30)

.append("tags", Arrays.asList("工程师", "摄影")); // 数组字段

users.insertOne(user1);

// 5. 创建索引(加速age字段查询)

users.createIndex(Indexes.ascending("age"));

// 6. 查询文档(使用Bson过滤器)

Document query = new Document("age", new Document("$gt", 25)); // age>25

FindIterable<Document> results = users.find(query);

for (Document doc : results) {

System.out.println(doc.toJson()); // 输出BSON为JSON

}

// 7. 更新文档(原子操作)

users.updateOne(

Filters.eq("name", "张三"),

Updates.set("age", 31) // 设置age=31

);

// 8. 聚合查询(统计各年龄人数)

users.aggregate(Arrays.asList(

Aggregates.group("$age", Accumulators.sum("count", 1)) // 按age分组计数

)).forEach(doc -> System.out.println(doc));

} catch (Exception e) {

e.printStackTrace();

}

}

}

六、关键注释说明

- 连接管理:

MongoClients.create()使用连接池(默认大小100) - 文档操作:

Document类对应BSON结构,支持嵌套和数组 - 查询优化:

createIndex()显著提升$gt等范围查询性能 - 聚合管道:

Aggregates.group()实现类似SQL的GROUP BY - 事务支持:Java驱动支持

client.startSession()开启多文档事务(需MongoDB 4.0+)

通过上述设计,MongoDB 在灵活数据模型、水平扩展和高吞吐场景中表现优异,但需避免复杂事务和关联查询。实际应用中,建议结合业务场景选择索引策略和分片键。

思维导图

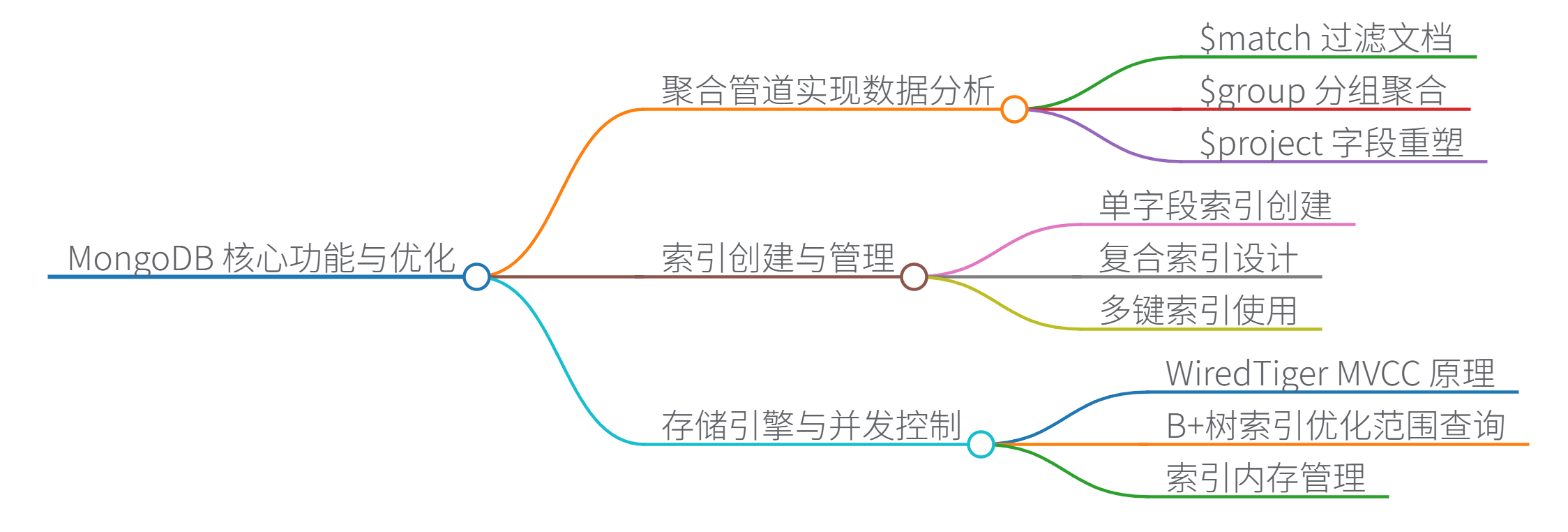

MongoDB 聚合管道实现复杂数据分析方法

MongoDB 聚合管道通过多阶段数据处理实现复杂分析,核心阶段包括:

$match:过滤文档(类似 SQL WHERE)$group:分组聚合(类似 SQL GROUP BY)$project:字段重塑(选择/计算新字段)$lookup:跨集合关联(类似 SQL JOIN)$unwind:展开数组字段

代码示例:按部门统计平均工资

db.employees.aggregate([

{ $match: { status: "active" } }, // 过滤活跃员工

{ $group: {

_id: "$department",

avgSalary: { $avg: "$salary" }, // 计算平均工资

maxSalary: { $max: "$salary" }

}},

{ $project: {

department: "$_id",

avgSalary: 1,

salaryGap: { $subtract: ["$maxSalary", "$avgSalary"] } // 计算薪资差距

}}

]);

注释:

$match减少后续处理文档量$group的_id定义分组键$project重命名字段并添加计算字段

与 SQL GROUP BY 区别:

| 特性 | MongoDB 聚合管道 | SQL GROUP BY |

|---|---|---|

| 多阶段处理 | ✅ 支持连续数据转换 | ❌ 单阶段聚合 |

| 数组处理 | ✅ 支持 $unwind 展开 | ⚠️ 需依赖数组函数 |

| 跨集合关联 | ✅ $lookup 支持 | ✅ JOIN 支持 |

| 实时流水线 | ✅ 各阶段独立优化 | ❌ 整体执行计划优化 |

MongoDB 索引优化技巧

索引类型及创建方法

- 单字段索引:

db.orders.createIndex({ orderDate: 1 }) // 1:升序, -1:降序 - 复合索引(优先高基数字段):

db.users.createIndex({ country: 1, age: -1 }) // 多字段查询优化 - 多键索引(数组字段):

db.products.createIndex({ tags: 1 }) // 自动为数组每个元素建索引 - TTL 索引(自动过期数据):

db.logs.createIndex({ createdAt: 1 }, { expireAfterSeconds: 3600 })

索引管理最佳实践

- 查询计划分析:

db.orders.find({ status: "shipped", total: { $gt: 100 } }).explain("executionStats") // 检查 winningPlan 是否使用索引 (IXSCAN) - 覆盖查询:确保查询字段均在索引中

- 避免索引爆炸:对大型数组字段慎用多键索引

- 内存优化:WiredTiger 内部缓存索引数据(默认分配 50% RAM - 1GB)

MongoDB vs MySQL 核心区别

| 维度 | MongoDB | MySQL |

|---|---|---|

| 数据模型 | 文档模型 (BSON),动态模式 | 关系模型,固定模式 |

| 查询语言 | JSON 式查询 + 聚合管道 | SQL |

| 事务支持 | 多文档 ACID 事务(4.0+) | 完整 ACID 事务 |

| 扩展性 | 原生分片集群,水平扩展 | 主从复制 + 分库分表 |

| 适用场景 | 半结构化数据、高吞吐写入、JSON 处理 | 复杂关联查询、强一致性事务 |

典型场景对比:

- JSON 处理:MongoDB 直接存储 BSON,PostgreSQL 需 JSONB 类型转换

- 地理空间查询:MongoDB 内置 GeoJSON 索引 vs PostgreSQL PostGIS 扩展

WiredTiger 存储引擎 MVCC 原理

WiredTiger 通过多版本并发控制实现高并发:

- 写操作:

- 修改数据时创建新版本(保留旧版本)

- 写入过程不阻塞读操作

- 读操作:

- 访问事务开始时的数据快照

- 避免脏读(读取未提交数据)

- 事务提交:

- 检查冲突(乐观锁机制)

- 更新全局版本号

MVCC 工作流程:

优势:读写分离,避免锁竞争;代价:需定期清理旧版本数据

分片集群查询性能优化策略

分片键设计原则

- 基数高(如用户ID)避免数据倾斜

- 写分布均匀(如哈希分片键)

- 匹配查询模式(如按时间范围查询选择时间戳分片)

$lookup 跨分片查询优化

默认 $lookup 在协调节点执行嵌套循环,效率低。优化方案:

- 冗余嵌入关联数据:

// 将部门信息嵌入员工文档 db.employees.insert({ name: "Alice", department: { id: 101, name: "Engineering" } // 避免跨集合查询 }) - 同分片键关联:

// 员工和部门使用相同分片键 sh.shardCollection("company.employees", { deptId: 1 }) sh.shardCollection("company.departments", { deptId: 1 }) // $lookup 可在本地分片执行

分片查询路由

- 定向查询:分片键精确匹配 → 路由到特定分片

- 广播查询:无分片键条件 → 扫描所有分片(性能最低)

时间序列数据:MongoDB vs PostgreSQL TimescaleDB

MongoDB 分片策略

// 1. 按时间分片(适合范围查询)

sh.shardCollection("sensor.data", { timestamp: 1 })

// 2. 按设备ID哈希分片(均匀分布写入)

sh.shardCollection("sensor.data", { deviceId: "hashed" })

// 3. 混合分片键(时间戳 + 设备ID)

sh.shardCollection("sensor.data", { timestamp: 1, deviceId: 1 })

优势:灵活水平扩展;缺点:跨分片聚合延迟高

TimescaleDB 超表设计

-- 创建超表(自动按时间分区)

CREATE TABLE sensor_data (

time TIMESTAMPTZ NOT NULL,

device_id INT,

value FLOAT

);

SELECT create_hypertable('sensor_data', 'time');

优势:

- 时间分区自动管理

- 支持连续聚合(实时物化视图)

- 列压缩减少存储 80%+

局限:水平扩展依赖 Citus 扩展

性能对比:

| 场景 | MongoDB 分片集群 | TimescaleDB |

|---|---|---|

| 高吞吐写入 | ✅ 更高并行度 | ⚠️ 单节点写入瓶颈 |

| 复杂时间窗口聚合 | ⚠️ 需跨分片协调 | ✅ 本地分区优化 |

| 存储压缩效率 | ⚠️ WiredTiger 块压缩 | ✅ 列存高效压缩 |

WiredTiger B+树索引优化范围查询

实现机制:

- 索引数据以 B+ 树存储,叶子节点双向链表链接

- 范围查询(如

db.users.find({ age: { $gt: 20, $lt: 30 } })):- 定位 B+ 树起始键

- 沿叶子节点链表顺序扫描

- 避免回溯非叶子节点

对比 LSM 树:

| 索引类型 | 范围查询性能 | 写入吞吐量 | 读放大 |

|---|---|---|---|

| B+ 树 | ✅ 稳定低延迟 | ⚠️ 需页分裂 | 低 |

| LSM 树 | ⚠️ 多层级合并影响 | ✅ 更高 | 高 |

WiredTiger 对 SSD 优化:缓存友好 + 无锁跳表加速查询

思维导图

338

338

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?