网上看到一个很有意思的美团面试题: 为什么线程崩溃崩溃不会导致 JVM 崩溃,这个问题我看了不少回答,但发现都没答到根上,所以决定答一答,相信大家看完肯定会有收获,本文分以下几节来探讨:

-

线程崩溃,进程一定会崩溃吗

-

进程是如何崩溃的-信号机制简介

-

为什么在 JVM 中线程崩溃不会导致 JVM 进程崩溃

-

openJDK 源码解析

-

主线程异常会导致 JVM 退出?

线程崩溃,进程一定会崩溃吗

一般来说如果线程是因为非法访问内存引起的崩溃,那么进程肯定会崩溃,为什么系统要让进程崩溃呢,这主要是因为在进程中, 各个线程的地址空间是共享的 ,既然是共享,那么某个线程对地址的非法访问就会导致内存的不确定性,进而可能会影响到其他线程,这种操作是危险的,操作系统会认为这很可能导致一系列严重的后果,于是干脆让整个进程崩溃

线程共享代码段,数据段,地址空间,文件

非法访问内存有以下几种情况,我们以 C 语言举例来看看

-

针对只读内存写入数据

#include <stdio.h> #include <stdlib.h> int main() { char *s = "hello world";// 向只读内存写入数据,崩溃 s[1] = 'H'; }

-

访问了进程没有权限访问的地址空间(比如内核空间)

#include <stdio.h> #include <stdlib.h> int main() { int *p = (int *)0xC0000fff;// 针对进程的内核空间写入数据,崩溃 *p = 10; }

在 32 位虚拟地址空间中,p 指向的是内核空间,显然不具有写入权限,所以上述赋值操作会导致崩溃

-

访问了不存在的内存,比如

#include <stdio.h> #include <stdlib.h> int main() { int *a = NULL; *a = 1; }

以上错误都是访问内存时的错误,所以统一会报 Segment Fault 错误(即段错误),这些都会导致进程崩溃

进程是如何崩溃的-信号机制简介

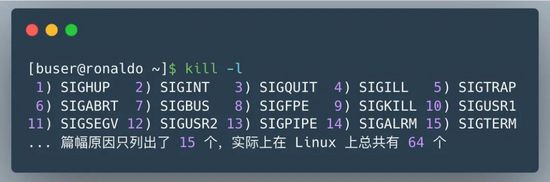

那么线程崩溃后,进程是如何崩溃的呢,这背后的机制到底是怎样的,答案是 信号 ,大家想想要干掉一个正在运行的进程是不是经常用 kill -9 pid 这样的命令,这里的 kill 其实就是给指定 pid 发送终止信号的意思,其中的 9 就是信号,其实信号有很多类型的,在 Linux 中可以通过 kill -l 查看所有可用的信号

当然了发 kill 信号必须具有一定的权限,否则任意进程都可以通过发信号来终止其他进程,那显然是不合理的,实际上 kill 执行的是系统调用,将控制权转移给了内核(操作系统),由内核来给指定的进程发送信号

那么发个信号进程怎么就崩溃了呢,这背后的原理到底是怎样的?

其背后的机制如下

-

CPU 执行正常的进程指令

-

调用 kill 系统调用向进程发送信号

-

进程收到操作系统发的信号,CPU 暂停当前程序运行,并将控制权转交给操作系统

-

调用 kill 系统调用向进程发送信号(假设为 11,即 SIGSEGV,一般非法访问内存报的都是这个错误)

-

操作系统根据情况执行相应的信号处理程序(函数),一般执行完信号处理程序逻辑后会让进程退出

注意上面的第五步,如果进程没有注册自己的信号处理函数,那么操作系统会执行默认的信号处理程序(一般最后会让进程退出),但如果注册了,则会执行自己的信号处理函数,这样的话就给了进程一个垂死挣扎的机会,它收到 kill 信号后,可以调用 exit() 来退出, 但也可以使用 sigsetjmp,siglongjmp 这两个函数来恢复进程的执行

// 自定义信号处理函数示例

#include <stdio.h>

#include <signal.h>

#include <stdlib.h>

// 自定义信号处理函数,处理自定义逻辑后再调用 exit 退出

void sigHandler(int sig) {

printf("Signal %d catched!\n", sig);

exit(sig);

}

int main(void) {

signal(SIGSEGV, sigHandler);

int *p = (int *)0xC0000fff;

*p = 10; // 针对不属于进程的内核空间写入数据,崩溃

}

// 以上结果输出: Signal 11 catched!

如代码所示:注册信号处理函数后,当收到 SIGSEGV 信号后,先执行相关的逻辑再退出

另外当进程接收信号之后也可以不定义自己的信号处理函数,而是选择忽略信号,如下

#include <stdio.h>

#include <signal.h>

#include <stdlib.h>

int main(void) {

// 忽略信号

signal(SIGSEGV, SIG_IGN);

// 产生一个 SIGSEGV 信号

raise(SIGSEGV);

printf("正常结束");

}

也就是说虽然给进程发送了 kill 信号,但如果进程自己定义了信号处理函数或者无视信号就有机会逃出生天,当然了 kill -9 命令例外,不管进程是否定义了信号处理函数,都会马上被干掉

说到这大家是否想起了一道经典面试题:如何让正在运行的 Java 工程的优雅停机,通过上面的介绍大家不难发现,其实是 JVM 自己定义了信号处理函数,这样当发送 kill pid 命令(默认会传 15 也就是 SIGTERM)后,JVM 就可以在信号处理函数中执行一些资源清理之后再调用 exit 退出。这种场景显然不能用 kill -9,不然一下把进程干掉了资源就来不及清除了

为什么线程崩溃不会导致 JVM 进程崩溃

现在我们再来看看开头这个问题,相信你多少会心中有数,想想看在 Java 中有哪些是常见的由于非法访问内存而产生的 Exception 或 error 呢,常见的是大家熟悉的 StackoverflowError 或者 NPE(NullPointerException),NPE 我们都了解,属于是访问

本文探讨了线程崩溃是否会致使JVM崩溃的问题,解释了线程共享地址空间可能导致的系统崩溃原因,介绍了信号机制在进程崩溃中的作用,并通过分析openJDK源码揭示JVM如何通过自定义信号处理函数防止因线程错误导致的整体崩溃,特别讨论了StackOverflowError和NullPointerException的情况。

本文探讨了线程崩溃是否会致使JVM崩溃的问题,解释了线程共享地址空间可能导致的系统崩溃原因,介绍了信号机制在进程崩溃中的作用,并通过分析openJDK源码揭示JVM如何通过自定义信号处理函数防止因线程错误导致的整体崩溃,特别讨论了StackOverflowError和NullPointerException的情况。

最低0.47元/天 解锁文章

最低0.47元/天 解锁文章

678

678

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?