MCP(Model Context Protocol,模型上下文协议)是由Anthropic推出的开源协议,旨在标准化大型语言模型(LLM)与外部数据源及工具的交互方式。它通过定义统一的接口和安全通信机制,使大模型能够动态调用外部API、访问实时数据,并执行复杂任务,从而突破传统AI的“信息孤岛”限制。

一、MCP协议核心架构

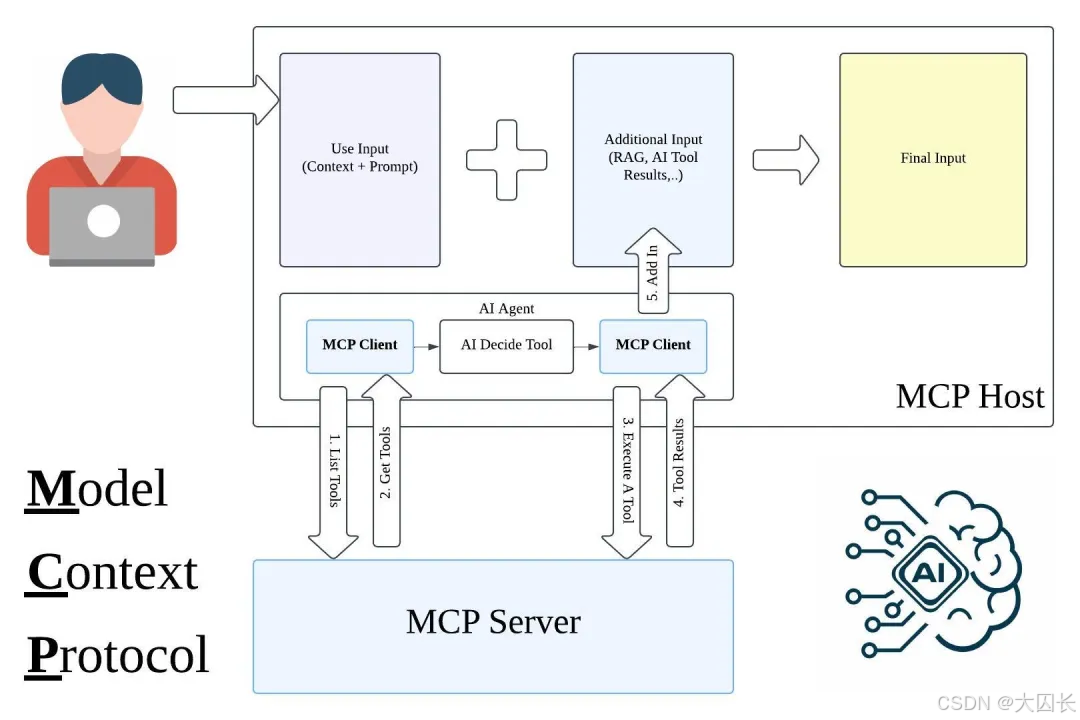

MCP采用客户端-服务器模型,包含三大核心组件():

-

MCP主机(Host)

- 运行LLM应用程序(如Claude桌面版、IDE插件),负责发起请求并整合结果。

- 示例:用户通过聊天界面提问时,Host生成初始指令并协调工具调用。

-

MCP客户端(Client)

- 嵌入在Host内部,负责与MCP服务器通信。每个Client对应一个Server的1:1连接。

- 功能:转发请求(如“搜索最新论文”)、接收结果,并维护会话状态。

-

MCP服务器(Server)

- 封装外部API或数据源(如GitHub、数据库、搜索引擎),提供标准化接口。

- 示例:一个Server可能实现“网络搜索工具”,接收查询指令后调用Brave API获取结果。

二、通信机制与协议栈

MCP基于JSON-RPC 2.0实现双向通信,支持本地与远程交互():

- 本地通信:通过标准输入输出(Stdio)实现,适用于高安全性场景(如访问本地文件系统)。

- 远程通信:采用HTTP/2或SSE(Server-Sent Events),适用于云服务调用(如连接Google Drive)。

- 数据格式:

请求和响应均以JSON结构化,例如工具调用请求可能包含:{ "method": "brave_web_search", "params": {"query": "Gemini 2.5 Pro功能", "max_results": 5}, "id": "request_123" }

三、大模型与API交互流程

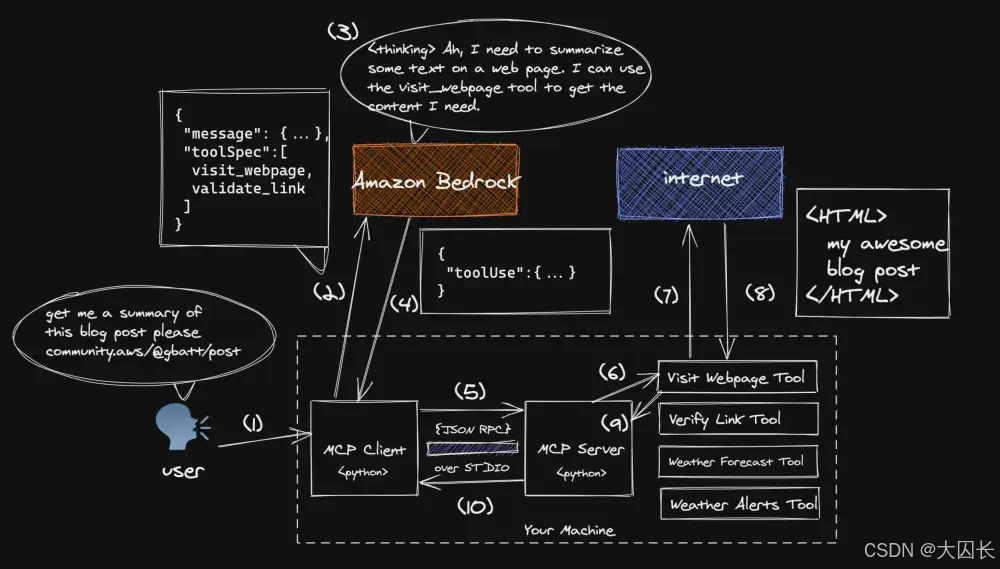

以下以“获取某URL的博客摘要”为例,说明MCP的工作流程():

-

初始化阶段

- Host启动时,Client与预设的MCP Server建立连接,获取可用工具列表(如“网页抓取工具”)。

-

请求处理与工具调用

- 用户输入请求后,Host将自然语言指令(如“总结https://example.com的内容”)发送给LLM。

- LLM解析意图,生成结构化指令调用

visit_webpage工具,通过Client转发至Server。

-

API执行与数据返回

- Server执行HTTP请求获取网页内容,返回Markdown格式的文本片段。

- Client将结果注入LLM上下文,触发二次推理生成摘要。

-

结果整合与输出

- LLM结合原始请求和工具返回数据,生成最终响应(如“该博客主要讨论MCP协议的三大优势:标准化、安全性和可扩展性…”)。

四、MCP的技术优势与挑战

优势()

- 标准化集成:统一协议替代定制API,开发效率提升80%以上(如一次集成可连接GitHub、Slack等多平台)。

- 安全隔离:API密钥由Server管理,避免直接暴露给LLM提供商(对比传统Function Call需全量传输密钥)。

- 动态上下文:支持实时数据注入(如数据库查询结果),减少模型“幻觉”并提升答案准确性。

挑战()

- 生态依赖:需广泛适配数据源(若仅少数工具支持MCP,则效用受限)。

- 性能瓶颈:复杂工具链可能导致延迟(如多级Server调用增加响应时间)。

- 配置复杂度:非技术用户需学习Server部署及JSON-RPC调试。

五、实际应用场景

-

代码开发()

- 开发者通过自然语言指令“在GitHub创建QuantumLeap仓库并推送Flask模板”,MCP自动完成全流程操作。

-

企业数据分析

- 连接内部数据库,执行指令:“提取上月购买X产品的客户邮箱”,结果直接注入模型生成报告。

-

医疗诊断辅助()

- 整合电子病历和医学影像库,AI生成诊断建议并标注数据来源。

六、未来发展方向

- 无服务器(Serverless)支持:适应云原生架构,动态扩缩容MCP Server资源()。

- 自动化工具发现:通过语义匹配推荐可用工具,降低人工配置成本()。

- 多模态扩展:支持图像、音视频资源的标准化交互()。

通过MCP协议,大模型从封闭的文本生成器进化为“数字世界操作员”,其标准化接口和灵活架构正在重塑AI应用开发范式。开发者可通过开源实现(如AIbase平台提供的SDK)快速构建MCP生态工具,推动LLM从实验室走向产业落地。

776

776

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?