一、ChatGPT 简介

ChatGPT的火爆

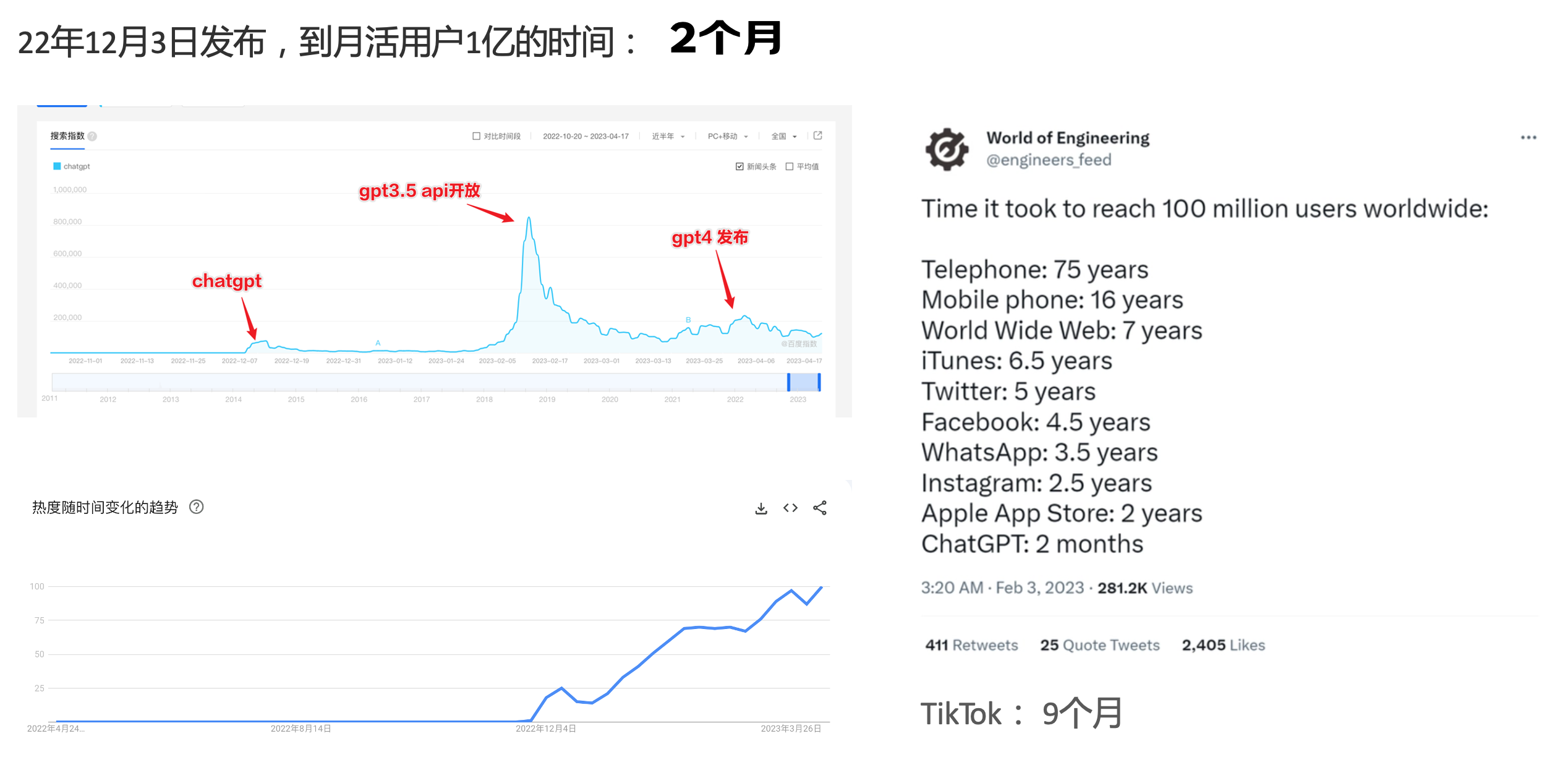

ChatGPT作为一个web应用,自22年12月发布,仅仅不到3个月的时间,月活用户就累积到1亿。在此之前,最快记录的保持者也需要9个月才达到月活1亿。

ChatGPT的反爬

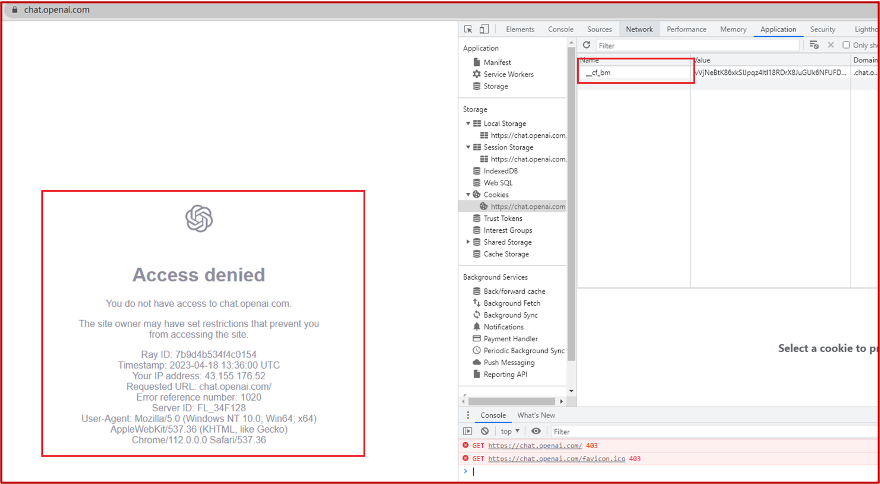

https://chat.openai.com 因为各种政策&倾向性问题,ChatGPT目前在中国无法访问。而它又是如此火爆,所以就有大量用户通过代理、爬虫等形式来体验ChatGPT。

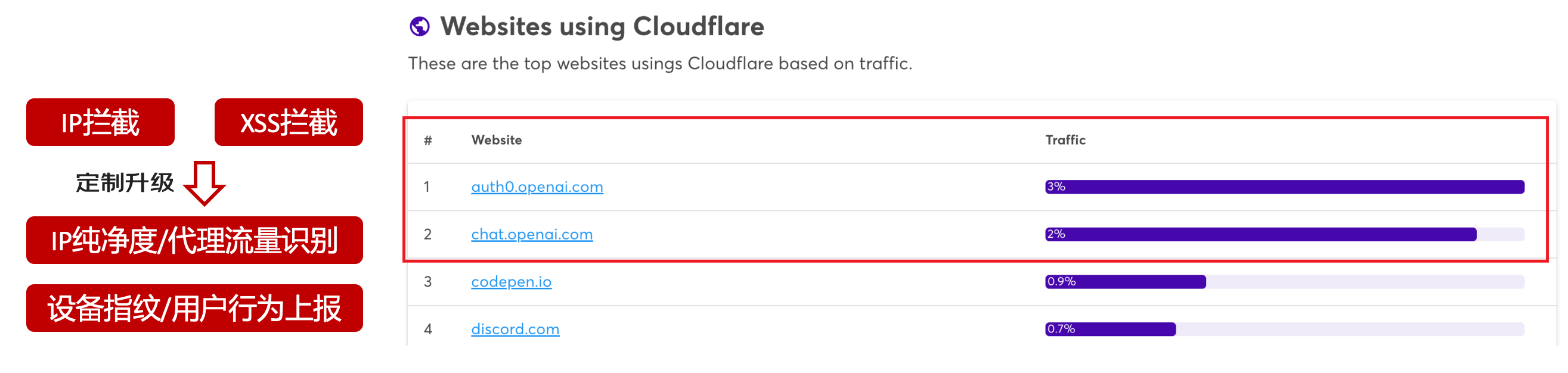

OpenAI不是专业做网络服务的公司,因此把反爬交给第三方公司CloudFlare去做。

CloudFlare目前全球最大CDN服务商,占比16%;而OpenAI的流量在CloudFlare中占比已经占据前二。

ChatGPT的打字效果

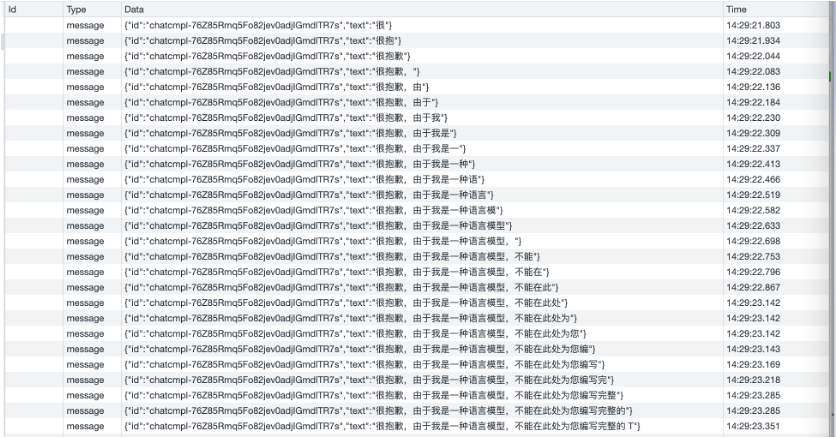

可以看到ChatGPT的输出是逐字输出的打字效果,这里应用到了SSE(SeverSideEvent)服务端推送的技术。一个SSE服务的Chrome开发工具化network截图 :

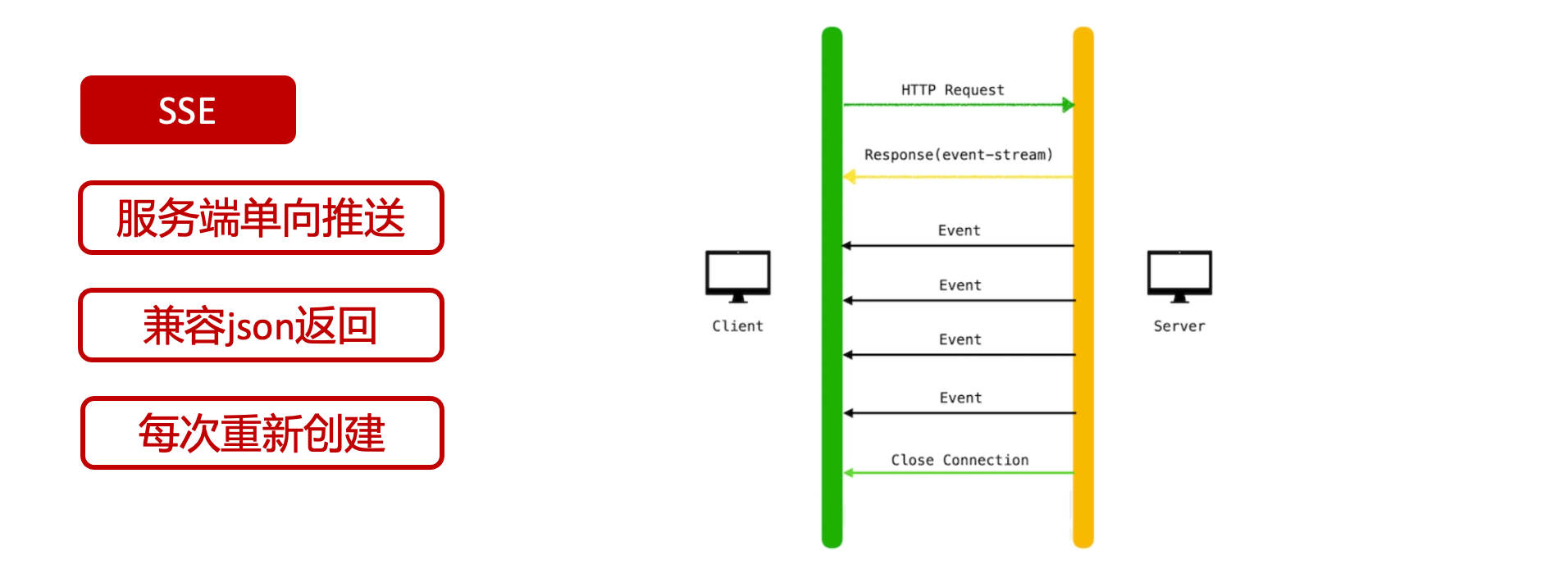

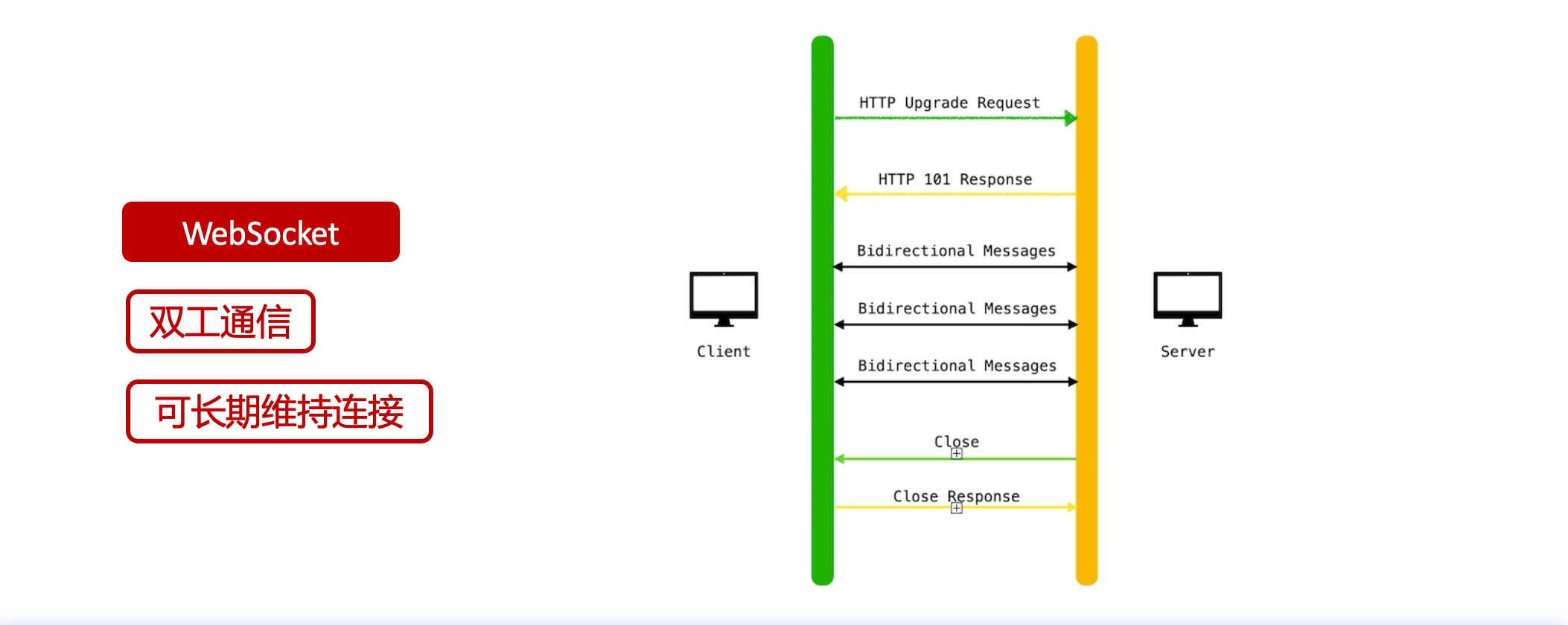

SSE对比常见Websocket如下:

那么这种打字效果它是故意的还是不小心的?

二、ChatGPT核心原理

ChatGPT我们可以拆解成 Chat、G、P、T 这四个部分讲述。在后续内容前,我们先补充几个机器学习容易理解的概念:

1.模型:所谓模型,本质上就是一个程序(函数),类似 y=ax+bx^2,这里的a和b就是参数,比如GPT3的参数量就是175B说的就是1750亿参数的程序,ChatGLM-6B的参数量是60亿。

2.机器学习:我们平时写的函数,是人来控制的逻辑和参数,而机器学习指的是机器通过某种方式(训练)来确认参数。这个找特定参数的函数的过程,一般分别为3步:

- 确定函数集合:尽可能穷尽所有参数的可能,比如文章中常见的CNN、RNN、Transform等就是函数集合;

- 数据:通过数据集,得到评价函数好坏的方式;

- 执行过程的参数:比如每批次对每个函数执行多少次,最大执行多少次等,这些参数一般称为“超参”,区别于函数内的参数(算法工程师一般自嘲的调参工程师,指的是这个“超参”)

Generative 文字接龙

ChatGPT本质上是个不断递归执行的生成式的函数,下面我们来看2个例子:

Case1:萝卜青菜

当你看到萝

ChatGPT:火爆的背后,核心技术与应用探索

ChatGPT:火爆的背后,核心技术与应用探索

最低0.47元/天 解锁文章

最低0.47元/天 解锁文章

2252

2252

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?