一、神经网络

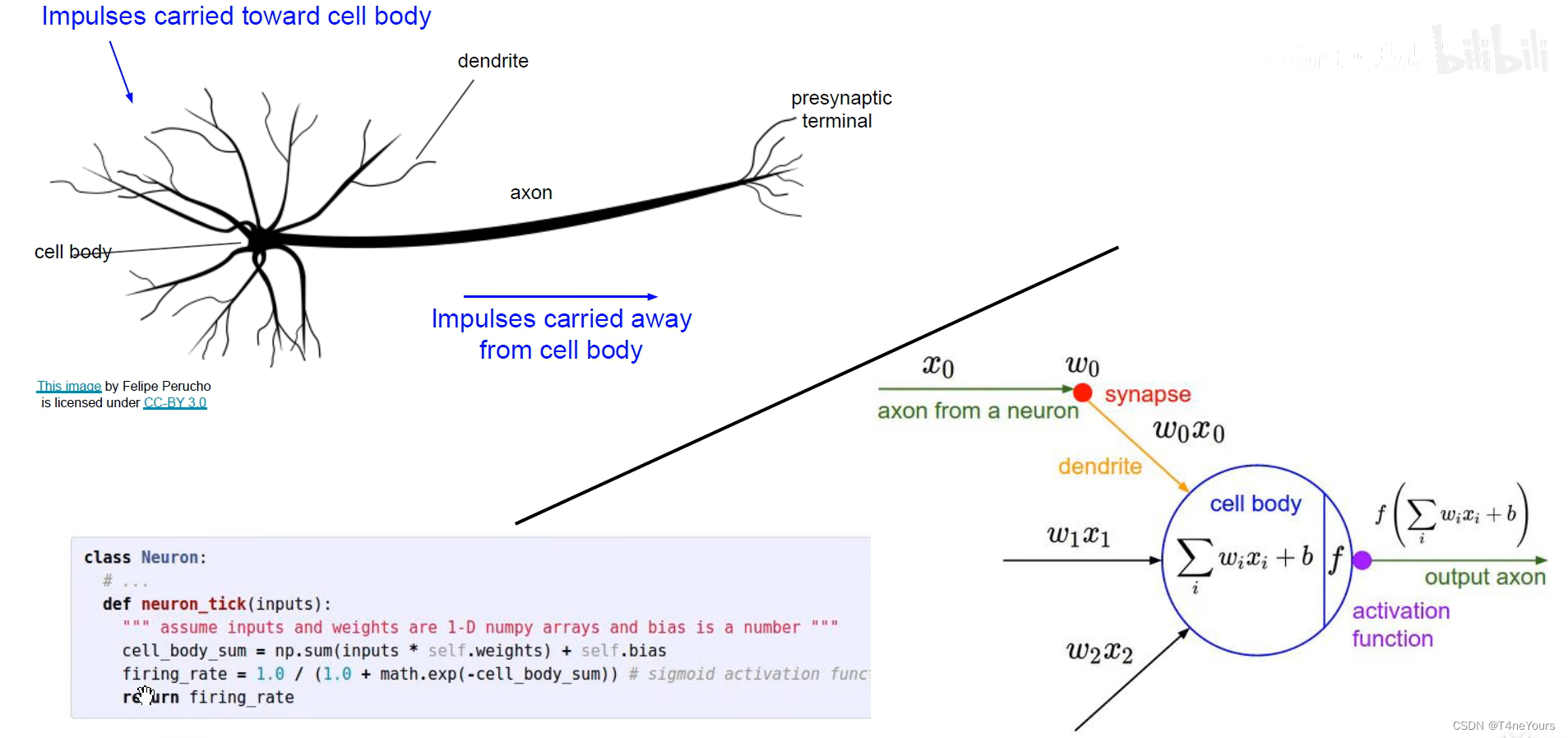

1.输入与激活函数

- 输入:不同的权重与输入值的乘积和 ∑ i = 0 w i x i \sum_{i=0}{w_ix_i} ∑i=0wixi

- sigmoid激活函数:将前步的输入做处理,缩放到一个0到1的范围里

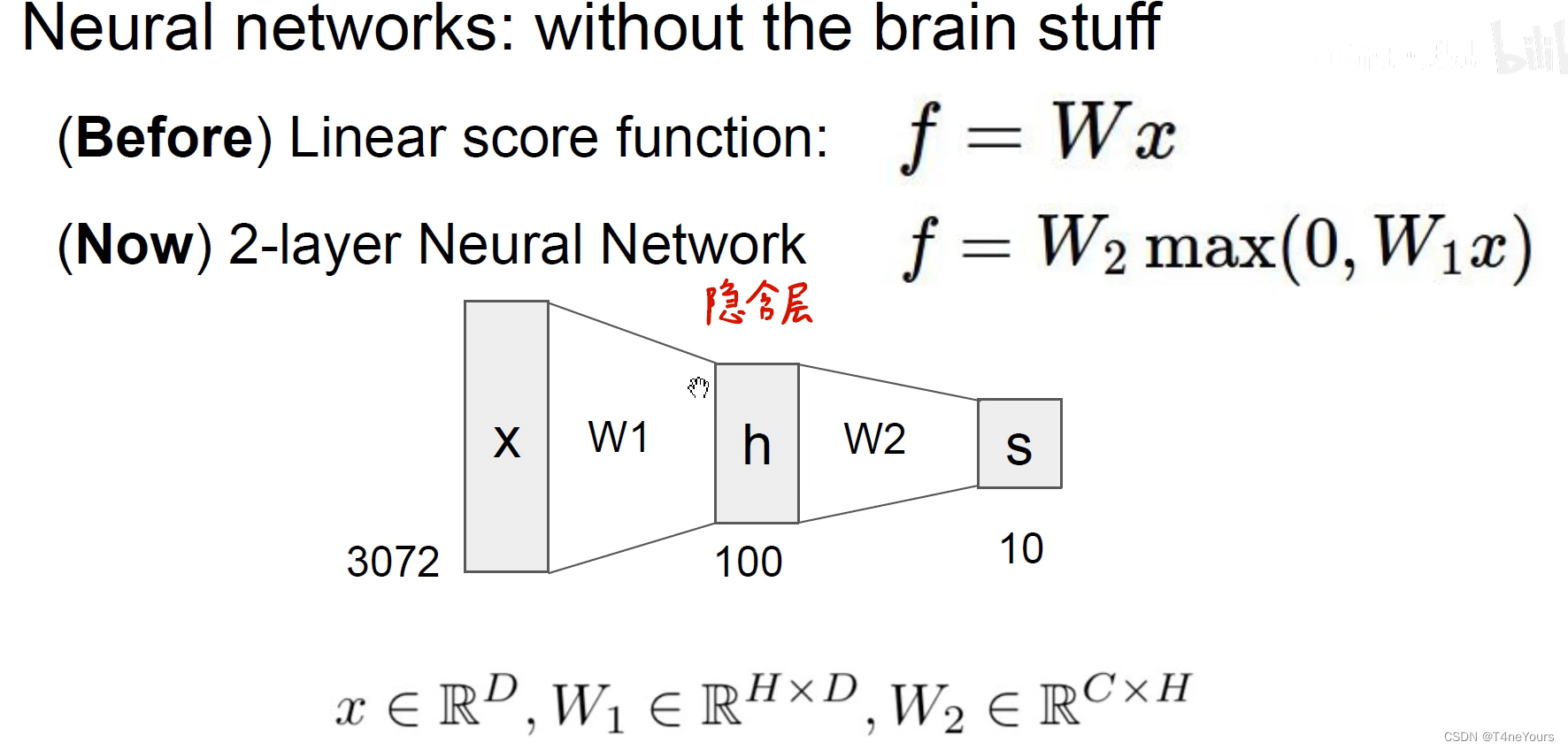

- ReLU激活函数: R e L U ( x ) = W 2 m a x ( 0 , W 1 x ) ReLU(x) = W_2max(0,W_1x) ReLU(x)=W2max(0,W1x),提取输入和0中的最大值,并作线性变化

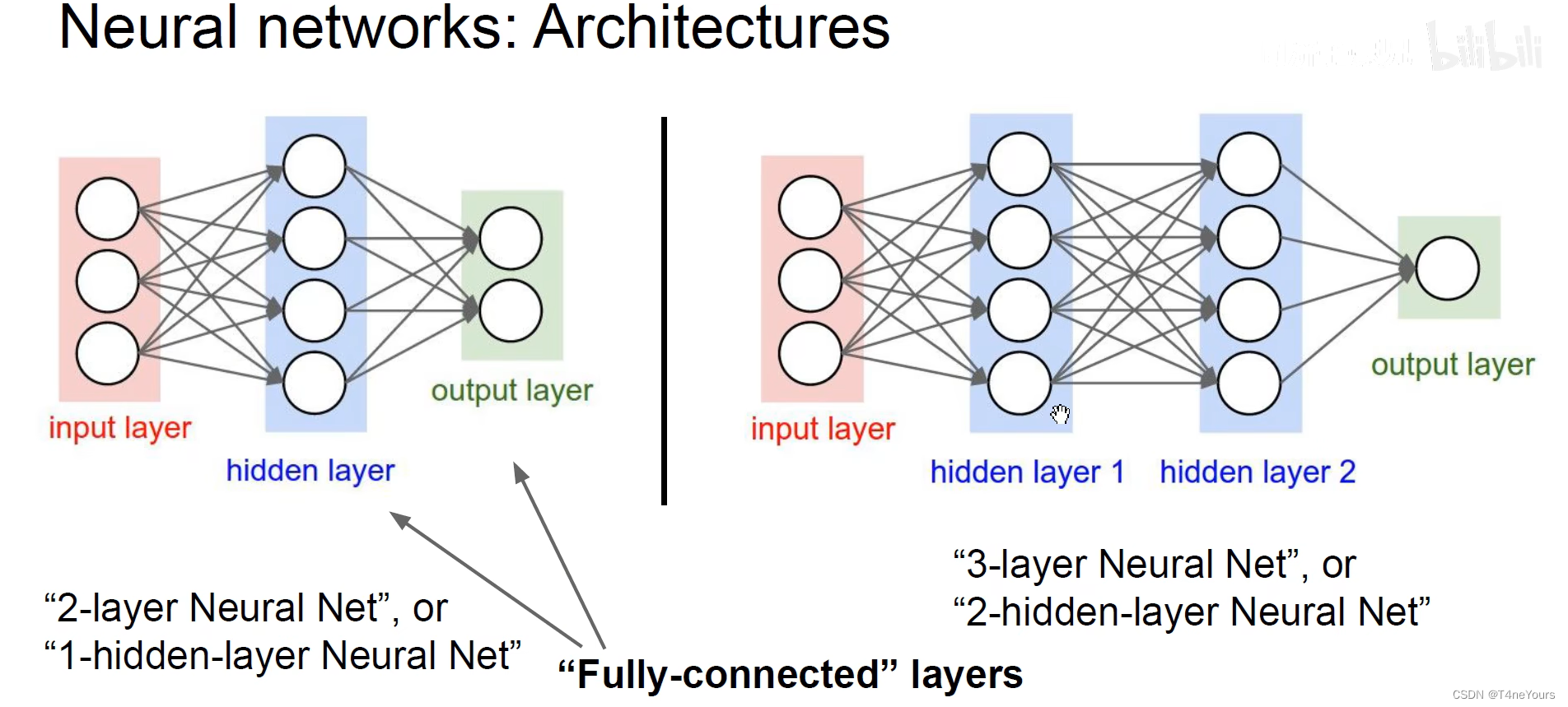

- 每一层的每一个神经元与上一层的全部神经元都做出链接,这样的层叫做全连接神经网络,也叫作多层感知机

- 输出层的神经元个数表示的是输出的特征个数

假设输入为3072维的向量

- 第一层有100个神经元,则第一层每一个神经元都有3072个权重,有100个偏置项

- 第二层有10个神经元,则第二层的每一个神经元都有100个权重,有10个偏置项

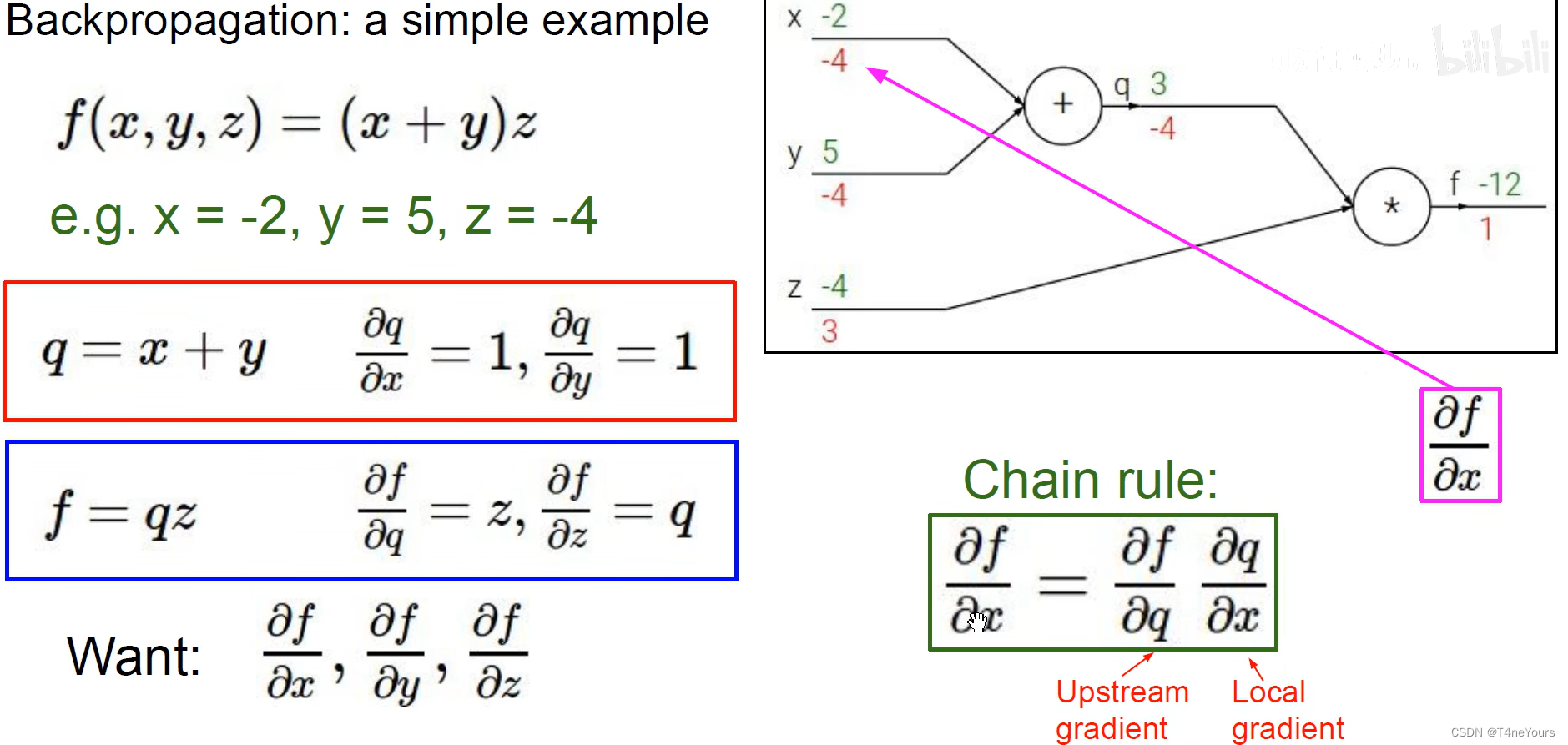

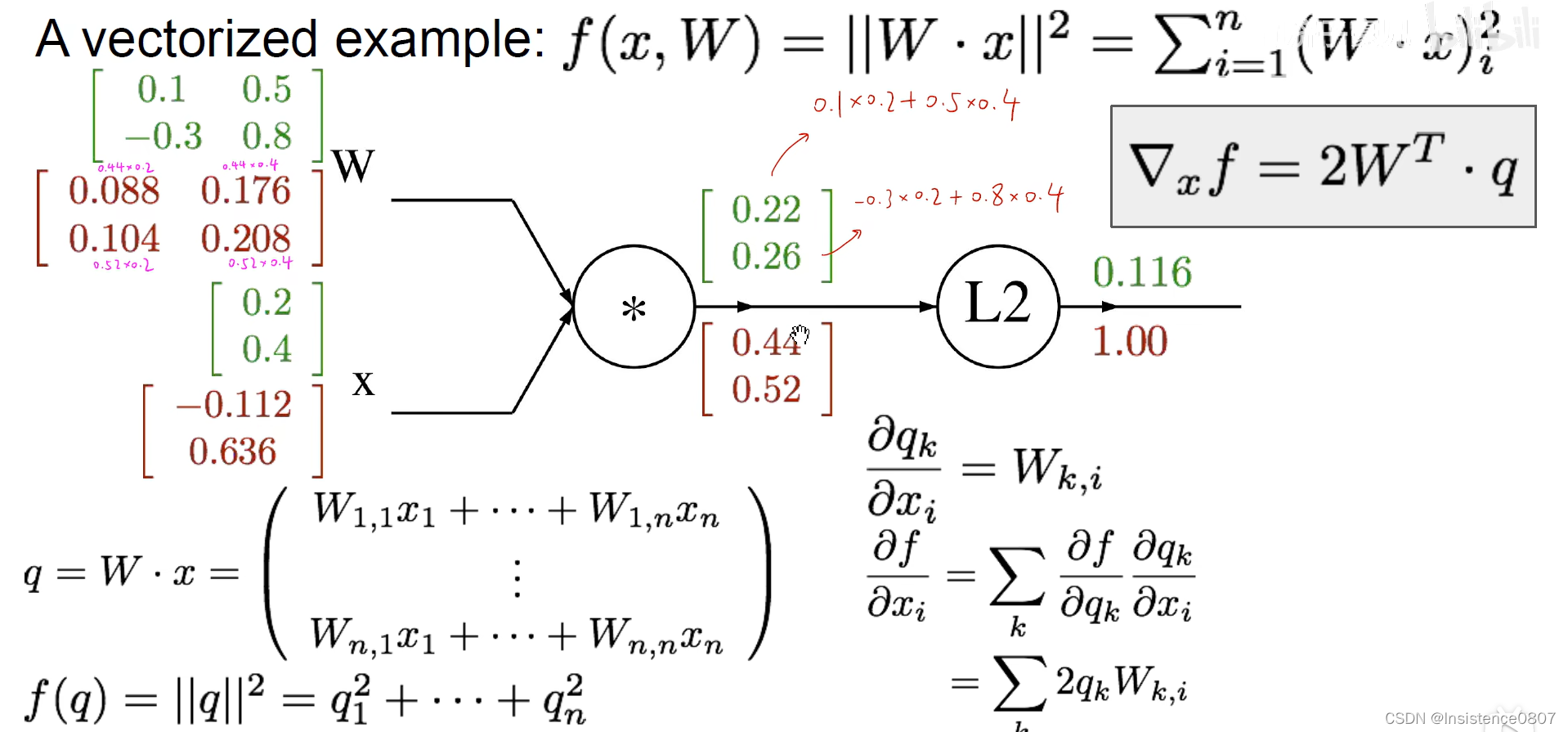

二、反向传播

1.传播方式

- 前向传播:根据公式计算

- 反向传播:反向求导(链式求导法则)

- 下图为计算过程,其中绿色为正向传播,红色为反向传播,图一为输入数字,图二为输入矩阵(向量)

7万+

7万+

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?