在支持向量机(SVM)模型中处理类别不平衡问题是一个常见的挑战。类别不平衡意味着数据集中某些类别的样本数量远远多于其他类别,从而导致模型偏向预测多数类,而忽略少数类的样本。这可能会严重影响模型的性能,特别是在关注少数类的应用场景(如欺诈检测或疾病诊断)中。

支持向量机处理不平衡类别的挑战

- 决策边界的偏移:SVM 的目标是找到最大化间隔的超平面,但在不平衡数据中,多数类样本对超平面的影响可能会压制少数类样本,导致决策边界向少数类一侧偏移。

- 分类器的偏向性:标准 SVM 可能会倾向于预测多数类,忽视少数类的样本,从而使得少数类的召回率较低。

解决不平衡类别问题的方法

以下是针对 SVM 处理不平衡类别问题的常用策略:

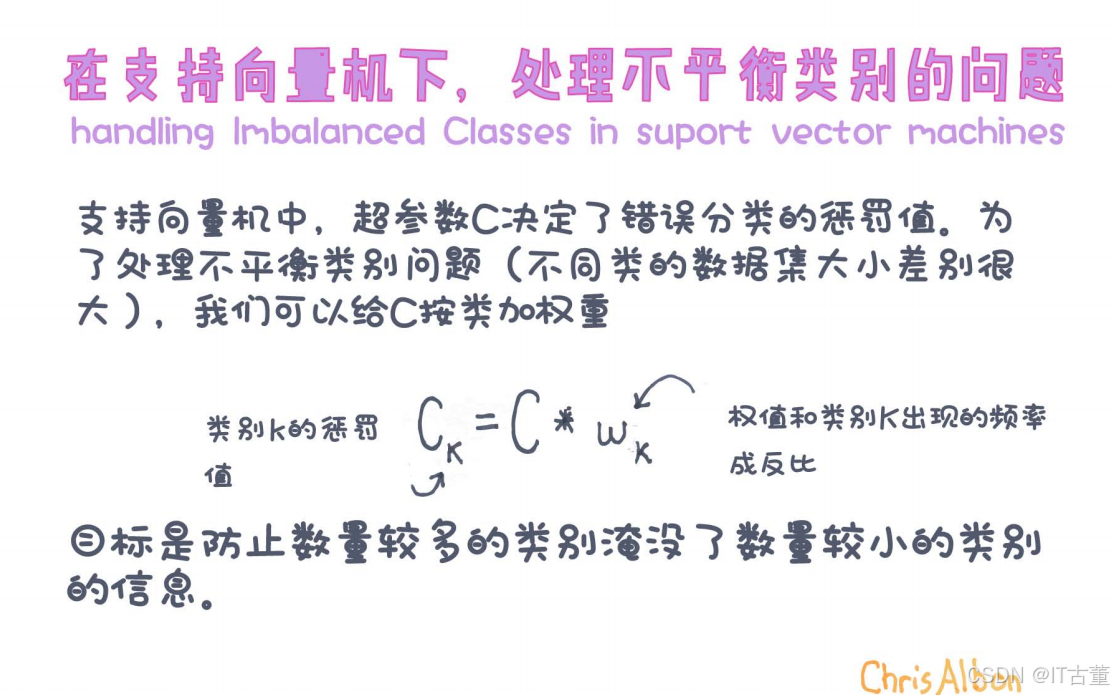

1. 调整类权重

- 原理:给少数类样本分配更高的权重,增加其在损失函数中的贡献,从而使 SVM 更关注少数类。

- 实现方式:

- 在 SVM 的优化目标中引入类权重参数

,其中

和

分别为多数类和少数类的权重。

- 比如,使用

scikit-learn的SVC模型时,可以通过设置class_weight='balanced',让模型根据类别比例自动调整权重。

- 在 SVM 的优化目标中引入类权重参数

- 代码示例:

from sklearn.svm import SVC from sklearn.datasets import make_classification # 生成不平衡数据集 X, y = make_classification(n_samples=1000, n_features=20, n_classes=2, weights=[0.9, 0.1], random_state=42) # 定义支持向量机模型,使用自动平衡类权重 model = SVC(class_weight='balanced') model.fit(X, y)

2. 过采样(Oversampling)和欠采样(Undersampling)

- 过采样:增加少数类样本的数量,例如使用 SMOTE(Synthetic Minority Over-sampling Technique) 方法。

- 欠采样:减少多数类样本的数量,从而平衡数据集。

- 代码示例(使用 SMOTE):

from imblearn.over_sampling import SMOTE from sklearn.svm import SVC from sklearn.datasets import make_classification from sklearn.pipeline import make_pipeline # 生成不平衡数据集 X, y = make_classification(n_samples=1000, n_features=20, n_classes=2, weights=[0.9, 0.1], random_state=42) # 过采样处理 smote = SMOTE(random_state=42) model = make_pipeline(smote, SVC()) model.fit(X, y)

3. 调整决策阈值

- 原理:SVM 通过计算样本距离分类超平面的距离来进行预测。默认阈值为 0,但可以通过调整该阈值来提高少数类的召回率。

- 方法:

- 通过模型的

decision_function或predict_proba方法获取样本的决策值或概率,根据不同的阈值重新进行分类。

- 通过模型的

- 代码示例:

from sklearn.metrics import classification_report from sklearn.svm import SVC from sklearn.datasets import make_classification # 生成不平衡数据集 X, y = make_classification(n_samples=1000, n_features=20, n_classes=2, weights=[0.9, 0.1], random_state=42) # 训练模型 model = SVC(probability=True, class_weight='balanced') model.fit(X, y) # 调整阈值 y_scores = model.decision_function(X) threshold = -0.5 # 调整决策阈值 y_pred = (y_scores > threshold).astype(int) print(classification_report(y, y_pred))

运行结果

precision recall f1-score support

0 1.00 0.91 0.95 897

1 0.55 1.00 0.71 103

accuracy 0.92 1000

macro avg 0.78 0.95 0.83 1000

weighted avg 0.95 0.92 0.93 1000

4. 采用不同的核函数

- 原理:不同的核函数(如线性核、多项式核、RBF 核)可以捕捉不同的特征模式。对于不平衡数据,选择适当的核函数可能会改善模型性能。

- 实践建议:

- 通过交叉验证选择最佳的核函数。

5. 数据预处理

- 归一化:对特征进行标准化或归一化,减少特征值范围的差异对 SVM 的影响。

- 特征工程:提取更能区分类别的特征,减少多数类对少数类的干扰。

评价指标

在不平衡数据问题中,准确率(Accuracy)往往不能全面反映模型性能,因此应采用其他评价指标:

- F1 分数:结合了精确率(Precision)和召回率(Recall)。

- ROC-AUC:衡量模型对类别的区分能力。

- 精确率-召回率曲线(PR Curve):特别适用于不平衡数据。

总结

支持向量机处理不平衡类别的关键在于通过调整权重、采样策略、决策阈值等方法,减少多数类的干扰,提升少数类的预测性能。在实际应用中,可以结合具体数据分布和任务需求,选择适合的策略。

1937

1937

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?