英文题目:Learning to rebalance multi-modal optimization by adaptively masking subnetworks

中文题目:通过自适应掩码子网学习多模态优化的再平衡

IEEE TRANSACTIONS ON PATTERN ANALYSIS AND MACHINE INTELLIGENCE 2025

作者来自南京理工大学

摘要

模态不平衡问题:偏向于占主导地位的模态而忽略其他模态,从而限制了整体效果。

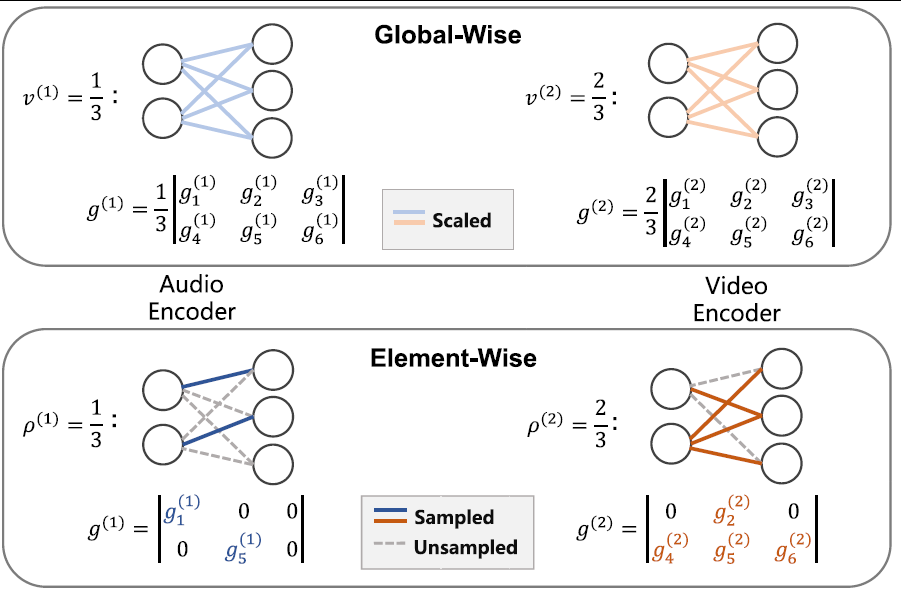

现有方法:通常采用modal-level的控制机制调整每个模态参数的更新。

存在问题:这种全局范围内的更新机制忽略了每个参数的不同重要性。

本文:受子网络优化的启发,探索了一种基于均匀采样的优化策略,其比全局更新更为有效。提出了一种基于重要性采样的元素级联合优化方法,称为Adaptively Mask Subnetworks Considering Modal Significance (AMSS)。具体而言,通过引入互信息率来确定模态的重要性,并采用非均匀自适应采样方法从每个模态中选择前景子网络进行参数更新,从而实现多模态学习的平衡。

引言

写作参考句:Compared with single-modal data, multi-modal data is more informative and covers a wider range of information dimensions and diversity. Hence, it is more important to use multiple modal data to perceive the world. By leveraging multi-modal data, multi-modal learning strives to surpass single-modal learning, capturing widespread attention across diverse domains.

作者发现:element-wise modulation strategy效果优于其他策略

主要贡献:

- 提出了一种名为AMSS的新型元素级更新方法,以解决模态不平衡问题。AMSS能够精细地激发非主导模态,并减轻主导模态的抑制作用。

- 通过理论分析展示子网络更新策略在不平衡多模态学习中的有效性。此外,基于理论研究结果,引入了一种在无偏估计下的新型掩码策略,称为 AMSS+。

- 在各种不同的模态场景中进行了大量实验,证明了细粒度子网络优化在实现多模态网络的均衡学习方法方面的有效性。

相关工作

- 多模态学习:列举了一些现有方法,这些方法的有效性取决于这样一个假设,即在联合训练过程中,每种模式都能发挥足够的作用。

- 不平衡的多模态学习:不平衡的多模态学习旨在重新平衡非主导模态和主导模态的拟合速度,确保在模型训练过程中每个模态都能得到充分利用。

- 子网络优化:所有子网络优化技术都是针对单个训练模型设计的,并且难以扩展到具有数据不平衡特征的多模态模型的联合训练中。

多模态网络的再平衡

在大多数多模态学习任务中,都会假定两种模态都能预测目标。因此,信息论能够自然地阐明模态的重要性,特别是互信息。

实验

与CNN架构相比,transformer架构下模态再平衡方法的有效性有限。

1552

1552

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?