此前,我们已经简单介绍了TextIn团队开发的开源acge_text_embedding模型及其下载和使用方法。

本篇将展开讨论Embedding模型中使用的技术框架。

Huggingface地址:https://huggingface.co/aspire/acge_text_embedding

模型API调用:https://www.textin.com/market/detail/acge_text_embedding

Embedding在自然语言处理和机器学习中起着关键作用,是基础、核心且经典的建模任务,对于各种不同的下游NLP任务是必不可少的,如分类、聚类、检索、句子相似性判断等[1]。

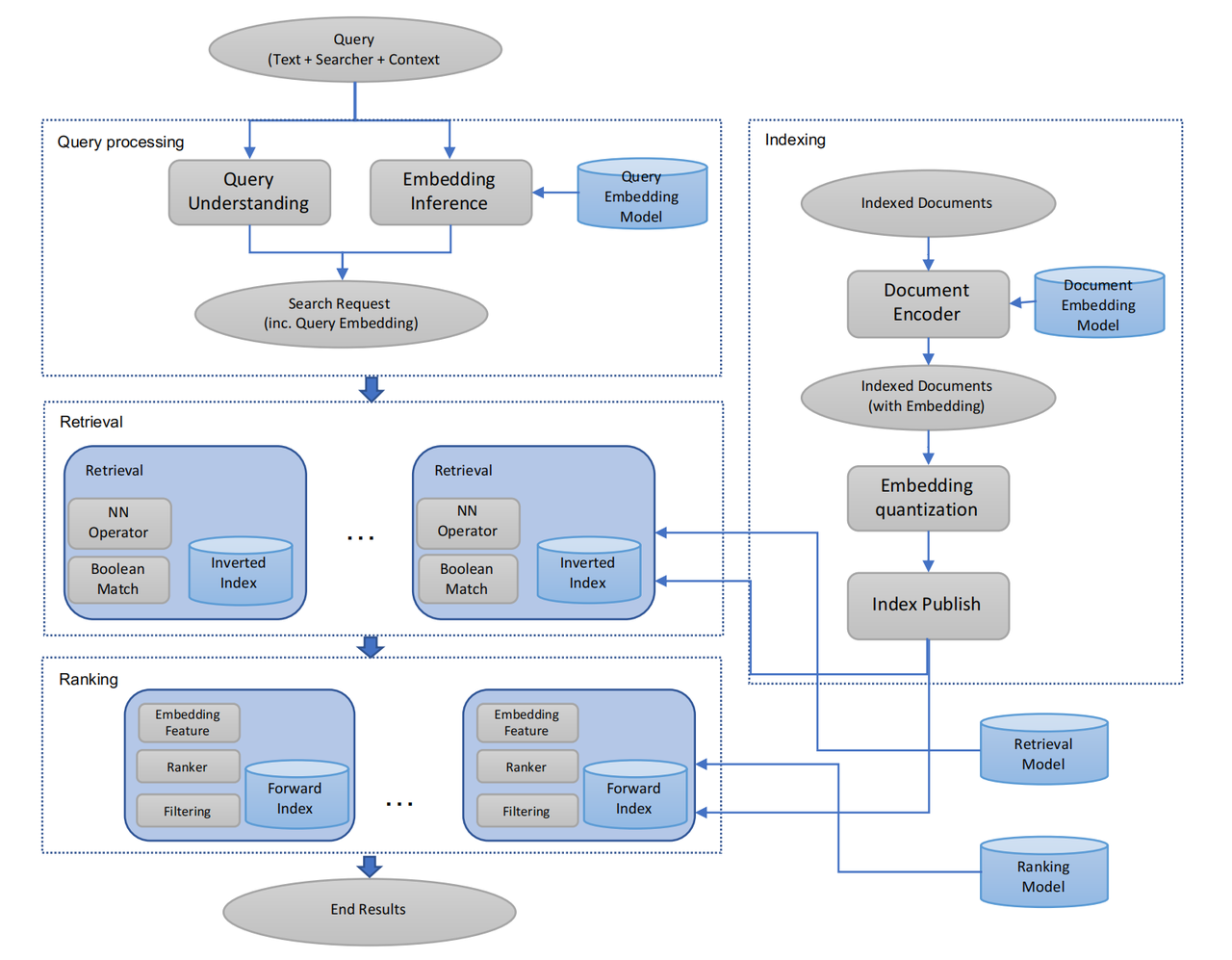

从Word2Vec到BERT表征模型、再到现如今的大模型,Embedding 建模方法在不断创新迭代。不论在传统的搜索[2]、问答场景,还是如今大语言模型(LLM)驱动的检索增强生成(Retrieval-Augmented Generation, RAG)场景中[3],Embedding 技术一直扮演着语义理解的核心角色。

在这款曾登顶C-MTEB榜首Embedding模型的研发过程中,TextIn团队采用并结合了多种技术框架:概括来讲,为提高整体召回效果,使用对比学习技术[4],通过最小化正对之间的距离和最大化负对之间的距离来呈现文本语义表示;重视数据挖掘,构造多场景、数量庞大的数据集提升模型泛化能力,挑选高质量数据集加快模型收敛。技术开发过程中,采用多任务混合训练,多loss适配场景,适应各种下游任务,避免模型“偏科”;引入持续学习训练方式[5],改善引入新数据后模型灾难性遗忘问题;同时运用MRL技术[6],训练可变维度的嵌入

最低0.47元/天 解锁文章

最低0.47元/天 解锁文章

486

486

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?