1 ResNet

1.1 ResNet创新点

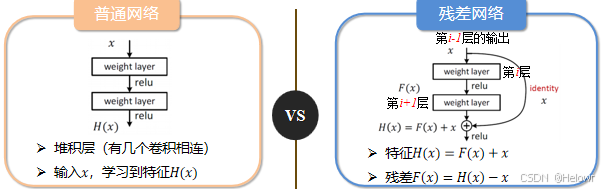

1:采用残差网络模块,模型收敛速度更快。

2:反向传播时,当网络加深时导致F(x)=0,此时网络做了恒等映射,即H(x)=x ,这个时候网络性能跟浅层神经网络基本一致,能保证模型效果与浅层神经网络相近,不会下降。

1.2 ResNet结构

1.ResNe模型包含两种不同的残差单元

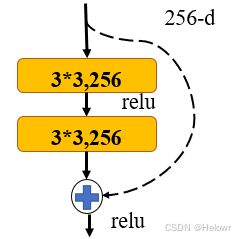

(1)BasicBlock

输入特征矩阵以两个分支进入残差块

直线分支经过2个3*3卷积层产生输出

短路分支传过来的特征与直线分支特征相加(维度不变)之后再进行Relu操作

参数:Kernel_size * Kernel_size * Cinput * Coutput

参数: 1179648

第一层: 3×3×256×256

第二层: 3×3×256×256

计算量: Cinput * Kernel_size * Kernel_size * Wout * Hout* Coutput

计算量:1179648×W_out×H_out

第一层:256×3×3×W_out×H_out×256

第二层: 256×3×3×W_out×H_out×256

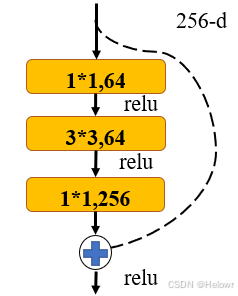

(2)Bottleneck

结构与BasicBlock类似

直线分支由2个1*1以及1个3*3卷积层

用1x1的卷积先降通道再升通道

参数:Kernel_size * Kernel_size * Cinput * Coutput (每层参数和)

参数: 69632

第一层: 1×1×256×64

第二层: 3×3×64×64

第三层: 1×1×64×256

计算量: Cinput * Kernel_size * Kernel_size * Wout * Hout* Coutput(缩小为原来的1/16)因此,Bottleneck常用于更深的网络,目的是减少计算和参数量

计算量: 69632×W_out×H_out

第一层:256×1×1×W_out×H_out×64

第二层:64×3×3×W_out×H_out×64

第三层:64×1×1×W_out×H_out×256

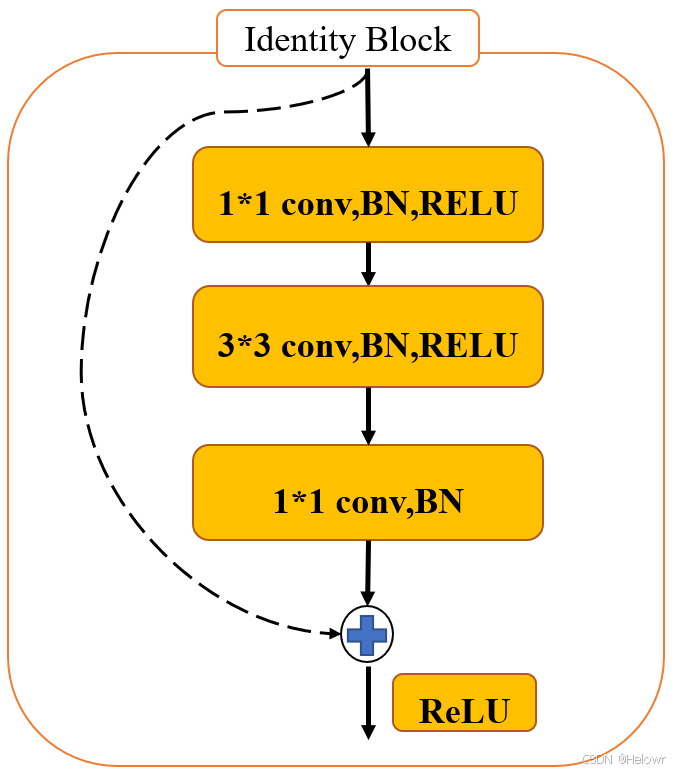

2.Identity Block与Conv Block

Identity Block的构成

Bottleneck结构

维度不变,可串联多个

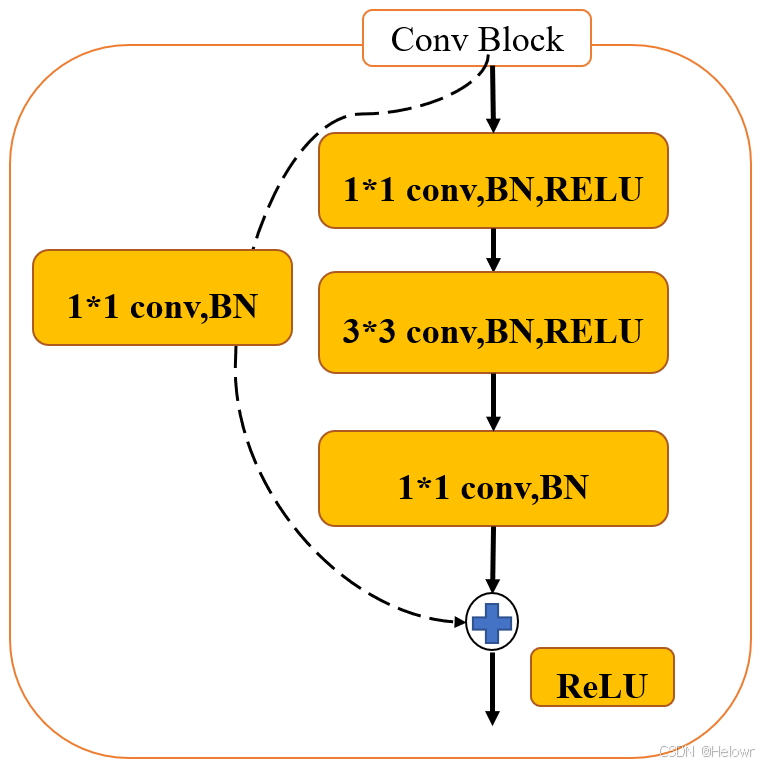

Conv Block

调整:在Identity模块加入1*1的卷积

通常步长为2,改变维度,不串联

2 ResAtteneionNet模型概述

2.1 ResAtteneionNet模型提出

2017年商汤、清华大学、香港中文大学、北京邮电大学提出

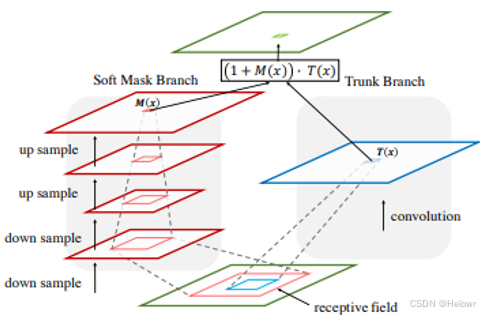

残差注意力网络(Residual Attention Network)是一种结合了注意力机制和ResNet的卷积神经网络,旨在提升图像分类任务的性能。

该网络由多个注意力模块堆叠而成,每个模块包含软掩膜分支( soft mask branch)和主干分支(trunk branch)。

软掩膜分支采用自底向上(bottom-up)和自顶向下(top-down)的结构,学习生成一个掩膜(mask),该掩膜作为权重的形式与主干分支的输出特征图相乘,从而生成最终的注意力感知特征图。

2.2 ResAtteneionNet创新点

软掩膜分支( soft mask branch)

(1)Soft Mask Branch利用bottom-up top-down的全卷积结构将全局信息与原始图像信息进行融合。

(2)该结构可以能够在梯度反向传到过程中自适应的调整权重参数信息,实现对显著性区域进行注意力加权。

4万+

4万+

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?