Hierarchical Relation Extraction with Coarse-to-Fine Grained Attention(2018)

核心:

为了解决的是DS抽取的噪声问题,多采用mutiinstance 的方式选取instance喂给模型,但存在信息丢失较多和信息抽取不充分的问题,本文是在attention based 的方法上提出的改进,在表示一个bag中的关系类型时,将关系层次结构信息通过注意力引入关系向量表示中。

基本流程:

B(s1,s2,s3,s4)

word–embedding:word2vec(skip gram)

sentences --encoder: CNN 和PCNN

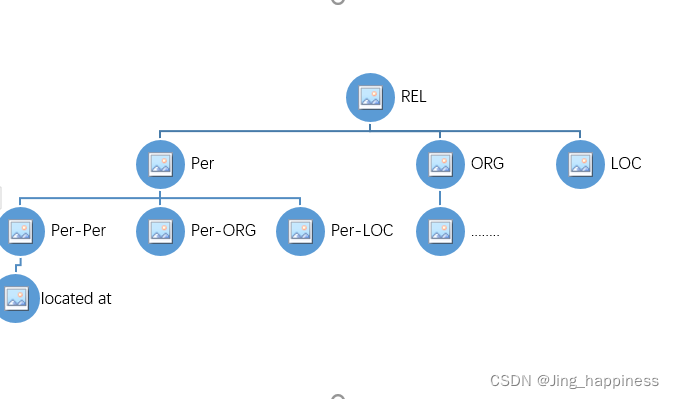

层次注意力机制:以底层为例,一个rel对应的是一个bag,一个bag里含有多个instance,利用注意力得到每个instance的注意力权重,加权求和作为rel在该层的表示。

(怎么做的注意力训练,权重是如何学出来的?)

随着关系向上层层次结构的传递,关系下的instance增多,就如下图所示,同样计算这一层的r(h,t)

最后将所有层的ri(h,t)做一个cat,作为r(h,t)的表示。

然后计算关系类别的分数矩阵?得到概率

最后得到的是不是S里含有h,t的instance是r的概率矩阵?

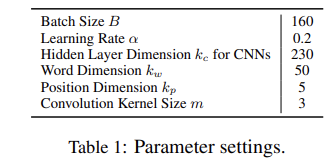

训练参数

loss 论文中定义的

训练语料:NYT(53种关系)

sentence-max-length=120

CNN dropout0.5

PCNN dropout0.9

测试语料:freebase

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?