目录

- 摘要

- MCP理论

- MCP快速开始

- fastmcp2.x

- Quickstart快速开始

- FastMCP 命令行工具(CLI)

- Server组件

- 基础知识

- 核心组件

- 高级功能

- MCP 上下文(Context)

- 代理服务器(Proxy Servers)

- 服务器组合(Server Composition)

- 资源前缀格式(Resource Prefix Formats)

- 用户引导输入(User Elicitation)

- 服务器日志记录(Server Logging)

- **进度报告(Progress Reporting)**

- LLM 采样

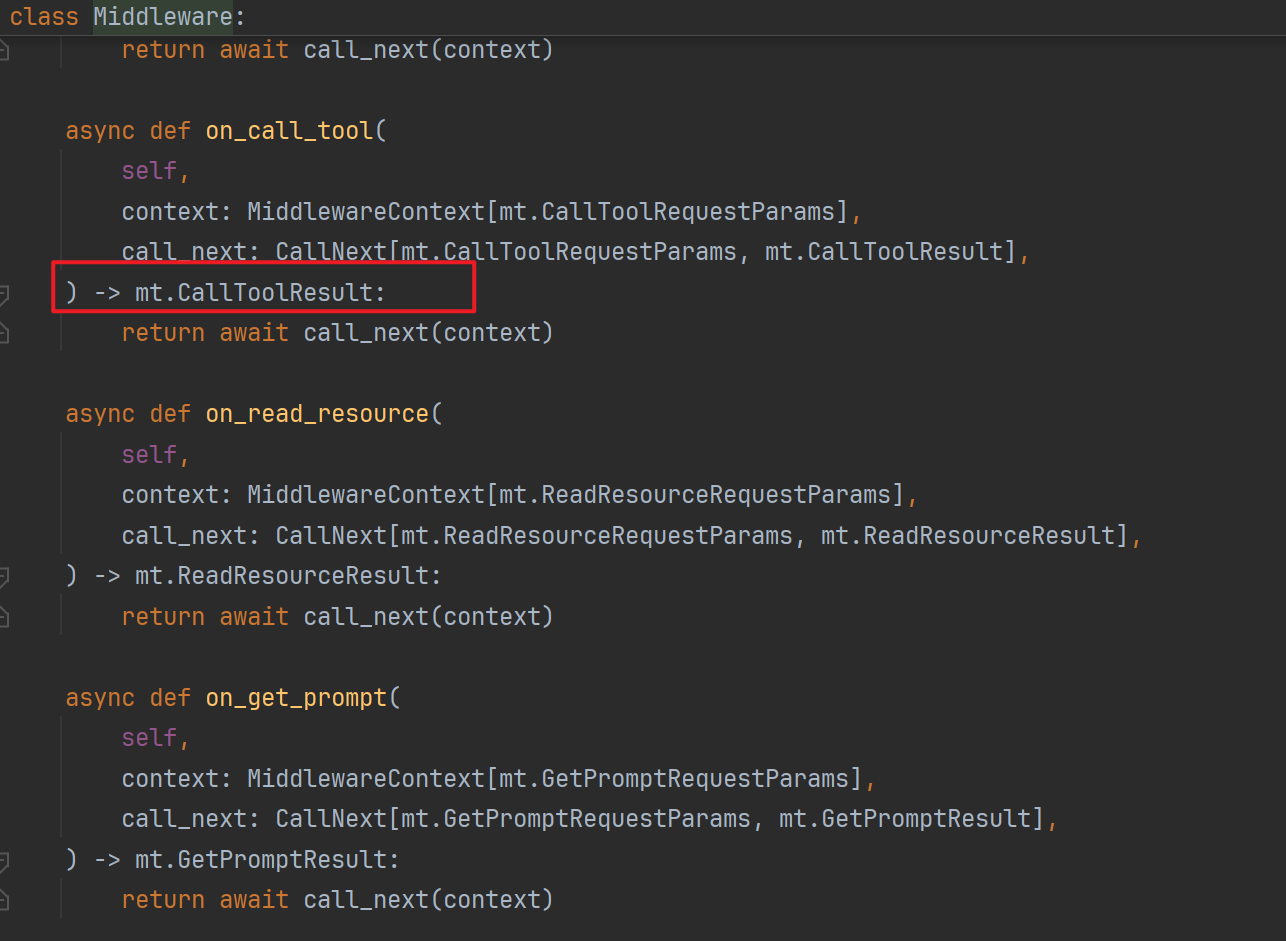

- MCP 中间件(MCP Middleware)

- Authentication

- FAQ

摘要

Model Context Protocol(MCP,模型上下文协议)是由 Anthropic 于 2024 年 11 月推出的一项开放标准,旨在解决大型语言模型(LLMs)与外部工具和数据源集成的复杂性问题。在 MCP 出现之前,开发者通常需要为每个数据源或工具编写定制的连接器,导致集成工作繁琐且难以维护。(维基百科,自由的百科全书, Wikipedia)

MCP 的核心理念是提供一个统一的通信协议,使得 LLMs 能够通过标准化的方式访问外部资源、调用工具函数,并利用预设提示模板来增强其功能。该协议基于 JSON-RPC 2.0,支持多种通信方式,包括本地的标准输入输出(stdio)和网络传输(如 HTTP 和 Server-Sent Events)。(维基百科,自由的百科全书, Wikipedia)

自发布以来,MCP 得到了广泛的支持和应用。例如,开发者可以通过 MCP 让 AI 助手直接访问 GitHub 仓库,执行代码检索和提交操作;或连接企业内部的数据库,实现实时数据查询和分析。目前,已有多家知名公司和开源项目采用 MCP,包括 OpenAI、Google DeepMind、Replit 和 Sourcegraph 等。(全栈开发网, Wikipedia)

MCP 的出现标志着 AI 系统向更高效、可扩展和标准化方向发展的重要一步,为构建更智能、灵活的 AI 应用奠定了坚实的基础。(维基百科,自由的百科全书)

MCP理论

MCP 是一个开放协议,用于标准化应用程序向大语言模型(LLMs)提供上下文的方式。

可以将 MCP 想象成 AI 应用中的 USB-C 接口。就像 USB-C 提供了一个标准化的方式,让设备可以连接各种外设和配件一样,MCP 提供了一个统一的标准,使 AI 模型能够连接到不同的数据源和工具。

为什么选择 MCP?

MCP 帮助你在 LLM 之上构建智能代理和复杂的工作流。由于 LLM 通常需要集成数据和工具,MCP 提供了以下优势:

- 越来越多的预构建集成,可供你的 LLM 直接连接使用

- 在不同的 LLM 提供商和厂商之间灵活切换的能力

- 实现数据在你自有基础设施内安全使用的最佳实践

通用架构:

从本质上讲,MCP 采用的是一种客户端-服务器架构,其中一个宿主应用可以连接多个服务器:

- MCP 宿主(MCP Hosts):如 Claude Desktop、集成开发环境(IDEs)或其他希望通过 MCP 访问数据的 AI 工具

- MCP 客户端(MCP Clients):协议客户端,负责与每个服务器建立 1:1 的连接

- MCP 服务器(MCP Servers):轻量级程序,每个服务器通过标准化的 Model Context Protocol 提供特定功能

- 本地数据源(Local Data Sources):如计算机上的文件、数据库和服务,MCP 服务器可以安全地访问这些资源

- 远程服务(Remote Services):可通过互联网访问的外部系统(例如通过 API 提供服务),MCP 服务器可以与其建立连接

假设你正在使用支持 MCP(Model Context Protocol)的 AI 应用(如 Claude Desktop)询问“明天天气怎么样?”时,整个请求的处理流程如下:

-

用户输入请求

你在 Claude Desktop 中输入:“明天天气怎么样?” -

LLM 解析意图并生成函数调用

Claude 的语言模型(LLM)解析你的自然语言请求,识别出需要获取天气预报的信息。它生成一个结构化的函数调用请求,例如:{ "method": "get-forecast", "arguments": { "location": "Osaka", "date": "2025-05-06" } } -

MCP 客户端转发请求

Claude Desktop 内置的 MCP 客户端接收到这个函数调用请求,并通过 MCP 协议将其转发给已连接的 MCP 服务器。 -

MCP 服务器处理请求

MCP 服务器是一个轻量级程序,专门处理特定功能。在本例中,它提供了一个名为get-forecast的工具,用于获取天气预报。服务器接收到请求后,调用相应的天气 API(如 OpenWeatherMap)获取大阪市 2025 年 5 月 6 日的天气预报数据。 -

MCP 服务器返回响应

MCP 服务器将获取到的天气信息封装成响应,返回给 MCP 客户端。例如:{ "forecast": "2025年5月6日,大阪市多云,最高气温22°C,最低气温15°C,有小雨。" } -

LLM 生成自然语言回复

Claude 的语言模型接收到天气信息后,将其转化为自然语言回复,例如:“明天大阪市多云,最高气温22°C,最低气温15°C,有小雨。” -

用户收到回复

最终,你在 Claude Desktop 中看到 AI 的回复,完成整个请求流程。

MCP的作用

上文提到,MCP定义了应用程序和 AI 模型之间交换上下文信息的方式。

这就使得开发者能够以一致的方式将各种数据源、工具和功能连接到 AI 模型,就像 USB-C 让不同设备能够通过相同的接口连接一样。MCP 的目标是创建一个通用标准,使 AI 应用程序的开发和集成变得更加简单和统一。

想象一下没有 MCP 之前我们会怎么做?

我们可能会人工从数据库中筛选或者使用工具检索可能需要的信息,手动的粘贴到 prompt 中。随着我们要解决的问题越来越复杂,手工把信息引入到 prompt 中会变得越来越困难。

为了克服手工 prompt 的局限性,许多 LLM 平台(如 OpenAI、Google)引入了 function call 功能。这一机制允许模型在需要时调用预定义的函数来获取数据或执行操作,显著提升了自动化水平。

但是 function call 也有其局限性,不同 LLM 平台的 function call API 实现差异较大。例如,OpenAI 的函数调用方式与 Google 的不兼容,开发者在切换模型时需要重写代码,增加了适配成本。再比如,虽然许多 LLM 提供商都采用了类似的 JSON schema 来定义函数调用,但在具体实现上仍存在一些关键差异。

-

OpenAI:使用符合 OpenAPI JSON schema 的结构,函数定义包含

name、description和parameters等字段。(DEV Community) -

Anthropic Claude:采用类似的结构,但参数定义字段为

input_schema,而不是 OpenAI 的parameters。(Superface: Connect AI agents) -

Cohere Command-R:使用

parameter_definitions字段,并在每个参数中显式指定是否为必需项,而不是使用单独的required数组。(DEV Community) -

Google Gemini:遵循 OpenAPI JSON schema,但在请求结构上有所不同,例如使用

function_declarations来包装函数,并在tool_config中指定函数调用配置。(Medium)

这些差异意味着,开发者在从一个平台切换到另一个平台时,可能需要调整函数定义的结构,以确保兼容性。除此之外,还有安全性,交互性等问题。

-

安全性:研究表明,LLM 的函数调用功能可能被滥用,导致执行未经授权的操作。例如,攻击者可能通过精心设计的输入诱导模型调用敏感函数,如删除用户账户等。

-

交互性:早期的实现中,模型通常在每次交互中只能调用一个函数,这限制了多步骤工作流的实现。虽然一些平台已经开始支持并行或多函数调用,但仍需开发者手动协调函数之间的依赖关系。(mikelev.in)

API 就像一扇扇独立的门——每扇门都有各自的钥匙和规则

MCP 传输机制 Stdio 与 SSE

Model Context Protocol (MCP) 支持两种主要的传输机制,用于 Cline 和 MCP 服务器之间的通信:标准输入/输出 (STDIO) 和服务器发送事件 (SSE)。每种机制都有其独特的特点、优势和适用场景。

STDIO

STDIO 传输在本地机器上运行,并通过标准输入/输出流进行通信:

- 客户端 (Cline) 将 MCP 服务器作为子进程启动

- 通信通过进程流进行:客户端写入服务器的 STDIN,服务器通过 STDOUT 响应

- 每条消息以换行符分隔

- 消息格式为 JSON-RPC 2.0

客户端 服务器

| |

|<---- JSON消息 ----->| (通过STDIN)

| | (处理请求)

|<---- JSON消息 ------| (通过STDOUT)

| |

STDIO 特性:

- 本地性:与 Cline 在同一台机器上运行

- 性能:非常低的延迟和开销(不涉及网络栈)

- 简单性:无需网络配置的直接进程通信

- 关系:客户端和服务器之间是一对一关系

- 安全性:由于没有网络暴露,因此本质上更安全

STDIO 传输适用于:

- 在同一机器上运行的本地集成和工具

- 安全敏感操作

- 低延迟需求

- 单客户端场景(每个服务器一个 Cline 实例)

- 命令行工具或 IDE 扩展

SSE 传输

服务器发送事件 (SSE) 传输在远程服务器上运行,并通过 HTTP/HTTPS 进行通信:

- 客户端 (Cline) 通过 HTTP GET 请求连接到服务器的 SSE 端点

- 这建立了一个持久连接,服务器可以通过该连接向客户端推送事件

- 对于客户端到服务器的通信,客户端向单独的端点发出 HTTP POST 请求

- 通信通过两个通道进行:

- 事件流 (GET):服务器到客户端的更新

- 消息端点 (POST):客户端到服务器的请求

客户端 服务器

| |

|---- HTTP GET /events ----------->| (建立 SSE 连接)

|<---- SSE 事件流 --------------| (持久连接)

| |

|---- HTTP POST /message -------->| (客户端请求)

|<---- 带响应的 SSE 事件 ---------| (服务器响应)

| |

SSE 特性

- 远程访问:可以托管在与您的 Cline 实例不同的机器上

- 可扩展性:可以同时处理多个客户端连接

- 协议:通过标准 HTTP 工作(不需要特殊协议)

- 持久性:为服务器到客户端的消息维持持久连接

- 认证:可以使用标准 HTTP 认证机制

SSE 传输更适合:

- 跨网络的远程访问

- 多客户端场景

- 公共服务

- 许多用户需要访问的集中式工具

- 与 Web 服务集成

部署模式

MCP 支持两种主要的传输方式:STDIO 与 SSE,它们决定了服务器的部署模式——是本地运行,还是作为远程服务托管运行。

🖥️ STDIO:本地部署模型

STDIO 模式下,MCP 服务作为 子进程 与客户端运行在 同一台机器,适合本地模型接入场景。

✅ 特点:

- 安装:每台用户机器都需要安装服务器(例如通过 pip、npm、pkg)

- 分发:需要为不同平台打包安装器(Windows/macOS/Linux)

- 更新:每台设备需要手动或自动更新

- 资源占用:使用本地 CPU、内存、磁盘资源

- 权限控制:继承本地文件系统的访问权限

- 系统集成:方便访问文件、运行 shell 命令、控制本地服务等

- 生命周期:随着客户端进程一起启动与销毁

- 依赖管理:服务所需依赖必须安装在用户的本地环境

📌 示例:

本地文件搜索工具:

- 安装在用户机器

- 直接访问本地磁盘

- 用户点击时自动调用

- 不需要网络

- 与前端一起打包或通过包管理器安装

☁️ SSE:托管部署模型

SSE 模式通过 HTTP 网络通信,允许 MCP 服务运行在远程服务器、容器或云平台上,适合集中管理和多用户共享场景。

✅ 特点:

- 安装:仅需在服务端部署一次

- 分发:一个服务支持多个客户端连接

- 更新:服务端统一更新即生效

- 资源使用:使用远程服务器资源

- 权限控制:使用认证/授权机制(如 Token、OAuth)

- 集成能力:访问受控远程资源(如数据库、API)

- 运行模式:常驻后台服务,持续运行

- 依赖管理:集中在服务端维护依赖,客户端无需关心

📌 示例:

数据库查询工具:

- 运行在远程服务器

- 使用统一配置连接数据库

- 多用户共享服务

- 需要网络访问

- 可通过 Docker/K8s 等方式部署

🔁 混合部署(Hybrid)

根据需求,您还可以使用混合策略:

- STDIO + 网络访问:本地代理连接远程服务

- SSE + 本地回调:远程服务通过回调控制本地操作

- 网关模式:本地服务器代理访问多个远程功能模块

📊 STDIO vs SSE 对比表

| 考虑因素 | STDIO(本地) | SSE(托管) |

|---|---|---|

| 位置 | 本地机器 | 本地或远程服务器 |

| 客户端 | 单客户端 | 多客户端共享 |

| 性能 | 低延迟,无网络开销 | 网络延迟可能较高 |

| 部署复杂度 | 简单(无服务端) | 高(需要 HTTP 服务) |

| 安全性 | 继承本地权限,安全性好 | 需配置认证/授权 |

| 网络要求 | 无需网络 | 需要稳定网络连接 |

| 可扩展性 | 有限,受限于本机资源 | 高,可水平扩展 |

| 更新管理 | 每台机器各自更新 | 服务端集中更新 |

| 资源占用 | 使用客户端资源 | 使用服务器资源 |

| 依赖管理 | 安装在本地 | 安装在服务器端 |

模型是如何确定工具的选用的?

当你在使用支持 MCP(Model Context Protocol)的 AI 应用(如 Claude Desktop 或 Cursor)提出问题时,例如“明天天气怎么样?”,整个请求的处理流程可以分为两个主要阶段:

🧠 阶段一:LLM 决策与工具选择

-

用户输入请求

你在 Claude Desktop 中输入:“明天天气怎么样?” -

LLM 解析意图

Claude 的语言模型(LLM)解析你的自然语言请求,识别出需要获取天气预报的信息。 -

工具选择

LLM 检查可用的 MCP 工具列表,决定使用哪个工具来获取所需信息。例如,选择名为get-forecast的天气预报工具。

⚙️ 阶段二:工具调用与结果处理

-

MCP 客户端转发请求

Claude Desktop 内置的 MCP 客户端将函数调用请求通过 MCP 协议转发给相应的 MCP 服务器。 -

MCP 服务器处理请求

MCP 服务器接收到请求后,调用相应的天气 API(如 OpenWeatherMap)获取天气预报数据。 -

返回响应

MCP 服务器将获取到的天气信息封装成响应,返回给 MCP 客户端。 -

LLM 生成回复

Claude 的语言模型接收到天气信息后,将其转化为自然语言回复,例如:“明天大阪市多云,最高气温22°C,最低气温15°C,有小雨。” -

用户收到回复

最终,你在 Claude Desktop 中看到 AI 的回复,完成整个请求流程。

🔄 总结:两阶段协同工作

- 阶段一(决策层):由 LLM 解析用户意图并选择合适的工具。

- 阶段二(执行层):通过 MCP 协议调用选定的工具,获取并处理结果。

这种架构使得 AI 应用能够高效、安全地与各种数据源和工具集成,实现如获取天气信息等功能,提升用户体验。

模型如何确定该使用哪些工具?这里以 MCP 官方提供的 client example 为例。通过阅读代码,可以发现模型是通过 prompt 来确定当前有哪些工具。

async def start(self):

# 初始化所有的 mcp server

for server in self.servers:

await server.initialize()

# 获取所有的 tools 命名为 all_tools

all_tools = []

for server in self.servers:

tools = await server.list_tools()

all_tools.extend(tools)

# 将所有的 tools 的功能描述格式化成字符串供 LLM 使用

# tool.format_for_llm() 我放到了这段代码最后,方便阅读。

tools_description = "\n".join(

[tool.format_for_llm() for tool in all_tools]

)

# 这里就不简化了,以供参考,实际上就是基于 prompt 和当前所有工具的信息

# 询问 LLM(Claude) 应该使用哪些工具。

system_message = (

"You are a helpful assistant with access to these tools:\n\n"

f"{tools_description}\n"

"Choose the appropriate tool based on the user's question. "

"If no tool is needed, reply directly.\n\n"

"IMPORTANT: When you need to use a tool, you must ONLY respond with "

"the exact JSON object format below, nothing else:\n"

"{\n"

' "tool": "tool-name",\n'

' "arguments": {\n'

' "argument-name": "value"\n'

" }\n"

"}\n\n"

"After receiving a tool's response:\n"

"1. Transform the raw data into a natural, conversational response\n"

"2. Keep responses concise but informative\n"

"3. Focus on the most relevant information\n"

"4. Use appropriate context from the user's question\n"

"5. Avoid simply repeating the raw data\n\n"

"Please use only the tools that are explicitly defined above."

)

messages = [{"role": "system", "content": system_message}]

...

class Tool:

"""Represents a tool with its properties and formatting."""

def __init__(

self, name: str, description: str, input_schema: dict[str, Any]

) -> None:

self.name: str = name

self.description: str = description

self.input_schema: dict[str, Any] = input_schema

def format_for_llm(self) -> str:

"""Format tool information for LLM.

Returns:

A formatted string describing the tool.

"""

args_desc = []

if "properties" in self.input_schema:

for param_name, param_info in self.input_schema["properties"].items():

arg_desc = (

f"- {param_name}: {param_info.get('description', 'No description')}"

)

if param_name in self.input_schema.get("required", []):

arg_desc += " (required)"

args_desc.append(arg_desc)

return f"""

Tool: {self.name}

Description: {self.description}

Arguments:

{chr(10).join(args_desc)}

"""

"""

那 tool 的描述和代码中的 input_schema 是从哪里来的呢?通过进一步分析 MCP 的 Python SDK 源代码可以发现:大部分情况下,当使用装饰器 @mcp.tool() 来装饰函数时,对应的 name 和 description 等其实直接源自用户定义函数的函数名以及函数的 docstring 等。

@classmethod

def from_function(

cls,

fn: Callable,

name: str | None = None,

description: str | None = None,

context_kwarg: str | None = None,

) -> "Tool":

"""Create a Tool from a function."""

func_name = name or fn.__name__ # 获取函数名

if func_name == "<lambda>":

raise ValueError("You must provide a name for lambda functions")

func_doc = description or fn.__doc__ or ""

is_async = inspect.iscoroutinefunction(fn)

总结:模型是通过 prompt engineering,即提供所有工具的结构化描述和 few-shot 的 example 来确定该使用哪些工具。

写到这里突然想到了langChain的Tool抽象,就是为了更方便的定义工具,让LLM可以正常使用。从函数创建工具可能足以满足大多数用例,可以通过简单的 @tool 装饰器 来完成。

比如我们要生成一个加法计算的工具,我们可以这样做:

from langchain_core.tools import tool

@tool

def multiply(a: int, b: int) -> int:

"""Multiply two numbers."""

return a * b

# Let's inspect some of the attributes associated with the tool.

print(multiply.name)

print(multiply.description)

print(multiply.args)

multiply

Multiply two numbers.

{'a': {'title': 'A', 'type': 'integer'}, 'b': {'title': 'B', 'type': 'integer'}}

而一个tool最重要的三要素:参数,name,描述,也是通过函数签名部分可以直接拿到。那么至此,我们就可以总结出 Function calling x MCP x LangChain的关系!

Fc x MCP x LangChain

🔧 Function Calling:LLM 与外部函数的桥梁

Function Calling 是 OpenAI 于 2023 年推出的功能,允许大语言模型(LLM)生成结构化的函数调用请求。开发者可以预定义函数的名称、参数和描述,模型在解析用户输入后,生成相应的函数调用请求,开发者再根据请求调用实际的后端函数或 API。

特点:

- 结构化调用:模型生成的函数调用请求为 JSON 格式,易于解析和处理。

- 平台依赖性:不同平台(如 OpenAI、Anthropic、Google)的函数调用实现存在差异,可能导致兼容性问题。

- 适用于简单任务:适合处理单步、明确的任务调用。

🧰 LangChain:构建 LLM 应用的开发框架

LangChain 是一个用于构建由 LLM 驱动的应用程序的开发框架。它提供了工具、链(Chains)和代理(Agents)等组件,帮助开发者管理与 LLM 的交互,并集成外部工具和数据源。(优快云博客)

特点:

- 模块化设计:通过工具、链和代理等组件,支持构建复杂的应用逻辑。

- 工具集成:允许开发者将外部函数或 API 封装为工具,供代理在任务执行中调用。

- 支持多模型:兼容多种 LLM 提供商,提供统一的接口。

🔌 MCP(Model Context Protocol):标准化的模型上下文协议

MCP 是 Anthropic 提出的开放协议,旨在标准化 LLM 与外部工具和数据源的交互方式。它采用客户端-服务器架构,允许 LLM 通过 MCP 客户端与多个 MCP 服务器通信,从而访问各种工具和数据。(优快云博客)

特点:

- 标准化接口:定义统一的协议和数据格式,促进工具和数据源的互操作性。

- 多样化工具接入:支持通过 MCP 服务器接入本地或远程的工具和数据源。

- 灵活的传输协议:支持多种通信方式,如 HTTP、WebSocket、标准输入输出等。(优快云博客)

🔄 三者关系总结

| 维度 | Function Calling | LangChain | MCP(Model Context Protocol) | |

|---|---|---|---|---|

| 定位 | LLM 与外部函数的桥梁 | 构建 LLM 应用的开发框架 | 标准化的模型上下文协议 | |

| 核心功能 | 结构化函数调用 | 工具集成、链式处理、代理任务管理 | 标准化工具和数据源的接入与通信 | |

| 扩展性 | 受限于平台实现 | 高度模块化,支持自定义扩展 | 支持多种工具和数据源的接入 | |

| 适用场景 | 简单、单步的函数调用 | 构建复杂的 LLM 应用 | 构建具备上下文感知的智能代理系统 | |

| 与其他组件关系 | 可作为 LangChain 工具的调用方式 | 可集成 Function Calling 和 MCP 工具 | 可通过适配器集成到 LangChain 中 |

🧩 实际应用中的协同方式

在实际应用中,Function Calling、LangChain 和 MCP 可以协同工作,构建功能强大的 LLM 应用。例如:

-

Function Calling 与 LangChain:开发者可以将 Function Calling 定义的函数封装为 LangChain 的工具,供代理在任务执行中调用。

-

MCP 与 LangChain:通过使用如

langchain-mcp-adapters这样的适配器库,开发者可以将 MCP 服务器提供的工具和资源转换为 LangChain 可用的格式,实现无缝集成 。(优快云博客) -

综合应用:在一个复杂的 LLM 应用中,LangChain 作为框架,集成了通过 Function Calling 定义的函数和通过 MCP 接入的工具,代理根据任务需求调用相应的工具,完成多步骤的任务执行。

说到协同就涉及到传统的开发范式和MCP下的开发范式了:

在传统的开发模式中,工具函数通常被直接集成在应用程序的代码库中,作为内部函数存在。而在 MCP 架构中,工具被定义在 MCP 服务器中,并通过标准化的接口向 MCP 客户端(如 Claude Desktop、Cursor 等)暴露。这种设计允许 LLM(大语言模型)通过 MCP 客户端调用这些外部工具,实现与外部系统的交互、数据处理等功能。

具体而言,MCP 工具的定义包括:

MCP 客户端可以通过 tools/list 接口获取可用工具列表,并通过 tools/call 接口调用特定工具。 (首页)

传统的工具集成方式通常将工具函数直接嵌入到应用程序中,这种方式的特点是:

- 紧耦合:工具函数与应用程序代码紧密集成,修改或替换工具可能需要更改应用程序代码。

- 扩展性差:添加新工具或修改现有工具可能涉及到应用程序的重新部署。

而 MCP 的外部化机制具有以下优势:

- 模块化:工具作为独立服务存在,便于开发、测试和部署。

- 灵活性:可以根据需要动态添加、修改或移除工具,而无需修改主应用程序。

- 可扩展性:支持多种通信协议(如 HTTP、WebSocket 等),便于与不同系统集成。

以 mcp_function_call_server 项目为例,该项目实现了一个兼容 MCP 协议的工具服务器,提供了如 Web 搜索、天气查询等功能。这些工具被定义在服务器的 tools/ 目录中,并通过 MCP 协议向外部暴露。LLM 应用程序可以通过 MCP 客户端调用这些工具,实现相应的功能。 (MCP)

同时langChain也提供了langchain_mcp_adapters用于连接MCP Server将远程的服务转为本地的Tool:

from langgraph.prebuilt import create_react_agent

from langchain_openai import ChatOpenAI

from langchain_mcp_adapters.client import MultiServerMCPClient

import asyncio

async def main():

async with MultiServerMCPClient(

{

"weather": {

# make sure you start your weather server on port 8000

"url": "http://localhost:8990/sse",

"transport": "sse",

}

}

) as client:

avTools = client.get_tools()

print(avTools)

if __name__ == "__main__":

asyncio.run(main())

通过 MCP 的架构设计,工具函数被外部化为独立的服务,主应用程序通过标准化的协议与这些工具进行交互。这种方式提高了系统的模块化程度,增强了灵活性和可扩展性,适应了现代 AI 应用对动态集成和快速迭代的需求。

MCP快速开始

MCP 和 LLMs 没有直接关系,只要模型具备一定的指令遵循能力,就可以使用 MCP,这也是 MCP 区别于 Function Call 的地方,就是为了更通用。

MCP 虽然是 Anthropic 提出来的,但完全可以脱离 Claude 的环境和生态进行使用,也就是说,你既不需要用 Claude 的服务器或客户端,也不需要用 Claude 的模型或 API,可以自己写 MCP Server,可以用第三方的 Client,可以用任何一个模型进行对话和工具调用。

这里我们使用官方的python案例:

使用pip快速安装MCP的python实现:pip install mcp,然后我们可以集成一系列操作到app中,比如物联网设备的操作,网络请求web search,数据库查询操作,宿主机操作…

除此之外还需要:uv工具,uv是一个Python依赖管理工具,可以通过pip install uv来安装!

from mcp.server.fastmcp import FastMCP

# Initialize FastMCP server

mcp_app = FastMCP("weather")

@mcp_app.tool()

async def get_forecast(latitude: float, longitude: float) -> str:

"""Get weather forecast for a location.

Args:

latitude: Latitude of the location

longitude: Longitude of the location

"""

return f"--{latitude}°--{longitude}°--的温度是: 37°C"

@mcp_app.tool()

def read_file(file_path: str) -> str:

"""

读取指定路径的文件内容。

Args:

file_path: 文件的完整路径

Returns:

文件的内容

"""

with open(file_path, 'r', encoding='utf-8') as file:

return file.read()

@mcp_app.tool()

def open_the_fucking_door(ip: str) -> str:

"""

打开指定ip的智能门

Args:

ip: ip地址

"""

return f"ip为:{ip}的门已打开!"

if __name__ == "__main__":

# Initialize and run the server

mcp_app.run(transport='stdio')

然后我们启动服务,如果没有node和npm可能需要提前安装:

这些命令会将 npm 的全局安装路径和缓存路径分别设置为您指定的目录:

npm config set prefix "D:\nodejs\node_global"

npm config set cache "D:\nodejs\node_cache"

验证:

npm config get prefix

npm config get cache

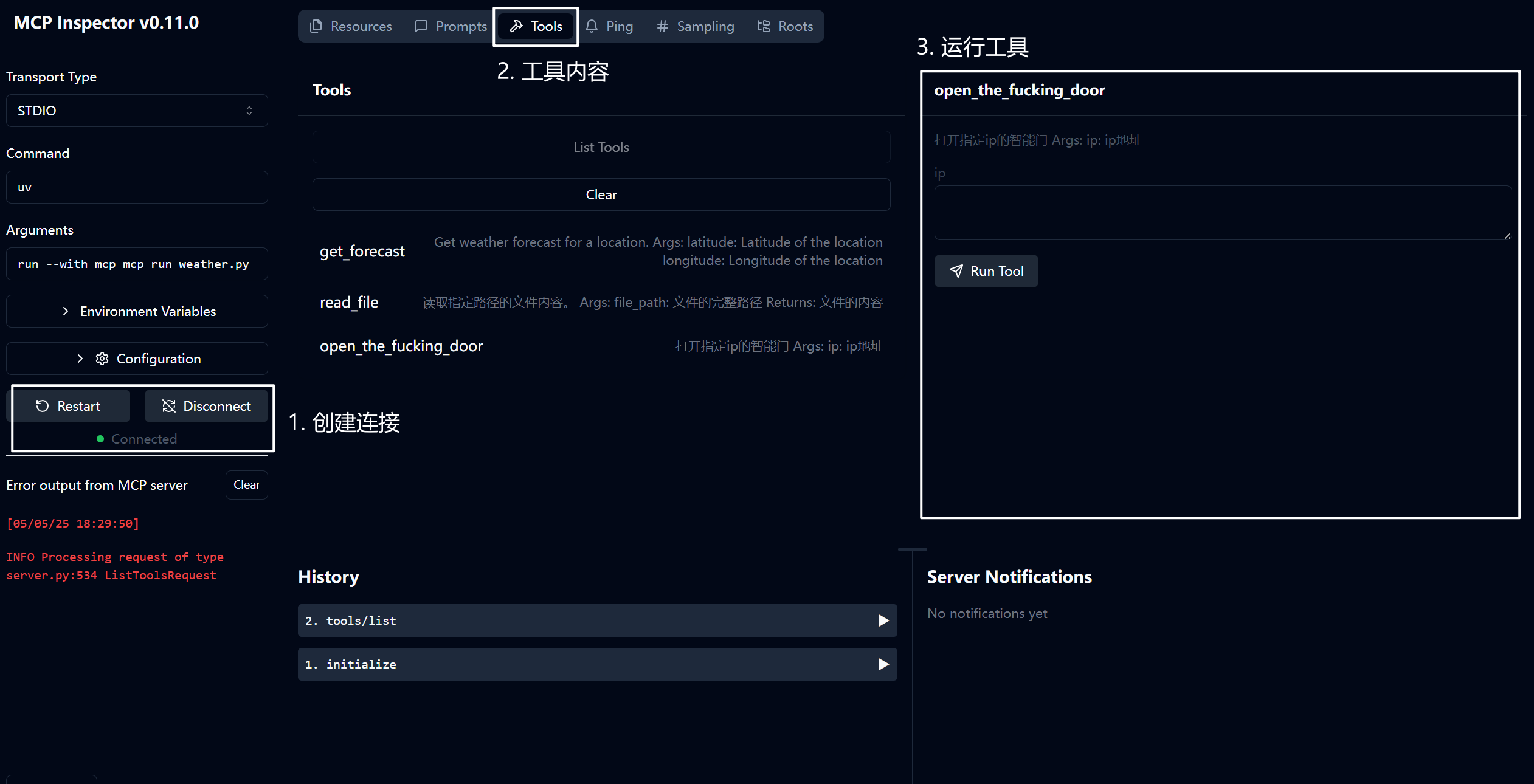

打开上文地址:http://127.0.0.1:6274/,就可以看到开发者模式下的看板:

我们让其打开一扇门,可以看到右边输出了我们的debug信息!

编写客户端

MCP是典型的C/S架构! 我们作为开发者,除了要写MCP Server外,还需要编写客户端将工具|模型|用户输入糅和在一起产生一个理想的输出!

import asyncio

from typing import Optional

from contextlib import AsyncExitStack

from mcp import ClientSession, StdioServerParameters

from mcp.client.stdio import stdio_client

class MCPClient:

def __init__(self):

# Initialize session and client objects

self.session: Optional[ClientSession] = None

self.exit_stack = AsyncExitStack()

# 暂时不初始化

self.llm = None

async def connect_to_server(self):

server_script_path = "./weather.py"

is_python = server_script_path.endswith('.py')

is_js = server_script_path.endswith('.js')

if not (is_python or is_js):

raise ValueError("Server script must be a .py or .js file")

command = "python" if is_python else "node"

server_params = StdioServerParameters(

command=command,

args=[server_script_path],

env=None

)

stdio_transport = await self.exit_stack.enter_async_context(stdio_client(server_params))

self.stdio, self.write = stdio_transport

self.session = await self.exit_stack.enter_async_context(ClientSession(self.stdio, self.write))

await self.session.initialize()

# List available tools

response = await self.session.list_tools()

tools = response.tools

print("\nConnected to server with tools:", [tool.name for tool in tools])

async def process_query(self, query: str) -> str:

"""Process a query using Claude and available tools"""

messages = [

{

"role": "user",

"content": query

}

]

response = await self.session.list_tools()

available_tools = [{

"name": tool.name,

"description": tool.description,

"input_schema": tool.inputSchema

} for tool in response.tools]

# Initial Claude API call

response = self.anthropic.messages.create(

model="claude-3-5-sonnet-20241022",

max_tokens=1000,

messages=messages,

tools=available_tools

)

# Process response and handle tool calls

final_text = []

assistant_message_content = []

for content in response.content:

if content.type == 'text':

final_text.append(content.text)

assistant_message_content.append(content)

elif content.type == 'tool_use':

tool_name = content.name

tool_args = content.input

# Execute tool call

result = await self.session.call_tool(tool_name, tool_args)

final_text.append(f"[Calling tool {tool_name} with args {tool_args}]")

assistant_message_content.append(content)

messages.append({

"role": "assistant",

"content": assistant_message_content

})

messages.append({

"role": "user",

"content": [

{

"type": "tool_result",

"tool_use_id": content.id,

"content": result.content

}

]

})

# Get next response from Claude

response = self.anthropic.messages.create(

model="claude-3-5-sonnet-20241022",

max_tokens=1000,

messages=messages,

tools=available_tools

)

final_text.append(response.content[0].text)

return "\n".join(final_text)

async def chat_loop(self):

"""Run an interactive chat loop"""

print("\nMCP Client Started!")

print("Type your queries or 'quit' to exit.")

while True:

try:

query = input("\nQuery: ").strip()

if query.lower() == 'quit':

break

response = await self.process_query(query)

print("\n" + response)

except Exception as e:

print(f"\nError: {str(e)}")

async def cleanup(self):

"""Clean up resources"""

await self.exit_stack.aclose()

async def main():

client = MCPClient()

try:

await client.connect_to_server()

await client.chat_loop()

finally:

await client.cleanup()

if __name__ == "__main__":

asyncio.run(main())

[05/05/25 19:16:40] INFO Processing request of type server.py:534

ListToolsRequest

Connected to server with tools: ['get_forecast', 'read_file', 'open_the_fucking_door']

MCP Client Started!

Type your queries or 'quit' to exit.

Query: quit

这样我们就可以连接到MCP Server,接下来就是搞定模型的问题!(MCP 和 LLMs 没有直接关系,只要模型具备一定的指令遵循能力,就可以使用 MCP)

上文我们定义的工具实际上会生成如下schema:

[{'description': 'Get weather forecast for a location.\n'

'\n'

' Args:\n'

' latitude: Latitude of the location\n'

' longitude: Longitude of the location\n'

' ',

'input_schema': {'properties': {'latitude': {'title': 'Latitude',

'type': 'number'},

'longitude': {'title': 'Longitude',

'type': 'number'}},

'required': ['latitude', 'longitude'],

'title': 'get_forecastArguments',

'type': 'object'},

'name': 'get_forecast'},

{'description': '\n'

' 读取指定路径的文件内容。\n'

'\n'

' Args:\n'

' file_path: 文件的完整路径\n'

'\n'

' Returns:\n'

' 文件的内容\n'

' ',

'input_schema': {'properties': {'file_path': {'title': 'File Path',

'type': 'string'}},

'required': ['file_path'],

'title': 'read_fileArguments',

'type': 'object'},

'name': 'read_file'},

{'description': '\n 打开指定ip的智能门\n\n Args:\n ip: ip地址\n ',

'input_schema': {'properties': {'ip': {'title': 'Ip', 'type': 'string'}},

'required': ['ip'],

'title': 'open_the_fucking_doorArguments',

'type': 'object'},

'name': 'open_the_fucking_door'}]

查询Qwen官方,我们需要的格式是这样的:

TOOLS = [

{

"type": "function",

"function": {

"name": "get_current_temperature",

"description": "Get current temperature at a location.",

"parameters": {

"type": "object",

"properties": {

"location": {

"type": "string",

"description": 'The location to get the temperature for, in the format "City, State, Country".',

},

"unit": {

"type": "string",

"enum": ["celsius", "fahrenheit"],

"description": 'The unit to return the temperature in. Defaults to "celsius".',

},

},

"required": ["location"],

},

},

},

{

"type": "function",

"function": {

"name": "get_temperature_date",

"description": "Get temperature at a location and date.",

"parameters": {

"type": "object",

"properties": {

"location": {

"type": "string",

"description": 'The location to get the temperature for, in the format "City, State, Country".',

},

"date": {

"type": "string",

"description": 'The date to get the temperature for, in the format "Year-Month-Day".',

},

"unit": {

"type": "string",

"enum": ["celsius", "fahrenheit"],

"description": 'The unit to return the temperature in. Defaults to "celsius".',

},

},

"required": ["location", "date"],

},

},

},

]

因此,我们改为Qwen适配的格式:

qwen_tools = [

{

"type": "function",

"function": {

"name": tool.name,

"description": tool.description,

"parameters": tool.inputSchema

}

}

for tool in response.tools

]

当我们询问经纬度为x的地区天气状况时,模型已经可以给出正确的函数调用了!

model='qwen2.5:7b' created_at='2025-05-05T11:45:09.210411Z' done=True done_reason='stop' total_duration=8104453800 load_duration=3359794600 prompt_eval_count=347 prompt_eval_duration=569000000 eval_count=108 eval_duration=3811000000 message=Message(role='assistant', content='', images=None, tool_calls=[ToolCall(function=Function(name='get_forecast', arguments={'latitude': 1, 'longitude': 1}))])

最后改造为:

import asyncio

from typing import Optional

from contextlib import AsyncExitStack

from mcp import ClientSession, StdioServerParameters

from mcp.client.stdio import stdio_client

from ollama import AsyncClient

from pprint import pprint

from ollama import ChatResponse

class MCPClient:

def __init__(self):

# Initialize session and client objects

self.session: Optional[ClientSession] = None

self.exit_stack = AsyncExitStack()

# 暂时不初始化

self.llm = AsyncClient()

async def connect_to_server(self):

server_script_path = "./weather.py"

is_python = server_script_path.endswith('.py')

is_js = server_script_path.endswith('.js')

if not (is_python or is_js):

raise ValueError("Server script must be a .py or .js file")

command = "python" if is_python else "node"

server_params = StdioServerParameters(

command=command,

args=[server_script_path],

env=None

)

stdio_transport = await self.exit_stack.enter_async_context(stdio_client(server_params))

self.stdio, self.write = stdio_transport

self.session = await self.exit_stack.enter_async_context(ClientSession(self.stdio, self.write))

await self.session.initialize()

# List available tools

response = await self.session.list_tools()

tools = response.tools

print("\nConnected to server with tools:", [tool.name for tool in tools])

async def process_query(self, query: str) -> str:

"""Process a query using Claude and available tools"""

messages = [

{

"role": "user",

"content": query

}

]

response = await self.session.list_tools()

qwen_tools = [

{

"type": "function",

"function": {

"name": tool.name,

"description": tool.description,

"parameters": tool.inputSchema

}

}

for tool in response.tools

]

ollama_response: ChatResponse = await self.llm.chat(

model="qwen2.5:7b", messages=messages, tools=qwen_tools

)

# Process response and handle tool calls

final_text = []

# 得到对话内容

message = ollama_response.message

messages.append({

"content": message.content,

"role": message.role

})

# 函数调用

for t in message.tool_calls or []:

fn = t.function

result = await self.session.call_tool(fn.name, fn.arguments)

final_text.append(f"[Calling tool {fn.name} with args {fn.arguments}]")

messages.append({

"role": "tool",

"content": result.content[0].text,

})

pprint(messages)

return "\n".join(final_text)

async def chat_loop(self):

"""Run an interactive chat loop"""

print("\nMCP Client Started!")

print("Type your queries or 'quit' to exit.")

while True:

try:

query = input("\nQuery: ").strip()

if query.lower() == 'quit':

break

response = await self.process_query(query)

print("\n" + response)

except Exception as e:

print(f"\nError: {str(e)}")

async def cleanup(self):

"""Clean up resources"""

await self.exit_stack.aclose()

async def main():

client = MCPClient()

try:

await client.connect_to_server()

await client.chat_loop()

finally:

await client.cleanup()

if __name__ == "__main__":

asyncio.run(main())

基于golang的mcp

目前官方没有给出对golang的实现,不过你可以在awesome-mcp-servers项目中找到基于go的SDK,如foxy-contexts、mcp-go、mcp-golang、当前这些库使用的golang版本均比较高,使用的时候需要注意下,目前,MCP 的 Golang 实现主要由 mark3labs/mcp-go 提供。这个库为开发者提供了一套完整的工具,用于创建和管理 MCP Server。它支持工具定义、参数处理、工具调用等功能,并且提供了丰富的配置选项和日志记录功能。

以https://github.com/mark3labs/mcp-go为例,下载:go get github.com/mark3labs/mcp-go

package main

import (

"context"

"errors"

"fmt"

"github.com/mark3labs/mcp-go/mcp"

"github.com/mark3labs/mcp-go/server"

)

func main() {

// Create a new MCP server

s := server.NewMCPServer(

"Calculator Demo",

"1.0.0",

server.WithResourceCapabilities(true, true),

server.WithLogging(),

server.WithRecovery(),

)

// Add a calculator tool

calculatorTool := mcp.NewTool("calculate",

mcp.WithDescription("Perform basic arithmetic operations"),

mcp.WithString("operation",

mcp.Required(),

mcp.Description("The operation to perform (add, subtract, multiply, divide)"),

mcp.Enum("add", "subtract", "multiply", "divide"),

),

mcp.WithNumber("x",

mcp.Required(),

mcp.Description("First number"),

),

mcp.WithNumber("y",

mcp.Required(),

mcp.Description("Second number"),

),

)

// Add the calculator handler

s.AddTool(calculatorTool, func(ctx context.Context, request mcp.CallToolRequest) (*mcp.CallToolResult, error) {

op := request.Params.Arguments["operation"].(string)

x := request.Params.Arguments["x"].(float64)

y := request.Params.Arguments["y"].(float64)

var result float64

switch op {

case "add":

result = x + y

case "subtract":

result = x - y

case "multiply":

result = x * y

case "divide":

if y == 0 {

return mcp.NewToolResultError("cannot divide by zero"), nil

}

result = x / y

}

return mcp.NewToolResultText(fmt.Sprintf("%.2f", result)), nil

})

// Start the server

if err := server.ServeStdio(s); err != nil {

fmt.Printf("Server error: %v\n", err)

}

}

在实现 MCP Server 后,需要将其配置到客户端插件中。以下是一个在 Windows 系统中配置cline插件的 MCP Server 的示例 JSON 文件:

{

"mcpServers": {

"culculate_server": {

"command": "C:\\Users\\Administrator\\go\\bin\\calculator.exe",

"args": [

],

"env": {

"GOPATH": "C:\\Users\\Administrator\\go",

"GOMODCACHE": "C:\\Users\\Administrator\\go\\pkg\\mod"

}

}

}

}

配置完成后,你可以通过对话框向大语言模型提问,例如计算 89989 + 4378247 的结果。大语言模型会自动调用 MCP Server 来完成计算任务,并返回结果。

除此之外,也可以通过一些支持 MCP Server 的客户端(AI代码编辑器)进行调试,比如Cursor,cline。

比如上面的python代码可以配置到Cursor:

uv --directory /Users/ryanjhzheng/Documents/my_mcp/weather run weather.py

cline则需要添加配置文件:

{

"mcpServers": {

"weather": {

"command": "uv",

"args": [

"--directory",

"/ABSOLUTE/PATH/TO/PARENT/FOLDER/weather",

"run",

"weather.py"

]

}

}

}

fastmcp2.x

FastMCP 是与模型上下文协议(MCP)配套使用的标准框架。FastMCP 1.0 已在 2024 年并入官方 MCP Python SDK。

而 FastMCP 2.0 是当前在维护的版本,提供了完整工具集以支持 MCP 生态系统的构建与交互。

FastMCP 2.0 的功能远远超出 MCP 协议规范本身,目标是为产品落地提供最简单的路径。这些功能包括:

- 部署支持

- 鉴权机制

- 客户端库

- 服务器代理与组合

- 基于 REST API 自动生成服务

- 动态工具重写

- 内置测试工具

- 各类平台集成

什么是 MCP?

模型上下文协议(Model Context Protocol,简称 MCP)让你可以构建以安全标准化方式将数据与功能暴露给 LLM 应用的服务器。它常被比喻为 AI 的 “USB-C 接口”,为大语言模型统一提供可调用的资源。你也可以将它理解为专为 LLM 交互设计的 API。

一个 MCP 服务器可以:

- 通过 Resources(资源)暴露数据(类似于 GET 接口,作用是将信息加载到 LLM 上下文中)

- 通过 Tools(工具)提供功能(类似 POST 接口,用于执行代码或产生副作用)

- 通过 Prompts(提示模板)定义交互模式(用于复用的 LLM 提示)

FastMCP 提供了构建、管理、交互上述元素的高级 Python 接口。

尽管 MCP 协议本身非常强大,但实现起来会涉及大量样板代码:服务器搭建、协议处理器、内容类型管理、错误处理等。而 FastMCP 帮你封装了所有协议细节和服务器管理流程,你只需专注于构建有价值的工具。在大多数情况下,只需装饰一个函数即可完成功能注册。

FastMCP 2.0 不仅仅是协议实现框架,更是一个完整的平台。它提供:

- 客户端库

- 认证系统

- 部署工具

- 与主流 AI 平台集成

- 测试框架

- 面向生产的基础设施模式

FastMCP 的目标是:

🚀 快速:高层接口,减少代码量,加快开发速度

🍀 简单:构建 MCP 服务几乎无需样板代码

🐍 Pythonic:自然贴合 Python 开发者的习惯

🔍 完整:涵盖从开发到生产的全方位解决方案

Quickstart快速开始

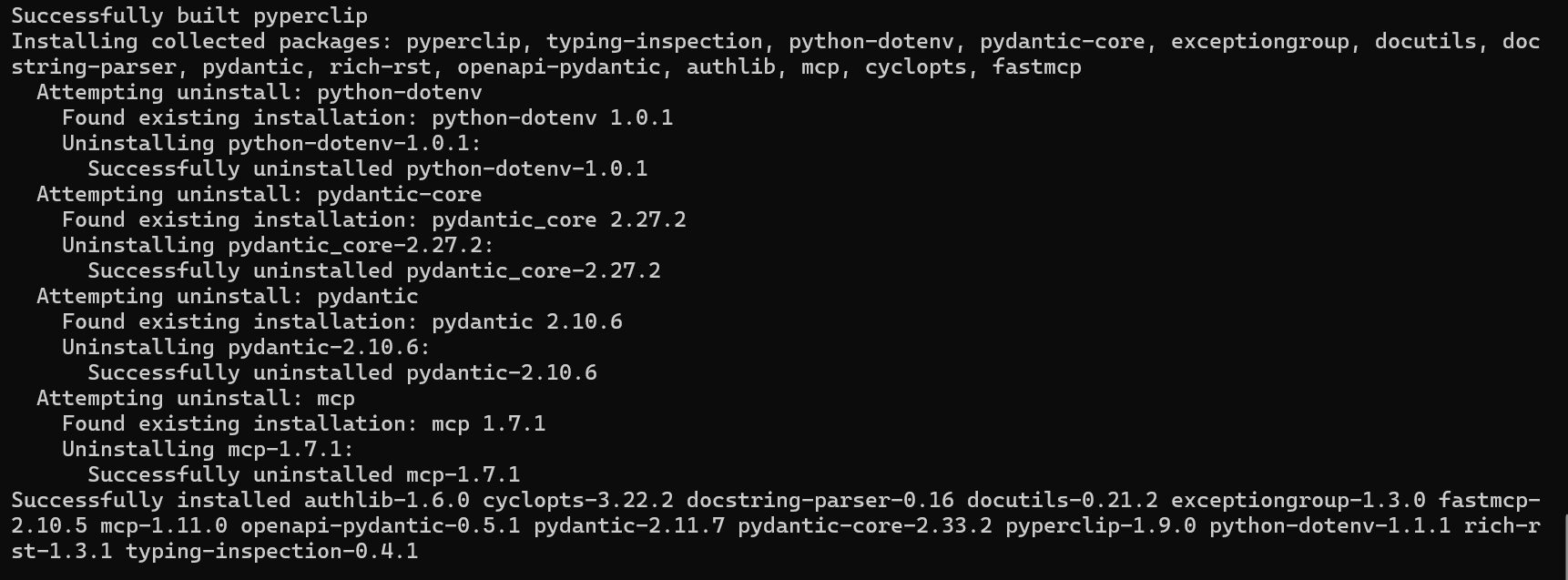

安装 FastMCP

推荐使用 uv 来安装和管理 FastMCP。如果你计划在项目中使用 FastMCP,可以通过以下命令将其添加为依赖项:

uv add fastmcp

或者,你也可以直接使用 pip 或 uv pip 安装:

uv pip install fastmcp

你可以运行以下命令,验证 FastMCP 是否安装成功:

fastmcp version

你应该会看到类似如下输出:

$ fastmcp version

FastMCP version: 0.4.2.dev41+ga077727.d20250410

MCP version: 1.6.0

Python version: 3.12.2

Platform: macOS-15.3.1-arm64-arm-64bit

FastMCP root path: ~/Developer/fastmcp

从官方 MCP SDK(FastMCP 1.0)升级到 FastMCP 2.0 通常非常简单。核心的服务端 API 兼容性很好,很多情况下,只需要将导入语句:

# 原先

# from mcp.server.fastmcp import FastMCP

# 改为

from fastmcp import FastMCP

mcp = FastMCP("My MCP Server")

在 fastmcp==2.3.0 和 mcp==1.8.0 之前,FastMCP 2.x 的 API 基本等同于官方 1.0 API。然而,随着项目的演进,这种兼容性无法完全保证。如果你在 FastMCP 2.x 中继续使用 1.0 的 API,可能会看到弃用警告。

创建一个 FastMCP 服务器

一个 FastMCP 服务器是由工具(Tools)、资源(Resources)及其他 MCP 组件组成的集合。创建服务器的第一步是实例化 FastMCP 类。

创建一个新文件 my_server.py,添加以下代码:

from fastmcp import FastMCP

mcp = FastMCP("My MCP Server")

到这里你已经成功创建了一个 FastMCP 服务器,虽然它目前还啥也不会。接下来我们添加一个工具,让它有点用处。

添加一个工具(Tool)

要添加一个返回简单问候语的工具,只需定义一个函数,并使用 @mcp.tool 装饰器注册到服务器中:

from fastmcp import FastMCP

mcp = FastMCP("My MCP Server")

@mcp.tool

def greet(name: str) -> str:

return f"Hello, {name}!"

运行服务器

为了使用 Python 启动服务器,我们需要在文件末尾添加如下运行语句:

from fastmcp import FastMCP

mcp = FastMCP("My MCP Server")

@mcp.tool

def greet(name: str) -> str:

return f"Hello, {name}!"

if __name__ == "__main__":

mcp.run()

这样就可以通过以下命令运行服务器:

python my_server.py

默认会使用 stdio 作为传输方式,这是 MCP 客户端与服务器交互的标准方法。

为什么需要 if __name__ == "__main__" 这行?

在 FastMCP 生态中,这行代码不是必须的。但为了确保不同用户、客户端的行为一致,推荐保留它作为最佳实践。

与 Python 服务器交互

现在我们可以通过 python my_server.py 启动服务器,也就能像使用其他 MCP 服务器一样与它交互。

在新文件中创建一个客户端,并指向服务器文件:

my_client.py:

import asyncio

from fastmcp import Client

client = Client("my_server.py")

async def call_tool(name: str):

async with client:

result = await client.call_tool("greet", {"name": name})

print(result)

asyncio.run(call_tool("Ford"))

几点说明:

- 客户端是异步的,因此我们需要使用

asyncio.run来执行; - 使用客户端之前必须进入上下文环境(

async with client:),你可以在同一个上下文中调用多个工具。

使用 FastMCP CLI 启动服务器

你也可以通过 CLI 命令让 FastMCP 来启动服务器:

fastmcp run my_server.py:mcp

这将启动服务器,并持续运行直到手动终止。默认仍使用 stdio 协议与客户端通信。

几点说明:

- FastMCP CLI 不依赖

__main__块,即使存在也会忽略; - CLI 会寻找命令中指定的服务器对象(如上述例子中的

mcp); - 如果没有显式指定,CLI 会自动在文件中查找名为

mcp、app或server的对象。

我们上面是让客户端直接指向

my_server.py文件,FastMCP 会识别它为一个 Python MCP 服务器,并默认以python my_server.py启动。这会执行文件中的__main__代码块。

FastMCP 命令行工具(CLI)

FastMCP 提供了一个命令行界面(CLI),用于轻松运行、开发和安装 MCP 服务器。安装 FastMCP 后,CLI 会自动安装。

fastmcp --help

| 命令 | 作用 | 依赖管理方式 |

|---|---|---|

run | 直接运行一个 FastMCP 服务器 | 使用当前环境,你需要自行确保依赖已安装 |

dev | 启动带 MCP Inspector 面板的测试服务器 | 创建隔离环境,依赖需通过 --with 和/或 --with-editable 指定 |

install | 将 MCP 服务器安装到 MCP 客户端应用中 | 创建隔离环境,依赖需通过 --with 和/或 --with-editable 指定 |

inspect | 生成 MCP 服务器的 JSON 报告 | 使用当前环境,自行管理依赖 |

version | 显示 FastMCP 的版本信息 | 无依赖 |

run

直接运行 MCP 服务器,或代理一个远程服务器。

fastmcp run server.py

此命令在当前 Python 环境中运行服务器,你需要确保依赖已安装。

常用参数:

| 参数 | 简写 | 说明 |

|---|---|---|

--transport | -t | 使用的传输协议(支持:stdio、http、sse) |

--host | 使用 HTTP 传输时绑定的主机(默认:127.0.0.1) | |

--port | -p | HTTP 模式下的端口(默认:8000) |

--path | HTTP 模式下的路径(默认:/mcp/ 或 /sse/) | |

--log-level | -l | 日志等级(DEBUG、INFO、WARNING 等) |

--no-banner | 禁用启动横幅 |

服务器对象指定方式(自 v2.3.5 起支持):

server.py:自动查找名为mcp、server或app的 FastMCP 对象server.py:my_server:指定对象名http://...或https://...:连接远程服务器并作为代理运行

示例:

# 使用 HTTP 模式启动本地服务

fastmcp run server.py --transport http --port 8000

# 代理远程服务器并作为本地 stdio 服务

fastmcp run https://example.com/mcp-server

# 设置日志级别为 DEBUG

fastmcp run server.py --log-level DEBUG

dev

使用 MCP Inspector(调试面板)运行一个 MCP 服务器进行测试。

fastmcp dev server.py

该命令会在一个隔离环境中运行你的服务器,所有依赖必须通过 --with 和/或 --with-editable 明确指定。

dev 命令是为了通过 STDIO 快速测试服务器的快捷方式。当 MCP Inspector 启动后,你可能需要:

- 从传输方式下拉框中手动选择 “STDIO”

- 手动点击 连接按钮

⚠️ 此命令不支持 HTTP 或 SSE 传输测试。

🌐 如果你想测试 HTTP/SSE 模式,请手动运行服务器:

使用命令行设置传输方式:

fastmcp run server.py --transport http

或在代码中设置传输方式后运行:

python server.py # 假设你的 __main__ 块中设置了 HTTP 模式

然后,手动打开 MCP Inspector 并连接到你正在运行的服务器。

🧩 可用参数

| 参数名称 | 简写 | 说明 |

|---|---|---|

--with-editable | -e | 指定包含 pyproject.toml 的目录,以“可编辑模式”安装当前项目 |

--with | 无 | 安装额外依赖包(可重复使用多次) |

--inspector-version | 无 | 指定 MCP Inspector 的版本 |

--ui-port | 无 | MCP Inspector Web UI 的端口号 |

--server-port | 无 | MCP Inspector 代理服务器的端口号 |

示例

# 以可编辑模式运行,并附加额外依赖

fastmcp dev server.py -e . --with pandas --with matplotlib

| 用途 | 是否支持 |

|---|---|

| MCP Inspector 调试面板 | ✅ 支持 |

| STDIO 传输 | ✅ 支持 |

| HTTP / SSE 测试 | ❌ 不支持(需改用 run 命令) |

| 隔离环境 + 自动安装依赖 | ✅ 支持 |

install

✅ 新增于版本 2.10.3

用于将 MCP 服务器安装到各种 MCP 客户端应用中。目前 FastMCP 支持以下客户端:

- Claude Code:通过其内建的 MCP 管理系统进行安装

- Claude Desktop:通过修改配置文件安装

- Cursor:通过 deeplink 安装,用户需确认

- MCP JSON:生成标准 MCP JSON 配置,供手动或通用使用

示例命令:

fastmcp install claude-code server.py

fastmcp install claude-desktop server.py

fastmcp install cursor server.py

fastmcp install mcp-json server.py

⚠️ 注意事项

-

出于安全性考虑,MCP 客户端会在完全隔离的环境中运行每个服务器。

- 所有依赖必须通过

--with和/或--with-editable显式声明(遵循uv的语法) - 或者在代码中通过

dependencies参数绑定依赖

- 所有依赖必须通过

-

不应假设 MCP 服务器可以访问你的本地开发环境。

-

uv必须在系统的 PATH 中可用:-

macOS 用户可使用 Homebrew 安装:

brew install uv

-

-

install命令主要适用于本地以 STDIO 方式运行的服务器。- 如果是远程 HTTP 或 SSE 服务,应使用目标客户端的原生配置方式。

- FastMCP 的

install命令核心价值是简化本地依赖环境与隔离部署的配置。

📦 服务器对象指定方式

与 run 命令一致,支持以下两种方式:

server.py:自动查找mcp、server或app命名的 FastMCP 实例server.py:custom_name:显式指定 MCP 实例名

🧩 可用选项

| 参数名 | 简写 | 说明 |

|---|---|---|

--name | -n | 设置自定义服务器名称(默认使用 FastMCP 名称或文件名) |

--with-editable | -e | 指定包含 pyproject.toml 的目录,使用可编辑模式安装依赖 |

--with | 无 | 指定额外依赖包(可重复使用) |

--env-var | -v | 设置环境变量(格式:KEY=VALUE,可重复) |

--env-file | -f | 从 .env 文件加载环境变量 |

🧪 使用示例

# 自动检测 FastMCP 实例(查找 mcp/server/app)

fastmcp install claude-desktop server.py

# 指定 MCP 对象

fastmcp install claude-desktop server.py:my_server

# 自定义名称并安装依赖

fastmcp install claude-desktop server.py:my_server -n "My Analysis Server" --with pandas

# 安装到 Claude Code 并设置环境变量

fastmcp install claude-code server.py --env-var API_KEY=secret --env-var DEBUG=true

# 安装到 Cursor 并加载 .env 文件

fastmcp install cursor server.py --env-file .env

# 生成 MCP JSON 配置

fastmcp install mcp-json server.py --name "My Server" --with pandas

# 将 JSON 配置复制到剪贴板

fastmcp install mcp-json server.py --copy

🧾 MCP JSON 生成

mcp-json 子命令用于生成标准化的 MCP JSON 配置,适用于所有兼容 MCP 的客户端,包括:

- Claude Desktop

- VS Code

- Cursor

- 自定义工具链、CI/CD、共享配置等

生成后的 JSON 配置示例:

{

"mcpServers": {

"server-name": {

"command": "uv",

"args": [

"run",

"--with",

"fastmcp",

"fastmcp",

"run",

"/path/to/server.py"

],

"env": {

"API_KEY": "value"

}

}

}

}

专属选项:

| 参数名 | 说明 |

|---|---|

--copy | 将生成结果复制到剪贴板,而非输出到控制台 |

| 功能 | 是否支持 | 说明 |

|---|---|---|

| 安装到 Claude Code | ✅ 支持 | 通过内置管理器安装 |

| 安装到 Claude Desktop | ✅ 支持 | 修改配置文件 |

| 安装到 Cursor | ✅ 支持 | 调起客户端确认 |

| 生成 MCP JSON 配置 | ✅ 支持 | 可用于通用客户端 |

| 自动安装依赖 | ✅ 支持 | 通过 uv 配合 --with 使用 |

适用于需要快速将服务器部署到主流 LLM IDE 的用户。

inspect

✅ 新增于版本:2.9.0

用于生成关于 FastMCP 服务器的详细 JSON 报告,其中包含该服务器的工具(tools)、提示词(prompts)、资源(resources)及其能力等信息。

fastmcp inspect server.py

该命令支持与 run 和 install 命令相同的服务器对象指定格式:

# 自动识别 FastMCP 实例(查找 mcp/server/app)

fastmcp inspect server.py

# 指定特定的 FastMCP 实例对象

fastmcp inspect server.py:my_server

# 指定自定义输出路径

fastmcp inspect server.py --output analysis.json

✅ 使用 inspect 可以方便地查看 MCP 服务有哪些可调用工具、定义的提示词、资源接口等内容,适合调试和文档生成。

version

显示 FastMCP 及相关组件的版本信息:

fastmcp version

可选参数:

| 参数名 | 简写 | 说明 |

|---|---|---|

--copy | 无 | 将版本信息复制到剪贴板,而非打印到控制台 |

✅ 使用 version 可以检查当前安装的 FastMCP 版本及兼容性情况。

version

显示当前安装的 FastMCP、MCP 版本及 Python 环境信息。

fastmcp version

参数:

--copy:将版本信息复制到剪贴板

总结

| 目的 | 推荐命令 |

|---|---|

| 快速启动服务 | fastmcp run server.py |

| 调试带 UI 面板 | fastmcp dev server.py |

| 安装到客户端工具 | fastmcp install cursor server.py 等 |

| 查看服务器结构报告 | fastmcp inspect server.py |

| 查看当前版本 | fastmcp version |

Server组件

基础知识

FastMCP 服务器:用于构建 MCP 应用程序的核心类,支持工具(tools)、资源(resources)和提示词(prompts)。

FastMCP 应用的核心组件是 FastMCP 服务器类。它是你应用中所有工具、资源和提示词的主要容器,并负责与 MCP 客户端的通信。

创建服务器

实例化服务器非常简单。你通常需要为服务器提供一个名称,以便在客户端应用或日志中识别它。

from fastmcp import FastMCP

# 创建一个基础的服务器实例

mcp = FastMCP(name="MyAssistantServer")

# 你也可以添加一些说明,指导如何与服务器交互

mcp_with_instructions = FastMCP(

name="HelpfulAssistant",

instructions="""

该服务器提供数据分析工具。

调用 get_average() 来分析数值数据。

""",

)

FastMCP 构造函数参数

| 参数名 | 类型 | 默认值 | 说明 |

|---|---|---|---|

name | str | "FastMCP" | 服务器的人类可读名称,用于识别服务器 |

instructions | str | None | 无 | 向客户端描述如何与该服务器交互的说明文字 |

lifespan | AsyncContextManager | None | 无 | 用于处理服务器启动和关闭的异步上下文管理器 |

tags | set[str] | None | 无 | 服务器的标签集 |

tools | list[Tool | Callable] | None | 无 | 要添加到服务器的工具列表,也可用函数动态添加,替代 @mcp.tool 装饰器 |

**settings | 任意类型 | 无 | 传递给 ServerSettings 的其他配置项 |

组件类型

FastMCP 服务器向客户端暴露几种类型的组件:

✅ 工具(Tools)

工具是客户端可以调用的函数,用于执行操作或访问外部系统。

@mcp.tool

def multiply(a: float, b: float) -> float:

"""将两个数相乘"""

return a * b

✅ 资源(Resources)

资源用于向客户端暴露可读的数据源。

@mcp.resource("data://config")

def get_config() -> dict:

"""提供应用配置"""

return {"theme": "dark", "version": "1.0"}

✅ 资源模板(Resource Templates)

资源模板是参数化资源,允许客户端请求特定数据。

@mcp.resource("users://{user_id}/profile")

def get_user_profile(user_id: int) -> dict:

"""根据用户 ID 获取用户资料"""

return {"id": user_id, "name": f"User {user_id}", "status": "active"}

📌 {user_id} 是从 URI 中提取的参数,并传递给函数。

✅ 提示词(Prompts)

提示词是可复用的消息模板,用于引导大语言模型(LLM)的行为。

@mcp.prompt

def analyze_data(data_points: list[float]) -> str:

"""构建一个提示词,请求对数值数据进行分析"""

formatted_data = ", ".join(str(point) for point in data_points)

return f"请分析以下数据点:{formatted_data}"

基于标签的过滤(Tag-Based Filtering)

新增于版本:2.8.0

FastMCP 支持基于标签的过滤机制,可根据配置的包含/排除标签集合,选择性地暴露组件。此功能适用于为不同环境或用户创建不同的服务器视图。

在定义组件时,可以通过 tags 参数为其添加标签:

@mcp.tool(tags={"public", "utility"})

def public_tool() -> str:

return "这是一个公开工具"

@mcp.tool(tags={"internal", "admin"})

def admin_tool() -> str:

return "这是一个仅供管理员使用的工具"

📌 过滤逻辑如下:

- 包含标签(include tags):如果指定了,只有至少包含一个匹配标签的组件才会被暴露;

- 排除标签(exclude tags):包含任意一个排除标签的组件将被过滤掉;

- 优先级(Precedence):排除标签始终优先于包含标签。

⚠️ 如果你希望某个组件永远不被暴露,可以直接对组件设置 enabled=False。

⚙️ 在创建服务器时配置过滤:

# 仅暴露带有 "public" 标签的组件

mcp = FastMCP(include_tags={"public"})

# 隐藏带有 "internal" 或 "deprecated" 标签的组件

mcp = FastMCP(exclude_tags={"internal", "deprecated"})

# 组合用法:显示带 "admin" 标签的组件,但排除 "deprecated" 的

mcp = FastMCP(include_tags={"admin"}, exclude_tags={"deprecated"})

该过滤机制适用于所有组件类型(工具、资源、资源模板和提示词),影响组件的列出与访问行为。

运行服务器

FastMCP 服务器需要一个传输机制(transport)与客户端进行通信。通常你会在 FastMCP 实例上调用 mcp.run() 方法来启动服务器,通常放在主脚本的 if __name__ == "__main__": 块中。这种写法可以确保与各种 MCP 客户端的兼容性。

# my_server.py

from fastmcp import FastMCP

mcp = FastMCP(name="MyServer")

@mcp.tool

def greet(name: str) -> str:

"""根据用户姓名打招呼。"""

return f"Hello, {name}!"

if __name__ == "__main__":

# 启动服务器,默认使用 STDIO 传输方式

mcp.run()

# 若要使用其他传输方式,例如 Streamable HTTP:

# mcp.run(transport="http", host="127.0.0.1", port=9000)

✅ FastMCP 支持的传输选项包括:

- STDIO(默认,适用于本地工具)

- Streamable HTTP(推荐用于 Web 服务)

- SSE(旧版 Web 传输,已弃用)

你也可以使用 FastMCP CLI 启动服务器。

组合服务器(Composing Servers)

新增于版本:2.2.0

FastMCP 支持通过 import_server(静态复制)和 mount(实时挂载)将多个服务器组合在一起。这样可以将大型应用拆分成模块化组件,或复用已有的服务器。

# 示例:导入子服务器

from fastmcp import FastMCP

import asyncio

main = FastMCP(name="Main")

sub = FastMCP(name="Sub")

@sub.tool

def hello():

return "hi"

# 直接挂载

main.mount(sub, prefix="sub")

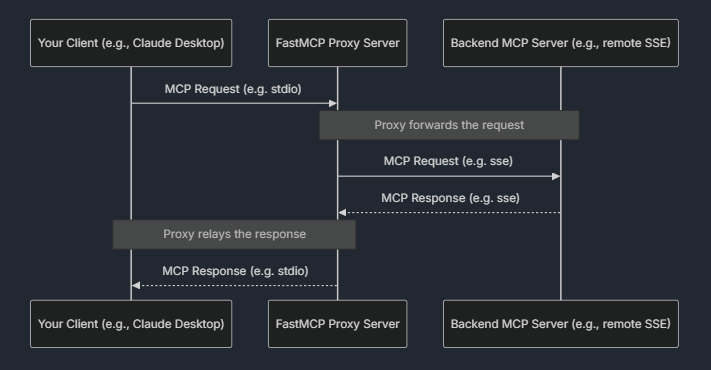

代理服务器(Proxying Servers)

新增于版本:2.0.0

FastMCP 可以通过 FastMCP.as_proxy 将任意 MCP 服务器(本地或远程)作为代理使用,使你可以桥接不同的传输方式,或为已有服务器添加前端接口。例如,可以将远程的 SSE 服务器通过本地 STDIO 暴露出来,反之亦然。

代理服务器在使用“非连接式客户端”时会为每个请求自动创建新的会话,从而安全地并发处理操作。

from fastmcp import FastMCP, Client

backend = Client("http://example.com/mcp/sse")

proxy = FastMCP.as_proxy(backend, name="ProxyServer")

# 现在可以像普通 FastMCP 服务器一样使用 proxy

OpenAPI 集成

新增于版本:2.0.0

FastMCP 可以通过 FastMCP.from_openapi() 或 FastMCP.from_fastapi(),根据 OpenAPI 规范或已有的 FastAPI 应用自动生成 MCP 服务器。

这让你可以立即将现有的 API 转换为 MCP 服务器,无需手动创建工具(tool)。

import httpx

from fastmcp import FastMCP

# 从 OpenAPI 规范创建服务器

spec = httpx.get("https://api.example.com/openapi.json").json()

mcp = FastMCP.from_openapi(openapi_spec=spec, client=httpx.AsyncClient())

# 从 FastAPI 应用创建服务器

from fastapi import FastAPI

app = FastAPI()

mcp = FastMCP.from_fastapi(app=app)

服务器配置(Server Configuration)

FastMCP 服务器可以通过初始化参数、全局设置和传输层设置进行配置。

服务器专属配置(Server-Specific Configuration)

服务器专属设置在创建 FastMCP 实例时传入,用于控制服务器行为:

from fastmcp import FastMCP

# 配置服务器参数

mcp = FastMCP(

name="ConfiguredServer",

dependencies=["requests", "pandas>=2.0.0"], # 可选的依赖包列表

include_tags={"public", "api"}, # 仅暴露包含这些标签的组件

exclude_tags={"internal", "deprecated"}, # 隐藏包含这些标签的组件

on_duplicate_tools="error", # 冲突的工具注册处理策略

on_duplicate_resources="warn", # 冲突的资源注册处理策略

on_duplicate_prompts="replace", # 冲突的提示词注册处理策略

)

构造参数说明(Constructor Parameters)

dependencies

- 类型:

list[str] | None - 用于指定服务器运行所需的依赖包(支持版本号)

include_tags

- 类型:

set[str] | None - 仅暴露至少包含一个指定标签的组件

exclude_tags

- 类型:

set[str] | None - 隐藏任何包含这些标签的组件

on_duplicate_tools

-

类型:

"error" | "warn" | "replace"(默认值:"error") -

冲突的工具(tool)注册处理策略:

error:抛出错误warn:记录警告replace:用新的覆盖旧的

on_duplicate_resources

- 类型:同上(默认值:

"warn") - 冲突的资源(resource)注册处理策略

on_duplicate_prompts

- 类型:同上(默认值:

"replace") - 冲突的提示词(prompt)注册处理策略

以下是你提供内容的中文翻译:

全局设置(Global Settings)

全局设置会影响所有 FastMCP 服务器,可通过环境变量(以 FASTMCP_ 为前缀)或 .env 文件进行配置:

import fastmcp

# 访问全局设置

print(fastmcp.settings.log_level) # 默认值: "INFO"

print(fastmcp.settings.mask_error_details) # 默认值: False

print(fastmcp.settings.resource_prefix_format) # 默认值: "path"

常见的全局设置包括:

- log_level:日志等级(可选值:“DEBUG”、“INFO”、“WARNING”、“ERROR”、“CRITICAL”),通过

FASTMCP_LOG_LEVEL设置 - mask_error_details:是否向客户端隐藏详细错误信息,使用

FASTMCP_MASK_ERROR_DETAILS设置 - resource_prefix_format:资源前缀格式(“path” 或 “protocol”),通过

FASTMCP_RESOURCE_PREFIX_FORMAT设置

传输层配置(Transport-Specific Configuration)

传输设置在运行服务器时提供,用于控制网络行为:

# 使用 mcp.run 配置传输方式

mcp.run(

transport="http",

host="0.0.0.0", # 绑定所有网络接口

port=9000, # 自定义端口

log_level="DEBUG", # 覆盖全局日志等级

)

# 或用于异步方式运行

await mcp.run_async(

transport="http",

host="127.0.0.1",

port=8080,

)

设置全局配置(Setting Global Configuration)

FastMCP 全局设置可通过设置环境变量完成,变量需以 FASTMCP_ 为前缀:

# 配置 FastMCP 的全局行为

export FASTMCP_LOG_LEVEL=DEBUG

export FASTMCP_MASK_ERROR_DETAILS=True

export FASTMCP_RESOURCE_PREFIX_FORMAT=protocol

自定义工具序列化(Custom Tool Serialization)

新增于版本 2.2.7

默认情况下,当工具的返回值需要转换为文本时,FastMCP 会将其序列化为 JSON。你可以通过在创建服务器时提供 tool_serializer 函数,来自定义这一行为:

import yaml

from fastmcp import FastMCP

# 定义一个自定义序列化函数,将字典格式化为 YAML

def yaml_serializer(data):

return yaml.dump(data, sort_keys=False)

# 创建带有自定义序列化器的服务器

mcp = FastMCP(name="MyServer", tool_serializer=yaml_serializer)

@mcp.tool

def get_config():

"""以 YAML 格式返回配置。"""

return {"api_key": "abc123", "debug": True, "rate_limit": 100}

该序列化函数接收任意数据对象,并返回其字符串形式。它会应用于所有非字符串的工具返回值。若工具本身已返回字符串,则不会调用该序列化器。

自定义序列化器在以下情况下非常有用:

- 希望以特定格式输出数据(如 YAML 或自定义格式)

- 控制序列化行为(如缩进、键排序等)

- 在返回给客户端前添加元数据或转换数据

如果自定义序列化函数抛出异常,FastMCP 会自动回退使用默认的 JSON 序列化方式,以避免导致服务器崩溃。

运行你的 FastMCP 服务

FastMCP 服务器可以根据应用需求以不同方式运行,从本地命令行工具到持久化 Web 服务。本指南将重点介绍通过各种传输协议运行服务器的主要方法:STDIO、可流式 HTTP、SSE。

你可以在 Python 中通过调用 FastMCP 实例的 run() 方法来直接运行服务器。

为保证兼容性,推荐将 run() 方法放入 if __name__ == "__main__": 块中,这样确保该脚本仅在直接执行时启动服务,而非被导入时启动。

示例:my_server.py

from fastmcp import FastMCP

mcp = FastMCP(name="MyServer")

@mcp.tool

def hello(name: str) -> str:

return f"Hello, {name}!"

if __name__ == "__main__":

mcp.run()

执行 python my_server.py 即可启动 MCP 服务器。

你可以通过给 run() 传递 transport 和其他关键参数,配置不同的传输方式以满足不同场景需求。

FastMCP 也提供命令行工具,无需修改源码即可运行服务:

fastmcp run server.py

⚠️ 注意:使用

fastmcp run时,会忽略if __name__ == "__main__"块,而是寻找名为mcp、server或app的FastMCP对象,并直接调用其run()方法。

你可以通过 CLI 覆盖源码中指定的传输方式,适合测试或无需更改代码地部署新方法:

fastmcp run server.py --transport sse --port 9000

开发或测试中,也可使用 dev 命令并配合 MCP Inspector 工具运行:

fastmcp dev server.py

当服务支持命令行参数(如通过 argparse 或 click),可在命令末尾添加 -- 来传递参数:

fastmcp run config_server.py -- --config config.json

fastmcp run database_server.py -- --database-path /tmp/db.sqlite --debug

传输协议选项对比

| 传输方式 | 使用场景 | 推荐情况 |

|---|---|---|

| STDIO | 本地工具、命令行脚本、Claude Desktop 等客户端 | 最适合本地工具和客户端启动服务 |

| 可流式 HTTP | Web 服务部署、微服务、对外公开的 MCP 接口 | 推荐用于 Web 服务部署 |

| SSE | 基于 SSE 的旧服务部署 | 已弃用,建议改用 HTTP |

STDIO 是本地运行 MCP 服务的默认传输方式,适用于本地工具、脚本、或 Claude Desktop 这类客户端。

from fastmcp import FastMCP

mcp = FastMCP()

if __name__ == "__main__":

mcp.run(transport="stdio")

通常你无需手动运行服务进程,客户端会为每次会话自动启动新服务。

可流式 HTTP(推荐)

新增于 v2.3.0

这是推荐的 Web 部署方式。默认绑定地址为 127.0.0.1:8000,路径为 /mcp/:

from fastmcp import FastMCP

mcp = FastMCP()

if __name__ == "__main__":

mcp.run(transport="http")

import asyncio

from fastmcp import Client

async def example():

async with Client("http://127.0.0.1:8000/mcp/") as client:

await client.ping()

if __name__ == "__main__":

asyncio.run(example())

自定义端口、路径等:

mcp.run(

transport="http",

host="127.0.0.1",

port=4200,

path="/my-custom-path",

log_level="debug"

)

import asyncio

from fastmcp import Client

async def example():

async with Client("http://127.0.0.1:4200/my-custom-path") as client:

await client.ping()

if __name__ == "__main__":

asyncio.run(example())

可使用别名 "streamable-http" 替代 "http"。

这里的 path 指的是服务器在 HTTP 服务中绑定的 URL 路径前缀。也就是说,当你通过浏览器或客户端访问你的 MCP 服务器时,URL 中需要包含这个路径部分。

举个例子:

- 你设置

path="/my-custom-path" - 服务器地址是

http://127.0.0.1:4200

那么客户端访问时的完整 URL 就是 http://127.0.0.1:4200/my-custom-path,FastMCP 会监听这个路径下的请求。

这个配置主要用于区分不同服务或避免路径冲突,尤其在同一台机器上运行多个 HTTP 服务时非常有用。

SSE(已弃用)

虽然仍支持,但不推荐新项目使用。使用方法如下:

mcp.run(transport="sse")

也可配置端口、路径等:

mcp.run(

transport="sse",

host="127.0.0.1",

port=4200,

path="/my-custom-sse-path",

log_level="debug"

)

异步运行(Async)

如果你在异步上下文中运行应用,应使用 run_async() 方法:

from fastmcp import FastMCP

import asyncio

mcp = FastMCP(name="MyServer")

@mcp.tool

def hello(name: str) -> str:

return f"Hello, {name}!"

async def main():

await mcp.run_async(transport="http")

if __name__ == "__main__":

asyncio.run(main())

run() 方法不能在异步函数(async def)内部调用,因为它内部会创建自己的异步事件循环(async event loop)。

如果你在异步函数中调用 run(),将会报错,提示事件循环已在运行。

正确用法:

- 在 异步函数 中使用

run_async(); - 在 同步上下文 中使用

run()。

此外,run() 和 run_async() 都支持相同的传输参数(如 transport、host、port 等),因此上面的所有示例都适用于这两种方法。

你也可以为你的 FastMCP 服务器添加自定义的 Web 路由,这些路由会和 MCP 端点一起暴露。

实现方法是使用 @custom_route 装饰器。

需要注意的是,这种方式的灵活性不如完整的 ASGI 框架,但对于为独立服务器添加简单的接口(例如健康检查)非常有用。

from fastmcp import FastMCP

from starlette.requests import Request

from starlette.responses import PlainTextResponse

mcp = FastMCP("MyServer")

@mcp.custom_route("/health", methods=["GET"])

async def health_check(request: Request) -> PlainTextResponse:

return PlainTextResponse("OK")

if __name__ == "__main__":

mcp.run()

核心组件

Tools

将函数暴露为可供 MCP 客户端执行的功能。

工具是构建 LLM 与外部系统交互的核心组件。它们允许 LLM 执行代码、访问训练数据之外的信息或系统。在 FastMCP 中,工具就是通过 MCP 协议暴露给大模型的 Python 函数。

在 FastMCP 中,工具会将普通的 Python 函数转换为 LLM 在对话中可调用的能力。当 LLM 决定使用某个工具时:

- 它会根据工具的参数定义发送一个调用请求;

- FastMCP 会根据函数签名验证这些参数;

- 你的函数会使用验证后的参数被执行;

- 执行结果会返回给 LLM,由其用于进一步回答。

这使得 LLM 可以执行如:

- 查询数据库

- 调用 API

- 做数学计算

- 读取或写入文件

等任务,从而将其能力扩展到训练数据之外。

@tool 装饰器

创建工具只需使用 @mcp.tool 装饰一个 Python 函数即可:

from fastmcp import FastMCP

mcp = FastMCP(name="CalculatorServer")

@mcp.tool

def add(a: int, b: int) -> int:

"""Adds two integer numbers together."""

return a + b

当该工具被注册后,FastMCP 会自动:

- 使用函数名

add作为工具名; - 使用函数的文档字符串作为工具说明;

- 根据参数及类型注解自动生成输入参数 schema;

- 处理参数校验与错误报告。

你的函数如何定义,将决定该工具在 LLM 客户端中的展示与行为。

注意:不支持带有

*args或**kwargs的函数作为工具。这是因为 FastMCP 必须为 MCP 协议生成完整的参数 schema,而可变参数无法满足这一要求。

虽然 FastMCP 会自动推断工具的名称和描述,但你也可以通过 @mcp.tool 装饰器的参数覆盖这些默认值,并添加更多元数据:

@mcp.tool(

name="find_products", # 自定义工具名

description="Search the product catalog with optional category filtering.", # 自定义描述

tags={"catalog", "search"}, # 可选标签,用于分类/过滤

)

def search_products_implementation(query: str, category: str | None = None) -> list[dict]:

"""内部函数描述(如果上面有 description,此处将被忽略)"""

print(f"Searching for '{query}' in category '{category}'")

return [{"id": 2, "name": "Another Product"}]

@tool 装饰器参数说明:

| 参数 | 类型 | 说明 |

|---|---|---|

name | str | None | MCP 中暴露的工具名(默认使用函数名) |

description | str | None | MCP 中显示的工具说明(若提供,则忽略函数 docstring) |

tags | set[str] | None | 工具分类标签,便于客户端过滤与组织 |

enabled | bool,默认:True | 是否启用此工具(详见“禁用工具”) |

exclude_args | list[str] | None | 要从 schema 中隐藏的参数名(详见“排除参数”) |

annotations | ToolAnnotations | dict | None | 用于添加附加元信息的对象或字典 |

ToolAnnotations 的常见字段:

| 字段 | 类型 | 说明 |

|---|---|---|

title | str | None | 可读性强的工具标题 |

readOnlyHint | bool | None | 若为 true,表示工具不修改外部环境 |

destructiveHint | bool | None | 若为 true,表示工具可能对环境造成破坏性更改 |

idempotentHint | bool | None | 若为 true,表示重复调用工具不会产生额外副作用 |

openWorldHint | bool | None | 若为 true,工具可能与“开放世界”的外部实体交互;若为 false,工具的交互域是封闭的 |

工具参数(Tool Parameters)

📌 类型注解(Type Annotations)

参数的类型注解是 FastMCP 工具功能正常运行的基础,它们能够:

- 告诉 LLM 每个参数期望的数据类型;

- 让 FastMCP 能验证客户端传入的数据;

- 生成符合 MCP 协议的准确 JSON Schema。

你应使用标准的 Python 类型注解来定义参数类型:

@mcp.tool

def analyze_text(

text: str,

max_tokens: int = 100,

language: str | None = None

) -> dict:

"""分析所提供的文本。"""

# 实现...

📌 参数元数据(Parameter Metadata)

你可以通过 Pydantic 的 Field 类结合 Annotated 提供更多参数元信息。这种方式更现代,推荐使用。

from typing import Annotated

from pydantic import Field

from typing import Literal

@mcp.tool

def process_image(

image_url: Annotated[str, Field(description="要处理的图片 URL")],

resize: Annotated[bool, Field(description="是否调整图像大小")] = False,

width: Annotated[int, Field(description="目标宽度(像素)", ge=1, le=2000)] = 800,

format: Annotated[

Literal["jpeg", "png", "webp"],

Field(description="输出图片格式")

] = "jpeg"

) -> dict:

"""处理图像,可选调整大小。"""

# 实现...

你也可以将 Field 用作默认值,不过推荐使用 Annotated 的方式。

@mcp.tool

def search_database(

query: str = Field(description="搜索关键词"),

limit: int = Field(10, description="返回的最大结果数", ge=1, le=100)

) -> list:

"""使用给定关键词搜索数据库。"""

# 实现...

✅ Field 支持的常用属性:

description: 给 LLM 显示的参数描述;ge,gt,le,lt: 数值上下限;min_length,max_length: 字符串/集合长度限制;pattern: 正则表达式;default: 默认值。

📌 支持的类型(Supported Types)

FastMCP 支持各种类型注解,包括所有 Pydantic 类型:

| 类型类别 | 示例 | 说明 |

|---|---|---|

| 基本类型 | int, float, str | 简单标量类型 |

| 二进制数据 | bytes | 处理文件/图片等 |

| 日期时间 | datetime, date | 时间类型 |

| 集合类型 | list[str], dict | 列表、字典、集合 |

| 可选类型 | float | None | 参数可为 null 或省略 |

| 联合类型 | str | int | 多种类型选择 |

| 约束类型 | Literal["A", "B"] | 限定值域 |

| 路径类型 | Path | 文件路径 |

| UUID | UUID | 唯一标识符 |

| 数据模型 | UserData(Pydantic) | 结构化复杂对象 |

📌 可选参数(Optional Arguments)

FastMCP 遵循 Python 的标准函数参数约定:

- 没有默认值:为必填参数;

- 有默认值:为可选参数。

@mcp.tool

def search_products(

query: str, # 必需

max_results: int = 10, # 可选

sort_by: str = "relevance", # 可选

category: str | None = None # 可选,可为 None

) -> list[dict]:

"""搜索产品目录。"""

# 实现...

上述示例中,

query参数是必填的,其余参数若不传则使用默认值。

排除参数(Excluding Arguments)

2.6.0 版本新增功能

你可以从工具的参数 schema 中排除某些参数,使其不暴露给 LLM。这对于在运行时由服务器注入的参数(例如 state、user_id 或 credentials)非常有用,不应暴露给 LLM 或客户端。只有具有默认值的参数才能被排除,尝试排除必填参数会导致报错。

示例:

@mcp.tool(

name="get_user_details",

exclude_args=["user_id"]

)

def get_user_details(user_id: str = None) -> str:

# user_id 会由服务器在运行时注入,而不是由 LLM 提供

...

配置后,user_id 将不会出现在工具的参数 schema 中,但仍可以在运行时由服务器或框架设置。

禁用工具(Disabling Tools)

2.8.0 版本新增功能

你可以通过启用或禁用工具来控制其可见性和可用性。这对于功能开关控制、维护模式或根据不同客户端动态变更工具集非常有用。被禁用的工具不会出现在 list_tools 返回的可用工具列表中,调用禁用的工具会报错“Unknown tool”(未知工具),行为等同于该工具不存在。

默认情况下,所有工具都是启用的。你可以在定义时通过 enabled 参数禁用工具:

@mcp.tool(enabled=False)

def maintenance_tool():

"""此工具当前正在维护中。"""

return "This tool is disabled."

你也可以在程序运行时动态启用或禁用工具:

@mcp.tool

def dynamic_tool():

return "I am a dynamic tool."

# 禁用后再启用

dynamic_tool.disable()

dynamic_tool.enable()

异步工具(Async Tools)

FastMCP 同时支持标准函数(def)和异步函数(async def)作为工具。

# 同步工具(适合 CPU 密集型或快速任务)

@mcp.tool

def calculate_distance(lat1: float, lon1: float, lat2: float, lon2: float) -> float:

"""计算两个坐标之间的距离。"""

return 42.5

# 异步工具(适合 I/O 密集型任务)

@mcp.tool

async def fetch_weather(city: str) -> dict:

"""获取某城市当前天气状况。"""

async with aiohttp.ClientSession() as session:

async with session.get(f"https://api.example.com/weather/{city}") as response:

response.raise_for_status()

return await response.json()

当你的工具需要进行外部系统操作(如网络请求、数据库查询、文件访问等),建议使用 async def,以保持服务器响应性,避免阻塞事件循环。

返回值(Return Values)

FastMCP 工具可以返回两种互补格式的数据:传统内容块(如文本、图片)和结构化输出(可被机器解析的 JSON)。

当你为返回值添加类型注解时,FastMCP 会自动生成输出模式(schema),用于验证结构化数据,并让客户端能够将结果反序列化为 Python 对象。

理解这三个概念如何协作:

- 返回值(Return Values):你的 Python 函数返回的内容,决定了内容块和结构化数据的值。

- 结构化输出(Structured Outputs):伴随传统内容一起发送的 JSON 数据,供机器处理。

- 输出模式(Output Schemas):用于描述和验证结构化输出格式的 JSON Schema 定义。

内容块(Content Blocks)

FastMCP 会自动将工具的返回值转换为合适的 MCP 内容块:

| Python 返回类型 | 转换后的内容块类型 |

|---|---|

str | 作为 TextContent 发送 |

bytes | base64 编码后作为 EmbeddedResource 内的 BlobResourceContents 发送 |

fastmcp.utilities.types.Image | 作为 ImageContent 发送 |

fastmcp.utilities.types.Audio | 作为 AudioContent 发送 |

fastmcp.utilities.types.File | base64 编码后作为 EmbeddedResource 发送 |

list[上述类型之一] | 每个元素都会被相应转换 |

None | 结果为空响应 |

结构化输出(Structured Output)

2.10.0 版本新增功能

2025 年 6 月 18 日的 MCP 规范更新引入了结构化内容的概念,这是一种全新的工具返回数据的方式。结构化内容是一段 JSON 数据,会与传统内容一起发送。

当你的工具返回的数据具有 JSON 对象表示时,FastMCP 会自动创建结构化输出,提供可供机器读取的 JSON 数据,客户端可以直接将其反序列化为 Python 对象。

自动结构化输出规则:

- 对象类返回值(如 dict、Pydantic 模型、dataclass):始终生成结构化内容(即使没有输出 schema)

- 非对象返回值(如 int、str、list):仅在提供输出 schema 的情况下才生成结构化内容

- 所有返回值:总会生成传统内容块(用于兼容旧版客户端)

这使得 LLM 客户端在无需额外配置的情况下,也能接收人类可读内容 + 机器可读结构。

对象类返回值(自动结构化内容)

@mcp.tool

def get_user_data(user_id: str) -> dict:

"""不带类型注解地返回用户信息。"""

return {"name": "Alice", "age": 30, "active": True}

传统content:

"{\n \"name\": \"Alice\",\n \"age\": 30,\n \"active\": true\n}"

结构化content:

{

"name": "Alice",

"age": 30,

"active": true

}

即使没有显式类型注解,也会自动生成结构化内容。

如果你返回的是原始类型(如 int),则只有在添加了输出 schema 的情况下才生成结构化内容:

@mcp.tool

def calculate_sum(a: int, b: int):

return a + b # 仅返回传统内容,不生成结构化 JSON

传统content:

"8"

带有schema:

@mcp.tool

def calculate_sum(a: int, b: int) -> int:

"""Calculate sum with return annotation."""

return a + b # Returns 8

传统content:

"8"

结构化content:

{

"result": 8

}

复杂示例:

from dataclasses import dataclass

from fastmcp import FastMCP

mcp = FastMCP()

@dataclass

class Person:

name: str

age: int

email: str

@mcp.tool

def get_user_profile(user_id: str) -> Person:

"""Get a user's profile information."""

return Person(name="Alice", age=30, email="alice@example.com")

生成的schema:

{

"properties": {

"name": {"title": "Name", "type": "string"},

"age": {"title": "Age", "type": "integer"},

"email": {"title": "Email", "type": "string"}

},

"required": ["name", "age", "email"],

"title": "Person",

"type": "object"

}

结构化输出:

{

"name": "Alice",

"age": 30,

"email": "alice@example.com"

}

输出模式(Output Schemas)

2.10.0 版本新增功能

2025 年 6 月的 MCP 规范更新引入了输出模式(output schemas),用于描述工具的预期返回格式。

当你在函数中添加返回类型注解时,FastMCP 会自动生成对应的 JSON schema,帮助客户端验证和理解结构化数据。

原始类型包装(Primitive Type Wrapping),当返回的是原始类型(如 int、str、bool)时,FastMCP 会将其自动包装成如下格式:

@mcp.tool

def calculate_sum(a: int, b: int) -> int:

"""Add two numbers together."""

return a + b

{

"type": "object",

"properties": {

"result": {"type": "integer"}

},

"x-fastmcp-wrap-result": true

}

{

"result": 42

}

你也可以显式指定输出 schema:

@mcp.tool(output_schema={

"type": "object",

"properties": {

"data": {"type": "string"},

"metadata": {"type": "object"}

}

})

def custom_schema_tool() -> dict:

return {"data": "Hello", "metadata": {"version": "1.0"}}

支持自动生成输出模式的类型包括:基础类型、集合、联合类型、Pydantic 模型、TypedDict、dataclass 等。

⚠️ 注意事项:

- 输出 schema 必须是 JSON 对象(

"type": "object") - 如果指定了输出 schema,返回值必须符合这个 schema

- 即使没有 schema,也可以返回结构化内容(例如使用

ToolResult)

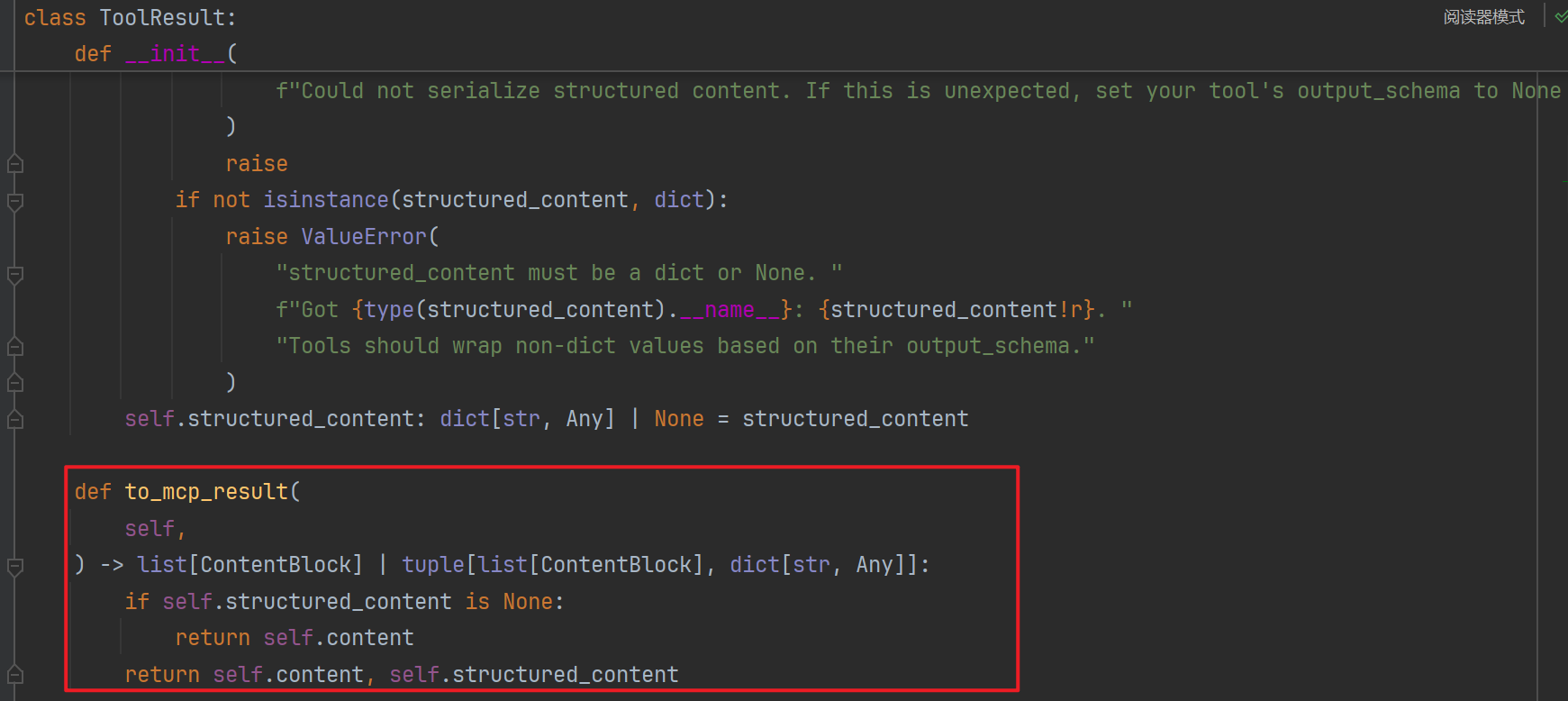

完全控制输出:ToolResult

如果你想完全控制返回的传统内容和结构化内容,可以返回一个 ToolResult 对象:

from fastmcp.tools.tool import ToolResult

@mcp.tool

def advanced_tool() -> ToolResult:

return ToolResult(

content=[TextContent(text="这是面向人类的内容")],

structured_content={"data": "value", "count": 42}

)

使用 ToolResult 的好处:

- 可以精确控制发送的内容和结构化数据

- 是否定义输出模式(schema)是可选的

- 客户端将收到内容块 + JSON 数据

如果你的返回类型无法转换为 JSON schema(例如自定义类,但未使用 Pydantic),那么输出 schema 会被忽略,但传统内容仍然可以正常使用。

错误处理(Error Handling)

新版本:2.4.1

当你的工具发生错误时,可以抛出标准的 Python 异常(如 ValueError、TypeError、FileNotFoundError,或自定义异常),也可以抛出 FastMCP 提供的 ToolError。

默认情况下,所有异常(包括详细信息)都会被记录并转换为 MCP 错误响应,返回给客户端 LLM,以帮助 LLM 识别失败原因并做出相应应对。

如果出于安全考虑希望隐藏内部错误细节,你可以:

-

✅ 使用

mask_error_details=True初始化 FastMCP 实例:mcp = FastMCP(name="SecureServer", mask_error_details=True) -

✅ 或者使用

ToolError明确指定要发送给客户端的错误信息:from fastmcp import FastMCP from fastmcp.exceptions import ToolError @mcp.tool def divide(a: float, b: float) -> float: """a 除以 b。""" if b == 0: raise ToolError("不允许除以 0。") if not isinstance(a, (int, float)) or not isinstance(b, (int, float)): raise TypeError("两个参数都必须是数字。") return a / b

若设置了

mask_error_details=True,只有ToolError的消息会暴露细节,其他异常将返回通用错误提示。

注解(Annotations)

新版本:2.2.7

FastMCP 允许你通过注解为工具添加专门的元数据。这些注解向客户端应用传达工具的行为方式,而不会占用 LLM 提示中的 token 上下文。

注解在客户端应用中有多种用途:

- 为显示目的添加用户友好的标题

- 指示工具是否会修改数据或系统

- 描述工具的安全特性(破坏性或非破坏性)

- 表明工具是否与外部系统交互

你可以通过 @mcp.tool 装饰器中的 annotations 参数为工具添加注解:

@mcp.tool(

annotations={

"title": "计算加法",

"readOnlyHint": True,

"openWorldHint": False

}

)

def calculate_sum(a: float, b: float) -> float:

"""Add two numbers together."""

return a + b

支持的标准注解:

| 注解名称 | 类型 | 默认值 | 说明 |

|---|---|---|---|

title | string | - | 工具在 UI 中显示的名称 |

readOnlyHint | boolean | false | 是否为只读工具(无状态更改) |

destructiveHint | boolean | true | 如果非只读,是否有破坏性更改 |

idempotentHint | boolean | false | 多次调用是否和一次调用效果一致 |

openWorldHint | boolean | true | 工具是否连接到外部系统 |

注解是提示性质的,仅帮助前端界面展示与交互,并不会强制实施安全策略。请准确表达工具行为以避免误导。

工具变更通知(Notifications)

新版本:2.9.1

FastMCP 会在工具被添加、移除、启用或禁用时自动发送 tools/list_changed 通知,帮助客户端实时同步工具列表,无需手动轮询。

@mcp.tool

def example_tool() -> str:

return "Hello!"

mcp.add_tool(example_tool) # 发送通知

example_tool.disable() # 发送通知

example_tool.enable() # 发送通知

mcp.remove_tool("example_tool") # 发送通知

只有在MCP 请求上下文中执行这些操作时才会发送通知(如:在某个工具内部调用)。服务器初始化期间执行这些操作不会触发通知。

客户端可监听这些通知以更新工具界面或工具列表。

这个意思是说:

-

通知触发时机有限制:只有当你在运行中的 MCP 请求过程中,比如某个工具正在被调用时,对工具进行添加、删除、启用、禁用等操作,才会触发通知发送给客户端。

-

启动时操作不触发通知:如果你在服务器刚启动初始化阶段,对工具进行类似操作(比如预先注册一些工具),这些操作不会触发通知。

-

客户端自动响应通知:客户端收到通知后,可以通过消息处理器(类似事件监听器)自动刷新它们的工具列表或更新界面,从而保证客户端显示的是最新的工具状态,无需手动刷新。

总结就是:通知机制设计成只针对“运行时动态变更”有效,帮助客户端实时同步工具变化;而初始化阶段的设置被认为是“静态配置”,不需要通知。 这样避免了初始化时的重复或无用通知,且保证客户端和服务器状态实时一致。你可以把通知看成是一种“热更新”提醒。

MCP 上下文

工具可以通过 Context 对象访问 MCP 功能,比如日志记录、读取资源或报告进度。使用时,只需在工具函数中添加一个类型标注为 Context 的参数。

示例代码:

from fastmcp import FastMCP, Context

mcp = FastMCP(name="ContextDemo")

@mcp.tool

async def process_data(data_uri: str, ctx: Context) -> dict:

"""处理资源中的数据并报告进度。"""

await ctx.info(f"正在处理来自 {data_uri} 的数据")

# 读取资源

resource = await ctx.read_resource(data_uri)

data = resource[0].content if resource else ""

# 报告进度

await ctx.report_progress(progress=50, total=100)

# 向客户端的 LLM 请求帮助示例

summary = await ctx.sample(f"用10个词总结以下内容: {data[:200]}")

await ctx.report_progress(progress=100, total=100)

return {

"length": len(data),

"summary": summary.text

}

Context 对象提供以下功能访问:

- 日志记录:

ctx.debug(),ctx.info(),ctx.warning(),ctx.error() - 进度报告:

ctx.report_progress(progress, total) - 资源访问:

ctx.read_resource(uri) - LLM 采样调用:

ctx.sample(...) - 请求信息:

ctx.request_id,ctx.client_id

参数类型详解

FastMCP 支持多种参数类型,方便你设计工具时灵活选择。

FastMCP 通常支持 Pydantic 支持作为字段的所有类型,包括所有 Pydantic 自定义类型。也就是说,你可以在工具参数中使用任何 Pydantic 能验证和解析的类型。

FastMCP 支持类型强制转换(type coercion)。当客户端发送的数据类型与期望类型不匹配时,FastMCP 会尝试转换为合适的类型。例如,如果客户端传入字符串但参数注解为 int,FastMCP 会尝试将其转换为整数;若无法转换,则返回验证错误。

内置类型

最常见的参数类型是 Python 的内置标量类型:

@mcp.tool

def process_values(

name: str, # 文本数据

count: int, # 整数

amount: float, # 浮点数

enabled: bool # 布尔值(True/False)

):

"""处理各种类型的值。"""

# 实现逻辑...

这些类型明确告诉 LLM 可接受的值类型,FastMCP 也能正确验证输入。即使客户端传了字符串 “42”,参数注解为 int 时也会被自动转换为整数。

日期和时间类型

FastMCP 支持来自 datetime 模块的多种日期和时间类型:

from datetime import datetime, date, timedelta

@mcp.tool

def process_date_time(

event_date: date, # ISO 格式日期字符串或 date 对象

event_time: datetime, # ISO 格式日期时间字符串或 datetime 对象

duration: timedelta = timedelta(hours=1) # 整数秒或 timedelta 对象

) -> str:

"""处理日期和时间信息。"""

assert isinstance(event_date, date)

assert isinstance(event_time, datetime)

assert isinstance(duration, timedelta)

return f"Event on {event_date} at {event_time} for {duration}"

datetime— 接受 ISO 格式字符串(如 “2023-04-15T14:30:00”)date— 接受 ISO 格式日期字符串(如 “2023-04-15”)timedelta— 接受整数秒数或 timedelta 对象

集合类型

FastMCP 支持所有标准 Python 集合类型:

@mcp.tool

def analyze_data(

values: list[float], # 数字列表

properties: dict[str, str], # 字符串键值对字典

unique_ids: set[int], # 唯一整数集合

coordinates: tuple[float, float], # 固定结构元组

mixed_data: dict[str, list[int]] # 嵌套集合

):

"""分析数据集合。"""

# 实现逻辑...

支持的集合类型:

list[T]— 有序序列dict[K, V]— 键值映射set[T]— 无序唯一元素集合tuple[T1, T2, ...]— 固定长度、类型可不同的序列

集合类型支持嵌套组合,符合结构的 JSON 字符串会自动解析转换为对应的 Python 集合类型。

联合和可选类型

对于允许多种类型或可选的参数:

@mcp.tool

def flexible_search(

query: str | int, # 可以是字符串或整数

filters: dict[str, str] | None = None, # 可选字典

sort_field: str | None = None # 可选字符串

):

"""支持灵活参数类型的搜索。"""

# 实现逻辑...

推荐使用现代 Python 语法 str | int 替代旧的 Union[str, int],str | None 替代 Optional[str]。

约束类型

当参数必须是预定义集合中的值时,可以使用 Literal 类型或枚举(Enum)。

字面量(Literals)

Literals 用于将参数限制为特定的一组值:

from typing import Literal

@mcp.tool

def sort_data(

data: list[float],

order: Literal["ascending", "descending"] = "ascending",

algorithm: Literal["quicksort", "mergesort", "heapsort"] = "quicksort"

):

"""使用特定选项对数据进行排序。"""

# 实现逻辑...

Literal 类型的作用:

- 在类型注解中直接指定允许的具体值

- 帮助 LLM 精确理解哪些值是可接受的

- 提供输入验证(无效值会报错)

- 为客户端创建清晰的参数结构

枚举(Enums)

对于更结构化的约束值集合,可以使用 Python 的 Enum 类:

from enum import Enum

class Color(Enum):

RED = "red"

GREEN = "green"

BLUE = "blue"

@mcp.tool

def process_image(

image_path: str,

color_filter: Color = Color.RED

):

"""使用颜色过滤器处理图像。"""

# 实现逻辑...

# color_filter 是 Color 枚举成员

使用 Enum 类型时需要注意:

- 客户端应传入枚举值(如 “red”),而不是枚举成员名(如 “RED”)

- FastMCP 会自动将字符串值转换为对应的 Enum 对象

- 你的函数实际接收到的是枚举成员(例如 Color.RED)

- 对于不在枚举中的值,会抛出验证错误

二进制数据

在工具参数中处理二进制数据有两种方式:

Bytes

@mcp.tool

def process_binary(data: bytes):

"""直接处理二进制数据。

客户端可以发送二进制字符串,会直接转换为 bytes 类型。

"""

# 使用二进制数据实现逻辑

data_length = len(data)

# ...

当你将参数标注为 bytes 时,FastMCP 会:

- 直接将原始字符串转换为 bytes

- 验证输入是否能被正确表示为 bytes

注意:FastMCP 不会自动对 base64 编码的字符串做解码。如果需要接受 base64 编码的数据,需要手动解码,如下所示。

Base64 编码字符串

from typing import Annotated

from pydantic import Field

@mcp.tool

def process_image_data(

image_data: Annotated[str, Field(description="Base64编码的图像数据")]

):

"""处理来自 base64 编码字符串的图像。

客户端预期提供 base64 编码的字符串数据。

你需要手动进行解码。

"""

import base64

binary_data = base64.b64decode(image_data)

# 处理 binary_data...

当预期客户端发送 base64 编码的二进制数据时,推荐使用此方式。

路径(Paths)

可以使用 pathlib 模块中的 Path 类型表示文件系统路径:

from pathlib import Path

@mcp.tool

def process_file(path: Path) -> str:

"""处理指定路径的文件。"""

assert isinstance(path, Path) # 路径已正确转换为 Path 对象

return f"正在处理路径 {path} 的文件"

客户端发送字符串路径时,FastMCP 会自动转换成 Path 对象。

UUID

可以使用 uuid 模块中的 UUID 类型表示唯一标识符:

import uuid

@mcp.tool

def process_item(

item_id: uuid.UUID # 字符串 UUID 或 UUID 对象

) -> str:

"""处理指定 UUID 的条目。"""

assert isinstance(item_id, uuid.UUID) # 已正确转换为 UUID 对象

return f"正在处理条目 {item_id}"

当客户端发送字符串形式的 UUID(例如 “123e4567-e89b-12d3-a456-426614174000”)时,FastMCP 会自动转换成 UUID 对象。

Pydantic 模型

对于复杂的结构化数据(带嵌套字段和验证),可以使用 Pydantic 模型:

from pydantic import BaseModel, Field

from typing import Optional

class User(BaseModel):

username: str

email: str = Field(description="用户的邮箱地址")

age: int | None = None

is_active: bool = True

@mcp.tool

def create_user(user: User):

"""在系统中创建新用户。"""

# 输入会自动根据 User 模型进行验证

# 即使输入是 JSON 字符串或字典也会自动转换

# 实现逻辑...

使用 Pydantic 模型带来的好处:

- 对复杂输入提供清晰、可自描述的结构

- 内置数据验证

- 自动生成详细的 JSON schema 供 LLM 使用

- 自动从 dict/JSON 输入转换

客户端可以用以下形式为 Pydantic 模型参数提供数据:

- JSON 对象(字符串形式)

- 具有相应结构的字典

- 嵌套的参数格式

FastMCP 通过 Pydantic 的 Field 类支持强大的参数验证,这特别有助于确保输入值满足除类型之外的特定要求。

字段也可以用在 Pydantic 模型外,为参数提供元数据和验证约束。推荐的做法是使用 Annotated 搭配 Field:

from typing import Annotated

from pydantic import Field

@mcp.tool

def analyze_metrics(

# 带范围约束的数字

count: Annotated[int, Field(ge=0, le=100)], # 0 <= count <= 100

ratio: Annotated[float, Field(gt=0, lt=1.0)], # 0 < ratio < 1.0

# 带正则和长度约束的字符串

user_id: Annotated[str, Field(

pattern=r"^[A-Z]{2}\d{4}$", # 必须匹配正则表达式

description="格式为 XX0000 的用户ID"

)],

# 带长度约束的字符串

comment: Annotated[str, Field(min_length=3, max_length=500)] = "",

# 数值约束

factor: Annotated[int, Field(multiple_of=5)] = 10, # 必须是5的倍数

):

"""用验证过的参数分析指标。"""

# 实现逻辑...

你也可以直接用 Field 作为默认值,虽然推荐用 Annotated 的方式:

@mcp.tool

def validate_data(

# 值约束

age: int = Field(ge=0, lt=120), # 0 <= age < 120

# 字符串约束

email: str = Field(pattern=r"^[\w\.-]+@[\w\.-]+\.\w+$"), # 邮箱格式

# 集合约束

tags: list[str] = Field(min_length=1, max_length=10) # 1-10 个标签

):

"""带字段验证处理数据。"""

# 实现逻辑...

常见的验证选项:

| 验证选项 | 类型 | 描述 |

|---|---|---|

| ge, gt | 数字 | 大于或等于 (greater or equal) |

| le, lt | 数字 | 小于或等于 (less or equal) |

| multiple_of | 数字 | 必须是该数字的倍数 |

| min_length, max_length | 字符串、列表等 | 长度限制 |

| pattern | 字符串 | 正则表达式约束 |

| description | 任意类型 | 可读的说明(显示在 schema 中) |

当客户端发送无效数据时,FastMCP 会返回验证错误,说明该参数为什么验证失败。

服务器行为

重复工具

新增于版本:2.1.0

你可以控制 FastMCP 服务器在尝试注册多个同名工具时的行为。通过创建 FastMCP 实例时传入参数 on_duplicate_tools 来配置:

from fastmcp import FastMCP

mcp = FastMCP(

name="StrictServer",

# 配置遇到重复工具名时的行为

on_duplicate_tools="error"

)

@mcp.tool

def my_tool(): return "版本 1"

# 由于 'my_tool' 已存在且 on_duplicate_tools 设置为 "error",

# 下面这段代码会抛出 ValueError。

# @mcp.tool

# def my_tool(): return "版本 2"

重复工具的行为选项包括:

"warn"(默认):记录警告,新工具替换旧工具。"error":抛出 ValueError,阻止重复注册。"replace":静默替换已有工具。"ignore":保留原有工具,忽略新注册请求。

移除工具

新增于版本:2.3.4

你可以动态地使用 remove_tool 方法从服务器中移除工具:

from fastmcp import FastMCP

mcp = FastMCP(name="DynamicToolServer")

@mcp.tool

def calculate_sum(a: int, b: int) -> int:

"""将两个数字相加。"""

return a + b

mcp.remove_tool("calculate_sum")

资源与模板——向你的 MCP 客户端暴露数据源和动态内容生成器

资源表示 MCP 客户端可以读取的数据或文件,而资源模板则扩展了这一概念,允许客户端根据 URI 中传入的参数请求动态生成的资源。

FastMCP 简化了静态和动态资源的定义,主要通过使用 @mcp.resource 装饰器来实现。

什么是资源?

资源为 LLM 或客户端应用提供只读的数据访问。当客户端请求资源 URI 时:

- FastMCP 查找对应的资源定义。

- 如果资源是动态的(由函数定义),则执行该函数。

- 返回内容(文本、JSON、二进制数据)给客户端。

这使得 LLM 能够访问文件、数据库内容、配置或与对话相关的动态生成信息。

@resource 装饰器

定义资源最常用的方法是装饰一个 Python 函数。装饰器需要资源的唯一 URI。

import json

from fastmcp import FastMCP

mcp = FastMCP(name="DataServer")

# 基本的动态资源,返回字符串

@mcp.resource("resource://greeting")

def get_greeting() -> str:

"""提供一个简单的问候信息。"""

return "Hello from FastMCP Resources!"

# 返回 JSON 数据的资源(dict 会自动序列化)

@mcp.resource("data://config")

def get_config() -> dict:

"""以 JSON 形式提供应用配置。"""

return {

"theme": "dark",

"version": "1.2.0",

"features": ["tools", "resources"],

}

关键概念:

-

URI:

@resource的第一个参数是资源的唯一 URI(例如"resource://greeting"),客户端通过该 URI 请求数据。 -

延迟加载:被装饰的函数(如

get_greeting,get_config)仅在客户端通过resources/read明确请求该 URI 时执行。 -

推断元数据:默认情况下:

- 资源名称取自函数名(如

get_greeting)。 - 资源描述取自函数的 docstring。

- 资源名称取自函数名(如

你可以通过 @mcp.resource 装饰器的参数自定义资源属性:

from fastmcp import FastMCP

mcp = FastMCP(name="DataServer")

# 示例:指定元数据

@mcp.resource(

uri="data://app-status", # 明确的 URI(必填)

name="ApplicationStatus", # 自定义名称

description="Provides the current status of the application.", # 自定义描述

mime_type="application/json", # 明确 MIME 类型

tags={"monitoring", "status"} # 分类标签

)

def get_application_status() -> dict:

"""内部函数描述(如果上面提供了 description 则忽略此处)"""

return {"status": "ok", "uptime": 12345, "version": mcp.settings.version} # 示例返回

@resource 装饰器参数说明:

-

uri

类型:str(必填)

资源的唯一标识符。 -

name

类型:str | None

资源的人类可读名称。如果未提供,默认为函数名。 -

description

类型:str | None

资源的说明文字。如果未提供,默认为函数的 docstring。 -

mime_type

类型:str | None

指定内容类型。FastMCP 通常会自动推断默认值,如text/plain或application/json,但非文本类型最好显式指定。 -

tags

类型:set[str] | None

用于分类的一组字符串,客户端可能会用来过滤。 -

enabled

类型:bool,默认值:True

用于启用或禁用该资源。详情见“禁用资源”部分。

返回值

FastMCP 会自动将函数的返回值转换为适当的 MCP 资源内容:

- str:作为

TextResourceContents发送(默认mime_type="text/plain")。 - dict, list, pydantic.BaseModel:自动序列化为 JSON 字符串,作为

TextResourceContents发送(默认mime_type="application/json")。 - bytes:进行 Base64 编码后作为