逻辑回归和线性回归的区别:(1)逻辑回归和多重线性回归在因变量上不同,逻辑回归的因变量是二项分布,多重线性回归的因变量是连续的

(2)逻辑回归是分类算法,可以是二分类,也可以是多分类

(3)逻辑回归算法实在线性回归上加上了激励函数,其实就是把线性回归的预测值根据激励函数映射到【0,1】之间,大于0.5就归为1,其他归为0

逻辑回归的原理:基于sigmoid函数,把线性回归的预测值映射到【0,1】之间

逻辑回归损失函数:

线性回归的函数:![]()

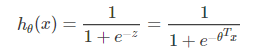

sigmoid函数公式:

因为sigmoid函数的值域是[0,1]所以将线性回归带入到sigmoid函数中得到逻辑回归的函数,而且因为逻辑回归是个分类问题所以要满足概率之和为1,所以:

P(y=1|x;θ)=hθ(x), P(y=0|x;θ)=1−hθ(x)

根据概率论中极大似然估计构造损失函数:![]()

推导过程以及正则化:大佬写的更清楚些:https://blog.youkuaiyun.com/chibangyuxun/article/details/53148005

逻辑回归的优缺点:

优点:速度快,很适合二分类问题

算法简单,易于理解

缺点:应用场景有限,数据容易欠拟合,分类精度可能不高

适用数据类型:数值型,标称型数据

样本不均匀的解决办法:

1.增加数据

2.尝试产生人工数据样本

3.尝试其它评价指标

4.对数据集进行重采样

5.尝试不同的分类算法等

参考资料:《统计学习方法》--李航

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?