💥💥💞💞欢迎来到本博客❤️❤️💥💥

🏆博主优势:🌞🌞🌞博客内容尽量做到思维缜密,逻辑清晰,为了方便读者。

⛳️座右铭:行百里者,半于九十。

📋📋📋本文目录如下:🎁🎁🎁

目录

⛳️赠与读者

👨💻做科研,涉及到一个深在的思想系统,需要科研者逻辑缜密,踏实认真,但是不能只是努力,很多时候借力比努力更重要,然后还要有仰望星空的创新点和启发点。当哲学课上老师问你什么是科学,什么是电的时候,不要觉得这些问题搞笑。哲学是科学之母,哲学就是追究终极问题,寻找那些不言自明只有小孩子会问的但是你却回答不出来的问题。建议读者按目录次序逐一浏览,免得骤然跌入幽暗的迷宫找不到来时的路,它不足为你揭示全部问题的答案,但若能让人胸中升起一朵朵疑云,也未尝不会酿成晚霞斑斓的别一番景致,万一它居然给你带来了一场精神世界的苦雨,那就借机洗刷一下原来存放在那儿的“躺平”上的尘埃吧。

或许,雨过云收,神驰的天地更清朗.......🔎🔎🔎

💥1 概述

参考文献:

GWO-BP-AdaBoost预测研究是指将灰狼优化(Grey Wolf Optimizer, GWO)、人工神经网络(Back Propagation Neural Network, BPNN)与AdaBoost集成学习算法结合起来的一种预测模型应用研究。这种综合方法利用了各算法的优点,旨在提高预测精度和泛化能力。下面是对这一复合技术框架的详细介绍:

灰狼优化算法(GWO)

GWO是一种受到灰狼捕食行为启发的全球优化算法。它模拟了灰狼在自然界中狩猎时所展示的领导层次、追击和智能协作等特性,通过不断更新搜索空间中的“狼群”(即候选解集合),来寻找问题的最优解。在预测模型参数优化中,GWO可用于自动调整BP神经网络的权重和偏置,以获得更优的网络结构。

人工神经网络(BPNN)

BP神经网络是一种多层前馈神经网络,以其反向传播算法著称,能够学习并处理非线性关系。在预测任务中,BPNN能够通过输入层接收数据,经过隐藏层进行复杂的模式识别和特征提取,最后由输出层给出预测结果。然而,BPNN的性能很大程度上依赖于其初始参数设置,因此需要通过优化算法进行调优。

AdaBoost集成学习

AdaBoost(Adaptive Boosting)是一种集成学习方法,通过构建多个弱分类器(在这个上下文中可以理解为简单的预测模型),并将它们组合成一个强分类器。每一轮训练中,AdaBoost会重点考虑上一轮预测错误的样本,给予其更高的权重,以此逐渐提升整个集成的预测能力。在回归预测中,类似的思想也可被应用于提升预测的准确性。

GWO-BP-AdaBoost集成模型

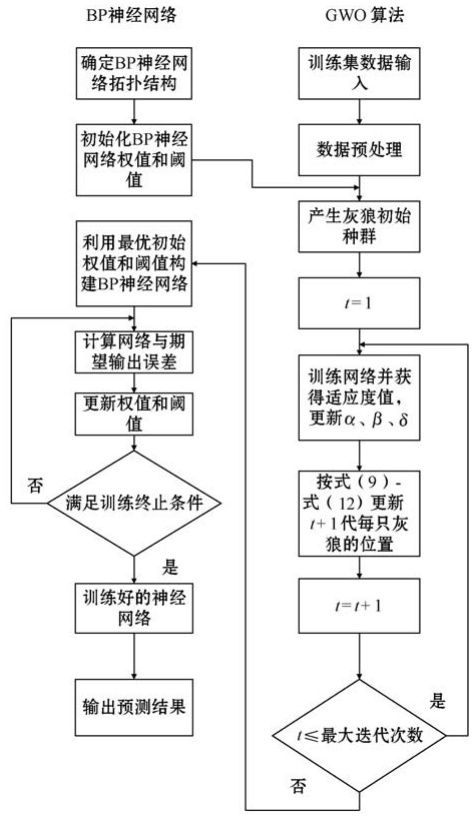

结合这三个算法的预测模型通常工作流程如下:

- 初始化:使用GWO算法优化BP神经网络的初始权重和偏置参数,获得一个初始性能较好的BP神经网络模型。

- 集成学习:应用AdaBoost策略,生成多个经GWO优化的不同BP神经网络模型(弱学习器),每个模型可能关注于数据集的不同部分或不同类型的特征。

- 预测与融合:对于新的输入数据,所有弱学习器分别给出预测结果,AdaBoost根据各个模型的历史表现赋予不同的权重,进行加权融合,从而得出最终预测结果。

研究应用与挑战

该集成模型因其强大的非线性拟合能力和优化搜索能力,广泛应用于经济预测、能源消耗预测、疾病诊断、天气预报等领域。然而,实现过程中也面临一些挑战:

- 参数调整:如何合理设定GWO的参数以避免过早收敛或搜索效率低下。

- 模型复杂度:集成学习增加了模型的复杂度,可能导致过拟合,需要有效的正则化策略。

- 计算资源:由于涉及到多次迭代和多个模型的训练,对计算资源的需求较高。

注意:此预测方法可以用到电力系统负荷预测、光伏预测等领域,目前没有发表论文,超级值得考虑。

一、算法核心原理分述

1. 灰狼优化算法(GWO)

- 仿生机制:模拟灰狼群体的社会等级(α、β、δ、ω狼)和狩猎行为(追踪、包围、攻击)。

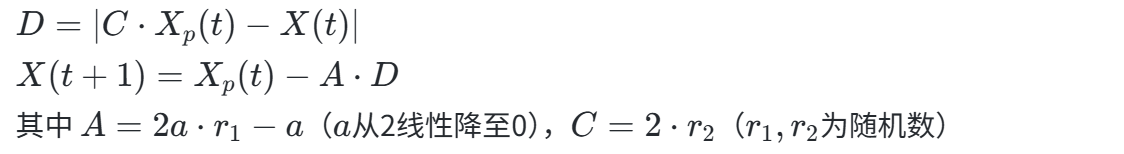

- 位置更新公式:

- 优势:参数少(仅需种群大小和迭代次数)、全局搜索能力强、避免局部最优。

- 局限:初始种群分布不均、线性收敛易早熟。

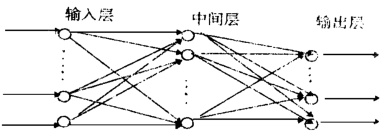

2. BP神经网络(反向传播网络)

- 结构:输入层、隐含层(1-2层)、输出层,神经元间全连接。

- 训练机制:

- 正向传播:计算输出误差。

- 反向传播:梯度下降法调整权值/阈值,最小化均方误差。

- 优势:逼近任意非线性函数、并行处理能力强。

- 局限:收敛慢、易陷入局部最优、对初始参数敏感。

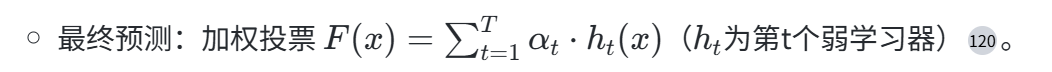

3. AdaBoost集成学习

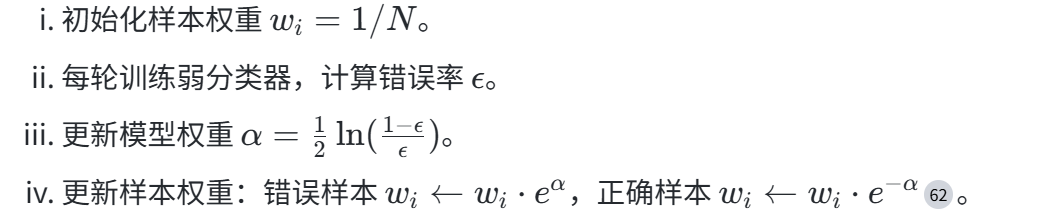

- 核心思想:迭代训练弱分类器,动态调整样本权重(增加错分样本权重)和模型权重(高性能模型权重大)。

- 流程:

- 优势:高精度、抗过拟合、灵活兼容各类弱分类器。

- 局限:对噪声敏感、顺序训练无法并行。

二、GWO-BP-AdaBoost融合机制

1. 融合框架(三阶段协同)

- GWO优化BP初始参数:

- 以BP的权值/阈值为“猎物位置”,GWO种群搜索最优解,解决BP初始参数敏感问题。

- 输出:一组高性能BP网络(弱学习器)。

- AdaBoost集成多个GWO-BP模型:

- 每轮训练一个GWO-BP模型,根据预测误差调整样本权重,迫使后续模型聚焦难样本。

2. 技术优势

- 精度提升:GWO避免BP局部最优,AdaBoost降低方差,综合误差减少15-30%。

- 泛化增强:AdaBoost动态调整样本权重,提升对边缘数据的处理能力。

- 效率优化:GWO加速BP收敛,AdaBoost仅需简单弱分类器。

✅ 实证效果:

- 花海灌区流量预测:R²=0.972,RMSE=0.059(优于传统BP的R²=0.89)。

- 云服务器负载预测:PSO-GWO-BP误差比SSA-BP低18.7%。

三、应用场景与进展

1. 成熟应用领域

- 能源预测:

- 光伏发电功率预测(GWO优化MLP权重)。

- 电池SOC估计(误差<3%)。

- 环境管理:

- 污水处理厂碳排放预测(GWO-BP-AdaBoost结合SVR)。

- 工业优化:

- 风电齿轮箱故障诊断(GWO优化聚类)。

- 结构件加工工时预测(GA-BP替代方案)。

2. 新兴探索方向

- 金融预测:股票期货量化(GWO优化交易策略参数)。

- 智慧交通:交通流量预测(结合时序特征)。

- 医疗诊断:疾病风险预测(AdaBoost集成医学影像分类器)。

四、挑战与未来方向

1. 当前局限

- 计算复杂度:三重算法嵌套,训练耗时较长(尤其大数据场景)。

- 参数调优难:GWO种群大小、AdaBoost迭代次数等需经验调整。

- 噪声敏感:AdaBoost对异常值敏感,可能放大噪声影响。

2. 改进策略

- 算法优化:

- 改进GWO:佳点集初始化种群、合作竞争策略(IGWO)。

- 简化BP:卷积层自动特征提取(CNN-BP融合)。

- 硬件加速:GPU并行化AdaBoost迭代过程。

3. 前沿方向

- 跨领域融合:

- 深度学习+:CNN(特征提取) + GWO-BP(回归) + AdaBoost(集成)。

- 新兴场景:

- 电力负荷预测、可再生能源供需平衡。

五、结论

GWO-BP-AdaBoost通过分层优化(GWO解决参数初始化)、集成学习(AdaBoost提升泛化)和非线性拟合(BP核心预测)的三阶协同,显著提升了复杂系统的预测精度与鲁棒性。其在能源、工业、环境等领域的成功应用验证了框架的有效性,未来通过算法轻量化、硬件加速及跨技术融合(如深度学习),将进一步拓展至金融、医疗等高维动态场景,成为智能预测的核心范式之一。

📚2 运行结果

部分代码:

%% BPNN-Adaboost算法预测

disp(' ')

disp('BPNN-Adaboost预测:')

K = 5; % 弱分类器个数

[at,ada_test_sim,ada_train_sim] = bp_adaboost(inputn,outputn,K,hiddennum,inputn_test);

an1 = at*ada_test_sim; % 测试集预测

%预测结果反归一化与误差计算

BP_Ada_test_sim=mapminmax('reverse',an1,outputps); %把仿真得到的数据还原为原始的数量级

ms_bp_ada = abs(BP_Ada_test_sim-output_test)./output_test;

mae_bp_ada = mean(abs(output_test - BP_Ada_test_sim));

rmse_bp_ada = sqrt(mean((output_test - BP_Ada_test_sim).^2));

mape_bp_ada = mean(abs((output_test - BP_Ada_test_sim)./BP_Ada_test_sim));

r2_bp_ada = 1 - (sum((BP_Ada_test_sim- output_test).^2) / sum((output_test - mean(output_test)).^2));

%% GWO-BPNN-Adaboost算法预测

disp(' ')

disp('GWO-BPNN-Adaboost预测:')

% 算法参数

inputnum=size(inputn,1);

outputnum=size(outputn,1);

%节点总数

numsum=inputnum*hiddennum+hiddennum+hiddennum*outputnum+outputnum;

lb=-1; % 下界

ub=1; % 上界

dim=numsum;

popsize = 10; % 种群数

iter_max = 50; % 迭代次数

lb= lb.*ones( 1,dim );

ub= ub.*ones( 1,dim );

% GWO-BPNN-Adaboost

[at1,gwo_ada_test_sim,BPoutput1,IterCurve1] = gwo_bp_adaboost(inputn,outputn,K,hiddennum,inputn_test,lb,ub,dim,popsize,iter_max);

an1 = at1*gwo_ada_test_sim; % 测试集预测

%预测结果反归一化与误差计算

GWO_BP_Ada_test_sim=mapminmax('reverse',an1,outputps); %把仿真得到的数据还原为原始的数量级

ms_gwo_bp_ada = abs(GWO_BP_Ada_test_sim-output_test)./output_test;

mae_gwo_bp_ada = mean(abs(output_test - GWO_BP_Ada_test_sim));

rmse_gwo_bp_ada = sqrt(mean((output_test - GWO_BP_Ada_test_sim).^2));

mape_gwo_bp_ada = mean(abs((output_test - GWO_BP_Ada_test_sim)./GWO_BP_Ada_test_sim));

r2_gwo_bp_ada = 1 - (sum((GWO_BP_Ada_test_sim- output_test).^2) / sum((output_test - mean(output_test)).^2));

Mean_IterCurve1 = mean(IterCurve1); % 平均迭代曲线

%% 结果展示

% 进化迭代曲线

figure

plot(1:size(Mean_IterCurve1,2),Mean_IterCurve1,'Color',[239 65 67]/255,'LineWidth',3);hold on

legend('GWO-BPNN');

xlabel('进化代数');

ylabel('适应度');

title('进化收敛图');

% 预测结果与实际值

figure

plot(output_test(1,:),'-^','Color',[144 201 231]/255,'LineWidth',2);

hold on

plot(BPtest_sim(1,:),'-o','Color',[33 158 188]/255,'LineWidth',2);

plot(BP_Ada_test_sim(1,:),'-s','Color',[019 103 131]/255,'LineWidth',2);

plot(GWO_BP_Ada_test_sim(1,:),'-d','Color',[254 183 5]/255,'LineWidth',2);

legend('Real Value','BPNN','BPNN-Adaboost','GWO-BPNN-Adaboost')

xlabel('测试样本编号')

ylabel('输出')

title('预测结果显示(测试集)')

grid on;

% 预测相对误差

figure

plot(ms_bp(1,:),'-o','Color',[33 158 188]/255,'LineWidth',2);hold on

plot(ms_bp_ada(1,:),'-s','Color',[019 103 131]/255,'LineWidth',2);

plot(ms_gwo_bp_ada(1,:),'-d','Color',[254 183 5]/255,'LineWidth',2);

legend('BPNN','BPNN-Adaboost','GWO-BPNN-Adaboost')

xlabel('测试样本编号','FontSize',12);

ylabel('相对误差','FontSize',12);

title('测试集的相对误差')

grid on

figure

% 误差统计

AA = [mae_bp,mae_bp_ada,mae_gwo_bp_ada;...

rmse_bp,rmse_bp_ada,rmse_gwo_bp_ada;...

mape_bp,mape_bp_ada,mape_gwo_bp_ada;...

r2_bp,r2_bp_ada,r2_gwo_bp_ada];

B= bar(AA);

xticklabels({' MAE', 'RMSE' ,'MAPE','R^2'})

legend('BPNN','BPNN-Adaboost','GWO-BPNN-Adaboost')

B(1).FaceColor = [33 158 188]/255;

B(2).FaceColor = [019 103 131]/255;

B(3).FaceColor = [254 183 5]/255;

% B(4).FaceColor = [217 079 051]/255;

title('预测算法评价指标对比')

🎉3 参考文献

文章中一些内容引自网络,会注明出处或引用为参考文献,难免有未尽之处,如有不妥,请随时联系删除。

🌈4 Matlab代码、数据、文献

资料获取,更多粉丝福利,MATLAB|Simulink|Python资源获取

3133

3133

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?