机器环境python==3.11

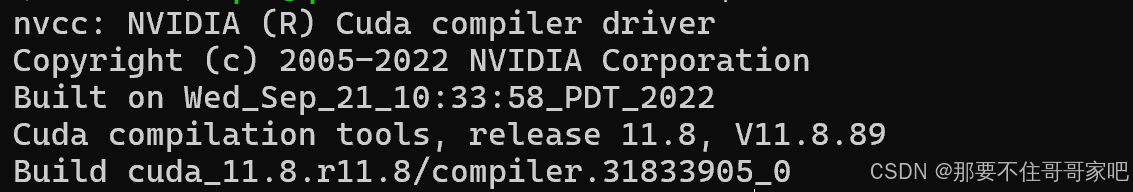

cuda==11.8

#创建环境

conda create -n qwen2 python==3.11#激活环境

conda activate qwen2#安装 torch

pip install torch torchvision torchaudio#查看cuda版本(注意nvidia-smi是查看最高支持版本,查看安装版本是nvcc -V)

nvcc -V

我的cuda版本是11.8

#安装xinference

pip install "xinference[all]"#部署xinference服务环境

#设置缓存路径

XINFERENCE_TRANSFORMERS_ENABLE_BATCHING=1 XINFERENCE_HOME=<设置xinference缓存的路径>

最低0.47元/天 解锁文章

最低0.47元/天 解锁文章

4万+

4万+

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?