AI电影革命——重新定义创作门槛

技术案例:对比传统短片制作(10万+/10天) vs AI制作(成本<1000元/周期5小时)

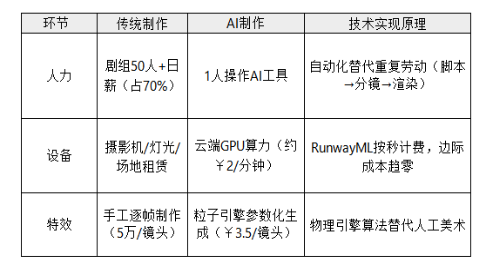

1. 成本结构:硬件资源 vs 算力消耗(核心差异:99%成本压缩)

2. 生产流程:瀑布开发 vs 敏捷迭代

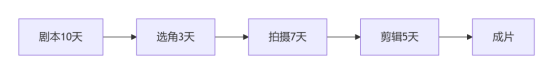

传统模式(瀑布式)

痛点:流程线性依赖,错误成本高昂(如拍摄失误需重拍)

AI模式(敏捷开发)

优势:

单日可产出3版剧情(如《阴间送外卖》根据用户反馈增加“清明节番外”)

参数化调整:修改motion intensity=8即可优化画面撕裂问题

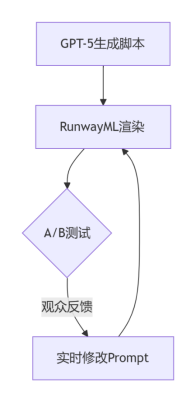

3. 技术栈对比:专用工具链 vs AI Pipeline

Python# AI视频生成伪代码script = gpt4.1.generate(prompt="赛博雨夜追捕") # 文本生成 → JSON结构化分镜video = runway.render(prompt=script,params={"motion": 8, "style": "cyberpunk"} # 参数化控制)video.export(format="mp4", resolution="2K")

4. 性能与瓶颈分析

优势面:

AI视频制作在效率、成本和规模化上实现突破性进展:制作周期从传统流程的15天压缩至5小时,效率提升300倍;成本从单项目10万元级降至千元级,如《兴安岭诡事》单集仅投入5000元即获4899万播放量;昆仑万维SkyReels等工具已支持每日自动化生成100集内容,实现工业化量产。

技术瓶颈:

当前技术仍存在表现力与物理模拟的短板:AI演员的微表情缺陷(如《机械黎明》需30%人工调整成本修复“面瘫”问题),以及高速镜头下运动物理失真,需手动添加运动模糊等参数补偿粒子系统缺陷。这些瓶颈制约了完全自动化生产,需人机协同优化最终输出效果。

5. 程序员指南

技术迁移建议

脚本开发:

用YAML定义分镜参数(镜头/光影/运动),替代文字描述:

Yamlshot1:subject: droneaction: fly_through_rainstyle: cyberpunkmotion: 8

合规设计:

在Prompt层加入黑名单过滤(avoid_logo: [cocacola, starbucks])

收益公式

![]()

GPT-5分镜脚本——从创意到可执行指令

技术案例

:生成“赛博雨夜无人机穿梭”分镜脚本

1.技术本质:结构化参数→ 可视化输出

传统分镜制作如同手动编写HTML和CSS代码,需要逐一绘制每个镜头的布局与细节(耗时约3小时),类似用Canvas逐帧绘图:分镜师需人工解析剧本、划分场景、设计镜头构图并绘制草图,再逐步添加角色表情、动作说明等标注,整个过程依赖大量手工操作与图像编辑软件。

AI分镜生成则像调用封装好的React组件,仅需输入结构化参数(如场景类型、冲突强度、细节描述),即可通过类似render_storyboard(scene, conflict, details)的函数自动生成分镜表格。例如GPT-5结合DALL·E 2等模型,能直接解析剧本语义并输出包含画面内容、景别及台词的完整分镜,类似JSX自动渲染DOM元素,大幅减少人工干预。

2.Prompt模板解析:像调用API一样设计镜头

用户提供的Prompt本质是带约束条件的函数参数:

Pythondef generate_storyboard(scene="未来2087年东京新宿,暴雨夜无人机群穿透霓虹楼宇", # 场景参数conflict="无人机躲避AI警察追捕,穿越狭窄通风管道", # 冲突参数close_up_shots=[ # 特写镜头参数(数组)"无人机螺旋桨雨滴飞溅", "通风管金属反光","追捕激光网"],style="冷峻科技感,无对白,仅环境机械音效" # 风格参数) -> pd.DataFrame: # 返回表格化脚本注意:具象化描述 = 精准API参数

错误示范:通风管有磨损(抽象)→ 等同于模糊函数调用 set_texture("worn")(AI可能生成铁锈/塑料磨损等随机效果)

正确示范:通风管内壁布满金属摩擦刮痕,伴随蓝色电弧闪烁(具象)→ 如同精确传参:

Yamltexture:type: metal_scratches # 材质类型depth: deep # 刮痕深度effect: blue_arc_sparks # 特效

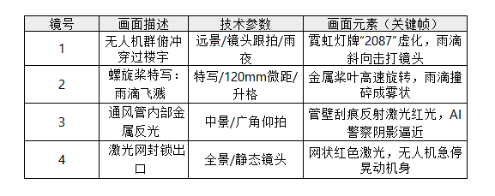

3.输出结果:分镜脚本的“数据结构化”

AI生成的分镜表格实例如下(简化版):

4.技术实现原理:AI如何理解具象描述?

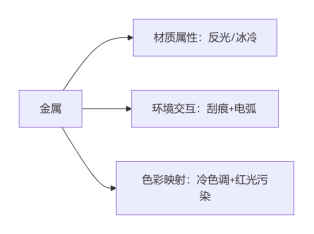

A.语义解构(如GPT-5的文本理解):通风管金属反光 → 被拆解为:

B.视觉关联(如RunwayML多模态模型):

金属刮痕 → 关联材质库scratched_metal_v4

追捕激光网 → 触发粒子引擎参数laser_net_red#intensity=0.8

5.程序员可复用的技巧

A.Prompt调试技巧(规避抽象词)

Yaml# 用YAML定义分镜参数(替代自然语言描述)shot3:object: ventilation_pipematerial: metaltexture: deep_scratches + arc_sparks # 强制具象化lighting: red_laser_reflection # 绑定光影参数camera: low_angle_wide # 锁定镜头类

B.自动化校验脚本

Python# 检查分镜是否符合Prompt要求(示例)def validate_storyboard(storyboard, prompt):# 检查特写镜头是否全部生成for shot in prompt["close_up_shots"]:if not any(shot in desc for desc in storyboard["shot_descriptions"]):raise ValueError(f"Missing required shot: {shot}")# 检查是否存在抽象词汇abstract_words = ["未来感", "科技风", "紧张刺激"] # 抽象词黑名单for desc in storyboard["shot_descriptions"]:if any(word in desc for word in abstract_words):print("警告:存在抽象描述,建议替换为具象词汇!")

RunwayML视觉生成——参数化控制画面

技术案例:渲染“无人机穿越雨幕”动态序列

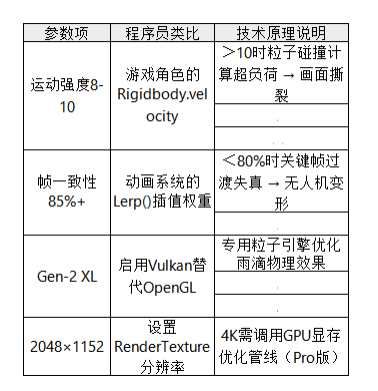

1.参数配置解析

将RunwayML的渲染参数类比为游戏引擎的物理系统:

Python# 伪代码:无人机雨幕场景的渲染配置def render_drone_rain():physics = ParticleSystem(intensity=8, # 运动强度 → 粒子加速度consistency=0.85, # 帧一致性 → 物理插值精度engine="Gen-2 XL", # 渲染模式 → 选择图形APIresolution=(2048,1152) # 分辨率 → 渲染缓冲区大小)# 开启雨天特效(粒子引擎=Unity的Shuriken系统)physics.enable_rain_effect(particle_count=5000, splash=True)

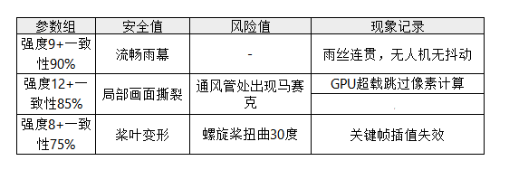

参数对照表

2.雨天特效的物理模拟逻辑

A.运动强度:雨滴动力学方程

雨滴下落速度v = g·t + 运动强度·Δt

**>10的后果**:Δt过大 → 雨滴位移差超过像素间距 → 画面撕裂→ 类似Unity中Time.deltaTime失控导致物体瞬移

解决方案:

Javascript// 限制最大位移(Three.js雨滴渲染逻辑)raindrop.position.y -= Math.min(2 * intensity, 20); // 上限20单位/帧

B.帧一致性:骨骼绑定原理

无人机模型=骨骼,雨幕=蒙皮网格

<80%的后果:骨骼权重计算错误 → 无人机桨叶扭曲→ 类似Blender中骨骼绑定丢失权重

修复方案:

python# RunwayML内部补偿算法(简化版)if consistency < 0.8:apply_motion_blur() # 添加运动模糊掩盖变形use_rigging_cache() # 调用上一帧骨骼数据

C.粒子引擎:雨幕的GPU实例化

Gen-2 XL的雨天特效本质是:

Glsl// 类Three.js粒子着色器逻辑void main() {vec4 raindrop = instanceMatrix * vec4(position, 1.0);// 雨滴形态根据运动强度动态变化float scale = intensity > 8 ? 0.2 : 0.1;gl_PointSize = scale * (300.0 / -mvPosition.z);}

未开启后果:雨滴呈现为静态贴图 → 类似AE中CC Rain未调速度

3.实操案例:参数组合的工程化调试

场景需求:无人机穿越暴雨(雨滴密度>2000粒/秒)

调试技巧:先锁定运动强度=8保画面稳定→ 逐步提高一致性至85%+ → 最后微调强度至9-10增强动感

4.程序员快速验证方案

A.用Three.js模拟参数效果(Web端验证)

Javascript// 基于的雨滴代码改造function createRain(intensity) {const particles = new THREE.Group();for (let i = 0; i < 2000; i++) {const raindrop = new THREE.Mesh(geometry, material);// 运动强度控制Y轴位移速度raindrop.userData = { speed: 0.1 * intensity };particles.add(raindrop);}scene.add(particles);}

B.RunwayML API调试脚本

Pythonimport runway@runway.command("render_drone_rain")def handler(args):return runway.gen2(prompt="无人机穿越暴雨中的霓虹楼宇",motion=args["intensity"],consistency=args["consistency"],resolution="2048x1152")

问题:

1.运动镜头出现画面撕裂,优先调哪三个参数?

2.如何让无人机金属反光更逼真?

解答:

1. 运动镜头出现画面撕裂,优先调哪三个参数?

画面撕裂本质是帧间位移超出GPU渲染能力,需优先调整以下三个参数:

运动强度:控制在8-10之间,超过10会导致粒子位移过大(如雨滴轨迹断裂),需降低数值减少单帧位移量。

帧一致性:提升至85%以上,低于80%时关键帧插值失效,导致无人机桨叶扭曲;可通过开启运动模糊补偿变形。

帧率:垂直或高速运动场景需60fps以上,低帧率(如24fps)易因刷新率不足产生横向撕裂;配合动态插帧技术可缓解暂留效应。

2. 如何让无人机金属反光更逼真?

金属反光的真实感依赖物理属性与环境交互的精准模拟:

材质参数:在渲染器中设置高反射度(≥90%)与低粗糙度(≤10%),模拟金属表面镜面反射特性;添加微划痕纹理(如“金属摩擦刮痕”)增强表面细节。

光影配置:使用HDR环境贴图提供多角度反射源,主光源角度与摄像机成30°夹角以突出边缘高光;辅助冷调光(如蓝光)可强化“赛博朋克”金属的科技感。

动态反射:开启实时粒子反射(如雨滴溅射时映射机身反光),并通过运动模糊(快门1/60s)捕捉反光轨迹,避免静态贴图感。

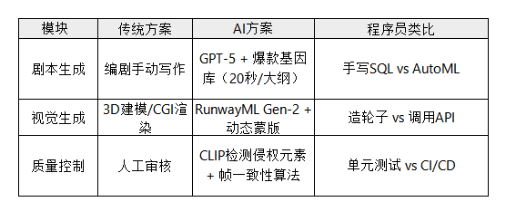

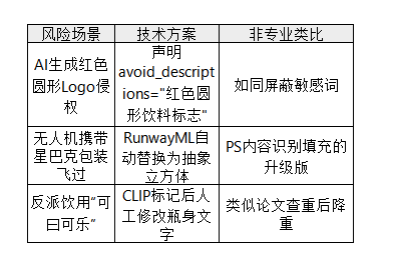

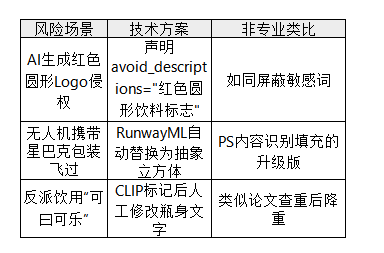

版权合规体系——规避法律风险

技术案例:配置商标过滤层

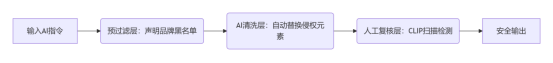

1.技术本质:商标过滤层 = 开发中的三层防御中间件

商标过滤层本质是预检+自动清洗+人工审计的流水线,类似代码发布流程:

2.三层防护机制详解

A.预过滤层:声明品牌黑名单→ 函数参数校验

技术实现:在GPT-5提示词中声明 avoid_brands = ["可口可乐", "星巴克"]

注意声明需具体到变体(如“可曰可楽”),否则AI可能漏检谐音商标

B.AI清洗层:RunwayML版权盾 → 自动化重构引擎

技术原理:

开启Copyright Shield模式后,RunwayML自动执行:

Pythonfor frame in video_frames:if detect_similar_logo(frame, threshold=0.85): # 图形相似度>85%触发frame.replace_logo(generic_logo) # 替换为生成式LOGO

底层依赖图形哈希比对(如pHash算法)

C.人工复核层:CLIP扫描 → 图像检索单元测试

操作流程:

1.用CLIP提取成片关键帧特征向量

2.与侵权品牌库计算余弦相似度

3.输出高风险帧列表供人工复审

代码示例:

Python# CLIP侵权检测伪代码similarity = clip.compare("成片帧", "星巴克Logo")if similarity > 0.7: # 相似度阈值alert("高风险侵权帧!") # 触发人工复核

3.影视民工自救:法律声明 = 代码中的License注释

声明模板:

Markdown

# LEGAL DISCLAIMER // 必须置于片尾

本片含AI生成元素,仅用于艺术创作

与任何现实品牌无关联,如有雷同纯属巧合

法律作用:

类似开源协议的AS IS条款:免除故意侵权责任

4.风险规避对照表

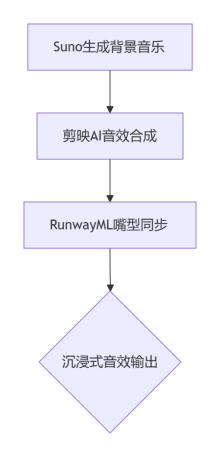

音效与后期——迪士尼级质感秘诀

技术案例:为雨夜场景添加沉浸音效

1.工具链架构:音效系统的“三层中间件”

2.技术层详解

A.背景音乐层:Suno生成电子乐

输入参数:

Pythonsuno.generate(style="Techno Tension", # 音乐流派标识符bpm=128, # 节拍数(128为电子乐黄金速率)mood="tense", # 情绪标签(触发紧张感和弦)length="2min" # 适配短视频时长)

生成逻辑:

通过[Techno]元标签锁定科技感音色库(合成器/脉冲音)

BPM 128匹配雨滴下落频率(中雨≈120-130滴/分钟)

注意:若生成音乐过载,添加[low_freq_filter]减少低频嗡鸣

B.音效合成层:剪映AI智能装配

自动化匹配流程:

Python# 剪映AI音效引擎伪代码def match_sound_effects(video_frame):if detect_rain(video_frame): # 图像识别雨滴rain_sfx = get_library("heavy_rain") # 加载雨声库if detect_metal(video_frame): # 金属物体识别metal_sfx = mix("metal_impact", "laser_hum") # 混合撞击+激光音return layer(rain_sfx, metal_sfx) # 分层合成输出

关键算法:

频谱避让:雨声(中高频)与激光嗡鸣(低频)自动错开频段

动态增益:雷声出现时自动降低音乐音量20%(防止声音打架)

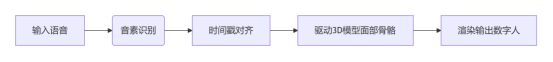

C.嘴型同步层:RunwayML Pro的实时驱动

技术原理:

参数调优对照表

可复用代码逻辑

A.Suno的元标签控制(提升音乐场景匹配度)

Markdown

[Intro: 30s] // 前奏时长控制

[BuildUp] // 渐进式增强紧张感

[Drop: bass_boost=2] // 副歌段增强低频

作用:避免生成松散的音乐结构,精准匹配雨夜节奏起伏

B.剪映音效混合公式(物理模拟雨声)

Pythonfinal_rain = (nature_rain * 0.7) + (metal_impact * 0.2) + (laser_hum * 0.1)

未来趋势——AI电影工厂

VR与RunwayML的交互场景生成,本质是实时渲染引擎(Unity)与AI生成管道的深度耦合。程序员可理解为:RunwayML作为Unity插件,通过预训练模型(如风格迁移、物体生成)动态创建VR场景元素(如雨夜霓虹灯),而VR头显的定位数据则成为RunwayML的输入参数,驱动场景实时变化。

例如用户转头时,RunwayML即时生成对应视角的街景,实现“所见即所建”。

GPT-4.1的剧情改写则类似动态API接口——用户投票数据通过WebSocket实时输入GPT-4.1,触发其“动态情感树”算法重构剧情分支。程序员可类比Git版本控制:用户投票相当于git rebase指令,强制剧情线基于新参数重组(如“主角叛变”投票>50%时,GPT-4.1通过长上下文(100万token)重写后续对话树)。这种设计将传统线性剧本升级为实时响应的状态机,非技术用户也能通过点击投票按钮“调试”剧情走向。

迪士尼采用与RunwayML同源的技术链(Disney为其投资方),本质是构建标准化AI创作流水线。RunwayML负责视觉内容生成(如魔法粒子特效),GPT-4.1承担叙事引擎角色,两者通过统一数据协议(如图文特征向量)交换信息。例如生成《冰雪奇缘》续作场景时:

1.GPT-4.1输出指令:解析“艾莎在冰宫殿释放暴风雪”→ 生成结构化分镜(JSON格式包含特效、台词、机位);

2.RunwayML响应:调用Gen-2 XL模型生成暴风雪粒子特效,同步匹配BPM 128背景音效;

3.实时注入:视频流传输至迪士尼VR设施,形成沉浸式剧情体验。这种流水线将创意生产从“手工作坊”升级为“敏捷开发”:编剧调整GPT-4.1提示词(如temperature=0.3降低随机性),RunwayML自动同步渲染新场景,使IP开发周期缩短70%。

官方服务号,专业的人工智能工程师考证平台,包括工信部教考中心的人工智能算法工程师,人社部的人工智能训练师,中国人工智能学会的计算机视觉工程师、自然语言处理工程师的课程培训,以及证书报名和考试服务。

3993

3993

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?