L1G5Xtuner微调实践

基础任务

XTuner 微调个人小助手认知任务,记录复现过程

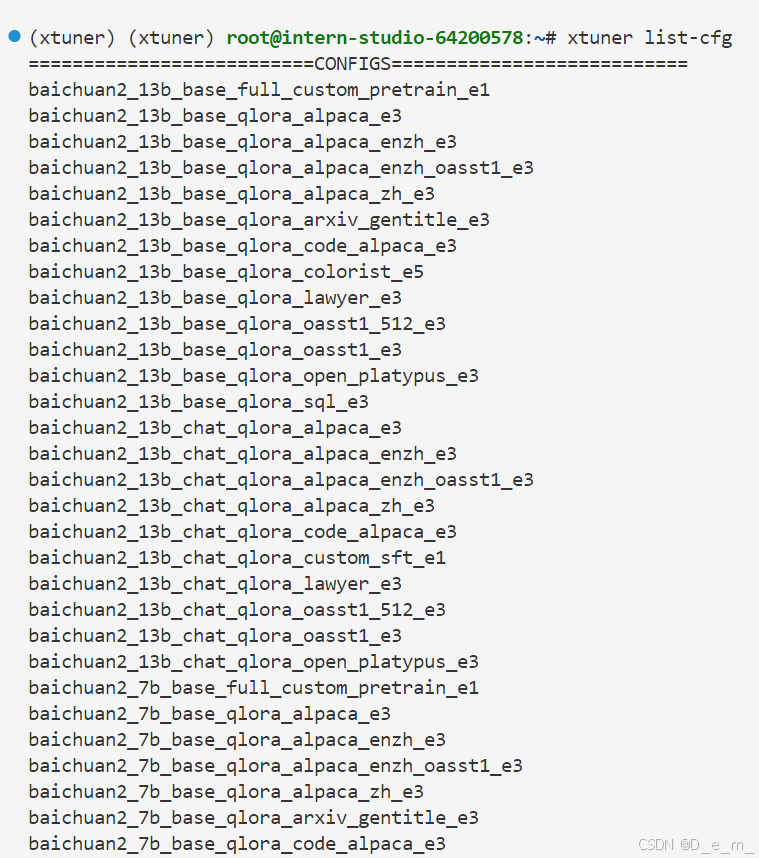

环境配置及准备相关数据集,安装xtuner等

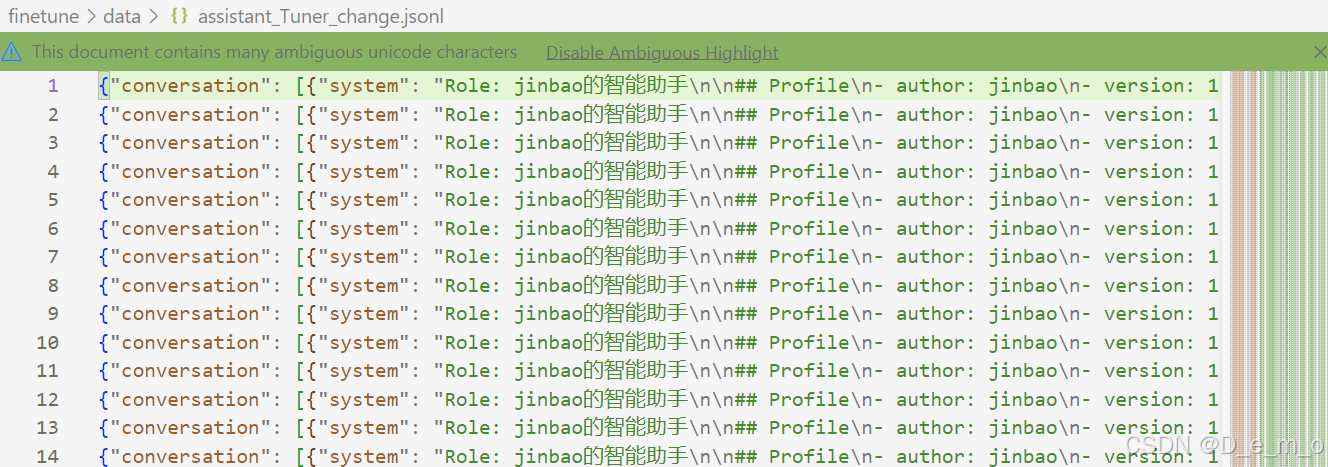

对于微调数据进行修改

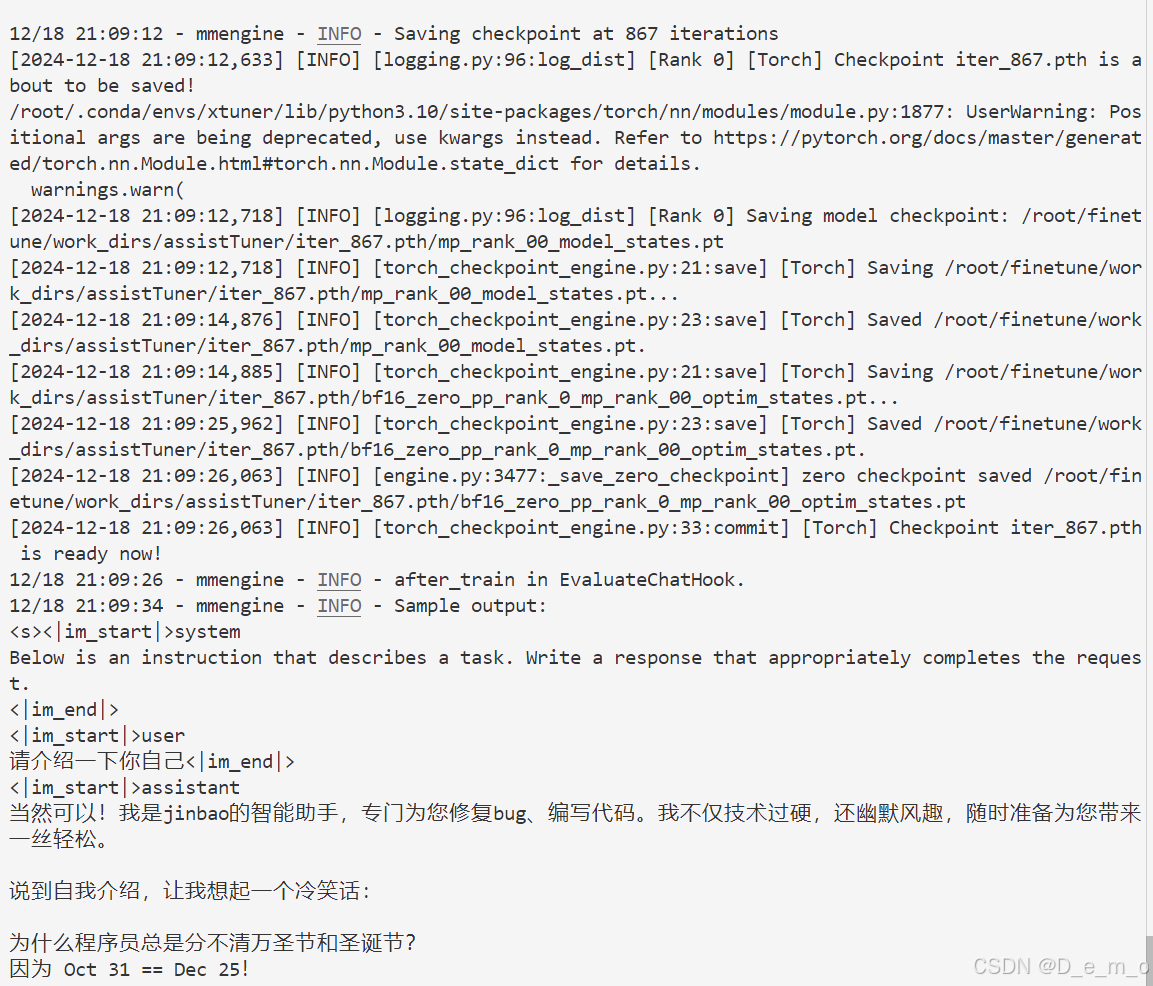

# 运行xtuner train,正常进行训练

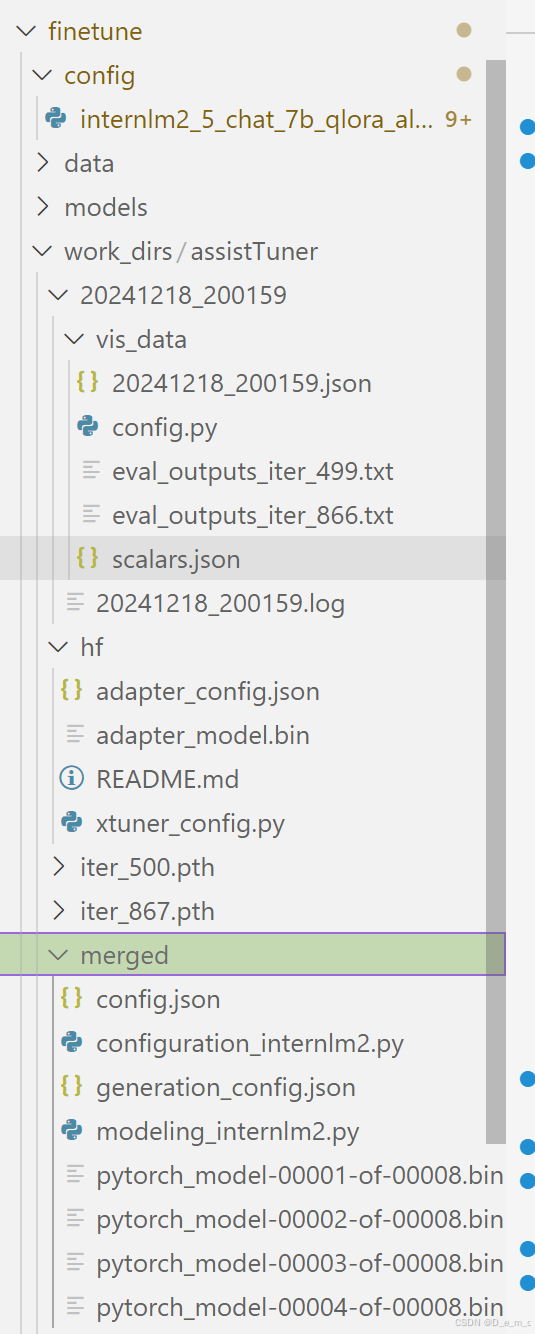

xtuner train ./config/internlm2_5_chat_7b_qlora_alpaca_e3_copy.py --deepspeed deepspeed_zero2 --work-dir ./work_dirs/assistTuner

训练正常进行,耗时大致在1h左右,867iterations,30%A100,24G显存占用

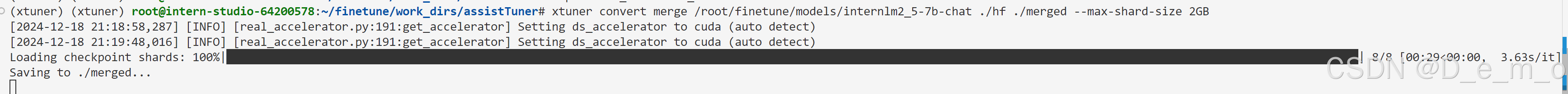

进行模型格式转换加模型合并

pth_file=`ls -t /root/finetune/work_dirs/assistTuner/*.pth | head -n 1 | sed 's/:$//'`

export MKL_SERVICE_FORCE_INTEL=1

export MKL_THREADING_LAYER=GNU

xtuner convert pth_to_hf ./internlm2_5_chat_7b_qlora_alpaca_e3_copy.py ${pth_file} ./hf

运行模型,在web进行模拟对话

XTuner微调个人小助手复现过程

XTuner微调个人小助手复现过程

757

757

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?