Code: https://github.com/whai362/PVT

目录

Pyramid Vision Transformer(PVT)

文章动机

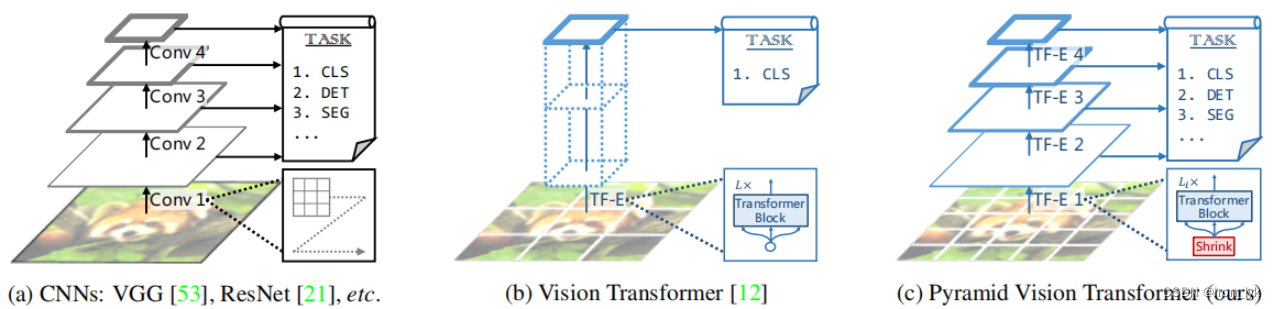

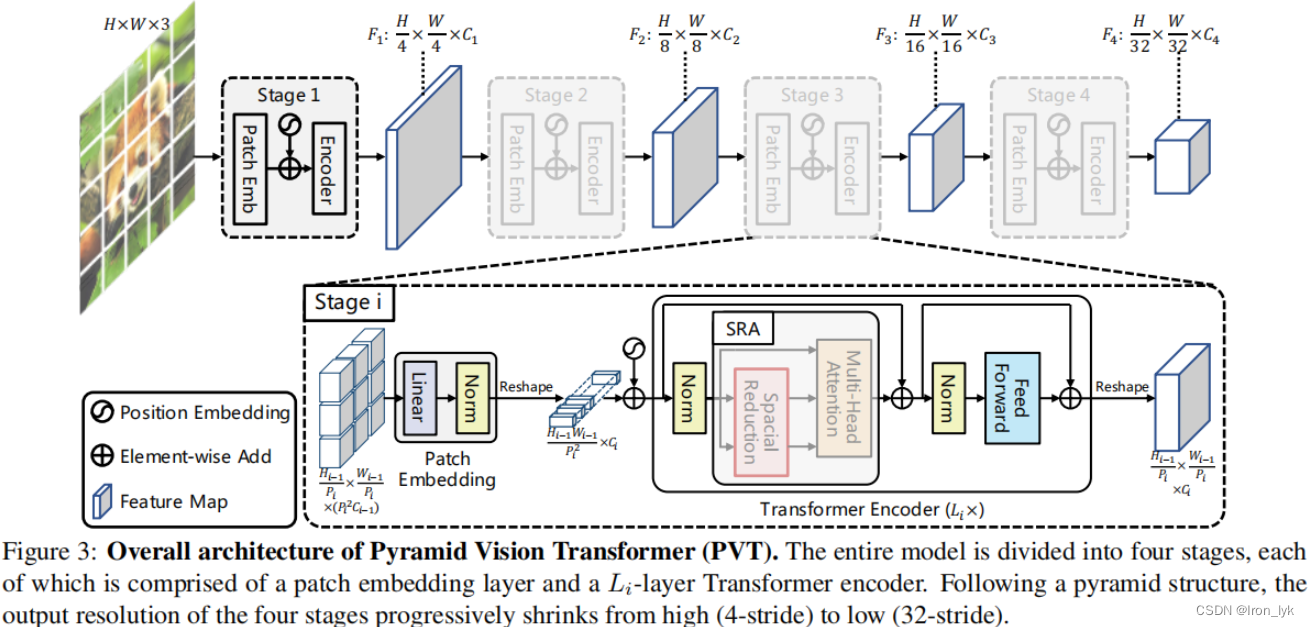

许多CNN Backbones使用金字塔结构来完成目标检测、实例分割等任务,本文将CNN中的金字塔结构引入到Transformer中去,来生成multi-scale(多尺度)的特征图,来更好的完成这些任务。

Pyramid Vision Transformer(PVT)

金字塔的结构如上图所示,由于本文方法对目前想做的研究没有太大的帮助,所以没细看。

启发

比较有意思的是在Encoder部分,作者在进行multi-head attention之前,将K和V的空间尺寸进行了缩减,目的是为了减小计算量。

启发于本文中如下左图的机制,对于一个query,更新时可以并不是对所有的query进行attention,而是对欧氏空间中距离最近的local进行attention,其他的不care。(ps : 这种想法很直接,可能已有人做)

该博客介绍了PyramidVisionTransformer(PVT),这是一种将Transformer的注意力机制与CNN的金字塔结构相结合的方法,用于生成多尺度特征图,以提升目标检测和实例分割等任务的性能。作者在编码器部分提出了减少K和V的空间尺寸的策略,以减小计算复杂性。此外,还讨论了一种灵感来自于局部注意力机制的优化方式,即仅对与查询最近的局部区域进行注意力操作,降低计算成本并保持效果。

该博客介绍了PyramidVisionTransformer(PVT),这是一种将Transformer的注意力机制与CNN的金字塔结构相结合的方法,用于生成多尺度特征图,以提升目标检测和实例分割等任务的性能。作者在编码器部分提出了减少K和V的空间尺寸的策略,以减小计算复杂性。此外,还讨论了一种灵感来自于局部注意力机制的优化方式,即仅对与查询最近的局部区域进行注意力操作,降低计算成本并保持效果。

3756

3756

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?