1、问题检索

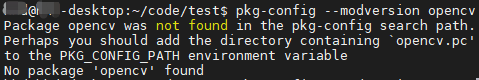

用pkg-config --modversion opencv命令,查看opencv版本,提示找不到

Package opencv was not found in the pkg-config search path.

Perhaps you should add the directory containing `opencv.pc'

to the PKG_CONFIG_PATH environment variable

No package 'opencv' found

报错原因:是因为没有找到opencv.pc,而刷机时是安装了OpenCV的,不过是OpenCV4,在/usr/lib/aarch64-linux-gnu/pkgconfig中找到了opencv4.pc

2、解决方案

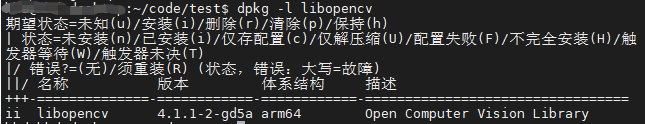

采用如下命令查看nx板中opencv版本,可知为opencv4

dpkg -l libopencv

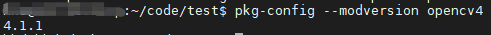

将pkg-config的命令修改为opencv4即可正常使用

pkg-config --modversion opencv4

3、C++使用opencv,并正确编译的方法

3.1 读取rtsp视频流示例

本文档介绍了在Jetson AGX Xavier上遇到使用pkg-config查找OpenCV时找不到package的问题,原因是缺少opencv.pc文件。解决方案是通过修改pkg-config命令为opencv4。同时,提供了C++读取rtsp视频流的示例代码及两种编译方法:命令行编译和使用CMakeLists.txt。文章还包含了正确设置编译选项以链接OpenCV库的步骤。

本文档介绍了在Jetson AGX Xavier上遇到使用pkg-config查找OpenCV时找不到package的问题,原因是缺少opencv.pc文件。解决方案是通过修改pkg-config命令为opencv4。同时,提供了C++读取rtsp视频流的示例代码及两种编译方法:命令行编译和使用CMakeLists.txt。文章还包含了正确设置编译选项以链接OpenCV库的步骤。

最低0.47元/天 解锁文章

最低0.47元/天 解锁文章

1214

1214

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?