#完整的网络模型套路

import torchvision

# from model import *

import torch

from torch.utils.data import DataLoader

from torch.nn import CrossEntropyLoss

#准备训练数据集 数据集为PIL类型,转化为tensor类型

train_data = torchvision.datasets.CIFAR10(root="E:\\notebookpytorch\\pyTorch学习\\NN\\data",train=True,transform=torchvision.transforms.ToTensor(),

download=False)

#准备测试数据集

test_data = torchvision.datasets.CIFAR10(root="E:\\notebookpytorch\\pyTorch学习\\NN\\data",train=False,transform=torchvision.transforms.ToTensor(),

download=False)

#看看训练数据集和测试数据集有多少张,获取数据集的长度

train_data_size = len(train_data)

test_data_size = len(test_data)

print("训练数据集的长度为:{}".format(train_data_size) ) #format()中的内容替换{}

print("测试数据集的长度为:{}".format(test_data_size) )

from torch import nn

from tensorboardX import SummaryWriter

#利用 DataLoader来加载数据集

train_dataloader = DataLoader(train_data,batch_size=64)

test_dataloader = DataLoader(test_data,batch_size=64)

#搭建神经网络,CIFAR10数据集有10个类别,所以这个网络是一个10分类的网络

class Tudui(nn.Module):

def __init__(self):

super(Tudui,self).__init__() #把网络放在一个序列当中

self.model = nn.Sequential(

nn.Conv2d(3,32,5,1,2),

nn.MaxPool2d(2),

nn.Conv2d(32,32,5,1,2),

nn.MaxPool2d(2),

nn.Conv2d(32,64,5,1,2),

nn.MaxPool2d(2),

nn.Flatten(),

nn.Linear(64*4*4,64),

nn.Linear(64,10)

)

def forward(self,x):

x = self.model(x)

return x

#创建网络模型

tudui = Tudui()

#创建损失函数

loss_fn = nn.CrossEntropyLoss()

#优化器 参数:(1:要优化的网络模型,2:学习率)

learning_rate = 0.01 #提出来方便修改

#或者这样写 ----> 1×(10)^(-2)= 0.01

#Learing_rate = 1e-2

optimizer = torch.optim.SGD(tudui.parameters(),lr = learning_rate)

#设置训练网络的一些参数

#记录训练的次数

total_train_step = 0

#记录测试的次数

total_test_step = 0

#训练的轮数

epoch = 10

#添加tensorboard

writer = SummaryWriter("../logs_train")

for i in range(epoch):

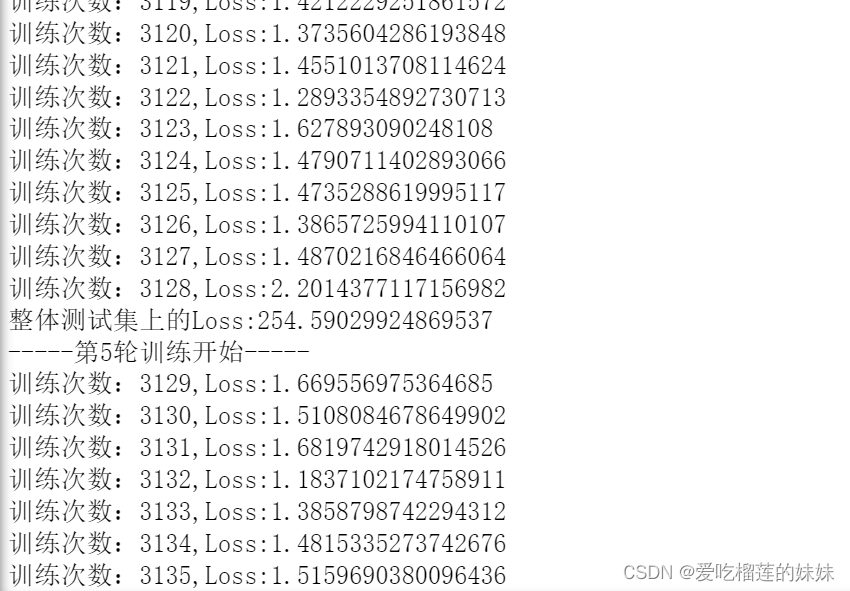

print("-----第{}轮训练开始-----".format(i+1))

#训练开始,取数据,放入网络模型中

#tudui.train() #进入训练状态,同测试那边一样

for data in train_dataloader:

imgs,targets = data

outputs = tudui(imgs)

loss = loss_fn(outputs,targets) #计算损失

#优化器优化模型,梯度清零,反向传播获得梯度,进行优化

optimizer.zero_grad()

loss.backward()

optimizer.step()

total_train_step = total_train_step + 1

print("训练次数:{},Loss:{}".format(total_train_step,loss.item()))

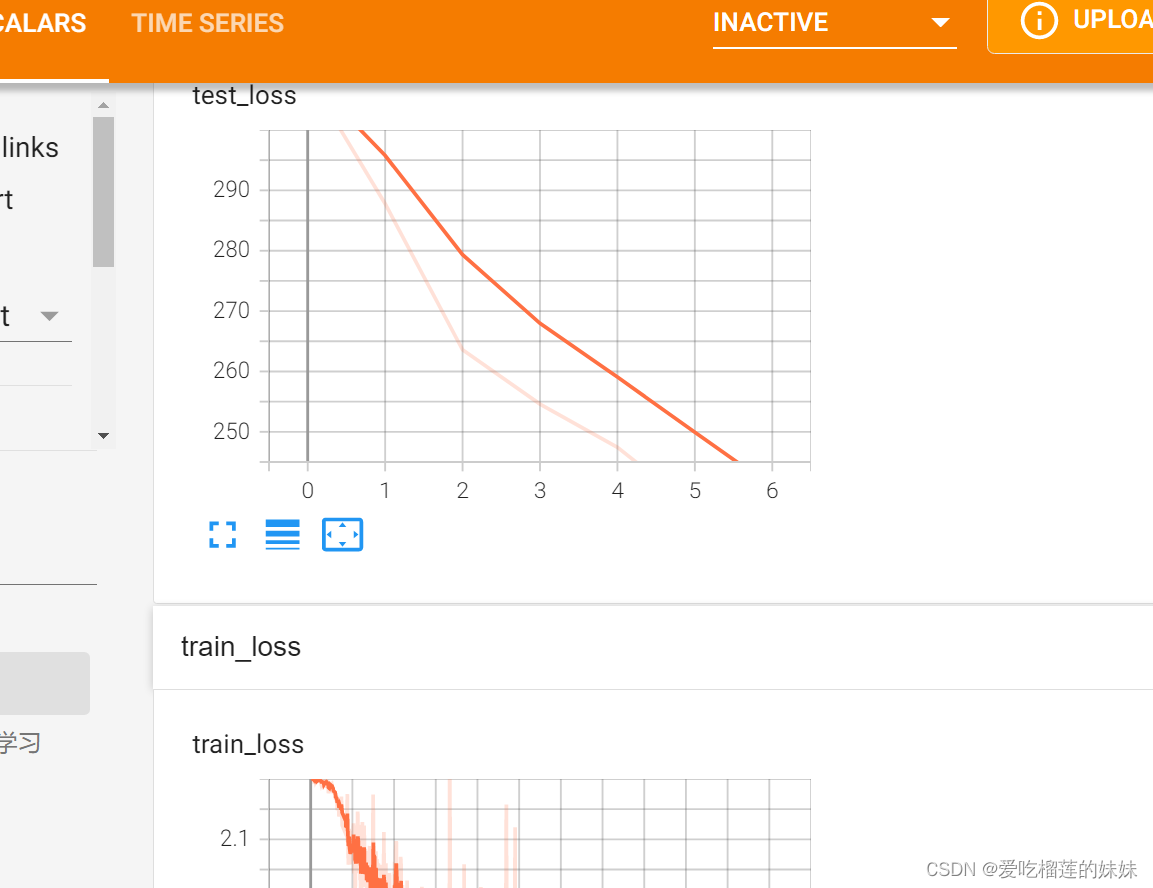

writer.add_scalar("train_loss",loss.item(),total_train_step)

#测试步骤开始

#tudui.eval() #--->有的会加上,进入一个测试状态。只对部分特殊层有作用:Dropout层等等

total_test_loss = 0

total_accuracy = 0 #整体测试集的正确率

with torch.no_grad():

for data in test_dataloader:

imgs,targets = data

outputs = tudui(imgs)

loss = loss_fn(outputs,targets)

total_test_loss = total_test_loss + loss.item()

accuracy = (output.argmax(1) == targets).sum()

total_accuracy = total_accuracy + accuracy

print("整体测试集上的Loss:{}".format(total_test_loss))

print("整体测试集上的正确率:{}".format(total_acuracy/test_test_size))

writer.add_scalar("test_loss",total_test_loss,total_test_step)

writer.add_scalar("test_accuracy",total_accuracy/test_data_size,total_test_step)

total_test_step = total_test_step + 1; #不然图画不出来

#保存模型

torch.save(tudui,"tudui_{}.pth".format(i))

print("模型已保存")

writer.close()

查看最大值所在位置

#查看最大值所在的位置

import torch

outputs = torch.tensor([[0.1, 0.2],

[0.3, 0.4]])

print(outputs.argmax(1))#按横向比 --》tensor([1, 1])

# print(outputs.argmax(0))#按纵向比 --》tensor([0, 1]) 0.3改为0.05

preds = outputs.argmax(1)

targets = torch.tensor([0, 1])

print(preds == targets) --->tensor([False, True])

print((preds == targets).sum()) #计算对应位置相等的个数

1652

1652

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?