前言

为什么要联网?本地的模型现在只能通过现有的训练参数+知识库内容,进行回答,如果你需要一些时效性的问题,它就无能为力了(甚至会胡言乱语,自己加戏)。想要本地的 DeepSeek 开启联网也很简单,只需要安装一个浏览器插件,这里我推荐的是 Page Assist。当然还有一些其他的方式比如 AnythingLLM 等我也尝试过,这个貌似更容易上手。

安装 Page Assist 插件

目前 Page Assist 支持 Chrome、Edge、Firefox 等主流浏览器。

https://github.com/n4ze3m/page-assist

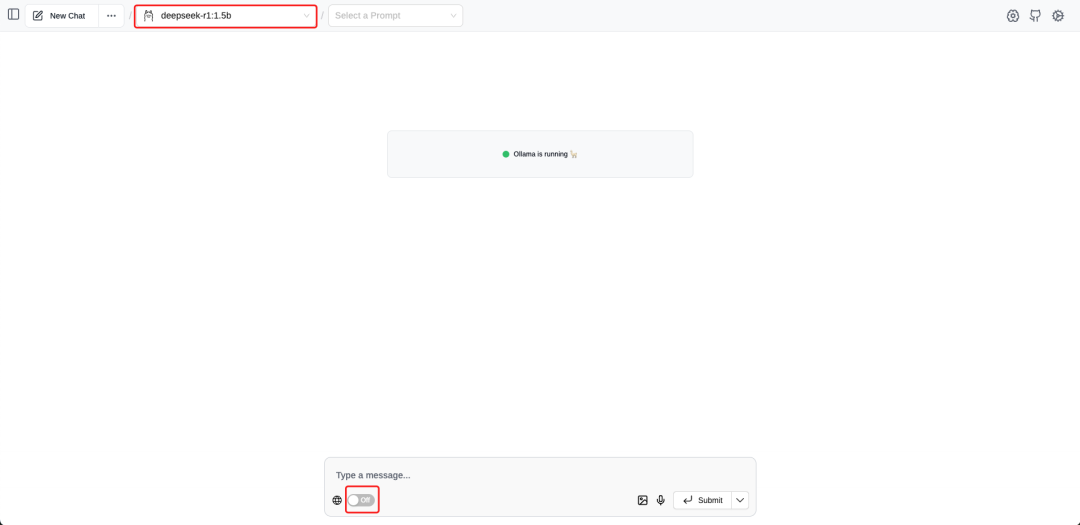

选择模型

在浏览器中 chrome-extension://jfgfiigpkhlkbnfnbobbkinehhfdhndo/options.html

选择本地的模型,然后开启联网。前提是你本地启动了 Ollama。在页面中间位置能过看到这个 Ollama is running 🦙。

最低0.47元/天 解锁文章

最低0.47元/天 解锁文章

994

994

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?