LangChain4j的Chain机制是其核心能力之一,本质是将AI任务拆解为多个有序的、可复用的步骤(节点),通过链式编排实现复杂AI工作流——每个步骤完成特定操作(如Prompt构建、模型调用、数据处理、FunctionCall等),输出作为下一个步骤的输入,最终形成闭环的AI任务流水线。

一、Chain机制的核心设计逻辑

LangChain4j的Chain围绕“模块化、可组合、可扩展”设计,核心要素包括:

| 核心要素 | 作用 |

|---|---|

| Step(步骤) | Chain的最小执行单元,可是Prompt构建、模型调用、数据转换、工具调用等; |

| Input/Output | 步骤间通过统一的输入输出格式(多为String/结构化对象)传递数据; |

| Context(上下文) | 贯穿整个Chain的上下文容器,存储中间结果、对话历史、配置参数等; |

| Executor(执行器) | 负责按顺序/并行执行Chain中的步骤,支持异常处理、重试、分支逻辑; |

二、Chain的核心类型与工作流程

LangChain4j提供了多种内置Chain(也支持自定义),不同Chain适配不同场景,核心工作流程可分为“基础链式执行”和“复杂编排执行”两类:

1. 基础Chain:SimpleSequentialChain(顺序执行链)

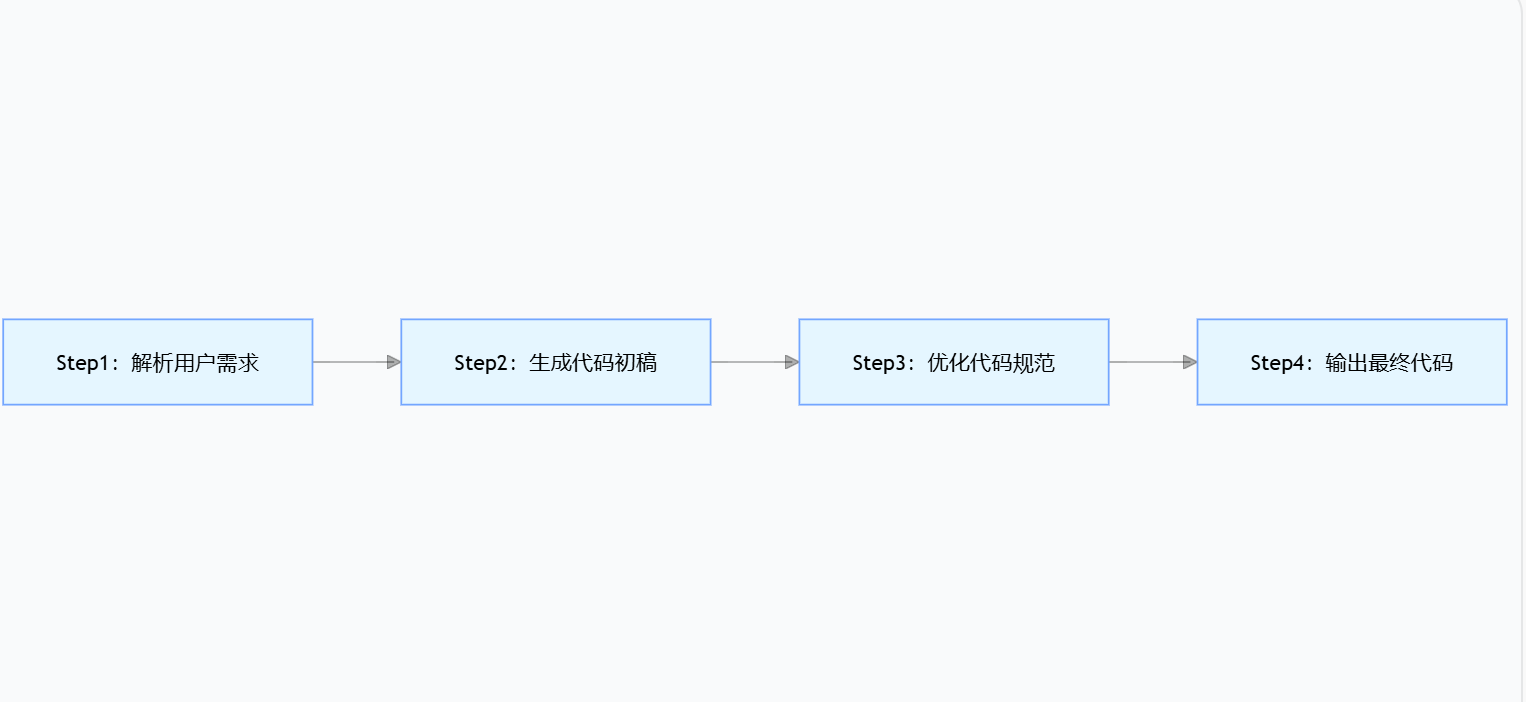

最核心、最常用的Chain,按固定顺序执行步骤,前一步输出直接作为后一步输入,适合线性任务(如“需求解析→代码生成→代码优化”)。

工作流程拆解(以代码生成为例):

- Step1(需求解析):接收用户原始需求(如“写一个Spring Boot接口查询订单”),通过Prompt模板格式化后调用模型,输出结构化的需求描述(如“功能:订单查询;技术栈:Spring Boot+JPA;参数:userId”);

- Step2(代码生成):接收Step1的结构化需求,传入代码生成Prompt模板,调用模型生成代码初稿;

- Step3(代码优化):接收Step2的代码初稿,传入代码规范校验Prompt(如“优化代码格式、补充注释、检查空指针”),调用模型输出优化后的代码;

- Step4(结果输出):整理Step3的优化代码,返回最终结果。

核心代码示例(SimpleSequentialChain):

@Service

public class CodeGenerationChainService {

// 注入LangChain4j的OpenAI模型

@Autowired

private ChatLanguageModel chatModel;

public String generateCode(String userRequirement) {

// Step1:需求解析链节点

PromptTemplate requirementParseTemplate = PromptTemplate.from(

"请结构化解析以下开发需求:{requirement}\n输出格式:功能:xxx;技术栈:xxx;参数:xxx"

);

ChainNode<String, String> requirementParseNode = input -> {

Prompt prompt = requirementParseTemplate.apply(Map.of("requirement", input));

return chatModel.generate(prompt.text()).content();

};

// Step2:代码生成链节点

PromptTemplate codeGenerateTemplate = PromptTemplate.from(

"根据以下结构化需求生成Spring Boot代码:{structuredRequirement}\n要求:代码可运行,包含注释"

);

ChainNode<String, String> codeGenerateNode = input -> {

Prompt prompt = codeGenerateTemplate.apply(Map.of("structuredRequirement", input));

return chatModel.generate(prompt.text()).content();

};

// Step3:代码优化链节点

PromptTemplate codeOptimizeTemplate = PromptTemplate.from(

"优化以下代码:{code}\n要求:补充注释、优化格式、检查空指针"

);

ChainNode<String, String> codeOptimizeNode = input -> {

Prompt prompt = codeOptimizeTemplate.apply(Map.of("code", input));

return chatModel.generate(prompt.text()).content();

};

// 组装顺序链:Step1 → Step2 → Step3

SimpleSequentialChain<String, String> codeGenerationChain = SimpleSequentialChain.builder()

.firstNode(requirementParseNode)

.nextNode(codeGenerateNode)

.nextNode(codeOptimizeNode)

.build();

// 执行链,传入初始输入(用户需求)

return codeGenerationChain.execute(userRequirement);

}

}

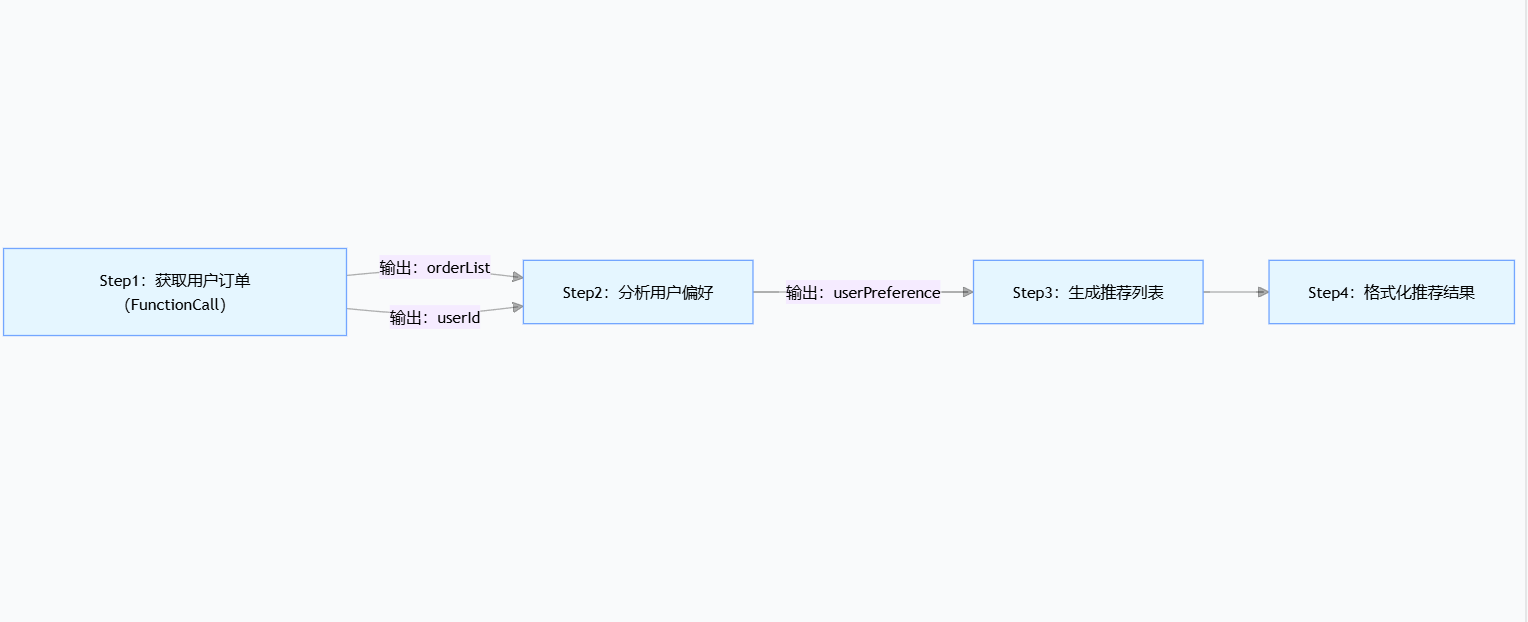

2. 进阶Chain:SequentialChain(多输入输出顺序链)

相比SimpleSequentialChain,支持多输入、多输出,适合步骤间需要多个参数传递的场景(如“用户信息+订单数据→生成个性化推荐”)。

核心特点:

- 每个步骤可接收多个输入参数(如同时传入“用户ID”和“订单列表”);

- 每个步骤的输出可指定名称,供后续步骤按需引用;

- 上下文(Context)贯穿全程,存储所有中间参数。

工作流程示例(电商推荐):

核心代码片段:

// 构建多输入输出顺序链

SequentialChain推荐Chain = SequentialChain.builder()

// Step1:调用订单接口(FunctionCall),输出orderList和userId

.addStep(

Step.builder()

.inputKeys("userId") // 接收userId输入

.outputKeys("orderList", "userId") // 输出订单列表和用户ID

.action(context -> {

String userId = context.get("userId");

List<Order> orderList = orderService.getUserOrders(userId);

context.put("orderList", orderList);

context.put("userId", userId);

return context;

})

.build()

)

// Step2:分析用户偏好,输入userId+orderList,输出userPreference

.addStep(

Step.builder()

.inputKeys("userId", "orderList")

.outputKeys("userPreference")

.action(context -> {

String prompt = "分析用户" + context.get("userId") + "的订单:" + context.get("orderList") + ",输出用户偏好";

String preference = chatModel.generate(prompt).content();

context.put("userPreference", preference);

return context;

})

.build()

)

// Step3:生成推荐列表

.addStep(

Step.builder()

.inputKeys("userPreference")

.outputKeys("recommendList")

.action(context -> {

String prompt = "根据偏好" + context.get("userPreference") + "生成电商推荐列表";

String recommend = chatModel.generate(prompt).content();

context.put("recommendList", recommend);

return context;

})

.build()

)

.build();

// 执行链,传入初始参数userId

Context initialContext = Context.builder().put("userId", "1001").build();

Context finalContext = 推荐Chain.execute(initialContext);

String recommendResult = finalContext.get("recommendList");

3. 高级Chain:分支链、循环链、并行链

LangChain4j还支持更复杂的Chain编排,满足非线形任务需求:

- 分支链(BranchChain):根据条件执行不同子链(如“高峰期调用GPT-4o,低峰期调用Llama3”);

- 循环链(LoopChain):重复执行某个步骤直到满足条件(如“代码生成→校验→不通过则重新生成”);

- 并行链(ParallelChain):同时执行多个独立步骤,最后合并结果(如“同时分析用户评论情感和商品销量,合并生成运营建议”)。

三、Chain机制的核心优势

- 解耦复杂任务:将“代码生成”“智能客服”等复杂AI任务拆解为小步骤,每个步骤可独立开发、测试、复用;

- 灵活扩展:可随时新增/删除/替换Chain中的步骤(如新增“代码安全扫描”步骤),无需重构整个流程;

- 可观测性:每个步骤的输入/输出可记录日志,便于排查问题(如某一步生成的代码出错,可快速定位);

- 与LangChain4j生态兼容:Chain可无缝集成FunctionCall、Memory(上下文)、Prompt模板等LangChain4j核心能力。

四、Chain机制的底层执行逻辑

- 初始化:构建Chain时,定义步骤的输入输出键、执行逻辑、依赖关系;

- 上下文初始化:执行Chain前,创建Context容器,存入初始输入参数;

- 步骤执行:Executor按顺序/条件执行每个Step,将Step的输出写入Context;

- 异常处理:支持自定义异常处理器(如步骤执行失败时重试、降级);

- 结果返回:所有步骤执行完成后,从Context中提取最终结果返回。

总结

LangChain4j的Chain机制本质是“AI工作流的流水线引擎”——通过将复杂AI任务拆解为标准化步骤,实现步骤间的有序编排和数据流转,既保证了灵活性(支持线性/非线性任务),又保证了可维护性(步骤解耦、复用)。核心是“以Context为数据载体,以Step为执行单元,以Executor为调度核心”,是LangChain4j实现复杂AI场景的核心基石。

下面说说下SpringAI

SpringAI的核心机制是如何工作的

SpringAI的核心机制围绕**“标准化AI能力接入 + 深度融合Spring生态”** 设计,本质是为Java/Spring开发者提供一套统一、低侵入、企业级的AI能力集成框架——通过抽象层屏蔽不同AI模型/服务商的差异,同时复用Spring的依赖注入、事务、安全、配置等核心能力,让AI能力像Spring组件一样被灵活使用。

一、核心设计理念:“AI能力Spring化”

SpringAI的核心目标是消除AI集成的“碎片化”(不同模型API差异、调用方式不统一),并将AI能力融入Spring的企业级特性体系。其设计遵循三大原则:

- 抽象统一:对AI模型(聊天、文本生成、嵌入、图像生成等)定义标准化接口,屏蔽底层服务商(OpenAI、Ollama、百度文心等)的API差异;

- 生态原生:AI组件完全遵循Spring规范(如

@Bean、@Configuration、自动配置),可无缝集成Spring Boot/Cloud、Spring Security、Spring事务等; - 低侵入性:无需重构现有Spring项目,通过依赖引入、配置声明即可快速接入AI能力。

二、核心机制拆解(从底层到应用)

1. 核心抽象层:屏蔽模型差异的“统一接口”

SpringAI最核心的设计是定义了一套标准化的AI能力接口,所有模型服务商的实现都基于这些接口,开发者无需关注底层细节。

| 核心接口 | 作用 | 典型实现 |

|---|---|---|

ChatClient | 聊天/对话型AI能力(如GPT-4o、Llama3),支持上下文、流式响应 | OpenAiChatClient、OllamaChatClient |

TextGenerator | 纯文本生成(如文案、摘要) | OpenAiTextGenerator |

EmbeddingModel | 文本嵌入(如向量数据库检索、语义相似度) | BgeEmbeddingModel、OpenAiEmbeddingModel |

ImageModel | 图像生成/处理(如文生图、图生图) | StabilityAiImageModel |

VectorStore | 向量数据库集成(如Milvus、Pinecone),适配EmbeddingModel的向量存储 | MilvusVectorStore、PgVectorStore |

工作逻辑示例(ChatClient):

// 1. 注入SpringAI标准化的ChatClient(无需关注底层是OpenAI还是Ollama)

@Autowired

private ChatClient chatClient;

// 2. 统一调用方式,底层由配置决定使用哪个模型

public String chat(String message) {

// 标准化请求构建

ChatRequest request = ChatRequest.builder()

.prompt(Prompt.of(message))

.temperature(0.7)

.build();

// 标准化响应处理

ChatResponse response = chatClient.call(request);

return response.getResult().getOutput().getContent();

}

核心优势:切换模型仅需修改配置(如从OpenAI切换到Ollama),无需改动业务代码——这是SpringAI“抽象统一”的核心体现。

2. 自动配置机制:Spring Boot风格的“零代码接入”

SpringAI遵循Spring Boot的“约定优于配置”原则,通过自动配置(AutoConfiguration) 实现AI组件的一键接入:

- 引入对应模型的Starter依赖(如

spring-ai-openai-spring-boot-starter); - 在

application.yml中配置API Key、模型名称等参数; - SpringAI自动创建对应的

ChatClient/EmbeddingModel等Bean,开发者可直接注入使用。

配置示例(OpenAI自动配置):

spring:

ai:

openai:

api-key: ${OPENAI_API_KEY}

chat:

model: gpt-4o

temperature: 0.5

# 自动配置会读取这些参数,创建OpenAiChatClient Bean

底层逻辑:

- SpringAI的

META-INF/spring/org.springframework.boot.autoconfigure.AutoConfiguration.imports文件声明自动配置类(如OpenAiAutoConfiguration); - 自动配置类通过

@ConditionalOnClass/@ConditionalOnProperty判断是否满足条件(如引入了OpenAI依赖、配置了API Key); - 满足条件时,自动注册

OpenAiChatClient、OpenAiEmbeddingModel等Bean到Spring容器。

3. 生态融合机制:AI能力+Spring企业级特性

SpringAI的核心价值不仅是“统一AI调用”,更是将AI能力融入Spring的核心生态,这是区别于纯AI框架(如LangChain4j)的关键:

(1)依赖注入与组件化

AI相关能力(如ChatClient、VectorStore)均为Spring Bean,支持:

- 通过

@Autowired/构造器注入; - 通过

@Qualifier指定多个模型实例(如同时注入OpenAI和Ollama的ChatClient); - 通过

@Scope控制Bean作用域(如请求级别的上下文ChatClient)。

(2)事务管理:AI调用纳入Spring事务

支持将AI模型调用与数据库操作绑定到Spring事务中,确保原子性(如金融风控场景:AI风险评分生成 + 评分入库,要么都成功,要么都回滚)。

@Service

public class RiskService {

@Autowired

private ChatClient chatClient;

@Autowired

private RiskRepository riskRepo;

// AI调用+数据库操作纳入Spring事务

@Transactional(rollbackFor = Exception.class)

public RiskResult assess(String userId) {

// Step1:AI生成风险评分(SpringAI调用)

String score = chatClient.call("评估用户" + userId + "的贷款风险,仅输出分数").getResult().getOutput().getContent();

// Step2:评分入库(Spring Data JPA)

RiskResult result = new RiskResult(userId, score);

riskRepo.save(result);

// 若入库失败,AI调用相关逻辑也会回滚(如记录调用日志的操作)

return result;

}

}

(3)安全管控:Spring Security集成

通过Spring Security管控AI接口的调用权限,确保只有授权用户/角色能调用AI模型(如医疗场景:仅医生可调用影像分析模型)。

@RestController

@RequestMapping("/ai/medical")

public class MedicalAIController {

@Autowired

private ChatClient medicalChatClient;

// 仅ROLE_DOCTOR角色可调用

@PostMapping("/analyze")

@PreAuthorize("hasRole('DOCTOR')")

public String analyzeImage(String imageInfo) {

return medicalChatClient.call("分析影像:" + imageInfo).getResult().getOutput().getContent();

}

}

(4)配置外部化:Spring Boot配置体系

AI模型的参数(API Key、模型名称、温度等)可通过application.yml、环境变量、配置中心(Nacos/Apollo)统一管理,符合Spring应用的配置习惯。

(5)监控与可观测性:Spring Boot Actuator集成

SpringAI支持暴露AI调用的监控指标(如调用次数、耗时、失败率),可通过Spring Boot Actuator接入Prometheus/Grafana,实现AI能力的可观测。

4. 提示词(Prompt)管理机制:标准化+模板化

SpringAI提供了一套标准化的Prompt管理能力,解决Prompt硬编码、复用性差的问题:

- Prompt模板:支持基于Mustache/FreeMarker的模板化Prompt,动态填充参数;

- Prompt工程:支持Prompt的版本管理、参数校验、上下文拼接。

// 1. 定义Prompt模板(可配置在yml或文件中)

@Bean

public PromptTemplate orderAnalysisPromptTemplate() {

return PromptTemplate.of(

"分析用户{{userId}}的订单:{{orderList}},输出消费偏好,要求简洁明了"

);

}

// 2. 动态填充参数并调用

@Autowired

private PromptTemplate orderAnalysisPromptTemplate;

@Autowired

private ChatClient chatClient;

public String analyzeOrder(String userId, List<Order> orderList) {

// 填充模板参数

Prompt prompt = orderAnalysisPromptTemplate.create(Map.of(

"userId", userId,

"orderList", orderList.toString()

));

return chatClient.call(prompt).getResult().getOutput().getContent();

}

5. 流式响应机制:适配实时交互场景

SpringAI支持AI模型的流式响应(如ChatGPT的逐字输出),并适配Spring WebFlux的响应式编程模型,满足实时聊天、实时生成等场景。

// 流式调用示例(WebFlux接口)

@GetMapping("/chat/stream")

public Flux<String> streamChat(String message) {

return chatClient.stream(message)

.map(response -> response.getOutput().getContent());

}

三、SpringAI的底层执行流程(以ChatClient为例)

- 配置加载:Spring Boot启动时,自动配置类读取

application.yml中的模型配置(如OpenAI的API Key、模型名称); - Bean初始化:创建对应模型的

ChatClient实现类(如OpenAiChatClient),注册到Spring容器; - 请求构建:开发者通过标准化

ChatRequest/Prompt构建AI请求; - 模型适配:

ChatClient将标准化请求转换为底层模型的API请求(如OpenAI的Chat Completions API); - 请求发送:通过Spring的

RestTemplate/WebClient发送请求到模型服务商; - 响应解析:将模型返回的原始响应(JSON)解析为标准化的

ChatResponse; - 结果返回:开发者从

ChatResponse中提取结果,融入业务逻辑(如结合事务、权限管控)。

四、SpringAI核心机制的优势

- 低学习成本:Spring开发者无需学习新的AI调用范式,用Spring的方式使用AI能力;

- 企业级可靠性:复用Spring的事务、安全、监控、配置等能力,解决AI集成的“工程化问题”;

- 模型无关性:切换AI模型/服务商无需改动业务代码,降低技术绑定风险;

- 低侵入性:可快速为存量Spring项目叠加AI能力,无需重构现有架构。

总结

SpringAI的核心机制可概括为:以“标准化抽象层”统一AI能力调用,以“Spring自动配置”降低集成成本,以“生态深度融合”赋予AI能力企业级特性。其本质是将AI能力“封装成Spring组件”,让开发者像使用JdbcTemplate、RestTemplate一样使用AI模型,重点解决“AI能力如何融入企业级Spring应用”的问题,而非单纯的AI工作流编排(这部分可结合LangChain4j补充)。

2323

2323

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?