Python爬取静态网页

参考书籍:唐松《Python网络爬虫从入门到实践》

简介

静态网页一般指纯粹的HTML格式的网页,对于爬虫来说,静态网页的数据都比较容易获取,利用好Requests库就能轻松发送HTTP请求,获取到网页的数据。

Requests库的安装

Requests库可以帮助我们获取到响应内容,再通过一些参数来满足我们的需求,它的安装也十分简单,对于Windows用户来说,在已经装好Python环境之后,可以通过Win+R快捷键打开cmd命令行,输入:

pip install requests

就可以等待安装了

获取响应内容

Requests常用于获取某个网页的内容。使用代码

r = request.get(url)

可以返回一个名为r的response对象,url可以替换为爬取网页的详细网址。存储了响应的内容,利用不同的参数获取需要的信息,响应内容包括如下:

- r.text是服务器响应的内容,会自动根据响应头部的字符编码进行解码

- r.encoding是服务器内容使用的文本编码

- r.status_code用于检测响应的状态码,用于检测请求是否被正确响应。200表示请求成功;4xx表示客户端错误;5xx表示服务器错误响应。

- r.content是字节方式的响应体,会自动解码gzip和deflate编码的响应数据

- r.json()是Requests内置的JSON解码器。

运行代码如下所示:

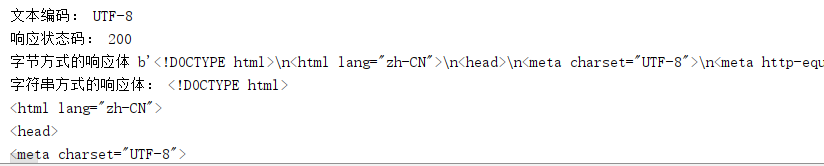

print("文本编码:",r.encoding)

print("响应状态码:",r.status_code)

print("字符串方式的响应体:",r.text)

print("字节方式的响应体",r.content)

运行结果如下所示:

这个时候,已经成功获取到信息并且输出了。

本文介绍如何使用Python的Requests库抓取静态网页,涵盖库的安装、获取响应内容及解析响应状态码等关键步骤。

本文介绍如何使用Python的Requests库抓取静态网页,涵盖库的安装、获取响应内容及解析响应状态码等关键步骤。

3019

3019

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?