一、CART算法回归树

1、原理:

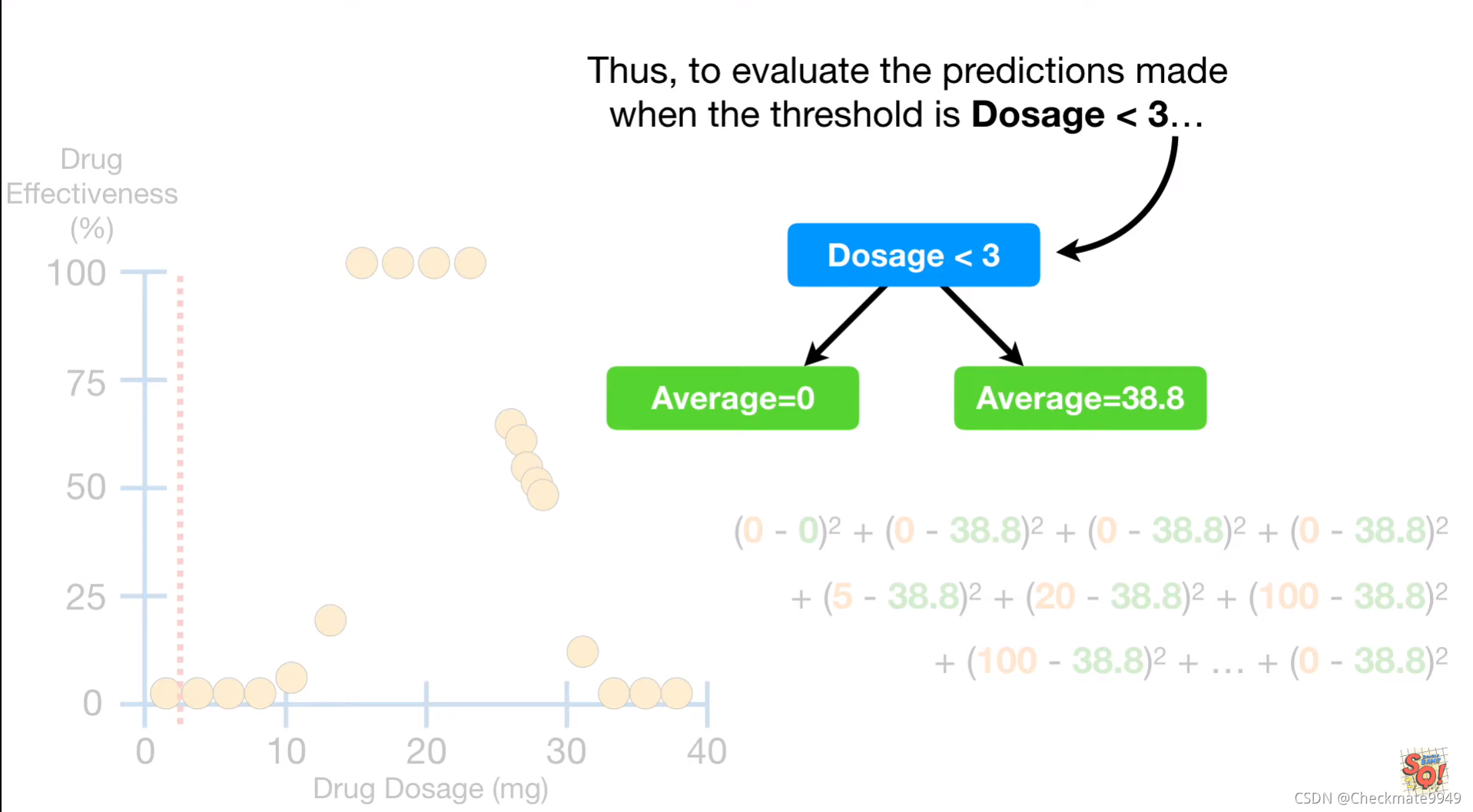

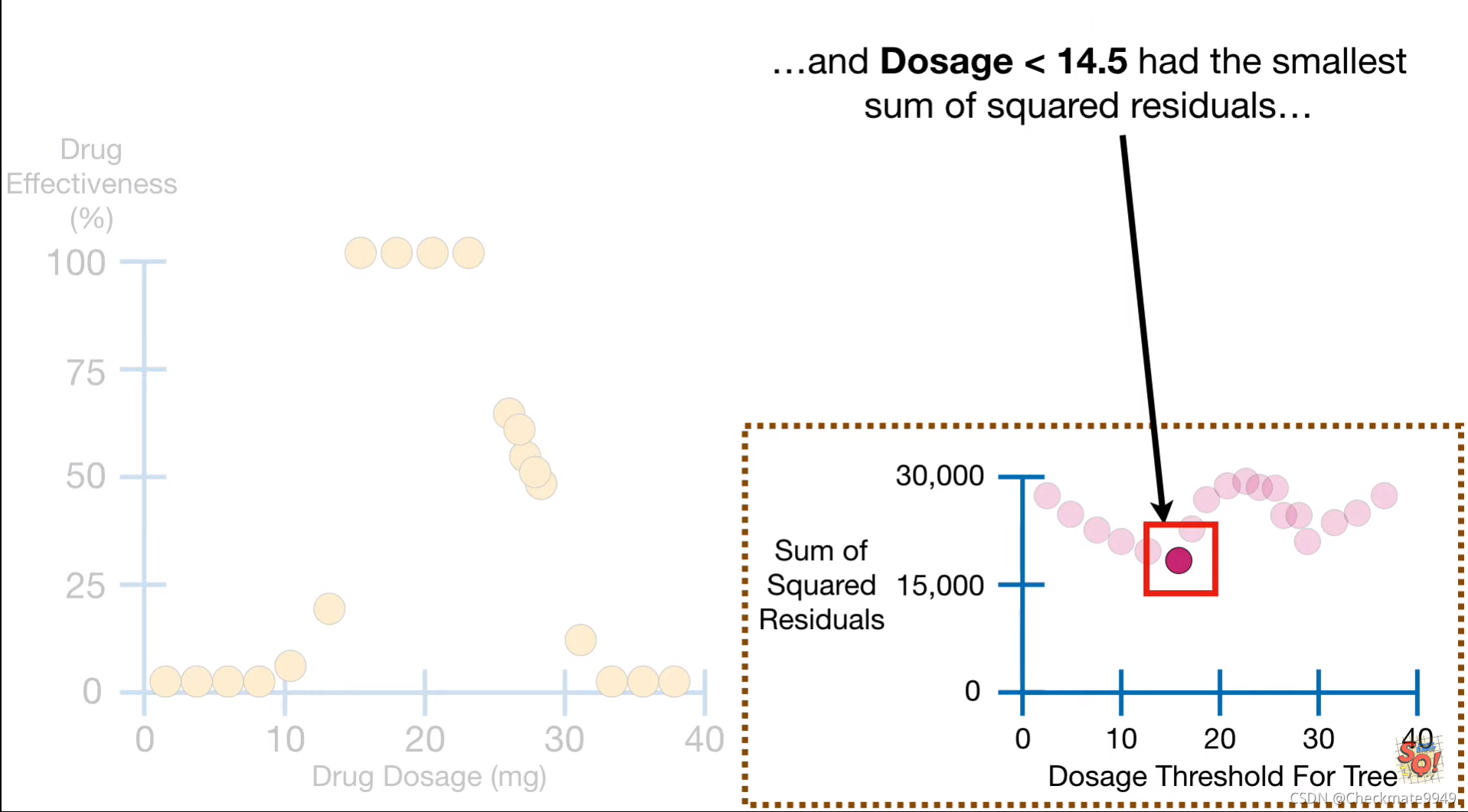

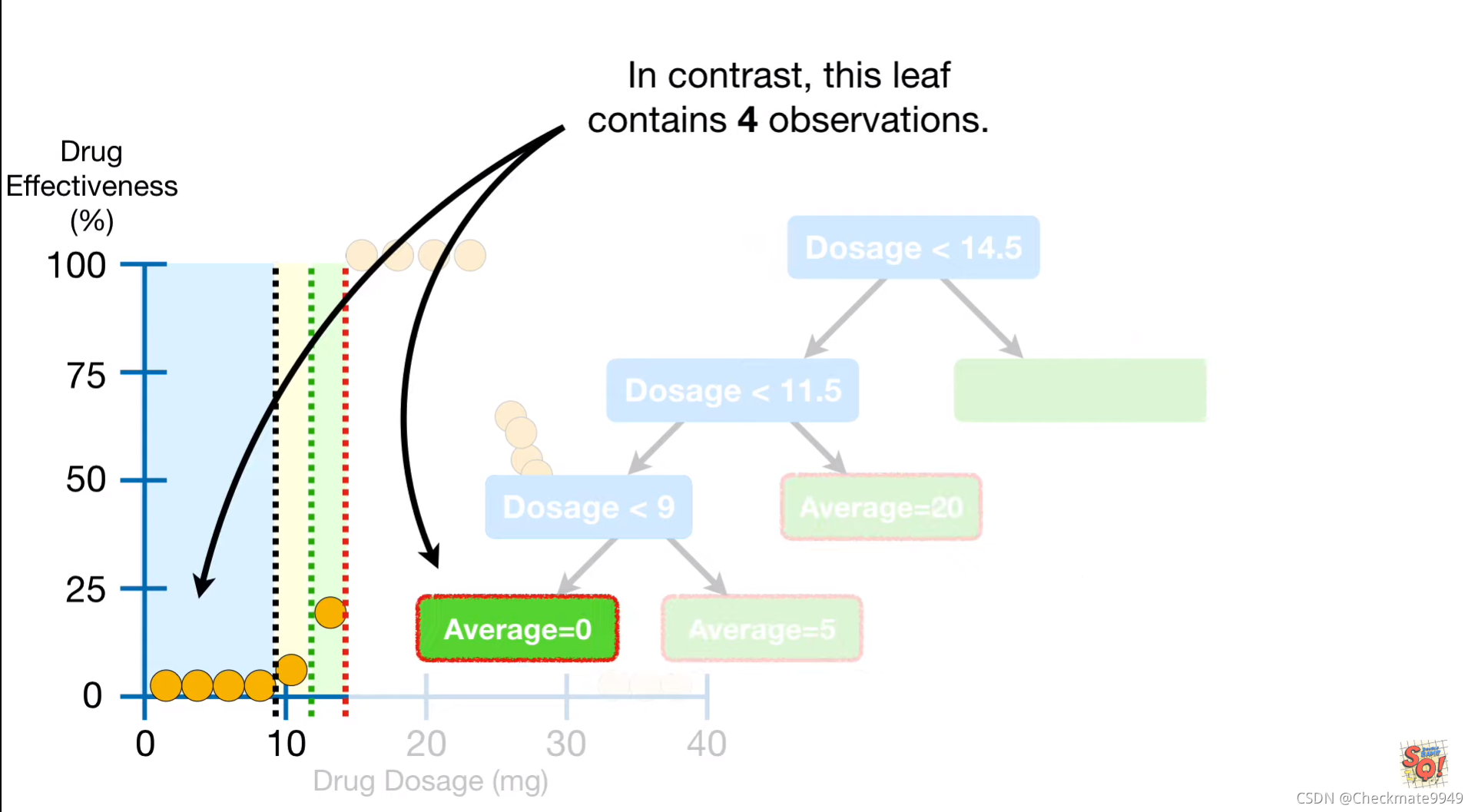

根据阈值计算均方根误差之和,并选取均方差误差和最小的阈值:

防止过度拟合:设定最小分割样本数https://www.youtube.com/watch?v=g9c66TUylZ4https://www.youtube.com/watch?v=g9c66TUylZ4 https://www.youtube.com/watch?v=g9c66TUylZ4

https://www.youtube.com/watch?v=g9c66TUylZ4

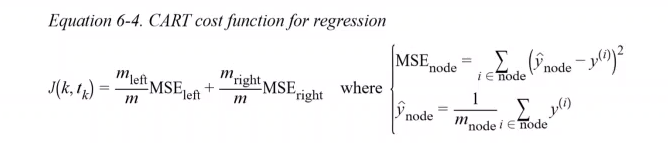

2、公式:

3、Sklearn是通过CART算法生成决策树

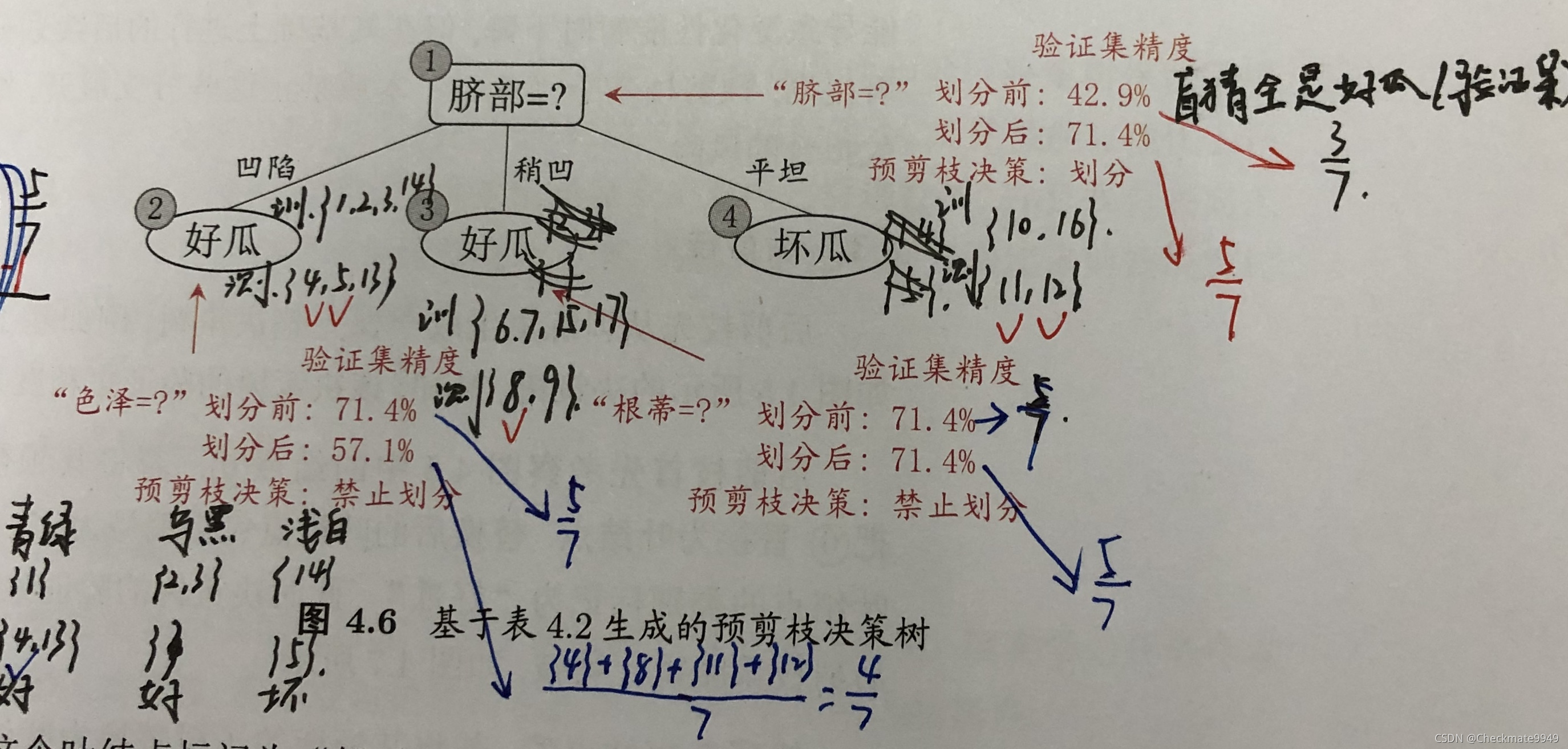

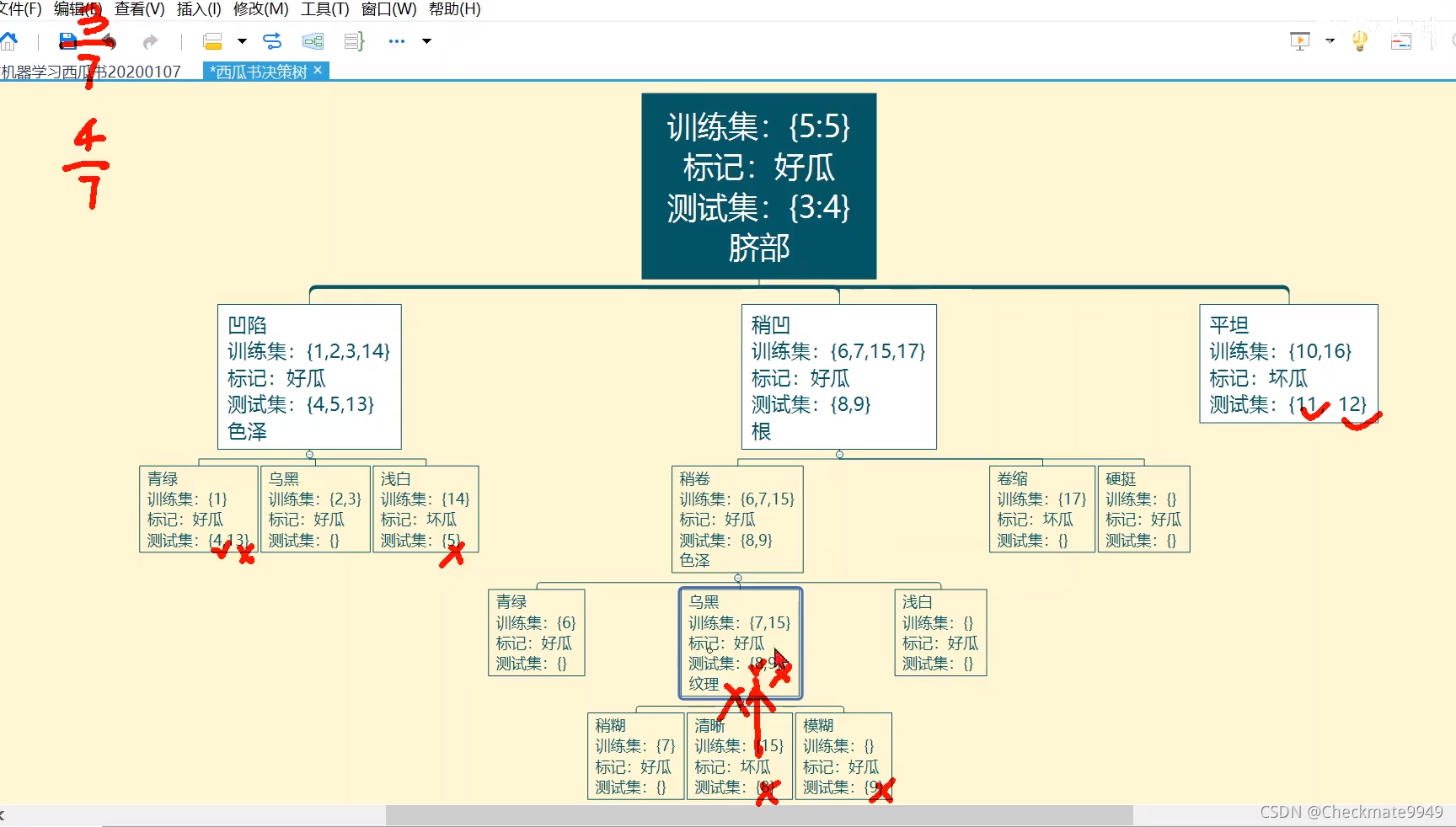

二、剪枝处理-预剪枝

1、作用:防止过度拟合

从上向下,精度提升再划分

2、概述

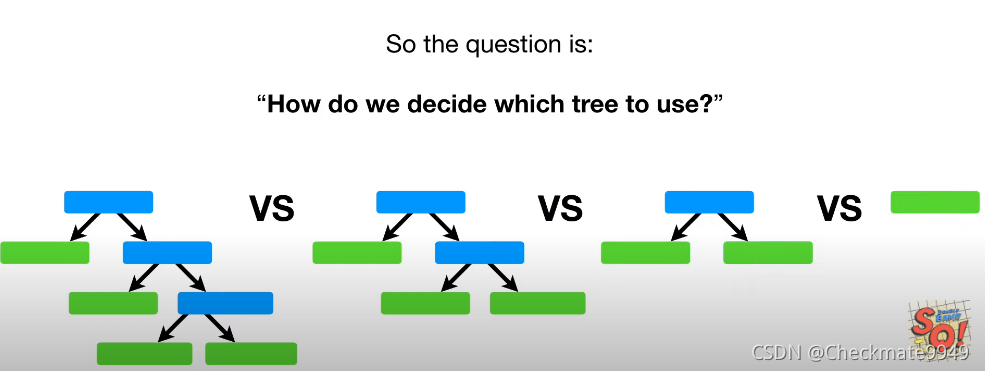

三、剪枝处理-后剪枝

从下往上,精度下降再剪枝(根据奥卡姆剃刀准则也可剪)

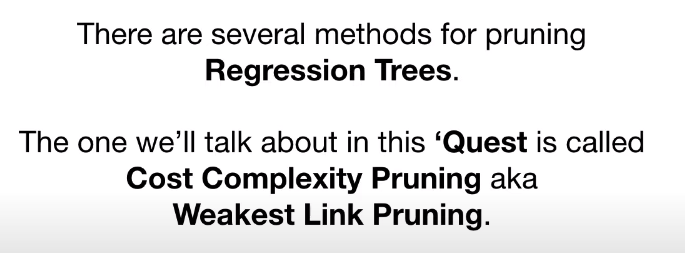

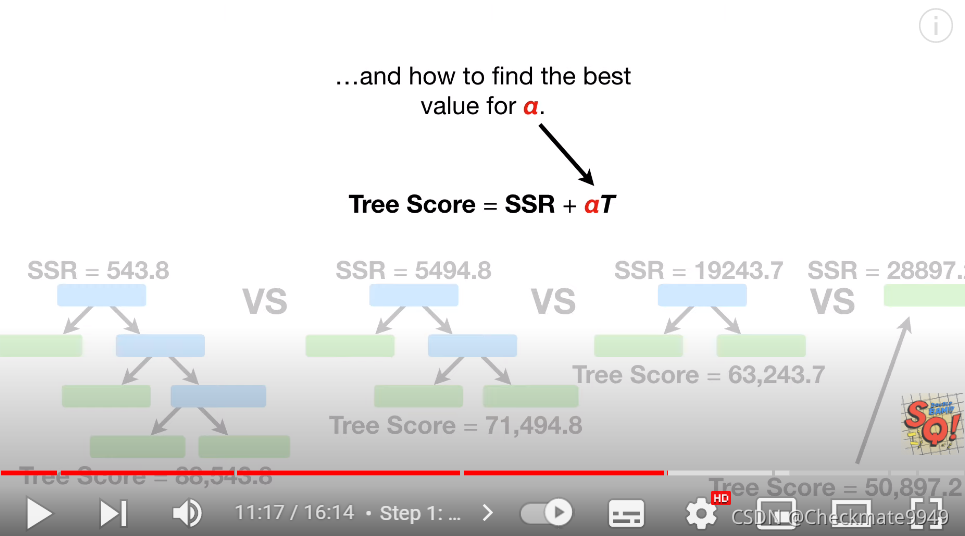

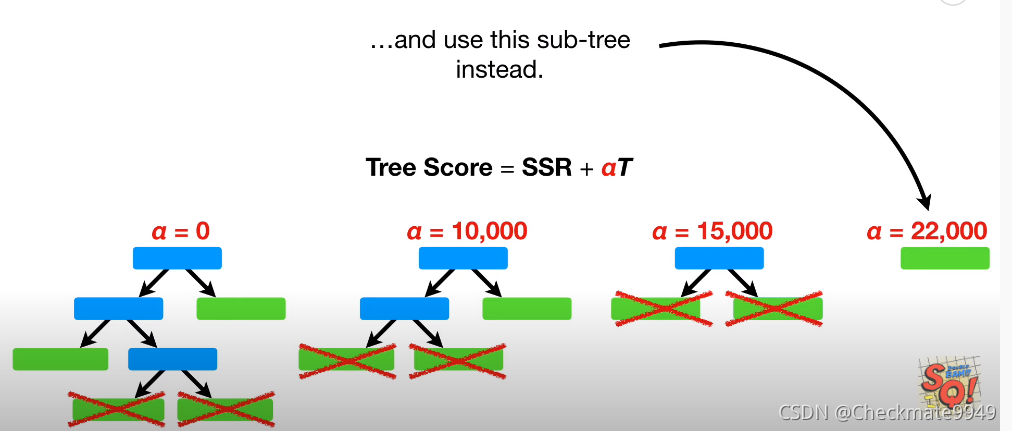

四、补充:回归树剪枝方法

https://www.youtube.com/watch?v=D0efHEJsfHo https://www.youtube.com/watch?v=D0efHEJsfHo

https://www.youtube.com/watch?v=D0efHEJsfHo

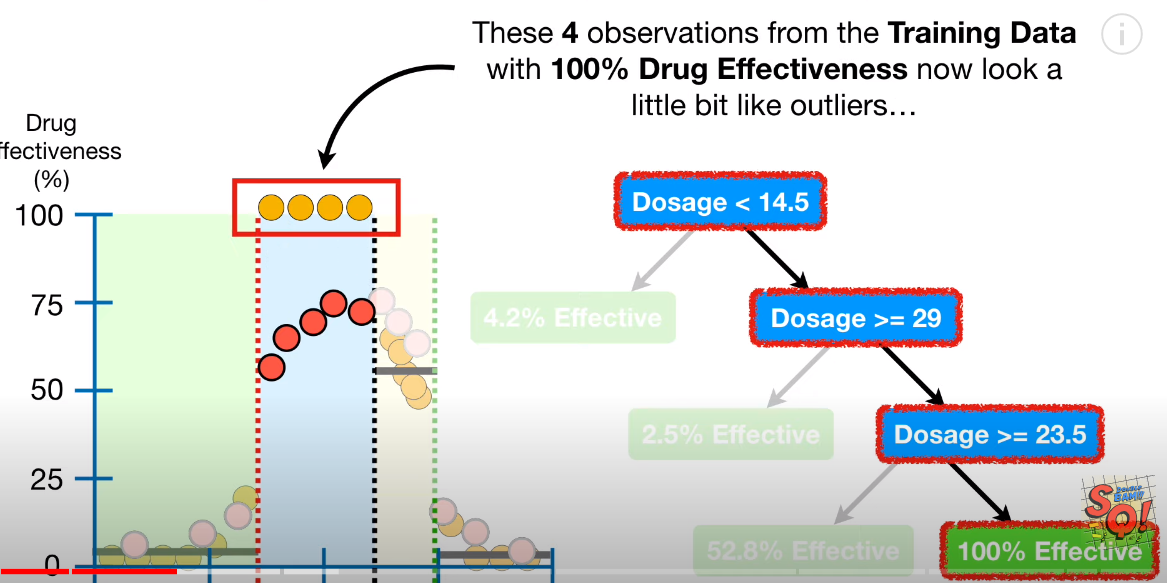

过大的误差,异常值,由样本内的过度拟合导致

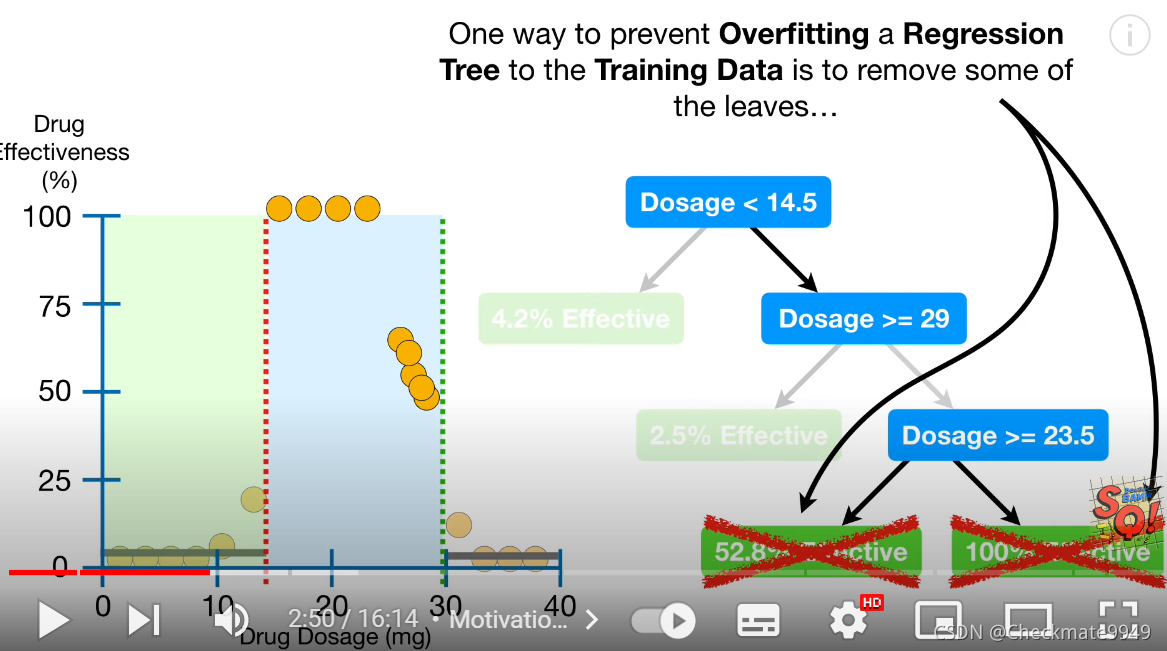

Remove some of the leaves: 防止过度拟合。

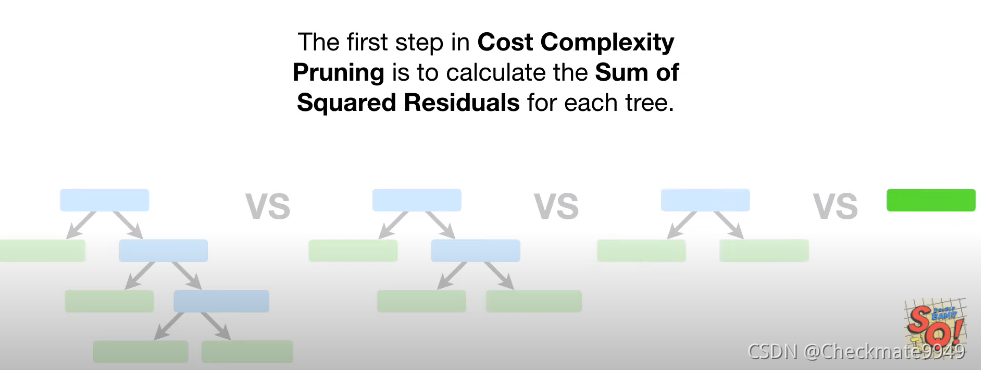

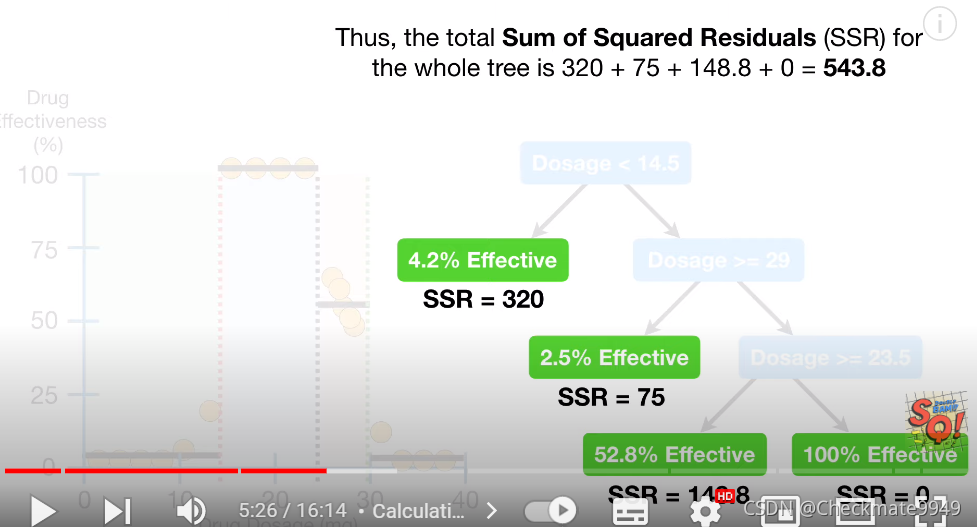

第一步:计算残差平方和SSR;

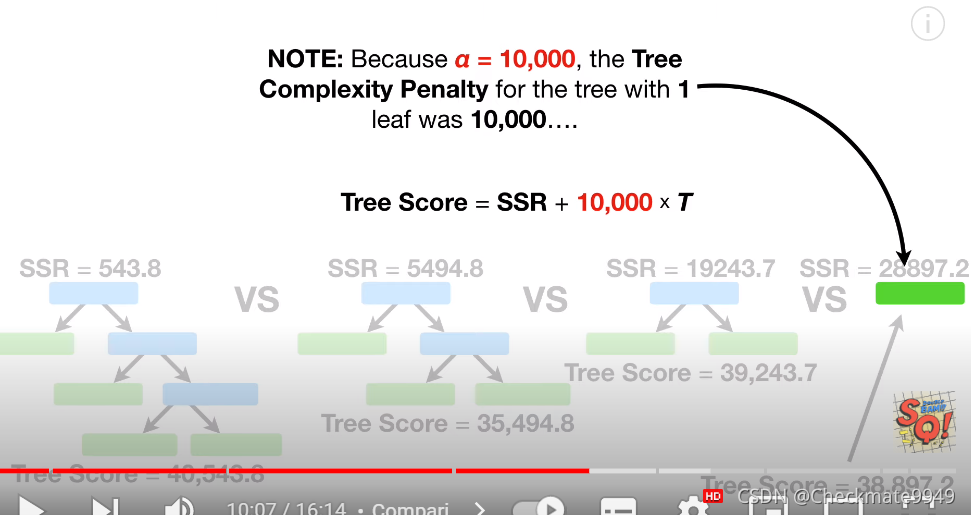

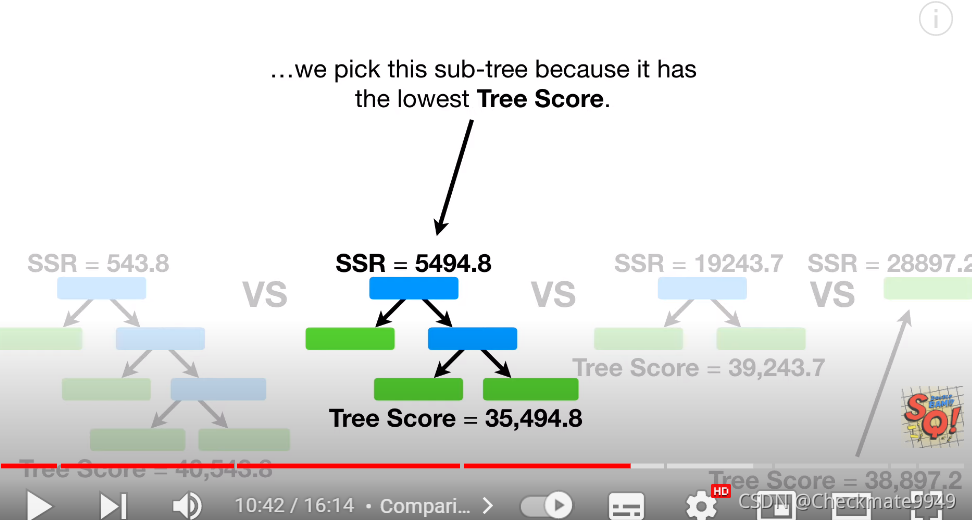

第二步:加上复杂惩罚项(即决策树叶子越多,该惩罚越大);

![]()

第三步:寻找最合适的Alpha值,选择test score最小的subtree。

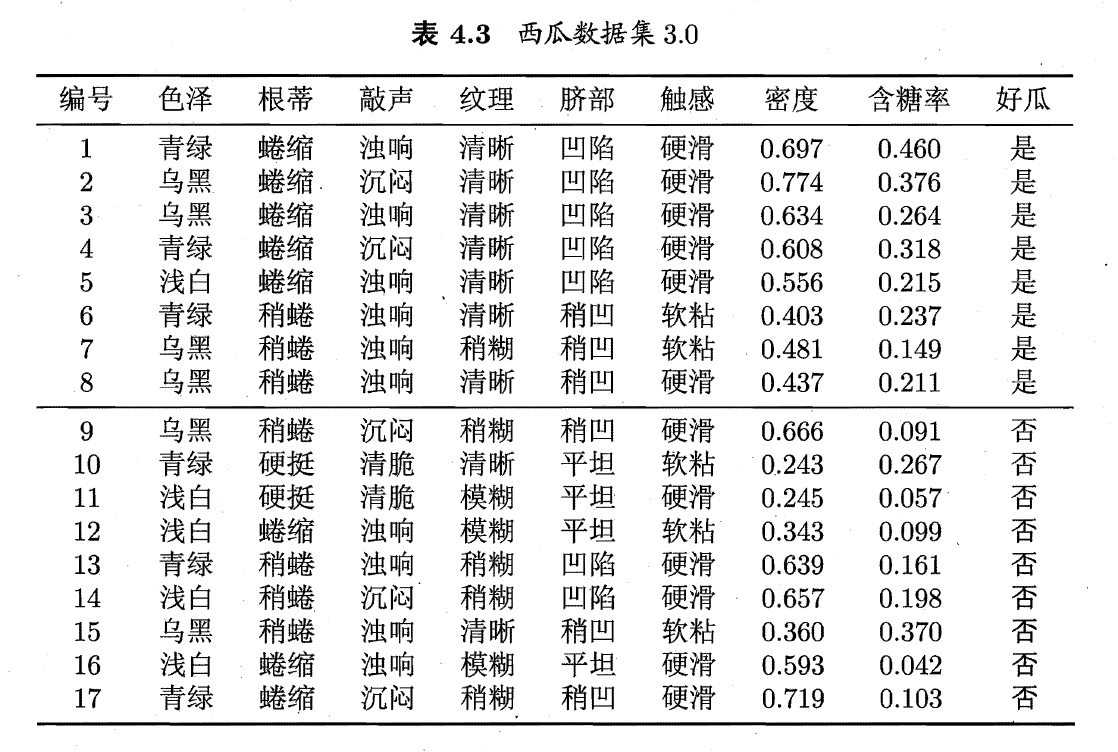

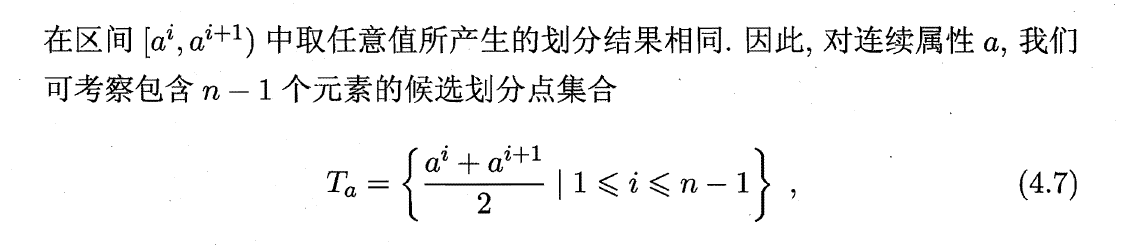

五、连续值处理

1、二分法:

(1)排序后求出其相邻的均值

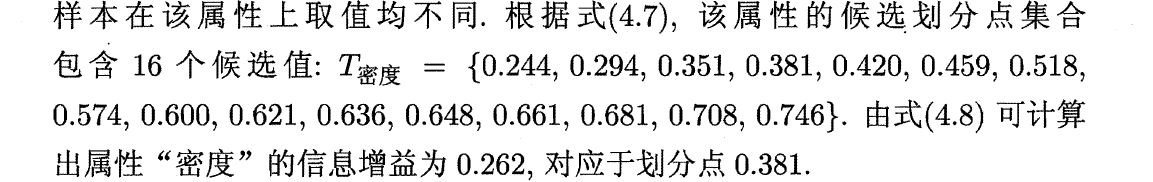

(2)根据每个候选划分点计算信息增益,计算得最大信息增益为0.262,对应于划分点0.381

划分点0.381计算过程如下:

六、缺失值处理

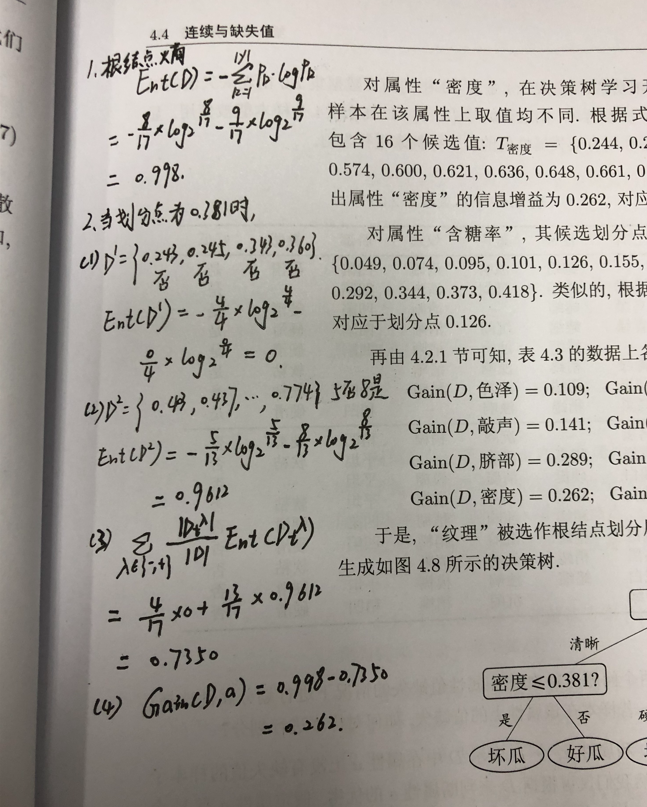

1、若西瓜数据集存在缺失值,如下:

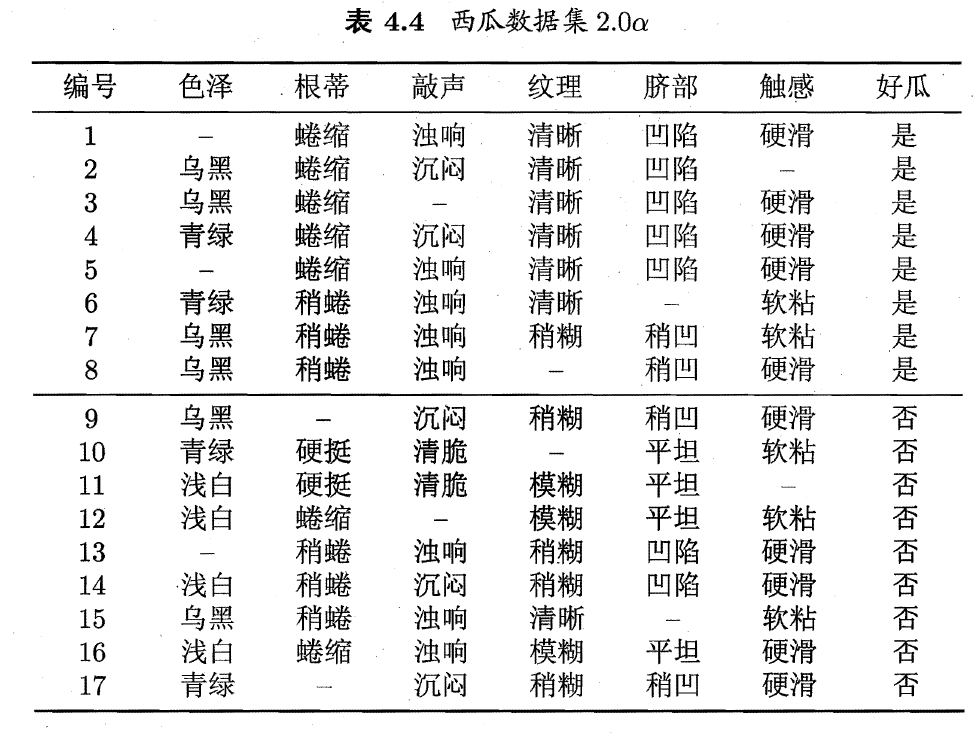

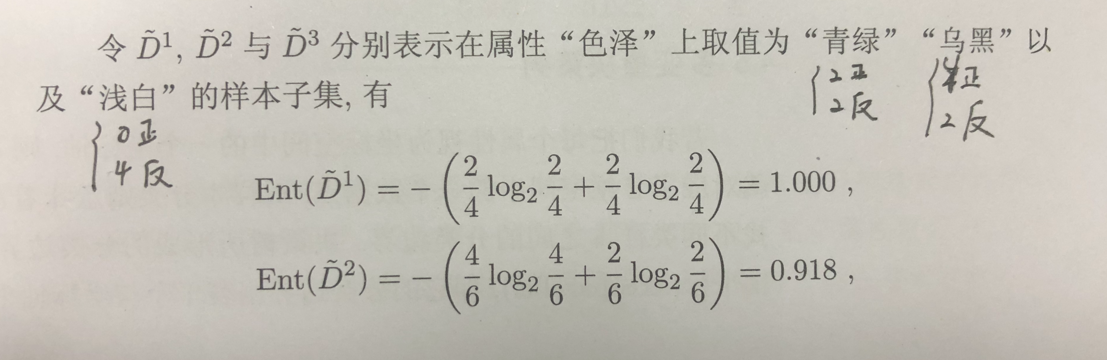

(1)根据属性“色泽”的14个非缺失值,计算“色泽”根节点熵:6个正例,8个反例

(2)根据属性“色泽”非缺失值的信息增益:

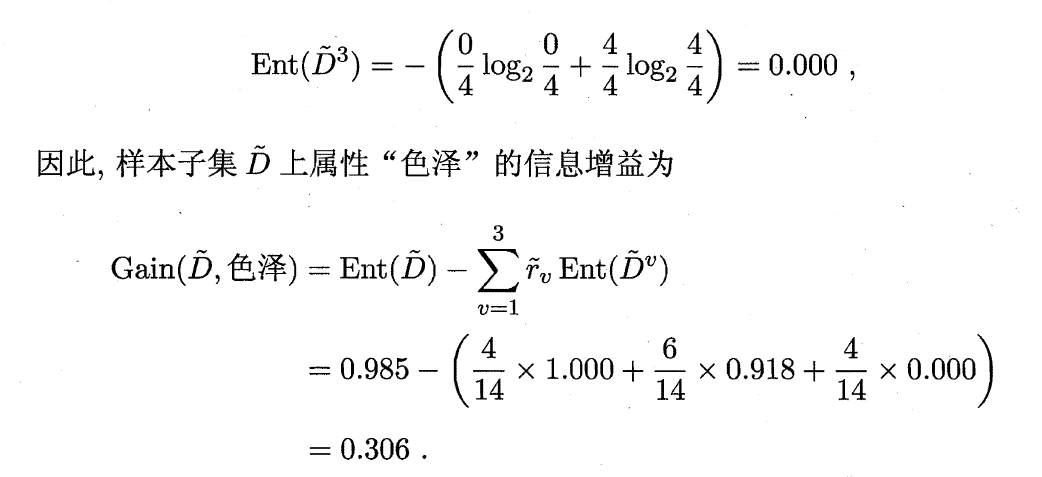

(3)乘以“惩罚系数,得最终信息增益”

(3)乘以“惩罚系数,得最终信息增益”

2、其他处理方法:

(1)离散值:

1)众数填充

2)相关性最高的列填充

(2)连续值:

1)中位数填充

2)相关性最高的列做线性回归估计

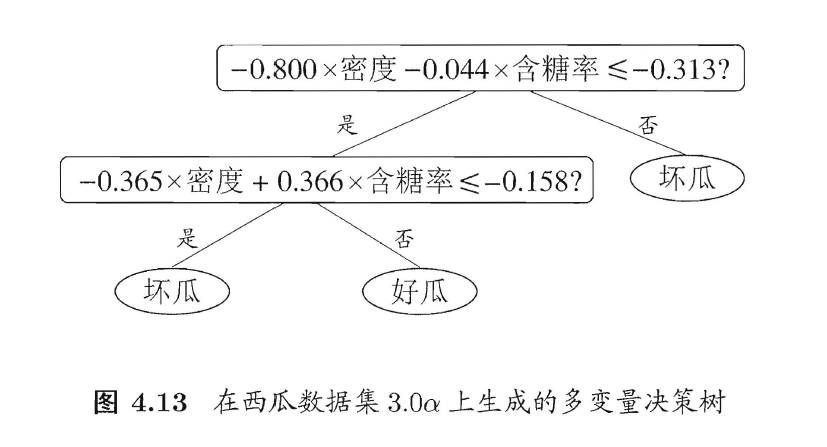

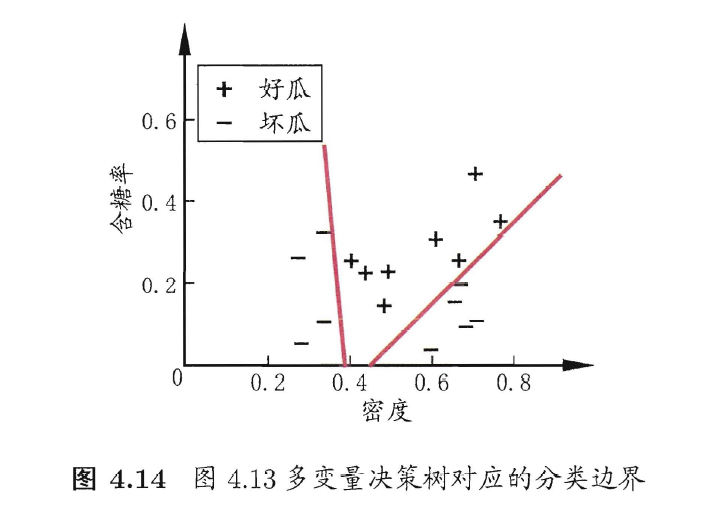

七、多变量决策树

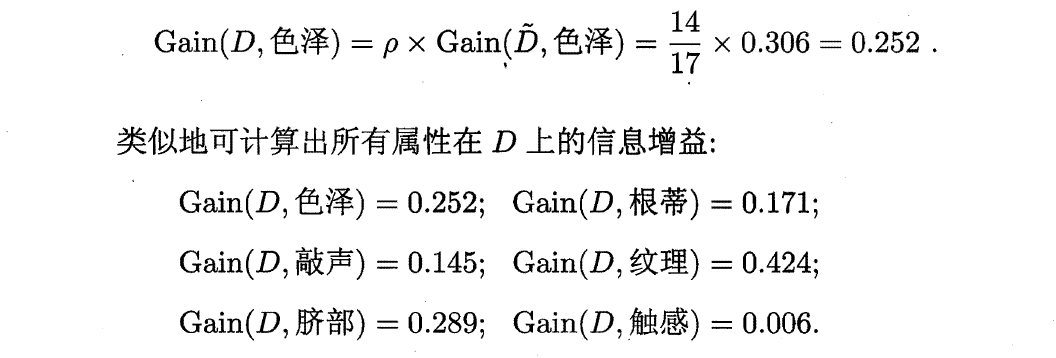

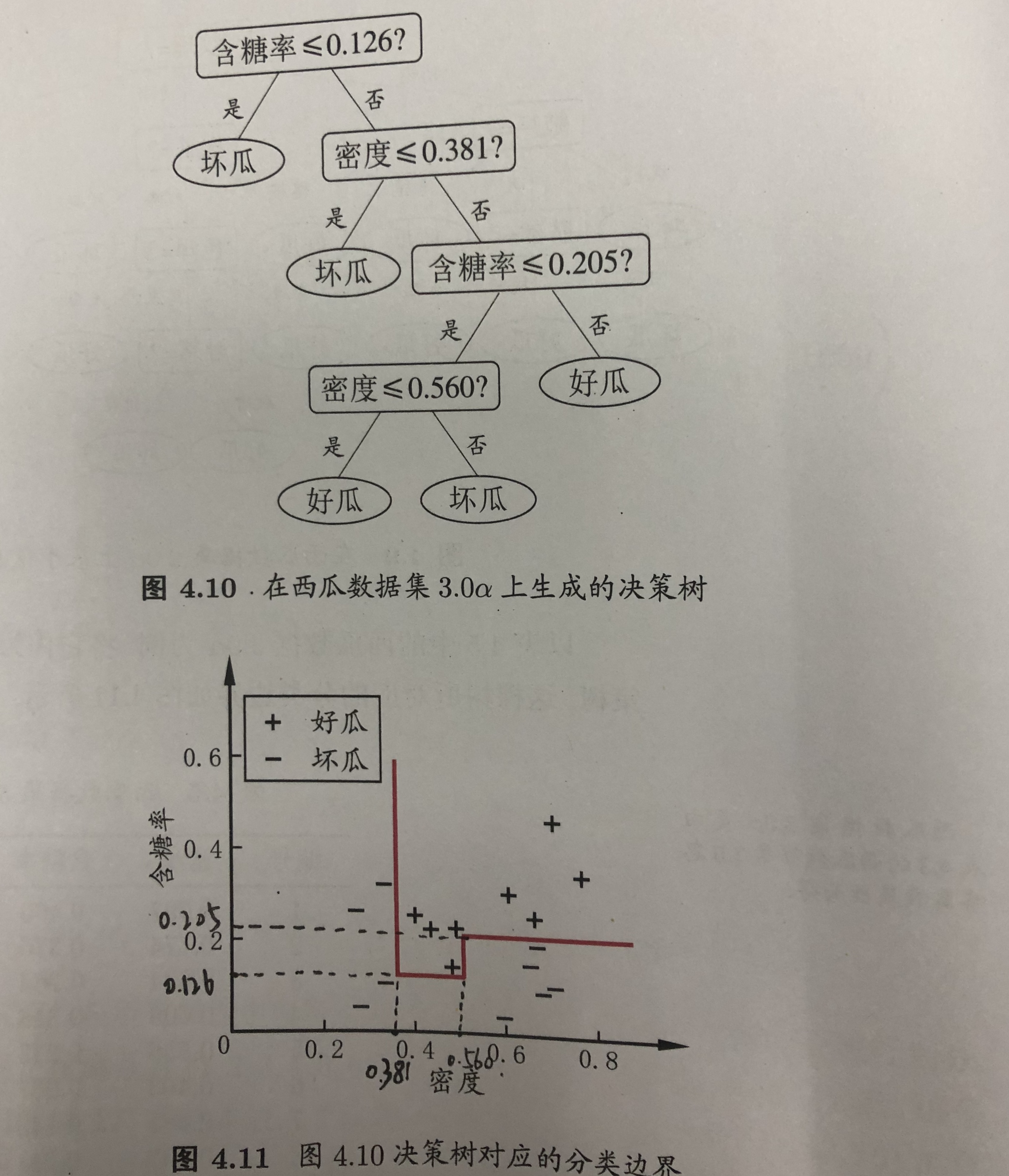

1、根据决策树形成的分类边界

2、多变量决策树:

(1)判定条件有多个变量

(2)对应分类边界:属性的线性组合

八、阅读资料

1、决策树有多种算法

ID3,C4.5, CART, C4.5Relu

多变量决策树算法OC1

感知机决策树:叶节点上嵌入神经网络

2、泛化能力:剪枝

本文详细介绍了CART算法回归树的原理、公式,探讨了预剪枝和后剪枝防止过度拟合的方法,涉及连续值和缺失值处理,以及多变量决策树应用。重点讲解了回归树剪枝策略,包括计算残差平方和和复杂惩罚项的选择。

本文详细介绍了CART算法回归树的原理、公式,探讨了预剪枝和后剪枝防止过度拟合的方法,涉及连续值和缺失值处理,以及多变量决策树应用。重点讲解了回归树剪枝策略,包括计算残差平方和和复杂惩罚项的选择。

1316

1316

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?