作者 | xxx 来源 | xxx

原文链接:

点击下方卡片,关注“自动驾驶之心”公众号

>>自动驾驶前沿信息获取→自动驾驶之心知识星球

本文只做学术分享,如有侵权,联系删文

「多尺度双边网格框架

实现几何与视觉渲染质量的双重突破」

在自动驾驶领域,准确、高效的三维场景重建对于确保安全、避障和可靠导航至关重要。然而,传统方法常常面临由于光照条件、动态物体等因素引起的光度不一致和几何不准确问题。

在自动驾驶技术飞速发展的今天,如何在复杂的动态环境中进行高精度的三维场景重建,依然是自动驾驶系统面临的一大挑战。传统的场景重建方法常常因为光照变化、视角差异和动态物体的影响,导致光度不一致和几何误差。

为此,北京智源人工智能研究院(BAAI), 清华大学智能产业研究院(AIR) 提出了一种多尺度双边网格框架,能够在不同尺度上对3D场景表征进行局部和全局调整,从而有效解决了光度不一致性问题,并提升了几何重建的精度。

通过在多个标准数据集(如Waymo、NuScenes、Argoverse和PandaSet)上的实验验证,该方法在几何精度和视觉质量上均超越了现有技术,尤其在复杂的动态场景中表现优异。

《Unifying Appearance Codes and Bilateral Grids for Driving Scene Gaussian Splatting》已被人工智能和机器学习领域的顶级国际学术会议NeurIPS 2025接收。

左:本文的方法,右:OmniRe,极端光照变化导致OmniRe出现严重的光度不一致和几何失真。我们的方法则有效解决了光照变化带来的问题,呈现出更加清晰、稳定的几何结构。

1

—

主要方法

当前的自动驾驶场景重建面临着来自光照、相机视角差异和动态物体等多重因素的挑战,这些因素会导致图像之间的色彩不一致,从而影响重建的真实感和几何精度。

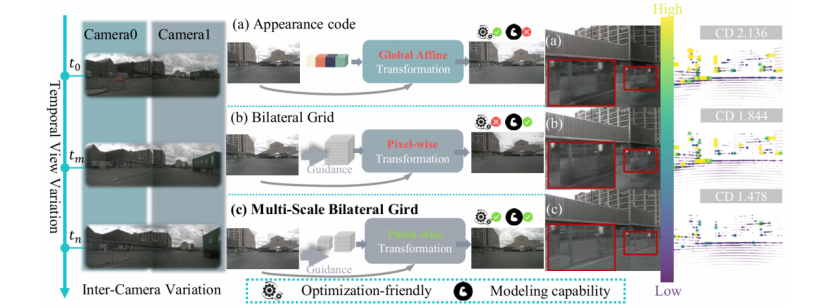

传统的解决方案,如外观编码(Appearance Codes)和双边网格(Bilateral Grids),各自有一定的优势,但仍然存在局限性。外观编码虽然能够调整全局光照,但无法处理局部光影变化;而双边网格则能够进行像素级的调整,但优化难度较大。

因此,如何结合两者的优点,实现更高效、更准确的自动驾驶场景重建,成为本研究的核心目标。

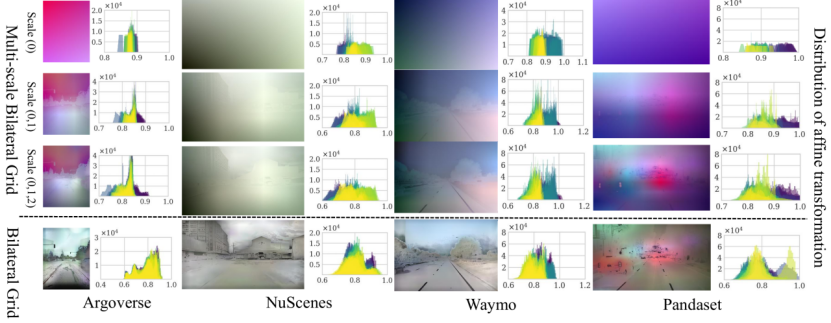

(a)外观编码进行全局变换,但建模能力有限。 (b)双边网格支持像素级变换,能提升色彩一致性,但优化难度大。 (c)本文提出的多尺度双边网格统一了前两者,实现了高效且强大的区块级变换。

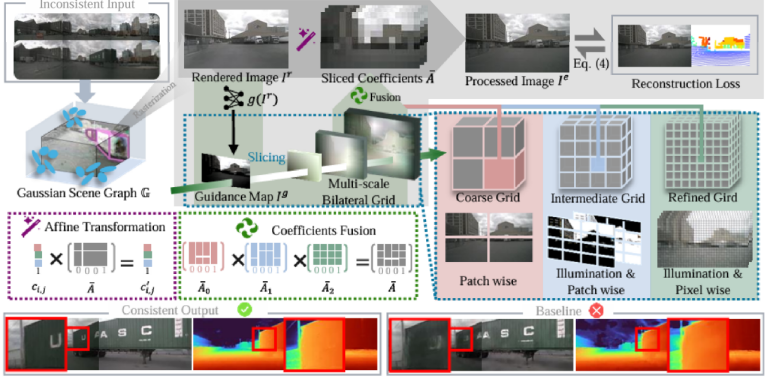

1.1 多尺度双边网格架构

我们采用高斯溅射(Gaussian Splatting)技术来建模复杂的驾驶场景。首先,场景被分解为一个混合场景图,包括独立建模的天空、静态背景和动态物体(如车辆、行人)。从该场景图渲染得到初步图像,尽管几何重建准确,但由于光照和视角变化,渲染图像通常存在明显的光度不一致性。

渲染图像接下来会送入我们设计的多尺度双边网格进行处理,最终输出色彩一致且观感真实的高质量图像。此过程分为三层次:

粗层级(Coarse Level):该层通过一个小型网格(2×2×1×12)捕捉并校正场景级别的全局光照和色调偏差,相当于外观编码的作用。

中层级(Intermediate Level):使用中等尺寸的网格(4×4×2×12),进一步调整区域性光影变化,例如大块阴影或光斑。

精细层级(Fine Level):使用更高分辨率的网格(8×8×4×12),进行像素级的精细微调,精确恢复物体的局部细节和材质。

多尺度双边网格架构示意图

1.2 层次化光度优化

每个网格层采用不同的学习策略,通过一个基于亮度引导的“切片”(Slicing)操作,结合三线性插值来确保平滑过渡。

粗层网格首先对全局光照进行调整,中层进一步处理区域性差异,而精细层则专注于局部像素级的微调。最终,所有层级的输出通过递进的方式进行融合,确保从全局到局部的逐级优化。

为了确保训练的稳定性和在真实环境中的应用效果,我们采用了从粗到细的优化策略。粗层使用较高的学习率进行全局光照校正,而精细层则以较低学习率微调细节。此外,我们还引入了正则化项,确保学习到的变换平滑且合理,从而避免了伪影和纹理失真。 循环正则化损失( ) 鼓励学到的色彩变换是可逆的,从而有效约束了变换空间,防止产生伪影,保证了高质量的视觉效果:

而自适应总变分正则化( )惩罚网格内部特征的剧烈变化, 使我们多尺度网格学习到的颜色变换更加平滑,并减少噪声伪影:

为了有效地训练整个框架,我们定义了一个复合损失函数,结合了重建损失、几何损失以及正则化项。主要的优化目标是最小化渲染图像与真实图像之间的差异,同时保持几何形状的准确性。损失函数可以表示为:

2

—

实验结果

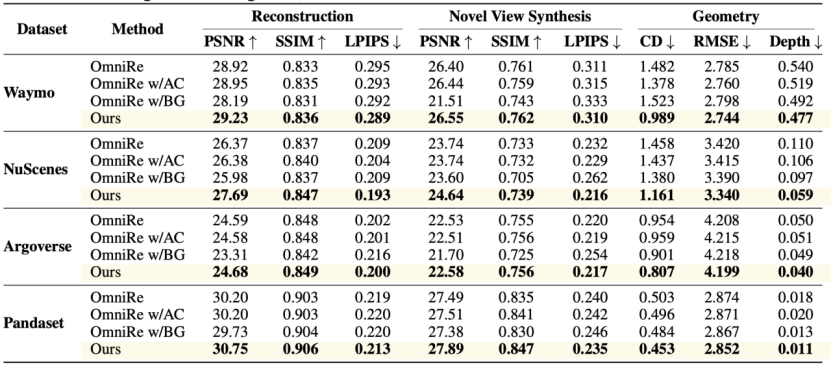

为了验证我们提出的多尺度双边网格框架在自动驾驶场景重建中的有效性,我们在Waymo、NuScenes、Argoverse和PandaSet这四个大规模自动驾驶数据集上进行了广泛的实验。

这些数据集涵盖了不同的传感器配置(如LiDAR、摄像头规格)、环境条件(光照、季节变化)和地理位置,确保了实验结果的广泛适用性。 我们比较了不同方法在几何精度、外观一致性、渲染质量等方面的表现,并对比了现有的最先进模型。

2.1 几何精度与外观一致性

在几何精度方面,我们的方法显著优于所有基准模型。

在Waymo数据集上,倒角距离(CD)从OmniRe的1.378降低至我们方法的0.989,提升了28.2%。

在NuScenes数据集上,我们的方法将CD降低至1.161,相较于OmniRe的1.458也有显著改善。

在外观一致性方面,我们的方法在PSNR和SSIM指标上也表现出色。例如,在NuScenes数据集上,我们的方法PSNR达到了27.69,比OmniRe的26.37有明显提升,SSIM也从OmniRe的0.837提升到了0.847。

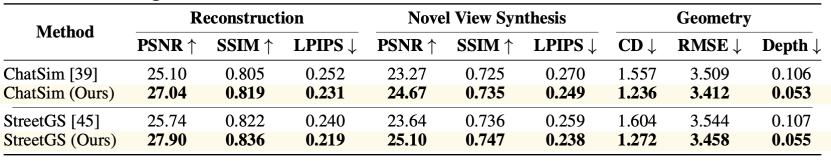

2.2 对现有SOTA模型的增强能力

为了验证方法的通用性,本文将其核心模块集成到了两种先进的基线方法ChatSim和StreetGS中。

结果显示,本文的方法能作为即插即用的增强模块,带来巨大提升。例如,它将ChatSim的重建PSNR从25.10提升至27.04;同时将StreetGS的重建PSNR从25.74提升至27.90,并将其几何误差(CD)从1.604降低到1.272。

2.3极端场景对比

我们进一步测试了极端场景(如夜间场景、极端光照、反射、雨天等),证明我们的模型在这些困难条件下表现更加稳健。

2.4 定性评估

以下视频展示了我们方法在处理车表面反射时的表现。

与 OmniRe 对比,视频中可以看到我们的方法在反射区域的处理上更加精准,避免了反射物体的畸变和浮动现象。

另一个视频展示了 我们的多尺度双边格栅 与 OmniRe 方法在阴影和阳光变化下的对比。

我们的方法在这种光照剧烈变化的场景中表现得尤为出色,能够更好地恢复物体细节,并减少因光照变化引起的几何误差与色偏。

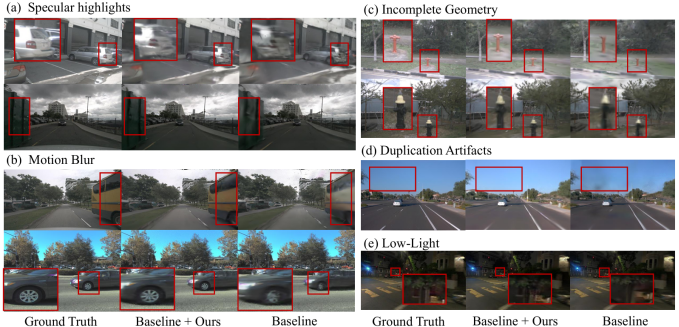

下图通过视觉对比,展示了本文的方法在处理真实世界复杂情况时的鲁棒性。通过对比真实图像(Ground Truth)、我们的结果(Baseline + Ours)和基线结果(Baseline),可以观察到:

(a)高光区域:基线方法在车身反光处出现过曝和细节丢失,而本文的方法能有效抑制高光,还原出下方纹理。

(b)运动模糊:本文的方法能生成比基线更清晰的动态物体边缘,有效减轻运动模糊带来的影响。

(c)和(d)不完整几何与伪影:基线方法在重建远处或被遮挡的物体时,容易产生不完整的、破碎的几何结构,而本文的方法能生成更连贯、更完整的场景。

(e)低光照:在光线不足的场景下,本文的方法能更好地提亮暗部细节,同时避免噪点,还原出更真实的夜间场景。

下图则深入剖析了本文的方法为何有效。它通过直方图的形式,可视化了不同方法所“学习”到的色彩校正策略。

1.下排(Bilateral Grid):代表传统的单尺度双边网格。可以观察到,其学习到的变换分布通常呈现出两个尖锐的峰值(即“双峰分布”)。这表明它只学会了少数几种固定的、缺乏弹性的校正模式,难以适应真实世界中多样化的光照变化。

2.上三排(Multi-scale Bilateral Grid):代表本文的多尺度方法。其最终聚合后的变换分布直方图(最右侧叠加图)显得平滑和分散。这证明本文的方法学习到了一个极其丰富和多样化的色彩变换集合,能够从全局、区域到像素级别进行平滑过渡和精细调整。正是这种强大的适应性和表示能力,使其能够在各种复杂场景中取得鲁棒的、高质量的渲染结果。

3

—

总结

通过广泛的实验评估,我们验证了多尺度双边网格框架在自动驾驶场景重建中的有效性。与现有方法相比,我们的方法在几何精度、外观一致性和动态场景重建方面均取得了显著提升。特别是在处理动态变化和复杂光照条件下,我们的方法展现了更强的鲁棒性和更高的重建质量。

这一技术突破为自动驾驶和3D场景重建带来了新的可能。通过提高场景的几何精度和视觉真实感,本研究的方法不仅为自动驾驶系统的避障和路径规划提供了更加可靠的数据支持,还为未来的智能交通系统提供了更加稳定和安全的导航基础。

未来,研究团队计划进一步优化该框架,扩展其应用范围,处理更大规模和更复杂的场景,并探索更高效的计算方法,使该技术能够在更多实际应用中落地。

论文题目:Unifying Appearance Codes and Bilateral Grids for Driving Scene Gaussian Splatting

论文作者:Nan Wang, Yuantao Chen, Lixing Xiao, Weiqing Xiao, Bohan Li, Zhaoxi Chen, Chongjie Ye, Shaocong Xu, Saining Zhang, Ziyang Yan, Pierre Merriaux, Lei Lei, Tianfan Xue and Hao Zhao

论文链接:https://arxiv.org/abs/2506.05280

代码地址:https://github.com/BigCiLeng/bilateral-driving

项目主页:https://bigcileng.github.io/bilateral-driving/

自动驾驶之心

3DGS理论与算法实战课程!

添加助理咨询课程!

知识星球交流社区

多尺度网格实现自动驾驶重建新SOTA

多尺度网格实现自动驾驶重建新SOTA

3498

3498

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?