点击下方卡片,关注“自动驾驶之心”公众号

近年来,多模态大模型在自动驾驶领域的潜力逐渐显现。它们能否真正“看懂”路况、理解交通行为、甚至预测风险,成为行业内外关注的焦点。

笔者对近期阿里通义最新的Qwen3-VL模型进行了一系列自动驾驶场景的实测,涵盖场景理解、空间推理、行为判断、风险预测等多个维度。

个人认为,Qwen3-VL不仅在基础感知任务上表现稳健,更在开放式推理与动态场景理解中展现出令人惊喜的“老司机”潜质。

更重要的是,它并未经过专门的自动驾驶指令微调(SFT),却能对复杂交通场景做出合理、连贯、甚至带有“安全意识”的判断——这让我们看到了通用视觉语言模型在垂直领域中落地的更多可能。

本次测试选取了CoVLA基准中的部分图像,以及基准中的一些中翻后的问题。此外笔者也自拟了一些开放式问题。

一起来看看吧!更多关于自动驾驶的技术解析、行业动态和业内交流,

欢迎加入自动驾驶之心知识星球,超过4000的人自驾社区......

场景理解和空间推理

示例1

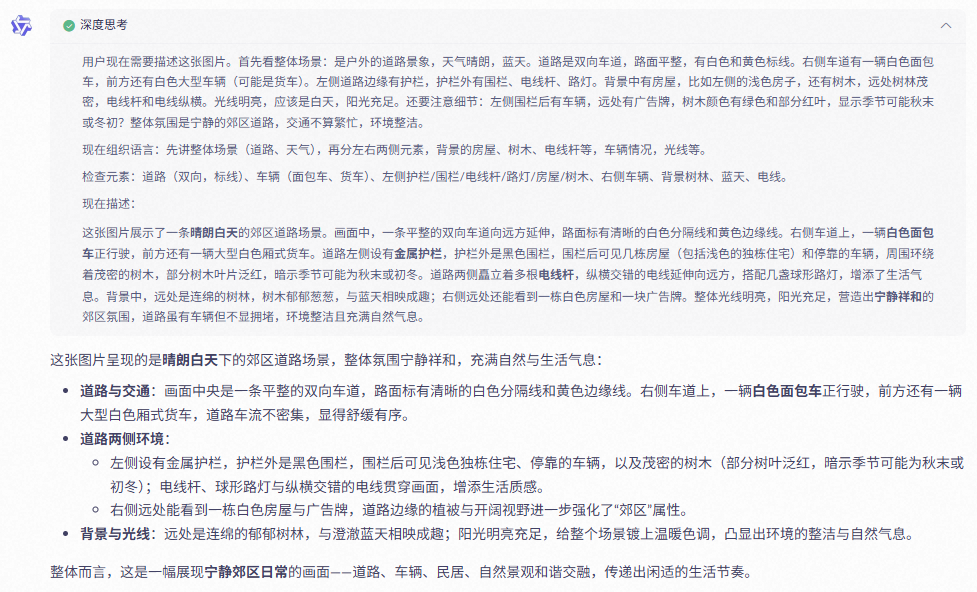

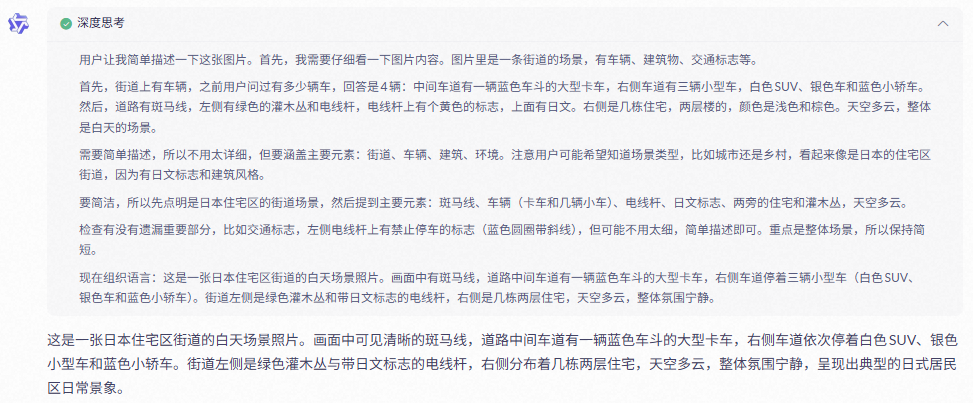

👨🎓:简单描述一下这张图片。

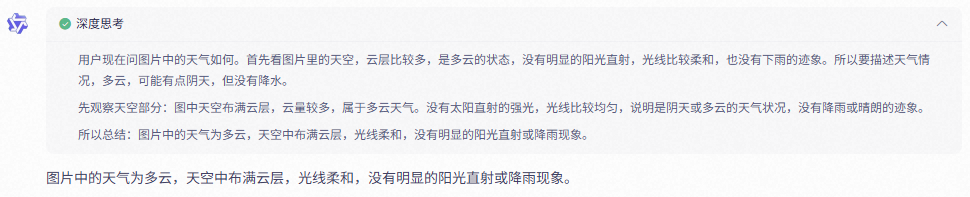

👨🎓:图片中的天气如何?

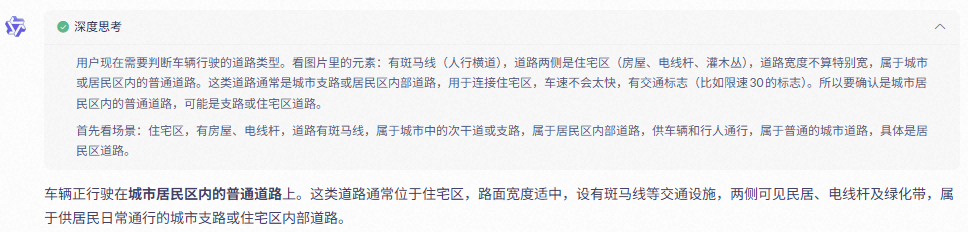

👨🎓:车辆正行驶在哪种道路?

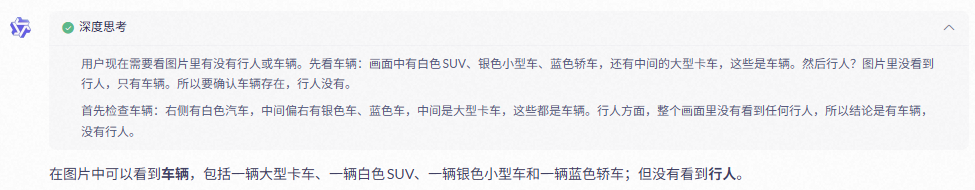

👨🎓:你可以在图片中看到行人或车辆吗?

示例2

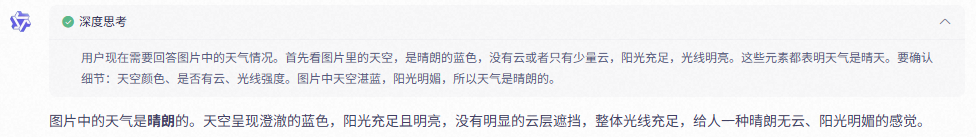

👨🎓:简单描述一下这张图片。

👨🎓:图片中的天气如何?

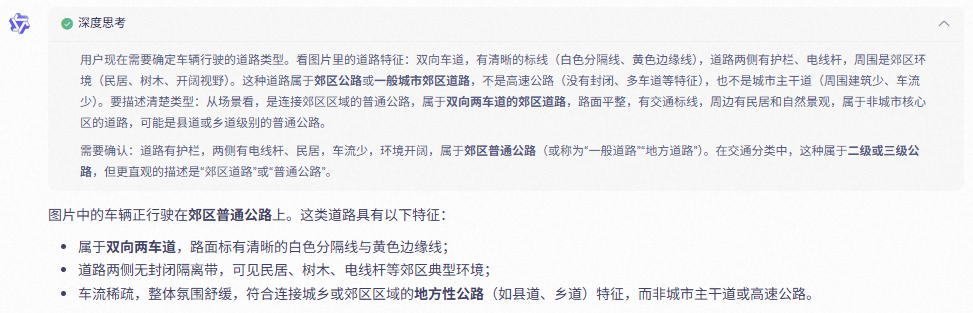

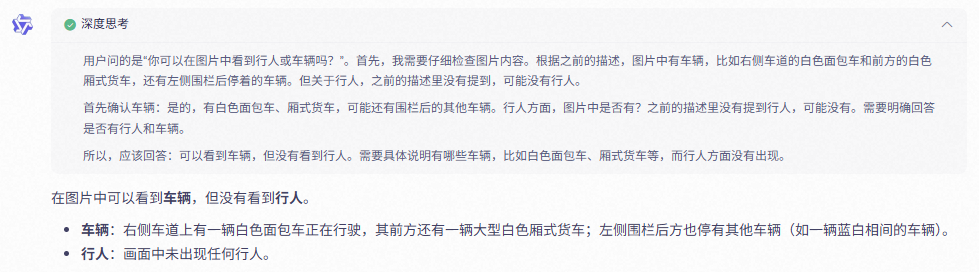

👨🎓:车辆正行驶在哪种道路?

👨🎓:你可以在图片中看到行人或车辆吗?

示例3

👨🎓:距离自车最近的车辆是什么?

👨🎓:前方那辆车是在移动还是静止的?

👨🎓:旁边车道的车有变道意图吗?

示例4

👨🎓:前方有多少辆车?在什么位置?

👨🎓:自车当前行驶在哪个车道上?前方有几条车道线?

👨🎓:图片中有交通信号灯吗?如果有,是什么颜色?

行为决策和因果推理

示例1

👨🎓:基于当前情况,自车应该加速、减速还是保持速度?

👨🎓:图中最大的潜在危险是什么?

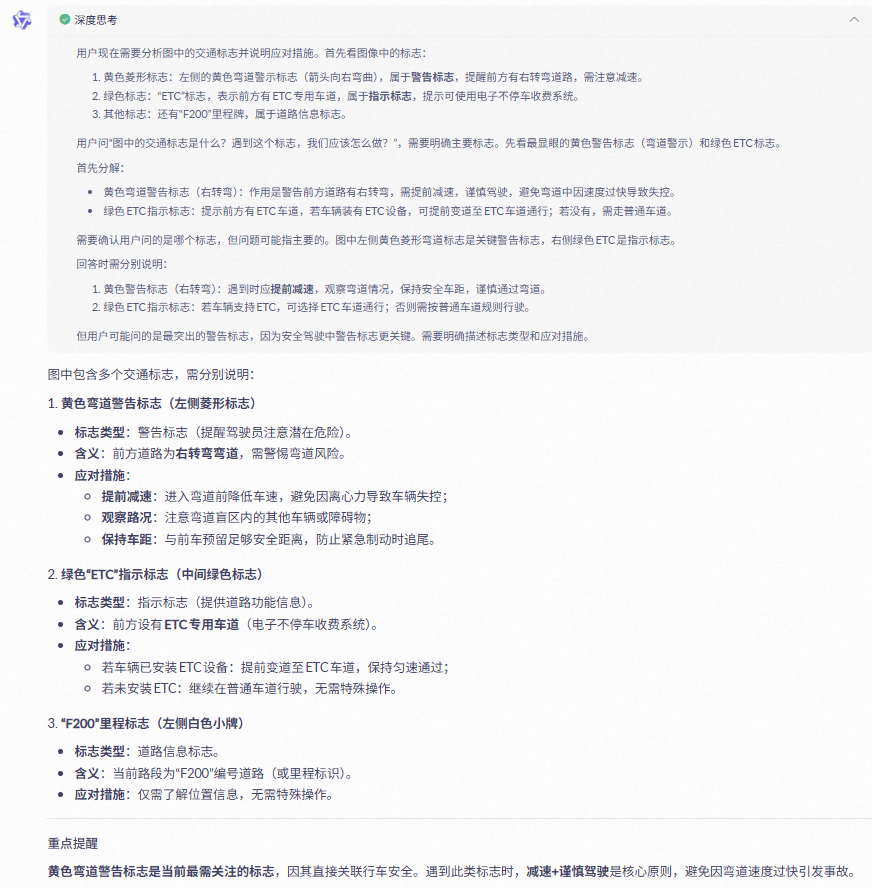

👨🎓:图中的交通标志是什么?遇到这个标志,我们应该怎么做?

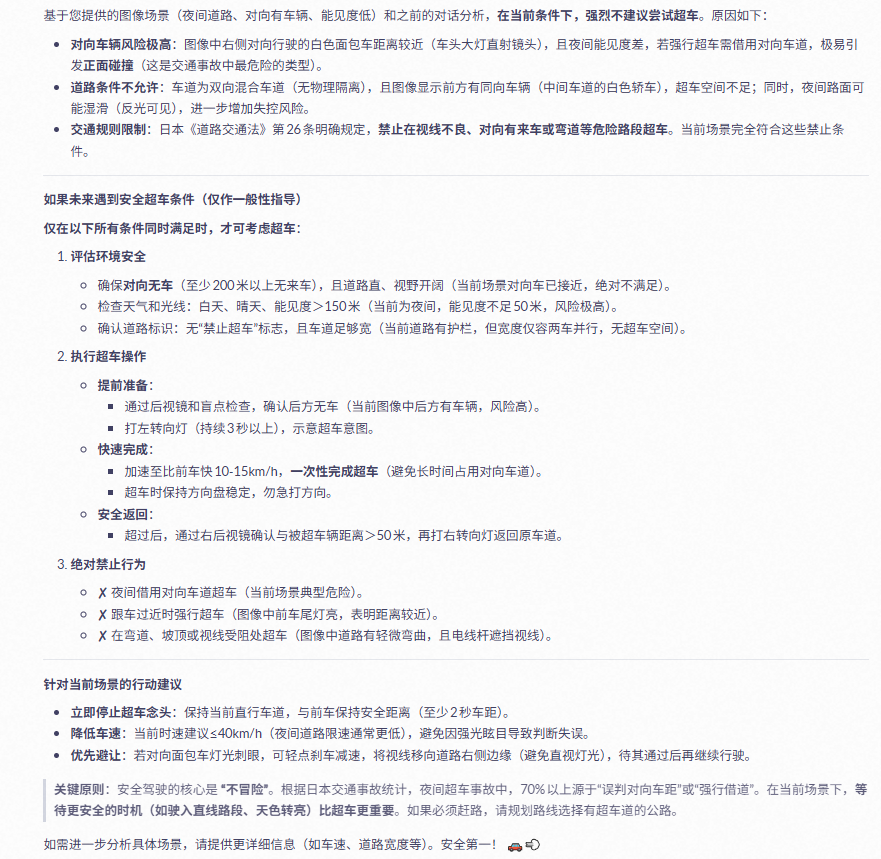

示例2

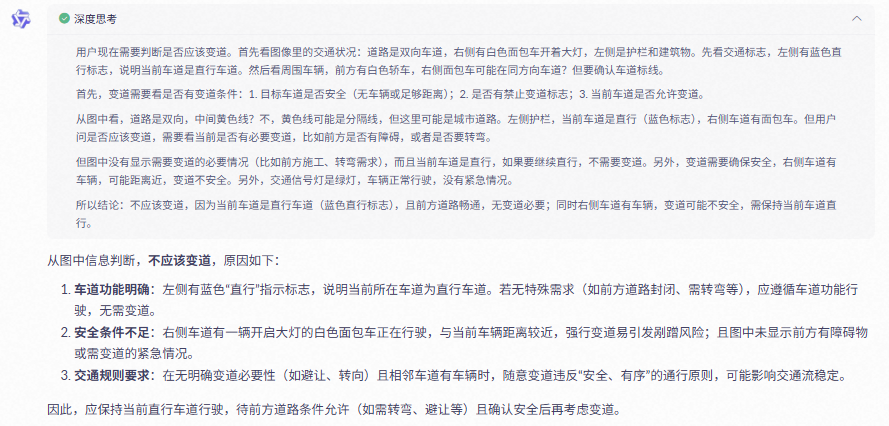

👨🎓:我们现在应该变道吗?为什么?

👨🎓:请按危险程度对图像中的交通参与者进行排序。

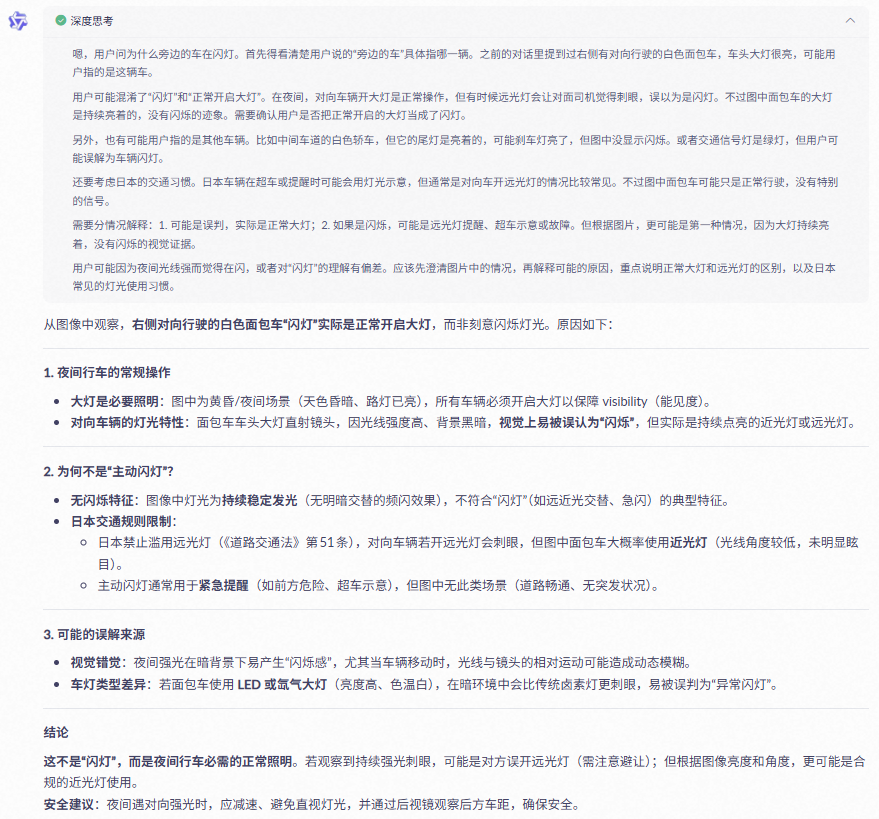

👨🎓:为什么旁边的车在闪灯?

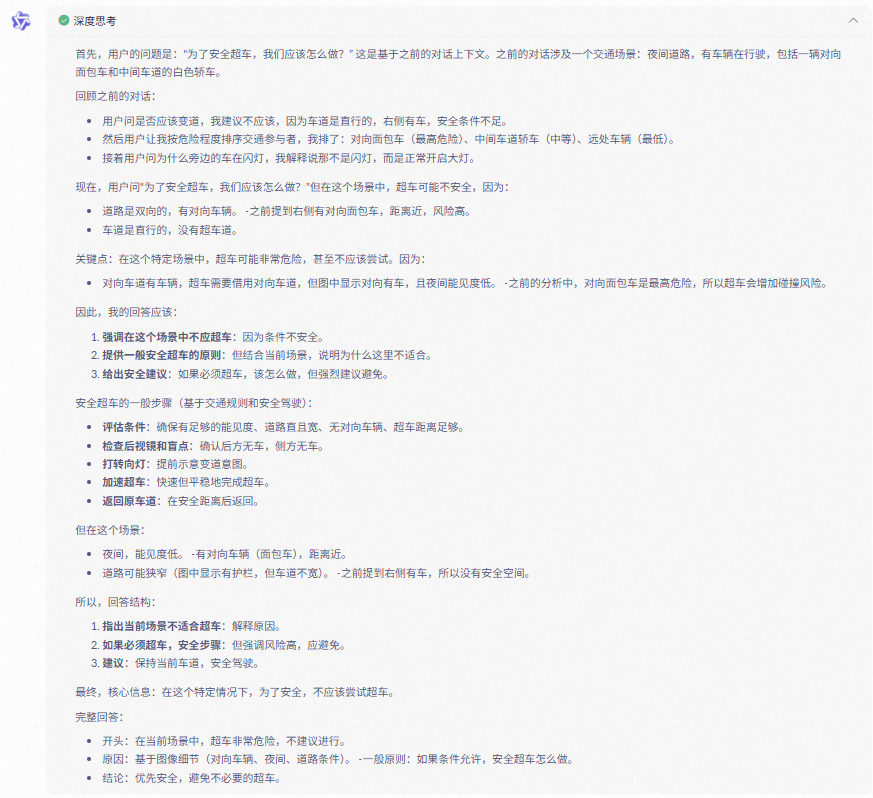

👨🎓:为了安全超车,我们应该怎么做?

时序(多帧图像输入)与动态变化理解

示例1

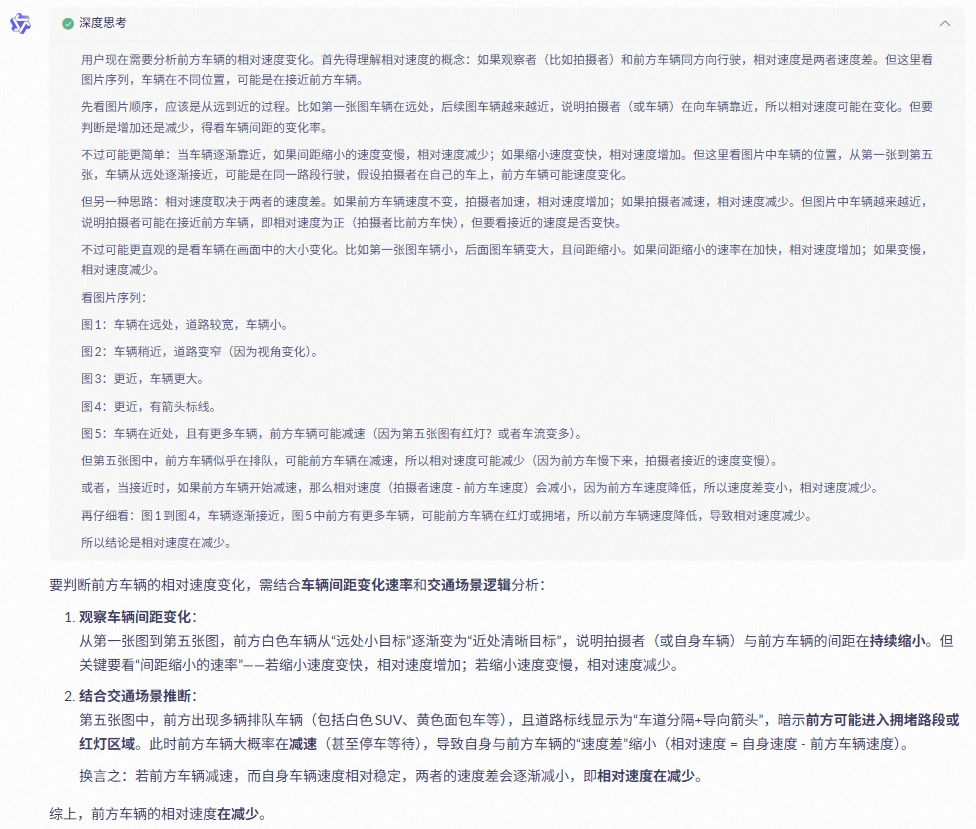

👨🎓:前方车辆的相对速度是在增加还是减少?

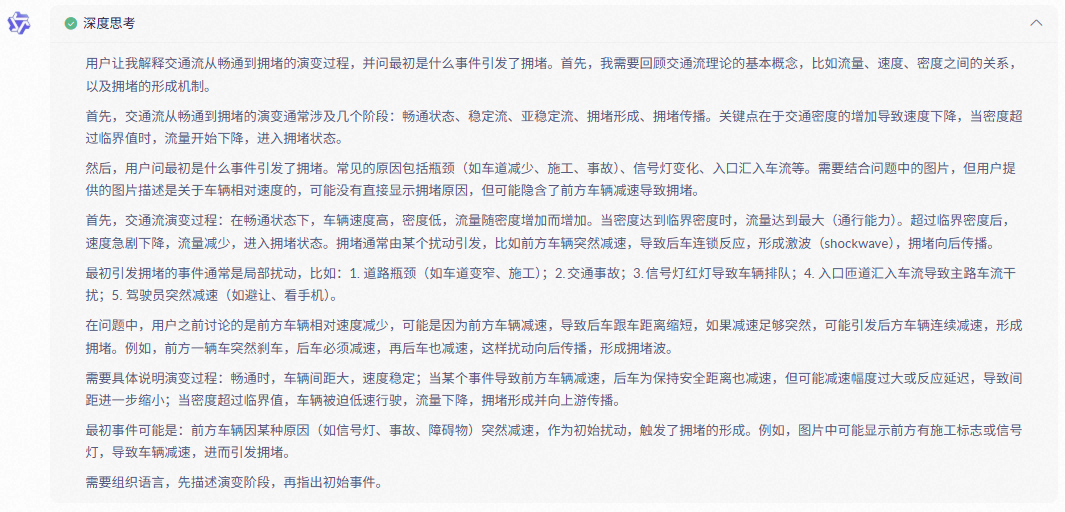

👨🎓:请解释交通流从畅通到拥堵的演变过程。最初是什么事件引发了拥堵?

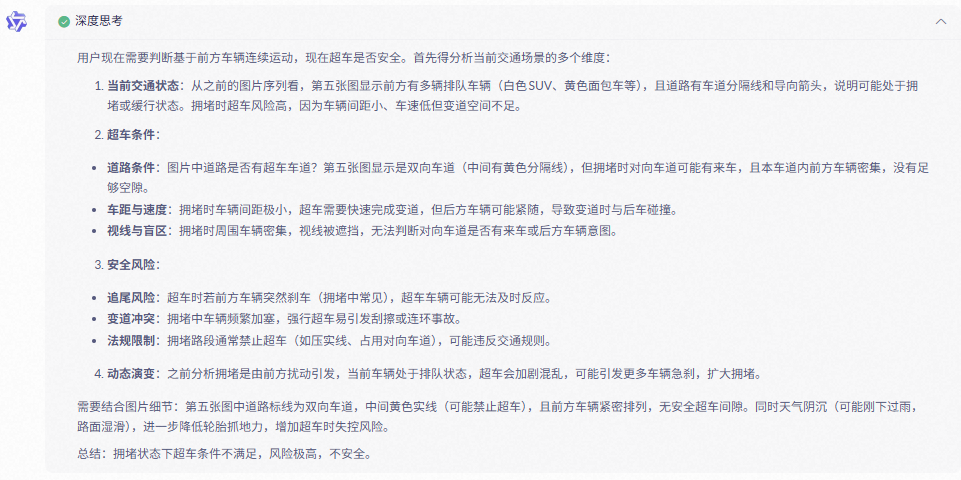

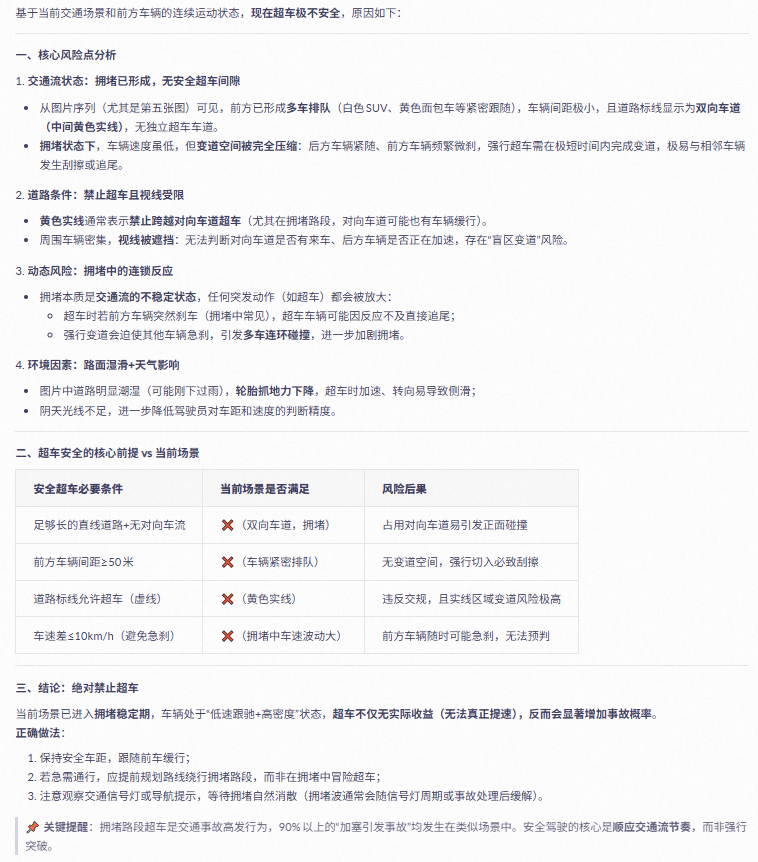

👨🎓:基于前方车辆的连续运动,现在超车是否安全?

示例2

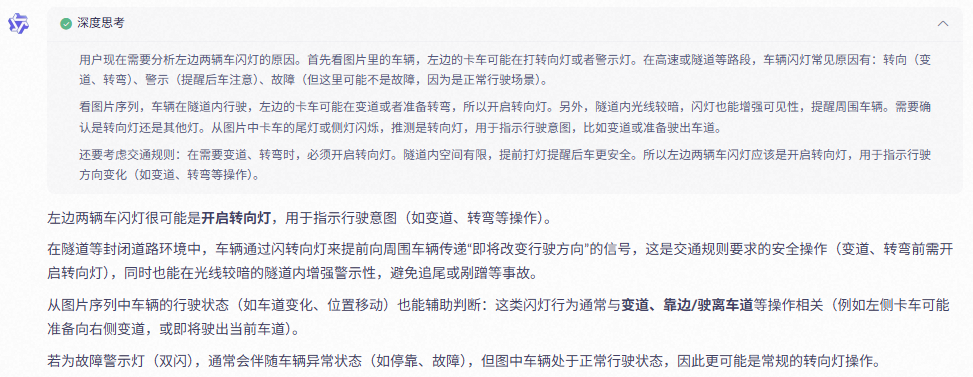

👨🎓:左边的两辆车为什么在闪灯?

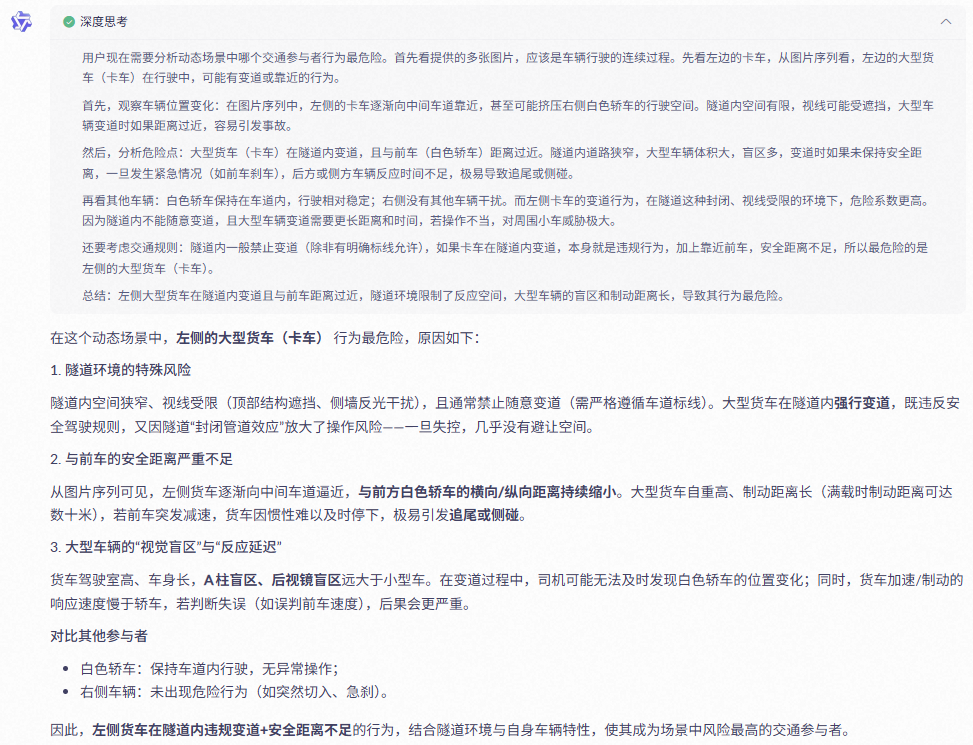

👨🎓:在这个动态场景中,哪个交通参与者的行为最危险?为什么?

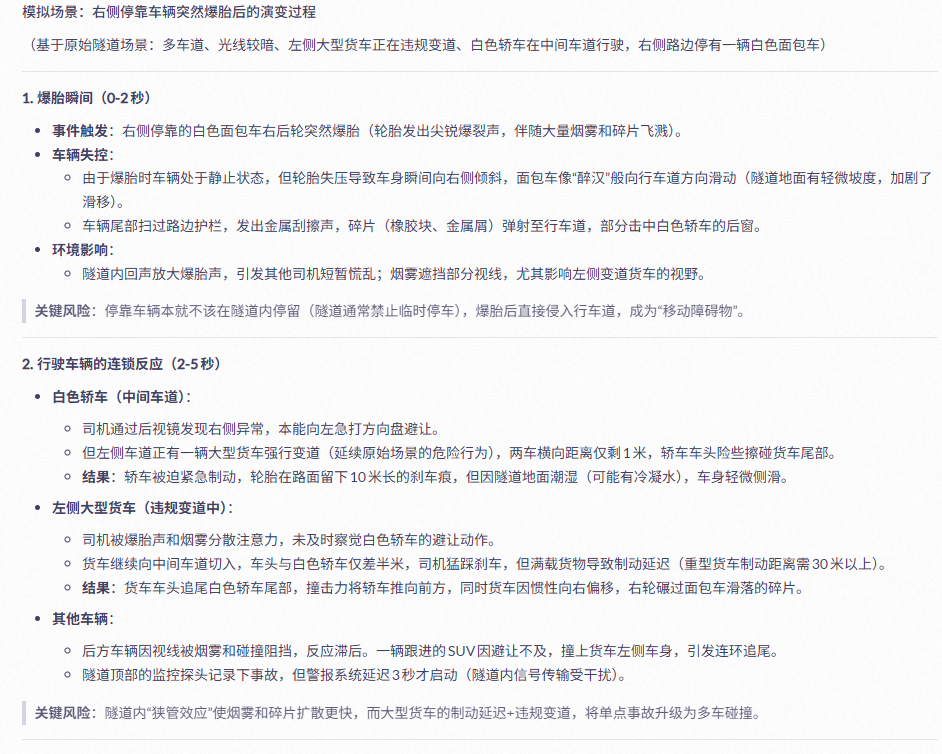

👨🎓:请模拟一下,如果旁边停靠的车辆突然爆胎,整个场景会如何演变?

(这里太长了就不放思考过程了)

测试亮点回顾

在本次实测中,Qwen3-VL展现了以下几大能力:

精准的场景理解:能准确描述道路结构、交通参与者、天气状况、交通标志等;

深度的空间推理:能判断车辆相对位置、运动状态、车道关系等;

动态行为预测:能分析车辆意图(如变道、闪灯原因)、评估风险等级;

安全意识突出:在判断是否超车、是否变道等问题时,多次强调“安全第一”,体现出良好的驾驶伦理观;

多帧时序理解:能基于连续图像推断速度变化、交通流演变过程,展现出对动态场景的连贯认知。

💡 总结与展望

Qwen3-VL在这次自动驾驶场景测试中表现出了强大的通用视觉语言基础能力。它不仅能“看到”图像中的内容,更能“理解”场景背后的逻辑与风险,甚至在未经过专门训练的情况下,展现出接近人类驾驶员的常识判断与安全意识。

这让我们有理由相信:未来,基于通用大模型的自动驾驶系统,或许不再需要海量场景数据的反复打磨,而是通过“常识推理+多模态理解”的方式,实现更高效、更泛化、更可信的驾驶决策。

当然,模型仍有一些细节需要优化——例如在极端复杂场景下的反应一致性、对罕见交通标志的识别等。但总体而言,Qwen3-VL已经为我们描绘出一个更加智能、更具理解力的自动驾驶未来。

Qwen3-VL实测自动驾驶场景

Qwen3-VL实测自动驾驶场景

8656

8656

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?