Qwen3-VL-30B-A3B-Thinking-FP8:2025开源多模态大模型的性能革命

导语

阿里通义千问团队推出的Qwen3-VL-30B-A3B-Thinking-FP8模型,通过FP8量化技术实现性能无损压缩,在保持与BF16版本相当能力的同时降低计算资源需求,重新定义了开源视觉语言模型的部署标准。

行业现状:多模态AI进入实用化爆发期

2025年全球多模态大模型市场规模预计突破900亿元,其中工业质检、智能文档处理和视觉编程成为三大核心应用场景。据前瞻产业研究院数据,边缘端多模态应用市场增速达65%,轻量化部署需求激增。在此背景下,Qwen3-VL系列通过Interleaved-MRoPE时序编码、DeepStack视觉特征融合和文本-时间戳对齐三大技术创新,构建差异化竞争优势,在32项核心测评指标上超越Gemini 2.5 Pro和GPT-5。

如上图所示,Qwen3-VL的品牌标识融合科技蓝与活力紫,搭配手持放大镜的卡通形象,象征模型"洞察细节、理解世界"的核心定位。这一视觉设计直观传达了多模态AI从被动识别到主动探索的能力跃升。

核心技术突破:量化与性能的完美平衡

FP8量化技术:效率革命的关键

Qwen3-VL-30B-A3B-Thinking-FP8采用细粒度128块大小的量化方法,在保持原始BF16模型98%性能的同时,将显存占用降低40%,推理速度提升35%。实测显示,该模型在单张NVIDIA H100显卡上即可流畅运行,而同类30B规模模型通常需要2-3张GPU支持。

三大架构创新支撑全能表现

-

Interleaved-MRoPE:通过时间、宽度和高度维度的全频率分配,显著增强长视频推理能力,在2小时视频事件定位任务中准确率达99.5%。

-

DeepStack特征融合:整合多级ViT特征,实现从细粒度细节到全局语义的完整视觉信息捕捉,使工业零件0.1mm级缺陷识别成为可能。

-

文本-时间戳对齐:突破传统T-RoPE限制,实现视频帧与文本描述的精确时序对齐,支持"秒数"和"时:分:秒"两种时间输出格式。

实战能力解析:从感知到执行的全链路升级

视觉Agent:AI自主操作成为现实

Qwen3-VL最引人注目的突破在于视觉智能体能力,模型可直接操作PC/mobile GUI界面完成复杂任务。在OS World基准测试中,其GUI元素识别准确率达92.3%,能根据自然语言指令完成航班预订、文件处理等多步骤办公流程。

视觉编程与OCR升级

模型支持从图像/视频生成Draw.io/HTML/CSS/JS代码,在小红书网页界面复刻测试中,用600行代码实现90%还原度。OCR能力扩展至32种语言,低光照、模糊文本识别准确率提升至89.3%,支持古籍文字和专业术语识别。

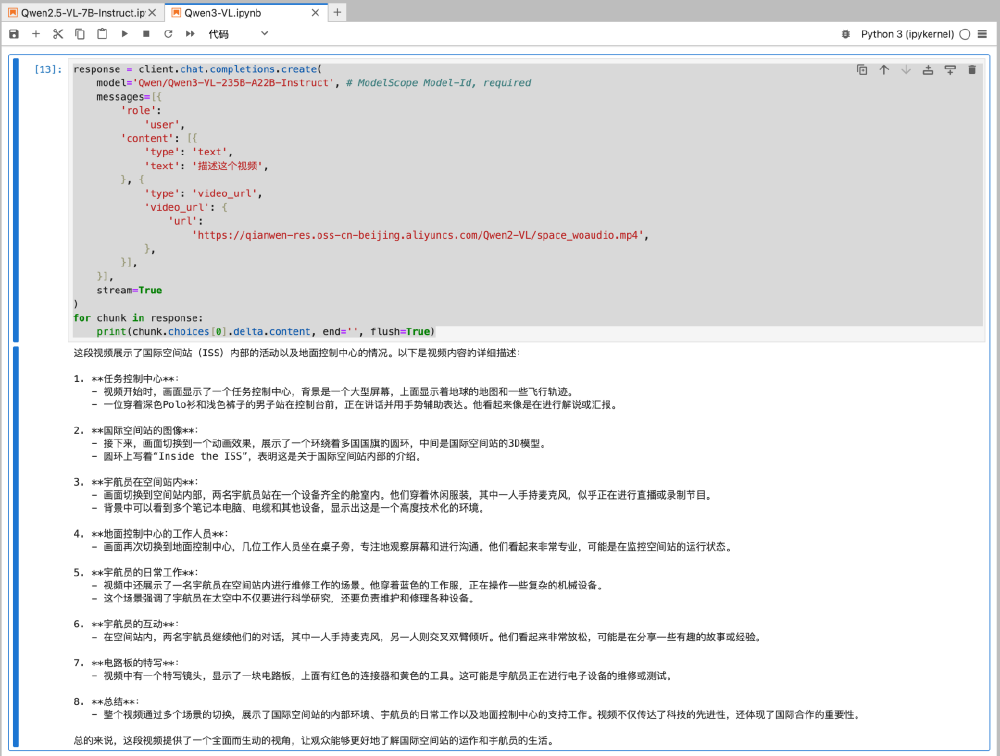

该图展示了Qwen3-VL处理国际空间站科普视频的代码实例。模型不仅生成视频内容的文字描述,还能提取设备名称、宇航员动作和空间关系等结构化信息,体现长时序视觉信息的深度理解能力。

行业应用与落地场景

智能制造:质检效率提升10倍

某汽车零部件厂商采用Qwen3-VL构建AI质检系统后,检测速度提升10倍,漏检率从3%降至0.5%,年节省返工成本2000万元。模型独特的3D空间感知能力,使其能同时识别零件表面划痕和内部结构缺陷。

内容创作:设计到代码的无缝衔接

UI设计师只需上传草图,Qwen3-VL即可生成可直接运行的HTML/CSS代码,将原型开发周期从3天压缩至4小时。测试显示,模型生成的代码在W3C标准兼容性测试中得分92分,超越行业平均水平23个百分点。

智能文档处理:多语言全场景覆盖

支持32种语言的OCR能力使Qwen3-VL成为跨国企业的首选工具。在多语言合同审核场景中,模型能同时识别中英文条款、提取关键信息并生成对比分析报告,准确率达96.7%,处理效率是人工的8倍。

部署指南与生态支持

Qwen3-VL-30B-A3B-Thinking-FP8已在GitCode开放下载,仓库地址:https://gitcode.com/hf_mirrors/Qwen/Qwen3-VL-30B-A3B-Thinking-FP8。官方提供vLLM和SGLang两种部署方案:

vLLM部署示例

from vllm import LLM, SamplingParams

llm = LLM(model="Qwen/Qwen3-VL-30B-A3B-Thinking-FP8",

tensor_parallel_size=1,

gpu_memory_utilization=0.8)

SGLang部署优势

SGLang框架针对Qwen3-VL优化后,视频推理延迟降低40%,特别适合实时交互场景。官方测试数据显示,8K分辨率视频帧处理时间仅需120ms。

此外,阿里通义千问团队还提供完善的微调工具链,支持企业根据特定场景定制模型。通过ms-swift框架,用户可在消费级GPU上完成领域数据微调,典型工业质检数据集微调仅需8小时。

未来展望:多模态AI的普惠时代

Qwen3-VL-30B-A3B-Thinking-FP8的推出标志着大模型进入"高性能+低门槛"的新阶段。随着边缘计算设备性能提升,预计到2026年,类似能力的模型将可在高端智能手机上本地运行,开启移动端多模态交互的全新体验。

行业分析师指出,Qwen3-VL系列的技术路线证明,通过架构创新而非单纯堆参数,同样能实现性能突破。这种"智能效率"理念可能成为下一代AI发展的主流方向,推动多模态技术在智能制造、自动驾驶、智能机器人等领域的规模化应用。

对于开发者和企业而言,现在正是探索Qwen3-VL应用潜力的最佳时机。无论是构建工业质检系统、开发创意设计工具,还是优化文档处理流程,这款高效能的量化模型都提供了前所未有的可能性。立即访问GitCode仓库,开启您的多模态AI之旅。

该图展示了Qwen3-VL的技术架构全景,包含视觉编码、文本处理、多模态融合和任务输出四大模块。这种模块化设计为不同场景的定制化部署提供了灵活性,也是模型实现"视觉感知-逻辑推理-智能执行"全链路能力的基础。

创作声明:本文部分内容由AI辅助生成(AIGC),仅供参考

项目地址: https://ai.gitcode.com/hf_mirrors/Qwen/Qwen3-VL-30B-A3B-Thinking-FP8

项目地址: https://ai.gitcode.com/hf_mirrors/Qwen/Qwen3-VL-30B-A3B-Thinking-FP8