点击下方卡片,关注“自动驾驶之心”公众号

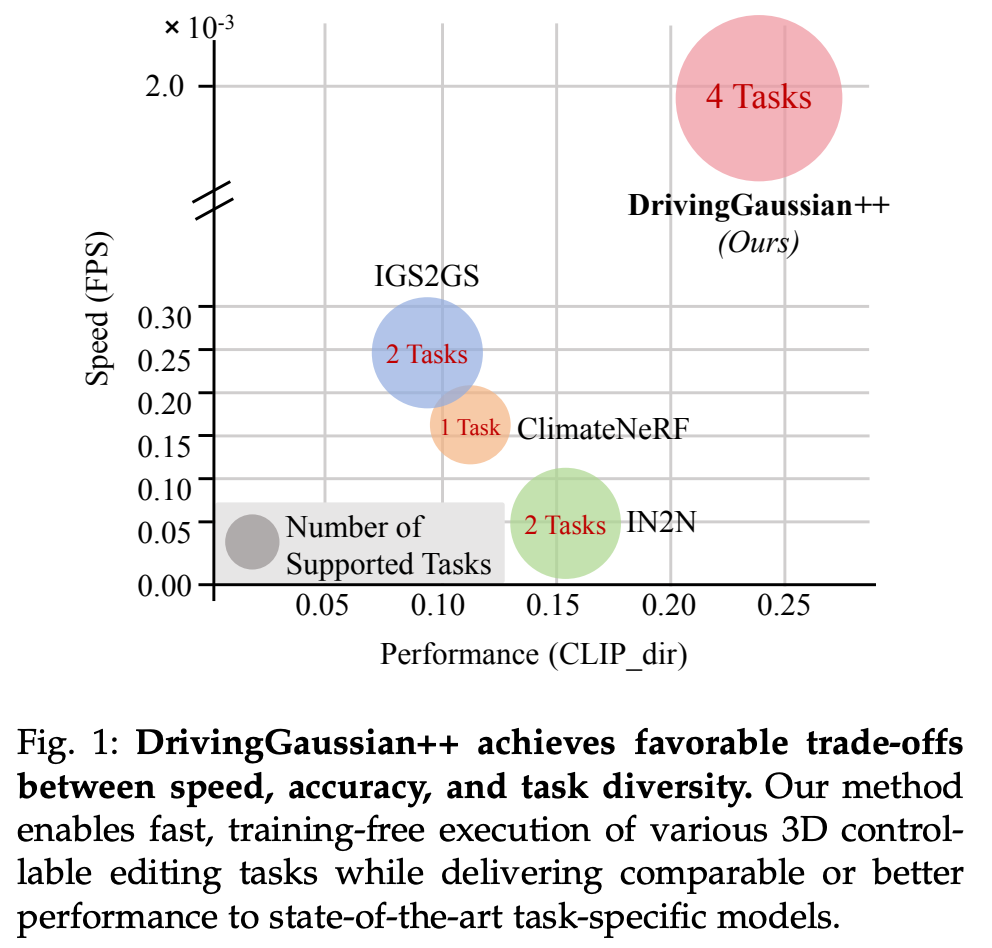

今天自动驾驶之心为大家分享北京大学&谷歌 DeepMind最新的工作!无需训练,自由编辑:DrivingGaussian++颠覆场景仿真!如果您有相关工作需要分享,请在文末联系我们!

自动驾驶课程学习与技术交流群加入,也欢迎添加小助理微信AIDriver005

>>自动驾驶前沿信息获取→自动驾驶之心知识星球

论文作者 | Yajiao Xiong等

编辑 | 自动驾驶之心

相信做 learning-based 任务的业内人士都有一个共识:数据一直是自动驾驶发展的一个重要基石,数据的多样性和标注的质量很大程度上决定模型的性能和潜力。自动驾驶发展到今天,需要大家用 80% 的精力去解剩下的 20% 的长尾场景,而往往长尾场景的数据采集并不是一件容易的事情,这就诞生了一个细分领域 —— 3D场景编辑。通过3D场景编辑,可以仿真各种真实世界的驾驶条件,从而增强自动驾驶系统的鲁棒性和安全性。

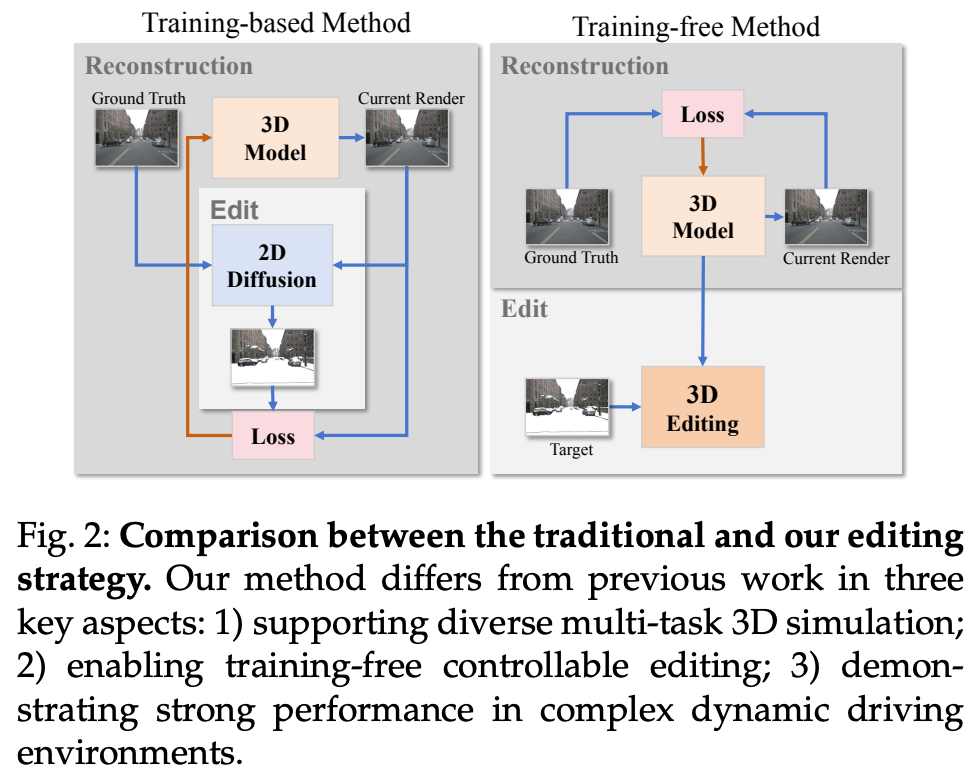

3D场景编辑任务 涵盖多种组成部分,包括风格迁移、运动修改、天气仿真以及目标的添加或移除。然而,这些编辑任务各有各的特点和难点,导致现有的编辑工具往往只能专攻某一项,缺少一个“全能型”的框架。目前常用的办法是先对2D画面进行编辑,效果好是好,但为了确保从各个角度看都一致,就得反复调整,非常耗时耗力。所以,这种方法很难用在大规模的自动驾驶仿真上。

要想对3D场景进行编辑,首先得把它精准地重建出来,这对于自动驾驶的测试至关重要。但重建场景本身就是一个大难题:车上装的传感器数量有限,车还在高速运动,采集到的数据既稀疏又不完整。再加上车周摄像头都是朝外安装,视野重叠区域小,光线条件也不统一,导致把不同角度、不同时间的画面拼成一个完整的3D场景格外困难。这种360度、大范围、动态变化的场景,想要建得准确、逼真,真的非常具有挑战性。

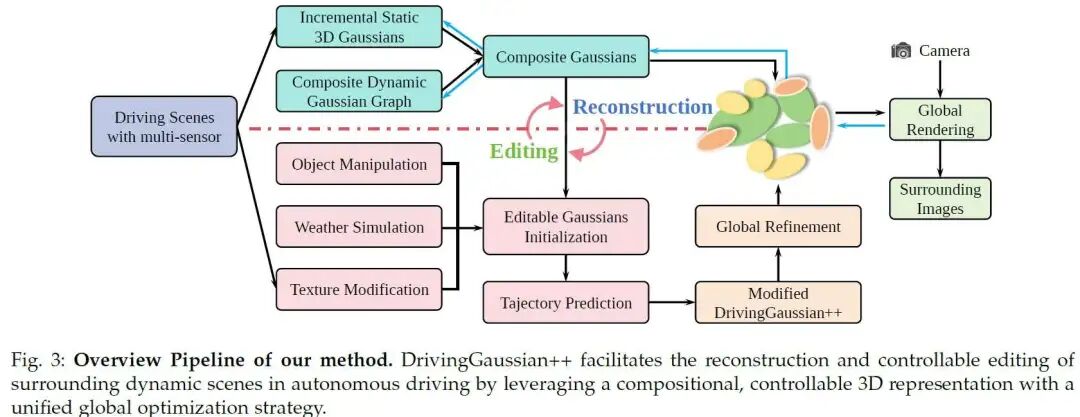

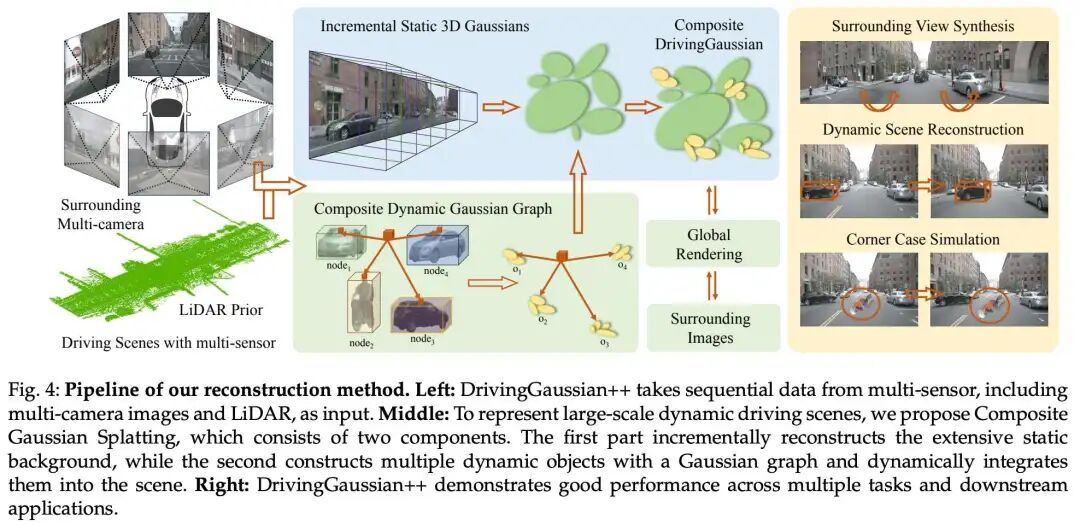

在本文中,作者提出 DrivingGaussian++(CVPR 2024 的工作 DrivingGaussian 的续作),核心思想是 利用来自多个传感器的序列数据对复杂的驾驶场景进行分层建模。作者采用复合 GS(Composite Gaussian Splatting)将场景分解为静态背景和动态目标,并分别重建每个部分。在此基础上,通过 GS 进行全局渲染捕捉真实世界中的遮挡,包括静态背景和动态目标。此外,作者将 LiDAR 先验融入高斯表示中,从而能够恢复更精确的几何结构并保持更好的多视图一致性。

论文题目: DrivingGaussian++: Towards Realistic Reconstruction and Editable Simulation for Surrounding Dynamic Driving Scenes

论文链接:https://arxiv.org/pdf/2508.20965

与CVPR 2024上发表的初步结果的差异。 作者在几个方面扩展了之前的工作:

基于复合 GS 表示大规模动态驾驶场景,引入了两个新颖模块,包括增量静态3D高斯(Incremental Static 3D Gaussians)和复合动态高斯图(Composite Dynamic Gaussian Graphs)。前者增量地重建静态背景,而后者使用高斯图对多个动态目标进行建模。

构建了一个场景编辑框架,以无需训练的方式编辑重建的场景,涵盖多个任务,包括纹理修改、天气仿真和目标操纵。它有助于生成新颖且真实的仿真数据。

实现了驾驶场景的动态编辑,预测插入场景中的粒子的运动轨迹。

通过3D生成和重建构建了一个前景资源库,并验证了数据的质量。

相关工作

3D 重建

神经辐射场

神经辐射场 (NeRFs) 利用多层感知机 (MLPs) 和可微分体渲染,可以从一组 2D 图像和相应的相机位姿信息中重建 3D 场景并合成新视图。

用于有界场景的 NeRF。 典型的 NeRF 模型最初仅适用于有界场景,且对相机与物体的相对位置有较高要求,也难以处理重叠少或向外捕捉的场景。尽管后续研究在训练速度、位姿优化、场景编辑和动态表达等方面改进了 NeRF,但其在处理自动驾驶等大规模无界场景时仍面临显著挑战。

用于无界场景的 NeRF。 针对无界场景,一些方法对 NeRF 进行了扩展,例如引入多尺度城市静态场景建模、采用抗混叠的 MIP-NeRF 结构、融合多分辨率地面特征,或通过解耦方式处理街道视图。但这些方法大多仍基于静态假设,难以有效表达动态元素。

此外,尽管已有工作尝试将 NeRF 用于动态单目视频合成,或通过场景图、实例感知仿真器和多传感器融合(如 LiDAR 和光流)处理动态城市环境,这些方法往往受限于前向视角或难以应对多摄像头、光照变化和动态目标的复杂交互。传统基于 NeRF 的方法严重依赖光线采样,在动态多目标和光照变化显著时渲染质量下降,同时 LiDAR 仅作为辅助深度监督,其几何先验能力未得到充分发挥。

为克服这些局限,本研究采用复合 GS 对无界动态场景进行建模:静态背景随自车移动增量重建,动态目标通过高斯图建模并集成到场景中。LiDAR 不仅用于深度监督,更为高斯初始化提供几何先验,从而提升重建精度与场景一致性。

3DGS

近期的 3D GS 方法使用大量 3D 高斯来表示静态场景,并在新视图合成和训练速度方面取得了最先进的结果。与现有的显式场景表示(例如,网格、体素)相比,3DGS 可以用更少的参数对复杂形状进行建模。与隐式神经渲染不同,3DGS 允许基于泼溅的光栅化进行快速渲染和可微分计算。

动态 3DGS 虽然原始的 3DGS 旨在表示静态场景,但已经开发了几种用于动态目标/场景的方法。给定一组动态单目图像,有些工作引入了一个变形网络来建模高斯的运动。此外还有些通过 HexPlane 连接相邻的高斯,实现实时渲染。然而,这两种方法都是明确为专注于中心物体的单目单摄像头场景设计的。另外一些工作使用一组演化的动态高斯来参数化整个场景。然而,它需要具有密集多视图图像的摄像头阵列作为输入。

在真实世界的自动驾驶场景中,数据采集平台的高速运动导致广泛而复杂的背景变化,并且通常由稀疏视图(例如,2-4 个视图)捕获。此外,具有剧烈空间变化和遮挡的快速移动动态目标使情况进一步复杂化。总的来说,这些因素对现有方法构成了重大挑战。

3D 场景可控编辑

神经辐射场 (NeRF) 和 3D GS 是两种用于 3D 场景重建的重要方法。NeRF 将场景几何和外观隐式编码在多層感知機 (MLP) 中,而 3D GS 使用 3D 高斯椭球显式表示场景。尽管已经展示了重建能力,但编辑这些表示仍然是一个重大挑战。当前的方法大致可分为两类:基于扩散模型引导的编辑和基于 3D 粒子系统的编辑。

基于扩散引导的编辑

扩散模型因支持文本驱动的图像编辑而受到关注。一些方法借助预训练的扩散模型,将这一能力引入3D场景编辑。具体做法是:对3D模型渲染出的图像添加噪声,再通过2D扩散模型结合控制条件预测噪声差异,并借助分数蒸馏采样(SDS)损失优化3D模型。尽管这类方法效果显著,但它们难以保持多视角一致性,也无法很好地处理复杂的大规模动态场景。

例如,Instruct-NeRF2NeRF 将3D编辑任务转化为2D图像编辑问题,但由于无法保证不同视角下编辑的一致性,容易出现不稳定、速度慢和明显伪影的问题。ViCA-NeRF 尝试通过选择部分参考图像编辑再融合其余图像以缓解问题,但仍未根本解决一致性问题,编辑结果往往模糊。

近期一些工作,如 DreamEditor 将 NeRF 转换为网格并借助 SDS 和 DreamBooth 进行优化;HiFA 通过调整扩散时间步和降噪权重提升多视角一致性;还有一些方法将 NeRF 编辑技术扩展至 3DGS,并引入深度估计作为几何先验。尽管这些方法在一致性方面取得进展,但仍因依赖固定深度估计而仅限于纹理修改,且通常需依赖静态掩码控制编辑区域,无法有效用于动态3D模型训练。现有方法多数仅在物体中心数据集上验证,尚未适用于复杂驾驶场景。

相比之下,DrivingGaussian++ 采用了一种无需训练的范式,有效解决了现有方法在动态驾驶场景编辑中的挑战,实现了卓越的编辑一致性和视觉质量。

基于 3D 粒子系统的编辑

另一类方法不依赖扩散模型或额外图像,而是直接操纵3D粒子实现编辑。例如,ClimateNeRF 通过仿真粒子生成雨、雪、雾等天气效果,并将其嵌入神经场中以增强真实感。GaussianEditor 和 Infusion 等则基于 3DGS,通过语义属性识别编辑区域,或借助深度补全控制高斯修复,实现精确的3D插入与删除。这类方法通常编辑效率更高,多视角一致性也更好。DrivingGaussian++ 采用 3D 粒子级编辑,并将其进一步扩展到多个任务,包括纹理、目标和天气编辑。通过无需训练的范式,作者的方法为大规模自动驾驶场景实现了显式、可控和高效的编辑。

方法论

作者的目标是在 3D 自动驾驶场景中实现无需训练的编辑。为了处理多个编辑任务,作者提出了一个可控且高效的框架。首先,作者采用复合 GS (Composite Gaussian Splatting) 精确重建动态驾驶场景。接下来,作者识别场景中待修改的特定高斯,或生成新的高斯以仿真特定的物理实体。这些目标高斯随后被集成到原始场景中,并预测目标的未来轨迹。最后,作者使用图像处理技术细化结果以增强真实感。使用此框架,作者为三个关键任务开发了详细的编辑方法:纹理修改、天气仿真和目标操纵。方法如图 3 所述。

复合 GS

3DGS 在静态场景中表现良好,但在涉及大规模静态背景和多个动态目标的混合场景中具有显著局限性。如图 4 所示,作者的目标是使用复合 GS 来表示环视的大规模驾驶场景,用于无界的静态背景和动态目标。

带有环视视图的 LiDAR 先验

原始的 3DGS 尝试通过运动恢复结构 (SfM, structure-from-motion) 来初始化高斯。然而,用于自动驾驶的无界城市场景包含许多多尺度的背景和前景。但是它们仅通过极其稀疏的视图被看见,导致几何结构的错误和不完整恢复。

为了给高斯提供更好的初始化,作者将 LiDAR 先验引入 3D 高斯以获得更好的几何结构,并在环视视图配准中保持多摄像头一致性。在每个时间步 ,给定收集的一组多摄像头图像 和多帧 LiDAR 扫描 。作者利用 LiDAR-图像多模态数据最小化多摄像头配准误差,并获得精确的点位置和几何先验。

作者首先合并多帧 LiDAR 扫描以获得场景的完整点云,记为 。作者遵循 Colmap 并分别从每个图像中提取图像特征 。接下来,作者将 LiDAR 点投影到环视图像上。对于每个 LiDAR 点 ,作者将其坐标转换到相机坐标系,并通过投影将其与相机图像平面的 2D 像素匹配:

其中 是图像的 2D 像素, , 和 分别是正交旋转矩阵和平移向量。此外, 代表已知的相机内参。值得注意的是,来自 LiDAR 的点可能会投影到多个图像的多个像素上。因此,作者选择到图像平面欧几里得距离最短的点,并将其保留为投影点,并分配颜色。

与现有的一些 3D 重建方法类似,作者将密集束调整 (DBA, dense bundle adjustment) 扩展到多摄像头设置并获得更新的 LiDAR 点。实验结果表明,使用 LiDAR 先验进行初始化以与环视多摄像头对齐,有助于为高斯模型提供更精确的几何先验。

增量静态 3D 高斯

驾驶场景的静态背景由于其大规模、长持续时间以及由自车移动和多摄像头变换引起的变化,对场景建模和编辑构成了挑战。随着车辆的移动,静态背景经常经历时间偏移和动态变化。由于透视原理,过早地合并远离当前时间步的遥远街道场景会导致尺度混淆,从而产生令人不快的伪影和模糊。为了解决这个问题,作者通过引入增量静态 3D 高斯来改进 3DGS,利用车辆运动引入的透视变化和相邻帧之间的时间关系,如图 5 所示。

作者根据 LiDAR 先验提供的深度范围,将静态场景统一划分为 个区间 (bins)。这些区间按时间顺序排列,记为 ,每个区间包含来自一个或多个时间步的多摄像头图像。相邻的区间有一个小的重叠区域,用于对齐两个区间的静态背景。然后将后一个区间增量地融合到前几个区间的高斯场中。对于第一个区间内的场景,作者使用 LiDAR 先验(同样适用于 SfM 点)初始化高斯模型:

其中 是 LiDAR 先验的位置; 是 LiDAR 点的均值; 是一个各向异性的协方差矩阵; 是转置运算符。作者利用此区间段内的环视视图作为监督来更新高斯模型的参数,包括位置 、协方差矩阵 、用于视图相关颜色的球谐系数 以及不透明度 。

对于后续的区间,作者使用前一个区间的高斯作为位置先验,并根据它们的重叠区域对齐相邻的区间。每个区间的 3D 中心可以定义为:

其中 是所有当前可见区域的高斯 的 3D 中心集合,

最低0.47元/天 解锁文章

最低0.47元/天 解锁文章

1717

1717

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?