点击下方卡片,关注“自动驾驶之心”公众号

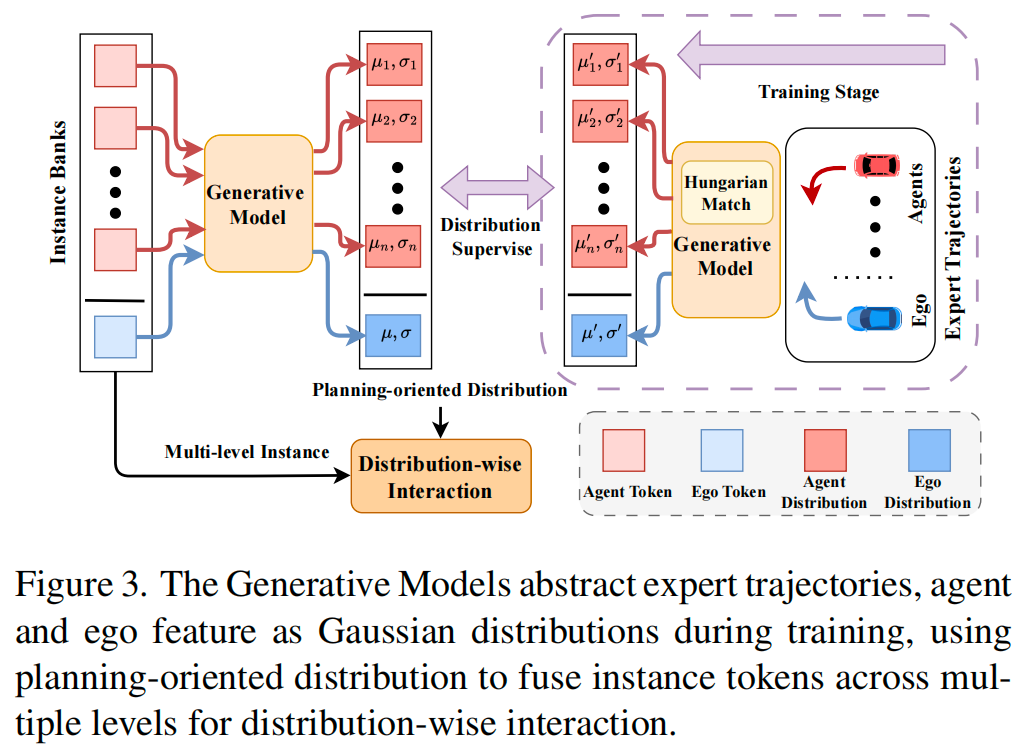

今天自动驾驶之心为大家分享华东理工大学、商汤研究院、悉尼大学最新的工作!DistillDrive:异构蒸馏框架显著降低自动驾驶碰撞率50% !如果您有相关工作需要分享,请在文末联系我们!

自动驾驶课程学习与技术交流群加入,也欢迎添加小助理微信AIDriver005

>>自动驾驶前沿信息获取→自动驾驶之心知识星球

论文作者 | Rui Yu等

编辑 | 自动驾驶之心

写在前面 & 笔者的个人理解

端到端自动驾驶近年来发展迅速,对工业界和学术界均产生了深远影响。然而现有工作过度关注将自车状态(ego-vehicle status)作为其唯一的学习目标,缺乏面向规划的理解能力,这限制了整体决策过程的鲁棒性。为此华理和SenseAuto的团队提出了 DistillDrive,一种基于知识蒸馏的端到端自动驾驶模型,该模型利用多样化的实例模仿(diversified instance imitation)来增强多模态运动特征学习。具体而言,采用一种基于结构化场景表示的规划模型作为教师模型(teacher model),利用其多样化的规划实例作为端到端模型的多目标学习目标。此外引入强化学习(reinforcement learning)来优化状态到决策的映射关系,同时利用生成式建模(generative modeling)来构建面向规划的实例,促进潜在空间内的复杂交互。本文在 nuScenes 和 NAVSIM 数据集上验证了DistillDrive模型,相较于基线模型,碰撞率降低了50%且闭环性能提升3个点。

论文链接:https://arxiv.org/abs/2508.05402

代码链接:https://github.com/YuruiAI/DistillDrive

简介

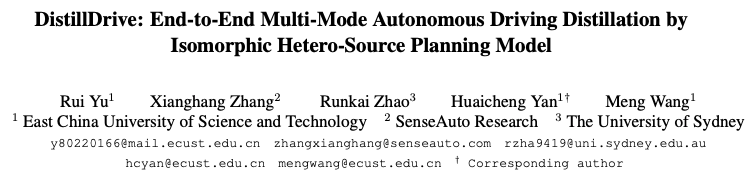

端到端自动驾驶近年来取得了显著进展,这主要得益于感知技术和模仿学习的进步。如图1(b)所示,该方法直接从复杂的传感器输入学习到最终的规划和决策,消除了中间的数据传递和目标表征过程,从而显著减少了级联误差。然而在闭环实验中,图1(a)中感知分离的规划模型表现优于端到端模型,这得益于其对比学习和仿真实验。尽管如此,它在感知和规划之间面临着耦合障碍。

与具有唯一解的感知任务不同,规划任务存在多种不确定的可行解,而依赖单一专家轨迹会限制模型学习多样化表征的能力。为了解决规划目标有限的问题,SparseDrive将单模态规划特征融入多模态位置嵌入中,从而实现多样化规划。同时,VADV2将规划任务抽象为概率动作分布,利用规划词汇与场景标记之间的交互来采样单一动作。DiffusionDrive提出了一种带有多模锚点和扩散时间表的截断扩散策略,使模型能够从高斯分布中学习去噪。尽管上述方法提供了一定的规划多样性,但仍存在几个问题:(a) 单模态学习:其目标仍然是来自日志回放的专家轨迹,缺乏对多模态特征和运动属性的多样化监督。(b) 状态泄露:模型过度依赖自车状态,且缺乏状态到决策空间的优化。(c) 运动引导缺失:上述方法缺乏面向规划的特征建模,无法以运动引导的方式促进实例间的交互。

为了解决上述问题,我们使用一个多模态解耦的规划模型作为教师模型,通过知识蒸馏来监督端到端模型中的运动引导实例交互,如图1(c)所示。与现有方法(这些方法侧重于仿真环境,且缺乏对潜在空间多模态特征的监督)不同,我们有效地实现了多模态模仿。同时,我们采用强化学习来提升对运动状态的综合理解,并利用生成模型来增强在潜在空间中与专家轨迹的运动分布特征的交互。

为了有效提升端到端模型的规划性能,并应对模仿学习在捕捉规划空间复杂性方面的挑战,我们提出了 DistillDrive,一种基于同构异源规划模型蒸馏的端到端多模态自动驾驶框架。总体而言,我们设计了一种知识蒸馏架构,利用解耦的规划模型来高效地监督端到端模型中的多模态规划学习。为了明确自车状态的作用,我们使用逆强化学习和Q学习来增强状态到决策关系的构建。最后,通过生成式建模实现运动引导的跨域特征交互,从而增强实例向规划空间的抽象。

我们的主要贡献总结如下:

我们提出了一种用于端到端规划中多模态实例监督的蒸馏架构,解决了单一目标模仿学习的局限性。

我们引入了基于强化学习的状态优化,以增强对状态到决策空间的理解,并缓解自车运动状态泄露问题。

为了解决缺失的运动引导属性,我们使用生成模型来实现专家轨迹与实例特征之间的分布级交互。

我们在nuScenes和NAVSIM数据集上进行了开环和闭环规划实验,相较于基线模型,实现了碰撞率降低50%以及EP和PDMS指标均提升3个百分点。

相关工作回顾

端到端规划

随着端到端概念的流行,自动驾驶技术正在迅速发展。已有研究通过使用Transformer进行规划模型中的时空特征学习,取得了令人印象深刻的结果。值得注意的是,UniAD首次利用注意力机制集成了检测、跟踪和建图,实现了强大的规划性能;而VAD则简化了这些步骤,通过向量化表示在准确性和性能之间取得了平衡。

与之前将规划建模为连续轨迹学习的方法不同,研究将运动空间抽象为概率决策空间。尽管SparseDrive提出了一种稀疏查询中心范式用于端到端自动驾驶,并取得了强大的性能,但研究表明,现有的端到端规划模型过度依赖自车状态,缺乏与其他智能体的交互。为了解决这个问题,我们设计了一种端到端模型,通过增强分布交互并利用专家轨迹进行实例级表征的监督,来提供运动先验。

知识蒸馏

知识蒸馏(KD)允许一个紧凑的学生模型模仿一个复杂教师模型的行为,从而继承其嵌入的知识。Hao等人提出了一种跨架构方法,将中间特征对齐到logits空间,以从异构模型中蒸馏知识。同时,也有方法通过多阶段自适应蒸馏和双路径机制来增强模型的表达能力。

在自动驾驶规划领域,Roach设计了一个基于强化学习(RL)的专家来指导模仿学习(IL)智能体学习状态空间表征。在PlanKD中,规划特征被蒸馏,轨迹和注意力机制被用来提取特征中心。而Hydra-MDP则通过一个基于规则的教师来监督多模态轨迹的生成。

相比之下,我们的工作通过知识蒸馏来解决跨模型的运动特征学习问题,从而应对单一目标模仿学习的局限性。

强化学习在规划中的应用

随着A3C智能体在CARLA中应用强化学习,该领域涌现出越来越多的研究。Roach训练了一个强化学习专家,将鸟瞰图图像转换为连续的低级动作,在CARLA中设定了性能基准。强化学习方法已被应用于车道保持和车道变换等任务,使策略能够通过闭环训练从奖励中学习。

一些方法结合了强化学习和模仿学习,以标准化Q学习并防止分布外值的过度估计。逆强化学习(Inverse Reinforcement Learning, IRL)从专家演示中推断成本函数,从而避免了手动指定。

在实践中,通过结合模仿学习和强化学习来实现智能体目标,使用软演员-评论家(Soft Actor-Critic)方法交替训练评论家和演员。

在我们的工作中,我们结合了Q学习和逆强化学习方法,以提升模型对状态到决策空间的理解,从而增强其在开环和闭环场景下的性能。

算法详解

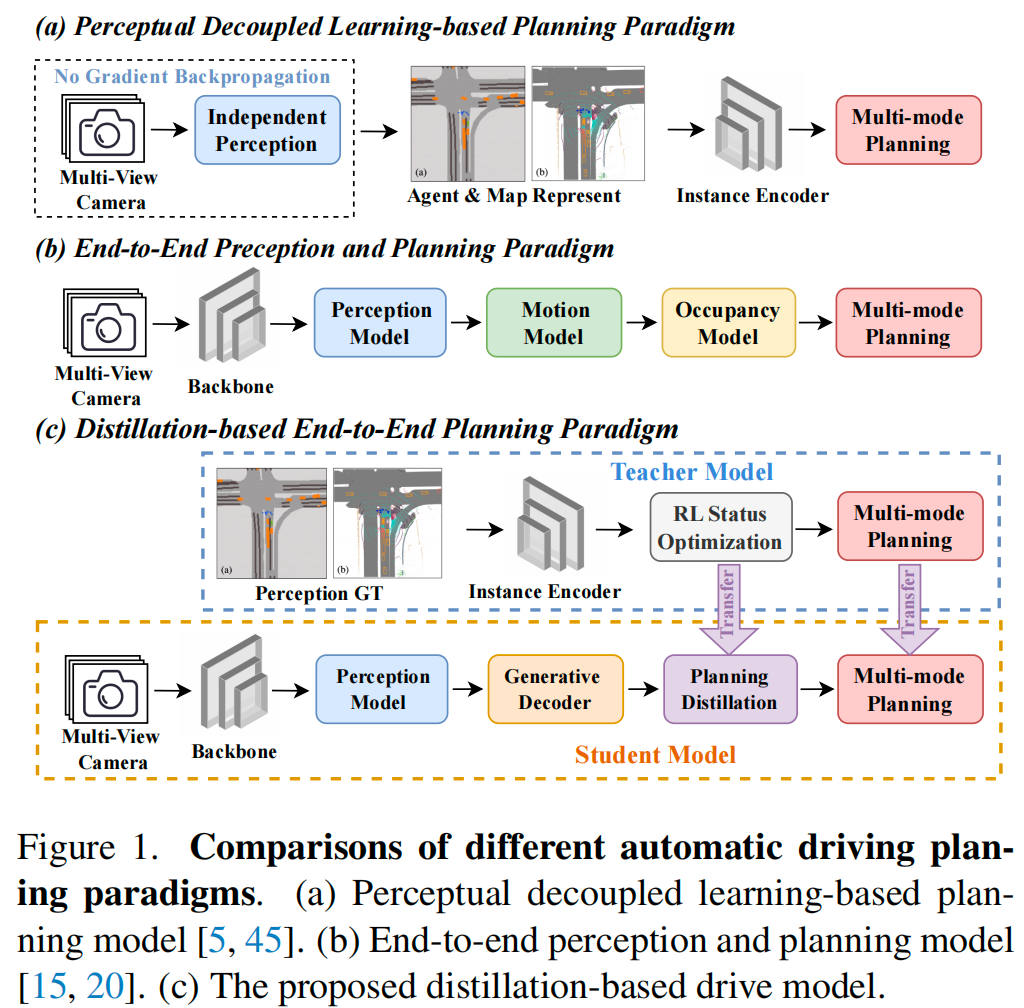

如图2所示,我们利用一种基于知识蒸馏的规划模型,通过基于规划的信息来增强多模态特征交互。

基于逆强化学习的教师模型

教师模型通过智能体编码器、场景编码器、规划解码器、基于模仿学习的预测头以及基于强化学习的状态优化来学习从场景到规划的关系。

智能体编码器 (Agent Encoder)。对于一个动态目标智能体,其在每个时刻 的状态由以下信息表征:位置 、朝向角 、速度 、尺寸 和二进制掩码信息 。为了增强对目标运动属性的表征,我们将特征向量化以关联连续帧之间的信息,从而建模目标的动态特性:

然后,应用一个多层感知机(MLP)对 进行编码,得到 ,其中 、 和 分别表示智能体数量、每个智能体的帧数和特征维度。

包含了智能体的时间特征,通过基于序列位置的位置编码 进行增强。全局位置嵌入 通过对初始位置 进行编码生成,提供了丰富的空间信息。编码器通过注意力机制捕捉目标时间感知之间的相关性:

场景编码器 (Scene Encoder)。静态目标(例如,车道线、道路边缘)有助于模型理解驾驶规则和区域,用点集 表示,其中 是车道数量, 是每条车道的点数。

车道中心点 作为位置来编码 ,代表车道分布。从车道中心编码中推导出向量化表示 、方向 和偏差 。同时,通过对每个车道的标签属性 进行编码,通过权重矩阵 进行加权。最后,使用PointNet折线编码器对车道线进行编码,得到有效的表示 ,如下所示:

规划解码器 (Planning Decoder)。如图2所示,我们从规划词汇中导出 ,这些词汇是通过对基于向量化和终点聚类的轨迹进行聚类得到的,其中 表示模态数量。

这些多模态实例与来自智能体编码器的特征一起,通过记忆库实现跨时间聚合,以增强多帧智能体和自车实例 以及位置嵌入 。

为了建模自车(Ego)、智能体(Agent)和地图(Map)之间的相互作用,我们采用注意力机制进行异构特征的表征学习,捕捉它们之间的交互。首先,时间注意力机制捕捉时间特征 之间的关联,以理解目标的动态演化;然后,自注意力机制进一步捕捉自车与智能体之间的交互,并分析它们的行为模态。最后,动态目标 与静态元素 之间的交叉注意力机制增强了智能体抽象场景的能力。具体细节在补充材料中提供。

基于模仿学习的预测头 (Imitation Learning-based Prediction Head)。在获得多模态自车实例 后,我们在多任务框架中使用MLP预测轨迹回归 、分类 和自车状态 。回归轨迹和运动状态均使用L1损失进行监督,得到 和 ,而分类损失则使用KL散度施加,得到多模态规划的 。细节在附录中提供,其中模仿学习误差 是三个损失的总和。

基于强化学习的状态优化 (Reinforcement Learning-based Status Optimization)。学习自车状态以防止状态泄露并减少对状态的依赖。由于运动复杂性,规划解空间是多样的,而模仿学习的单一目标限制了模型的通用性。因此,将强化学习原理集成到状态和行为的策略空间优化中,是增强模型交互性和适应性的关键。

首先,基于预测的轨迹 和状态 ,计算相对于专家轨迹 和状态 的每点误差、碰撞率和速度限制。这些值使用负指数函数进行平滑和归一化作为奖励,并对每个奖励应用可学习的权重 来优化规划奖励:

其中 是奖励的数量。与通过熵最大化奖励的最大熵逆强化学习不同,我们通过学习来优化权重系数,并设计了奖励规则以进行更直观的计算。

随后,应用Q学习将状态值 映射到运动决策 ,简化为左转、右转和直行。专家的运动状态 被传递给目标网络 以学习行为决策,决策 监督网络,如公式(4)所示。

由于 和 之间存在差异,我们避免了目标网络更新,而是使用独立监督来明确状态空间和决策之间的关联。然后,我们使用目标网络计算场景的Q值 ,其中 是奖励衰减系数:

最后, 计算为主网络预测与值 之间的差异,优化模型的行为决策状态空间表征:

运动引导的学生模型

稀疏场景表示 (Sparse Scene Representation)。对于模型的感知部分,我们保留了SparseDrive的设计,该设计使用完全稀疏的时间表示。实例 的结构与前文描述的相同。

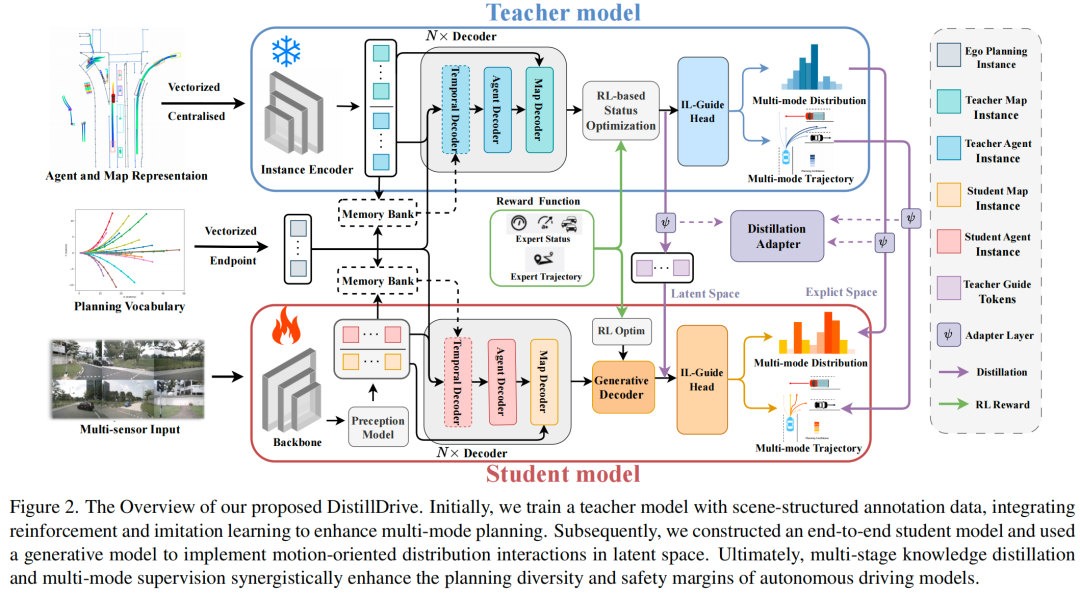

生成模型中的规划导向交互 (Planning-oriented Interactions in Generative Models)。为了增强自车和智能体实例的运动表征,我们将 和专家轨迹抽象为高斯分布,通过在隐藏空间 中的分布级交互来提升规划性能。如图3所示,我们通过编码器将专家轨迹 映射到潜在空间 中的高斯分布,学习 以建模分布 ,捕捉专家轨迹的先验。

同样,对于智能体和自车的实例 ,我们也使用编码器将它们映射到高斯空间 ,获得 和 以建立实例抽象的分布 。

训练过程使用 进行运动特征的交互,并监督 ,而推理过程则利用 生成运动引导特征 。这里, 表示高斯噪声, 表示系数。然后,将 连接并进行维度变换,得到多级实例 ,其中 表示层级数。最后,多尺度实例 作为隐藏状态,而运动引导特征 作为输入,通过GRU和MLP进行分布级特征交互,细节在附录中提供。

对于实例抽象的分布 和专家轨迹的分布 ,我们使用KL散度监督这些分布。自车分布可以直接获得,而智能体目标需要使用匈牙利算法进行对齐。

规划解码器和预测头 (Planning Decoders and Prediction Heads)。如图2所示,学生模型的解码器和运动属性学习层与教师模型对齐,防止了后续蒸馏任务中的异构性。

知识蒸馏

在本节中,我们设计了一种蒸馏架构,利用多模态教师模型通过多样化的模仿学习来监督学生模型。

编码器的实例蒸馏 (Instance Distillation of Encoders)。首先,我们应用L2损失来对齐教师和学生模型的编码器特征 和 。该方法有效地对齐了两个模型的浅层特征,确保了潜在空间的一致性,编码器蒸馏损失 如下:

解码器的实例蒸馏 (Instance Distillation of Decoders)。在场景级和实例级解码器之后,我们设计了一个专用的适配器(adapter)来适应两个模型的领域变异性并解决实例间的异构性。MLP适配器 确保了学生和教师解码器特征之间的同构性,而解码器蒸馏损失 如下:

运动属性蒸馏 (Motion Property Distillation)。最后,为了捕捉其在各模态下的概率,我们还设计了多模态蒸馏。如下所示,我们使用KL散度来监督多模态分类 和 ,鼓励学生学习一个更接近教师的分布。

总之,我们设计了从多模态教师模型到学生模型的多阶段蒸馏,解决了单一学习目标的挑战。通过监督特征和概率,我们丰富了模型对智能体交互的表征,从而增强了规划性能。最终的多阶段蒸馏损失如下:

训练目标

学习目标包括蒸馏损失 、分布损失 和强化学习损失 。模仿学习损失 前文,总损失 定义如下,其中 是权重。

实验结果分析

数据集与指标

为了评估端到端规划模型的性能,我们在 nuScenes 数据集上进行了对比和消融实验。该数据集包含了来自波士顿和新加坡的1000个驾驶场景,每个场景持续20秒,以2Hz的频率提供摄像头、激光雷达和标注数据。然而,大多数场景涉及匀速运动,且该数据集主要针对感知任务,使用开环评估进行规划,这使其非常适合性能评估。

NAVSIM 数据集由 nuPlan精简而来,使用八个摄像头实现360°覆盖,并融合了来自五个传感器的激光雷达点云以增强感知能力。该数据集以2Hz提供高质量的标注,包括高精地图和物体边界框,为自动驾驶规划任务提供了可靠的数据。最后,该数据集专注于由驾驶意图动态变化驱动的复杂场景,同时排除了静止或匀速行驶等简单情况,以更好地模拟复杂交通环境中的自动驾驶规划。

实验设置

为了确保公平比较,我们在 nuScenes 数据集上使用了与 SparseDrive相同的主干网络和感知模块,仅依赖全景图像,不使用额外的激光雷达数据。我们在8块NVIDIA A800 GPU上进行训练,总批量大小为48,使用AdamW优化器。训练过程包括:首先用30个epoch训练教师模型,然后进行100个epoch的感知预训练。接着,教师模型和经过感知预训练的模型共同进行10个epoch的端到端蒸馏,以训练规划模型。

在 NAVSIM 数据集上,我们使用了 Transfuser的基线设置,输入为三个裁剪并缩放的前视摄像头图像(1024×256)和光栅化的鸟瞰图(BEV)激光雷达,不进行时序训练以确保公平比较。我们在8块NVIDIA A800 GPU上使用AdamW优化器(学习率 )训练100个epoch。训练过程遵循相同的逻辑:首先单独训练教师模型,然后用于学生规划模型的端到端蒸馏。其中, 的值分别为 0.5, 1, 1, 0.95, 和 0.5。

结果与分析

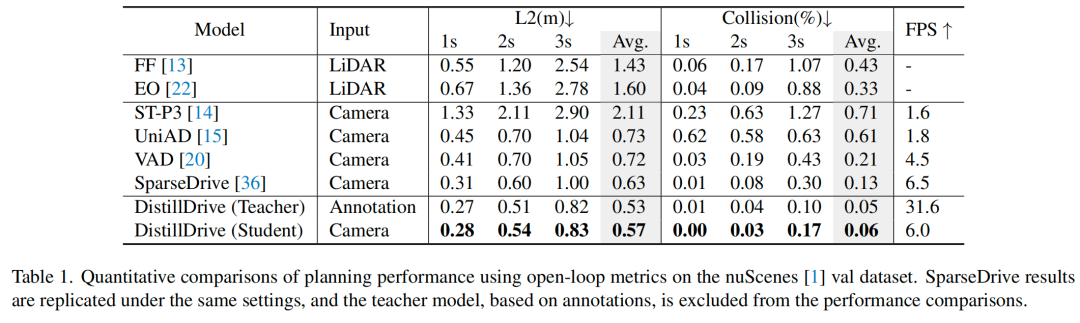

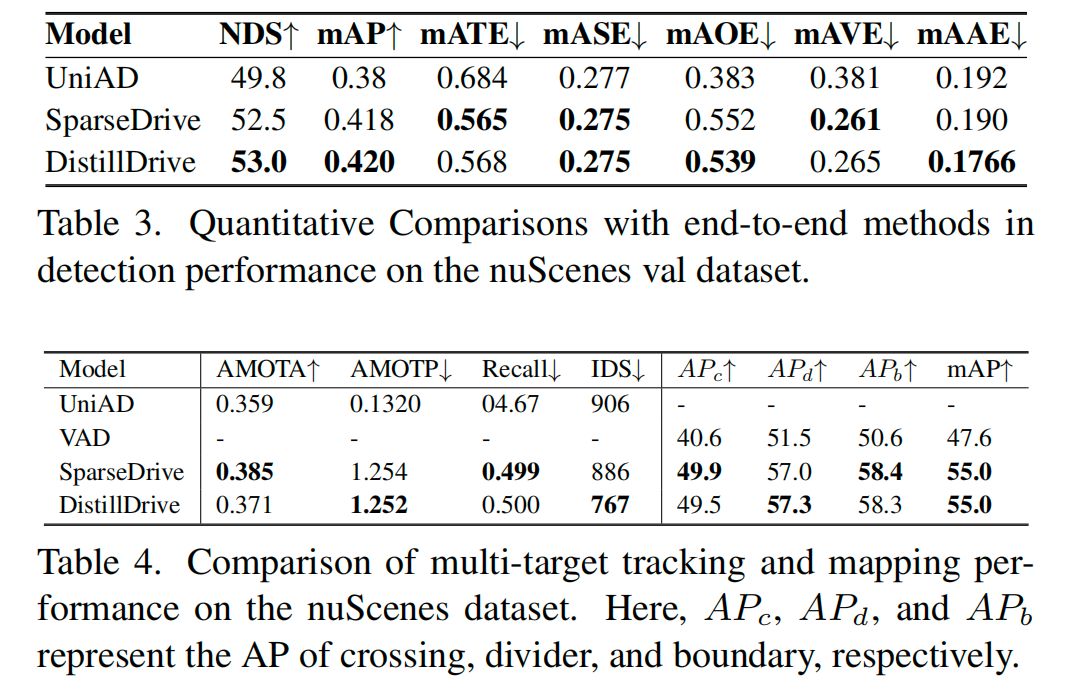

nuScenes 数据集上的规划性能。我们在 nuScenes 数据集上验证了所提出的 DistillDrive 的规划性能,结果如表1所示。教师模型在所有模型中表现最佳,验证了强化学习在状态空间优化方面的有效性,但它在现实世界中遇到了耦合障碍。因此,我们提出了一种知识蒸馏方案来增强端到端的多模态规划学习,并在表中验证了我们模型的性能。与基于激光雷达和基于摄像头的模型相比,我们的模型均表现出色,相较于 SparseDrive,碰撞率降低了50%,L2误差减少了10%。这表明,多样化的模仿学习有效地增强了不同模态实例之间的区分度。

NAVSIM 数据集上的规划性能。表1侧重于评估有限的开环性能,而表2则利用NAVSIM的数据驱动、非反应式模拟提供了全面的评估。结果显示,教师模型在性能上表现出色,证实了其设计的有效性。通过有效的多模态实例模仿,我们的端到端学生模型在PDMS指标上比Transfuser高出2.5%,在DAC和EP上也有显著提升。DistillDrive也超越了基于规则的蒸馏方法,并取得了显著的性能提升。甚至在NC和TTC指标上,它也超过了教师模型,这表明多模态蒸馏不仅能传递教师的知识,还能实现显著的突破。

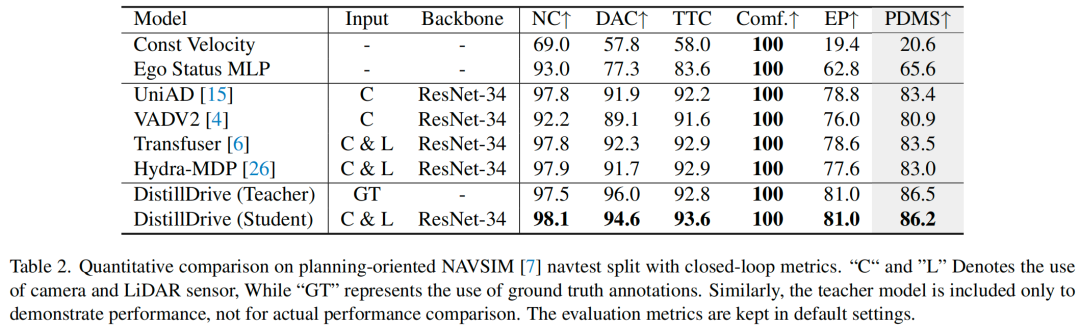

nuScenes 数据集上的感知性能。为了评估我们的规划模型,表3和表4依次验证了其检测、跟踪和建图性能。由于没有设计额外的感知模块,整体性能与SparseDrive相似。然而,我们通过生成式建模的贡献,在IDS等指标上实现了提升。

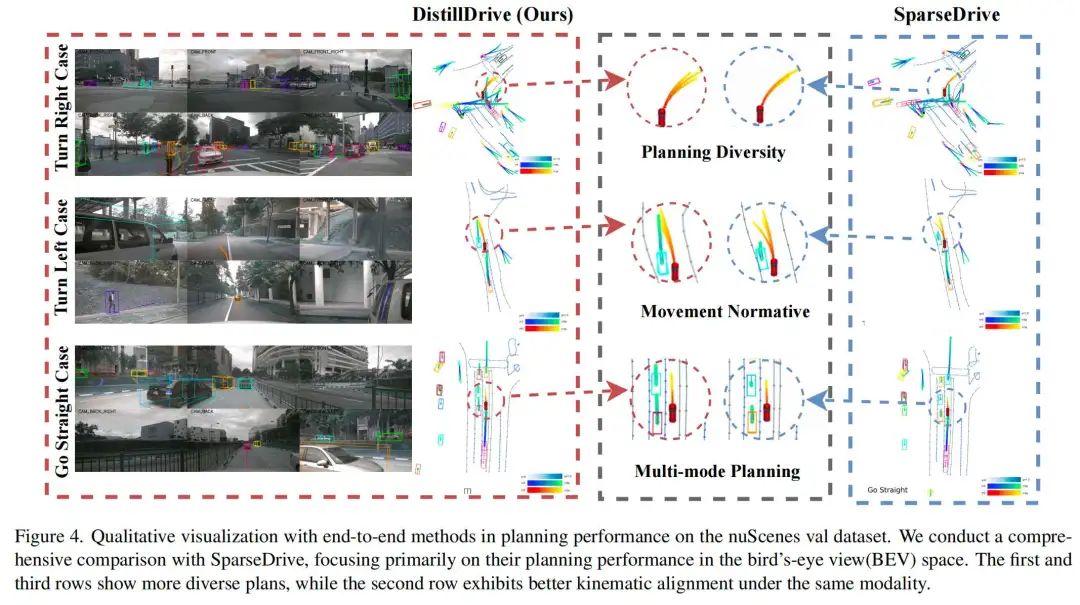

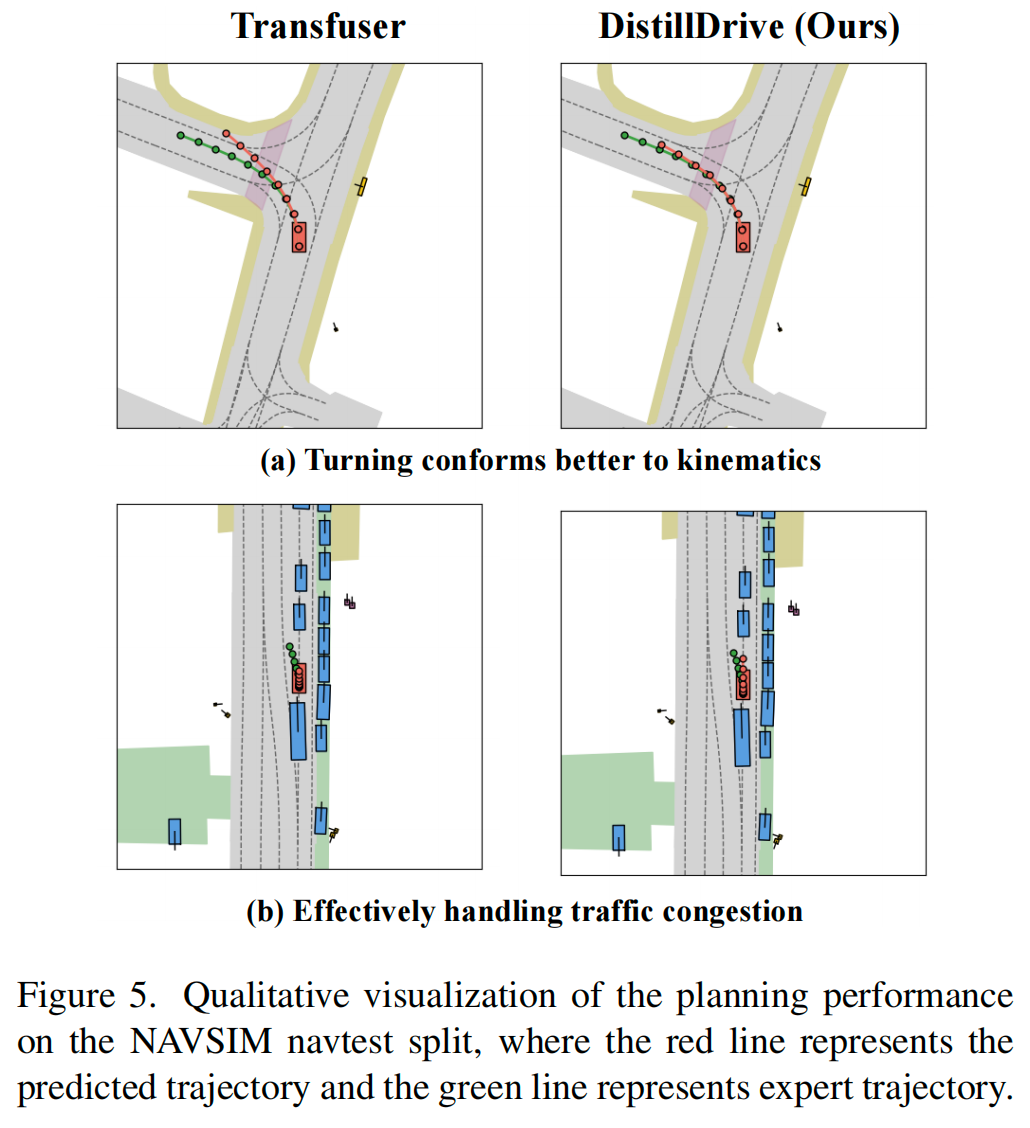

定性可视化。图4在nuScenes数据集上可视化了规划模型在三种场景(右转、左转、直行)下的性能。右转案例显示出更大的轨迹多样性,突显了多模态实例蒸馏的作用。在左转案例中,由于有效的基于强化学习的状态优化,我们的模型产生了更平滑、更自然的轨迹。直行案例则显示出更丰富的轨迹候选集,展示了增强的规划能力。在图5中,我们验证了模型在NAVSIM数据集上的规划性能。在第一个案例中,我们的模型轨迹与专家轨迹高度吻合,表现出更好的完成度。在第二个案例中,当Transfuser因刹车而失败时,我们的模型成功完成了超车,有效处理了拥堵情况。

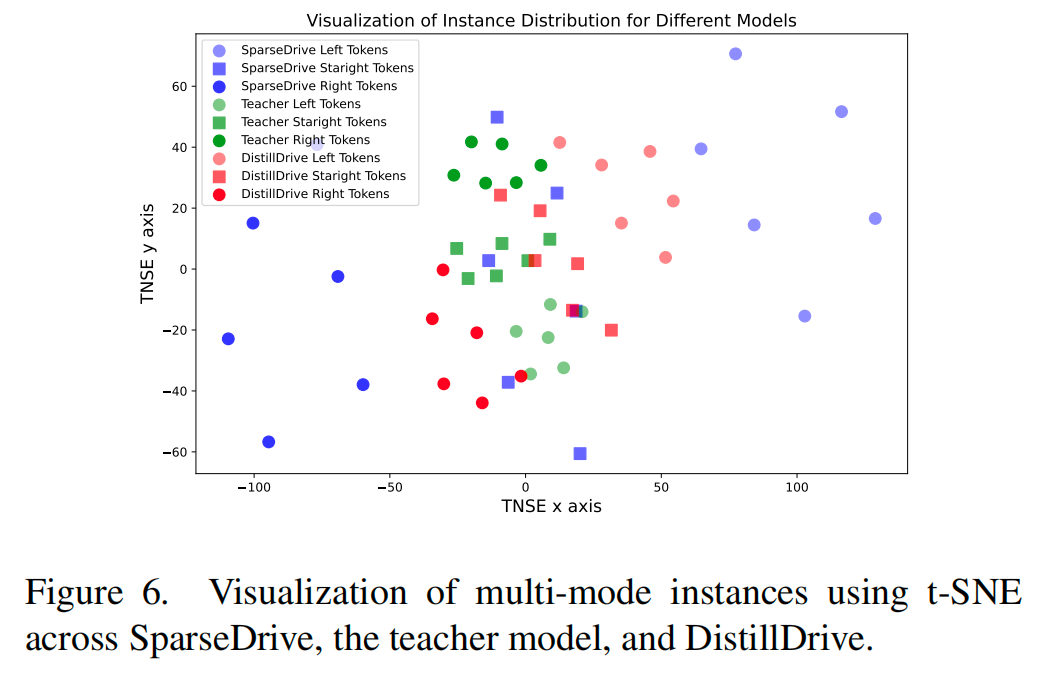

为了分析多模态实例模仿对规划标记(planning tokens)的影响,我们使用t-SNE将标记投影到二维空间,并在图6中比较了SparseDrive、教师模型和DistillDrive。DistillDrive在压缩空间表示的同时保留了原始模型的分布,通过同构模型蒸馏学习到了中间表示,这证明了多样化实例模仿的可行性。

消融实验

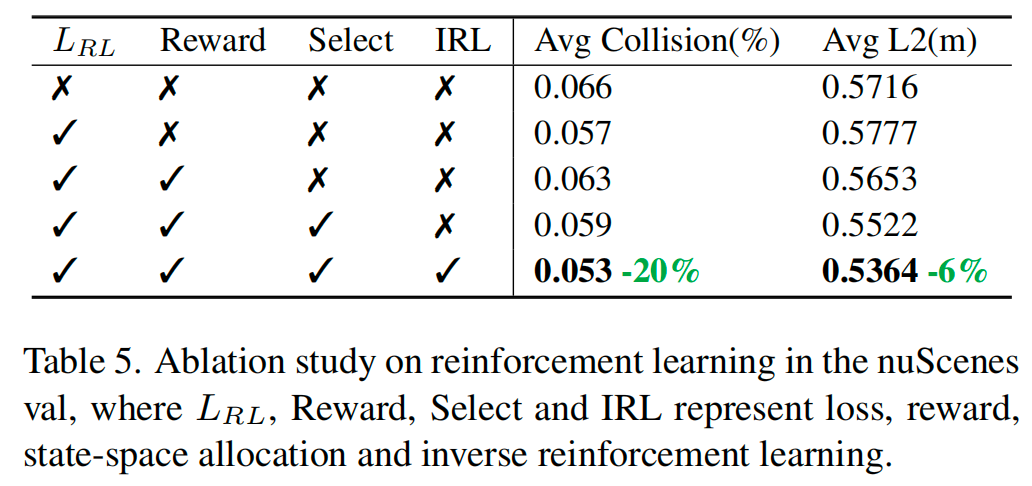

强化学习优化的影响。在表5中,我们应用强化学习来精炼模型,增强其对状态和决策空间的理解。比较第二到第四行表明,适当的监督和奖励可以增强轨迹规划,而第五行的动作选择进一步提升了性能。最后,所提出的线性加权强化学习动态地整合了各种奖励值。该方法实现了碰撞率20%的降低和对齐L2误差6%的减少,证明了其在优化规划准确性和安全性方面的有效性。

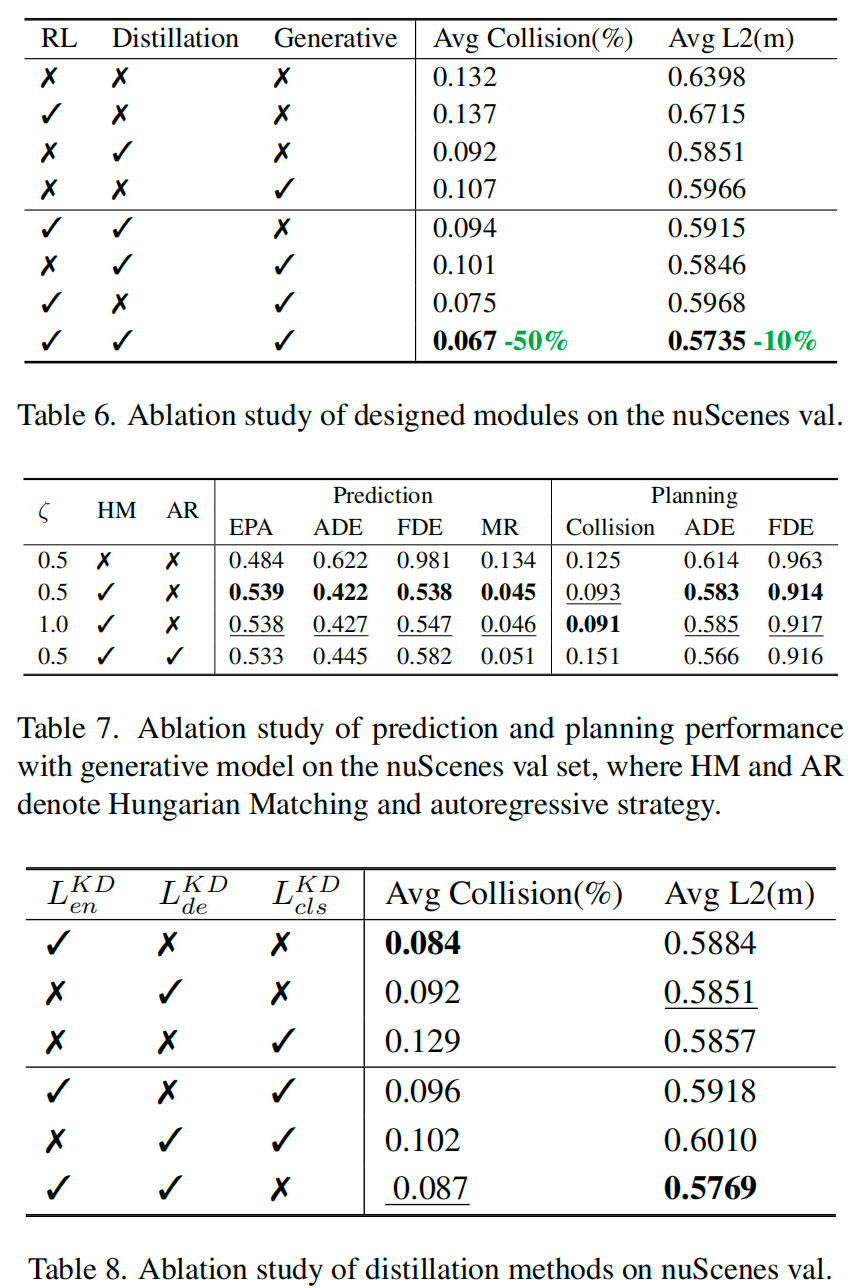

DistillDrive模块的消融研究。为了验证设计的有效性,我们在表6中评估了端到端规划模型的核心模块。在第二到第五行,单独评估表明,知识蒸馏(KD)通过多模态监督显著增强了模型的表达能力,而生成模型则通过分布级交互从运动学习中受益。然而,强化学习(RL)由于受限的状态空间表示而面临挑战。同时,结果表明,组合这些组件能显著提升模型性能。KD作为核心元素,增强了多模态运动模仿,而RL通过状态到决策的监督,提升了对分布外数据的泛化能力,提高了决策的稳定性和鲁棒性。进一步的闭环实验结果包含在附录中。

生成模型的消融研究。分析表7,我们观察到,使用匈牙利匹配(Hungarian matching)将编码在专家轨迹中的运动特征与图像解码中的运动特征对齐,能显著提升规划和预测性能。虽然调整 参数影响较小,但将 设为0.5时性能始终较高。最后,引入自回归策略由于训练困难而对性能产生了负面影响。

知识蒸馏的影响。在表8中,我们验证了我们的知识蒸馏方法,并证明其收益在编码器和解码器中更为显著,从而促进了多样化的实例模仿学习。分类蒸馏的收益有限,因为核心规划功能依赖于回归头,这使得分类监督对规划性能的影响微乎其微。回归蒸馏的更多细节在附录中提供。

结论与未来工作

为了提升端到端模型的规划性能,我们实现了一种多样化的实例模仿学习架构,以监督多模态特征的学习。强化学习和生成式建模增强了运动引导的特征交互,从而在nuScenes和NAVSIM数据集上取得了显著的改进。

在未来的工作中,我们计划将世界模型与语言模型相结合,以提升规划性能。我们将采用更有效的强化学习方法,以更好地理解场景的语义几何空间与决策规划空间之间的关系,从而提升模型的闭环性能。

自动驾驶之心

论文辅导来啦

自驾交流群来啦!

自动驾驶之心创建了近百个技术交流群,涉及大模型、VLA、端到端、数据闭环、自动标注、BEV、Occupancy、多模态融合感知、传感器标定、3DGS、世界模型、在线地图、轨迹预测、规划控制等方向!欢迎添加小助理微信邀请进群。

知识星球交流社区

近4000人的交流社区,近300+自动驾驶公司与科研结构加入!涉及30+自动驾驶技术栈学习路线,从0到一带你入门自动驾驶感知(大模型、端到端自动驾驶、世界模型、仿真闭环、3D检测、车道线、BEV感知、Occupancy、多传感器融合、多传感器标定、目标跟踪)、自动驾驶定位建图(SLAM、高精地图、局部在线地图)、自动驾驶规划控制/轨迹预测等领域技术方案、大模型,更有行业动态和岗位发布!欢迎加入。

独家专业课程

端到端自动驾驶、大模型、VLA、仿真测试、自动驾驶C++、BEV感知、BEV模型部署、BEV目标跟踪、毫米波雷达视觉融合、多传感器标定、多传感器融合、多模态3D目标检测、车道线检测、轨迹预测、在线高精地图、世界模型、点云3D目标检测、目标跟踪、Occupancy、CUDA与TensorRT模型部署、大模型与自动驾驶、NeRF、语义分割、自动驾驶仿真、传感器部署、决策规划、轨迹预测等多个方向学习视频

学习官网:www.zdjszx.com

1924

1924

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?