点击下方卡片,关注“自动驾驶之心”公众号

今天自动驾驶之心为大家分享港科技、滴滴&卓驭ICCV 2025中稿的最新工作!从Planning的视角重新思考轨迹预测,实现二段式端到端新SOTA。如果您有相关工作需要分享,请在文末联系我们!

自动驾驶课程学习与技术交流群事宜,也欢迎添加小助理微信AIDriver004做进一步咨询

>>自动驾驶前沿信息获取→自动驾驶之心知识星球

论文作者 | Muleilan Pei等

编辑 | 自动驾驶之心

写在前面 & 笔者的个人理解

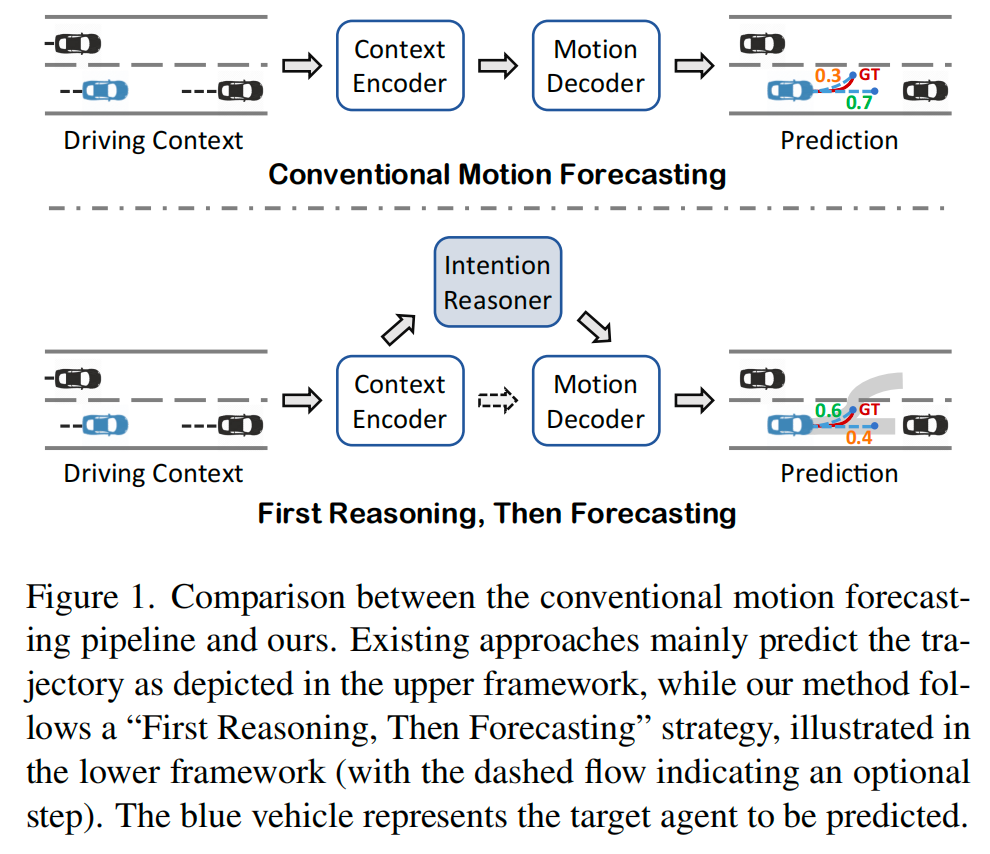

预测行驶中的交通参与者的轨迹运动,对于确保自动驾驶系统的安全性而言,既是一项重大挑战,也是一项至关重要的需求。与大多数现有的、直接预测未来轨迹的数据驱动方法不同,我们从规划(planning)的视角重新思考这一任务,提出一种“先推理,后预测(First Reasoning, Then Forecasting)”的策略,该策略显式地将行为意图作为轨迹预测的空间引导。为实现这一目标,进一步引入了一种可解释的、基于奖励的意图推理器(intention reasoner),其建立在一种新颖的以查询为中心的逆强化学习(query-centric Inverse Reinforcement Learning, IRL)框架之上。我们的方法首先将交通参与者和场景元素编码为统一的向量化表示,然后通过以查询为中心的范式聚合上下文特征。进而推导出一个奖励分布(reward distribution)——一种紧凑但信息丰富的表示,用于刻画目标参与者在给定场景上下文中的行为。在该奖励启发式(reward heuristic)的引导下,我们进行策略 rollout,以推理多种可能的意图,从而为后续的轨迹生成提供有价值的先验信息。最后开发了一种集成双向选择性状态空间模型(bidirectional selective state space models)的分层DETR-like解码器,以生成精确的未来轨迹及其对应的概率。在大规模的Argoverse和nuScenes运动预测数据集上进行的大量实验表明,我们的方法显著提升了轨迹预测的置信度,在性能上达到了与当前最先进方法相当甚至更优的水平。

论文链接:https://arxiv.org/abs/2507.12083

简介

轨迹预测是自动驾驶系统的关键组成部分,它连接了上游的感知模块和下游的规划模块。准确预测周围交通参与者未来的运动,需要对未知的意图进行推理,因为驾驶行为本质上具有不确定性和多模态特性。

大多数现有的数据驱动运动预测模型采用模仿学习(imitative)方法,要么直接回归轨迹,要么基于训练数据集中的数据分布对终点进行分类。然而,这些方法通常对驾驶行为的考虑不足,限制了其可解释性和可靠性。尽管许多方法在基准测试指标上表现出色,但很少有方法能显式地对未来的意图进行推理,这在现实应用中生成可解释且鲁棒的多模态预测时,形成了一个关键瓶颈。

相比之下,人类驾驶员通常以分层的方式操控车辆,先做出高层次决策(例如变道或超车),再执行具体的运动策略。我们可以将自车(ego vehicle)的预测模块视为在为其他参与者进行规划,前提是假设道路使用者的行为是理性的。尽管轨迹预测与规划之间存在内在联系,但很少有研究探索来自规划领域的洞见。受这些观察的启发,我们提出了一个关键问题:能否从规划的视角来处理轨迹预测任务,并通过引入意图推理能力来加以增强?

为此,我们提出一种“先推理,后预测(First Reasoning, Then Forecasting)”的策略,其中行为意图推理为准确且可信的多模态运动预测提供了关键的先验指导。以超车场景为例:一个能够提前显式推理出“超车”和“保持车道”两种意图的模型,相比没有进行推理而直接预测的模型,能够生成更可靠的预测结果,如图1所示。

此外,结合更长期的意图推理可以进一步提升预测的置信度(见表2)。

然而,由于驾驶场景固有的复杂性,仅依赖手工设计的规则或预定义的规划器来进行未来意图推理仍然具有挑战性。一种有前景的替代方案是利用大型推理模型(Large Reasoning Models, LRMs)(如OpenAI-o1)在轨迹预测器中实现意图推理。然而,它们巨大的计算需求使其在车载驾驶系统中不切实际。幸运的是,LRMs的最新进展表明,强化学习(RL)技术在数学和编程等领域展现了卓越的推理能力,这引发了一个有趣的问题:能否利用基于RL的范式来推理轨迹预测中参与者的未来意图?

在这方面,我们探索了将RL范式应用于建模自动驾驶场景中参与者行为推理的可行性。我们将任务形式化为一个马尔可夫决策过程(Markov Decision Process, MDP),并据此定义目标参与者的行为意图。为了在性能和计算效率之间取得平衡,我们构建了一个网格级图(grid-level graph)来表示场景布局,其中意图被定义为在离散网格世界中的一系列决策,类似于传统RL语境中的“规划”。本文将这种意图序列称为基于网格的推理遍历(Grid-based Reasoning Traversal, GRT)。

然而,将RL应用于轨迹预测的一个根本性挑战在于如何建模奖励(reward),因为参与者的意图是未知的。

为克服这一挑战,我们提出了一种基于最大熵逆强化学习(Maximum Entropy Inverse Reinforcement Learning, MaxEnt IRL)的奖励驱动意图推理器。该框架首先通过IRL,从专家示范(demonstrations)和相关驾驶上下文中学习参与者特定的奖励分布。所学习到的奖励作为一种紧凑的表示,捕捉了参与者的可观测行为及其潜在意图。利用这些推断出的奖励作为启发式信息,我们随后进行策略rollout,以采样多种可能的GRT,并提取其对应的、以意图为指导的特征,从而为轨迹预测提供先验指导,进而提高预测的准确性和置信度。

此外,为了进一步增强从场景上下文中提取特征的能力,提出了一种新颖的以查询为中心的IRL框架(Query-centric IRL, QIRL),该框架将IRL与一种基于查询的编码机制相结合。QIRL能够高效且灵活地将向量化场景上下文特征聚合到类似空间网格的token中,便于进行结构化推理。

通过这种密集的网格表示,我们在模型中增加了一个辅助的占用网格图(Occupancy Grid Map, OGM)预测头,该模块能够对场景中每个参与者未来的时空占用进行密集预测。这一辅助任务通过捕捉参与者之间的未来交互,有效增强了特征融合过程,从而提升了整体预测性能(见表7)。

最后为了充分利用意图推理器提供的特征,开发了一种分层的DETR-like轨迹解码器。一个无锚点(anchor-free)的轨迹token首先基于GRT推导出的特征生成初始提议(proposals),这些提议随后作为最终轨迹解码的初始化锚点。考虑到轨迹状态固有的序列性质,以及选择性状态空间模型(Mamba)在长时程、结构化动态建模方面的最新进展,引入了一种双向变体——Bi-Mamba,以有效捕捉轨迹状态的序列依赖关系。这一增强显著提升了预测的准确性和置信度(见表6)。

总结来说,本文的主要贡献如下:

提出了一种“先推理,后预测”的策略,从规划的视角重新思考轨迹预测任务。

为运动预测提出了一种全新的奖励驱动意图推理器,其中QIRL模块在以查询为中心的框架下,集成了MaxEnt IRL范式和向量化上下文表示。

开发了一种集成双向选择性状态空间模型(Bi-Mamba)的分层DETR-like解码器,以提高预测的准确性和置信度。

的方法显著提升了预测置信度,并在Argoverse和nuScenes运动预测基准测试上取得了极具竞争力的性能,超越了其他最先进的模型。

相关工作回顾

自动驾驶轨迹预测

自动驾驶的轨迹预测已研究数十年。该领域的早期工作主要依赖于手工设计的基于规则或基于物理的方法,这些方法难以处理复杂场景,且缺乏进行长期预测的能力。近年来,研究方法已转向基于学习的框架,该框架利用深度神经网络来编码交通参与者的运动历史,同时整合高精地图(HD maps)的拓扑和语义信息。这些地图通常以光栅化(rasterized)或向量化(vectorized)格式表示。光栅化表示通常使用鸟瞰图(Bird’s-Eye-View, BEV)图像作为输入,而向量化表示则依赖于参与者和地图的折线(polylines)作为输入。卷积神经网络(CNNs)和图神经网络(GNNs)被广泛用作这些格式的特征提取器,在编码场景上下文方面发挥着关键作用。最近,基于Transformer的架构因其能够提升整体预测性能而受到广泛关注。顺应这一趋势,我们的工作采用了向量化表示,并利用基于查询的Transformer编码器-解码器结构来进行特征聚合和轨迹生成。

尽管取得了这些进展,但在使轨迹预测对分布外(out-of-distribution)场景具有鲁棒性,以及对未见过的环境具有可泛化性方面,挑战依然存在。我们的工作通过从规划的视角重新思考轨迹预测任务,引入了一种基于奖励的意图推理器,以提供行为指导和上下文丰富的先验信息,从而推进轨迹预测,来解决这些不足。

奖励(Reward)

奖励是规划(planning)和强化学习(RL)中的一个基础概念,它作为一种引导信号,塑造了智能体的行为和决策过程。在规划中,奖励通常被设计为与高层目标对齐,例如在避开障碍物的同时到达目标点。通常,奖励函数是手工设计的,或通过分层框架进行塑造,其中高层规划器为低层控制器提供策略指导。关于奖励塑造(reward shaping)的研究表明,通过修改奖励结构来强调特定行为或里程碑,可以加速学习过程并提高策略的鲁棒性。

在强化学习(RL)中,奖励函数扮演着核心角色,它定义了智能体的目标,并引导其执行能够随时间最大化累积奖励的动作。奖励函数的设计在规划和RL中都至关重要;然而,为复杂任务(如自动驾驶)设计有效的奖励函数极具挑战性。为了解决这一挑战,逆强化学习(Inverse RL, IRL)被提出。IRL专注于从观察到的专家示范(expert demonstrations)中推断出奖励函数,这在直接定义奖励函数不可行的场景中尤其有价值。例如,最大熵逆强化学习(MaxEnt IRL)已被广泛应用于学习能够捕捉专家行为潜在意图的奖励函数,从而使智能体能够在规划任务中复制细致入微、类似人类的决策。

尽管IRL非常有用,但现有的高效IRL算法通常针对结构化和网格状环境进行定制,这限制了它们在更复杂领域中的灵活性。为了克服这一局限性,我们提出了一种新颖的以查询为中心的框架(query-centric framework),该框架增强了MaxEnt IRL在我们基于奖励的意图推理器中的适用性和灵活性。通过利用这一范式,我们的方法提供了有价值的奖励启发式信息,能够有效推理未来行为的意图,为解决运动预测任务固有的复杂性提供了信息丰富的先验。

算法详解

问题定义

标准轨迹预测任务的目标是,在给定驾驶上下文的情况下,预测目标参与者在未来时间范围 内的位置。我们采用向量化表示作为场景输入,包括历史观测状态 ,其中 表示场景中的参与者数量, 表示过去的时间戳数量, 捕捉位置、速度、航向等运动特征,以及高精地图(HD map)信息 ,其中 和 分别对应车道中心线和车道段的数量, 表示相关的车道属性。

我们的方法采用以目标为中心的坐标系,通过平移和旋转操作,将所有输入元素归一化到目标参与者当前的状态。鉴于运动意图的内在不确定性,预测器的任务是提供 条未来的轨迹 ,以及对应的概率

最低0.47元/天 解锁文章

最低0.47元/天 解锁文章

2177

2177

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?