点击下方卡片,关注“自动驾驶之心”公众号

>>自动驾驶前沿信息获取→自动驾驶之心知识星球

论文作者 | Haohong Lin等

编辑 | 自动驾驶之心

英伟达最近工作很多啊,而且做的都挺扎实。前一段时间的自驾VLA框架 - Alpamayo-R1,昨天新的一篇闭环仿真测试框架 - MPA。可圈可点,今天自动驾驶之心为大家分享的就是这篇新工作MPA。

自动驾驶中的开环评测已经相对完善,但在闭环评测中仍然面临着级联误差和泛化能力不足的问题。针对这个问题,CMU、斯坦福和英伟达的团队提出一种基于模型的策略自适应通用框架 - Model-based Policy Adaptation。旨在提升预训练E2E驾驶智能体在部署阶段的鲁棒性与安全性。MPA首先利用几何一致的仿真引擎生成多样化反事实轨迹,让智能体接触到原始数据集之外的场景;基于生成的数据,MPA训练一个基于扩散模型的策略适配器以优化基础策略的预测结果,并训练一个多步Q值模型来评估长期收益。推理阶段,适配器生成多个轨迹候选,Q值模型则选择期望效用最高的轨迹。在nuScenes基准数据集上,通过重建出的真实闭环仿真器的实验表明,MPA在域内场景、域外场景及安全关键场景中均显著提升了性能。MPA进一步探究了反事实数据规模和推理阶段引导策略对整体效果的影响。

论文标题:Model-Based Policy Adaptation for Closed-Loop End-to-End Autonomous Driving

论文链接:https://arxiv.org/abs/2511.21584

项目主页:https://mpa-drive.github.io/

背景回顾

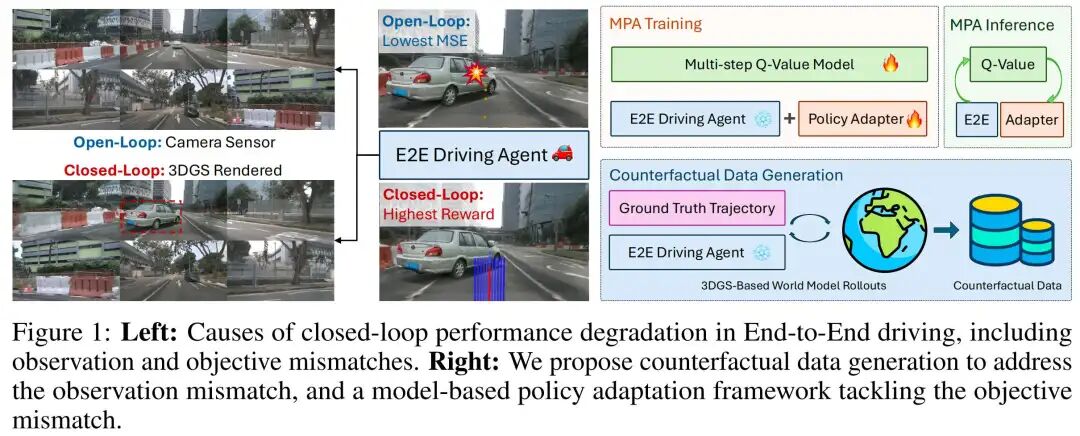

端到端(E2E)自动驾驶模型通过将感知、预测和规划集成到统一的学习框架中,取得了令人瞩目的进展。借助大规模离线驾驶数据集,E2E模型在开环评估协议下表现出色——在此类评估中,智能体仅需从离线记录的观测序列中被动预测未来行为。然而,些模型在闭环环境中性能会下降:微小偏差随时间累积,导致误差叠加、分布偏移,并难以泛化到长时域场景。这种性能差距揭示了一个核心挑战:基于经验风险最小化的离线训练,与最大化累积奖励的在线目标并不一致(如图1所示)。

为弥合这一差距,近期研究开始关注E2E智能体的闭环性能评估。部分开环方法(如NavSim)通过在开环评估中引入预测驾驶模型评分(Predictive Driver Model Score),实现了近似闭环评估。其他研究则为闭环评估引入了传感器仿真技术,基于扩散模型、神经辐射场(NeRF)或3D高斯溅射(3DGS)生成相机视图,支持对新视角的照片级真实感渲染。这些工具能对智能体干预和视觉真实性进行细粒度控制,成为研究失效模式和恢复策略的理想测试平台。现有工作(如VAD、VAD-v2和Hydra-MDP)设计了不同的评分机制来选择用于闭环控制的预测运动,但这些工作要么缺乏闭环评估结果,要么仅在非照片级真实感仿真器(如CARLA)中进行评估。最新的RAD结合了强化学习,并利用3DGS进行在线轨迹推演和评估,但近端策略优化(PPO)智能体的训练成本较高,且价值评判器在推理阶段未被充分利用。在所有现有尝试中,尚无任何工作在训练阶段纳入经过筛选的反事实数据。

本文的目标是借助基于3DGS的驾驶仿真数据引擎,将真实场景下预训练的开环E2E驾驶智能体,适配为安全且具有泛化能力的闭环智能体。我们发现,闭环与开环评估之间的性能下降源于两个根本原因:(1)观测不匹配——训练阶段的传感器输入,与部署阶段不同数据引擎产生的扰动行为下的闭环观测之间存在差异;(2)目标不匹配——离线模仿学习过程中缺乏有意义的奖励反馈,限制了智能体的长时域推理能力。

我们通过初步实验证明,开环评估中第一种不匹配的影响实际上较小。为此,我们提出一种统一解决方案——基于模型的策略自适应(MPA),该通用框架通过分离并针对两类不匹配的根本原因,直接解决上述问题。首先,我们将预训练策略作为行为策略的初始化,利用高保真3DGS仿真引擎生成反事实数据集。为缓解观测不匹配,我们设计了一种基于扩散模型的残差策略适配器,以多样化的反事实轨迹为条件进行训练,使策略能够接触到离线数据集之外的广泛行为和视觉场景。为解决目标不匹配,我们从相同的反事实数据中学习Q值模型,该模型能够捕捉长时域结果,并支持超越规则化指标的基于价值的评估。MPA在推理阶段同时利用这两个组件:策略适配器基于当前观测生成残差动作建议,价值模型通过推理阶段的缩放选择期望效用最高的动作。

本文的贡献主要体现在三个方面:

分析了E2E智能体闭环性能下降的根本原因,并评估了基于3DGS的仿真在建模观测和行为偏移方面的保真度;

提出了一种基于3DGS轨迹推演的系统性反事实数据筛选流程,并训练了包含基于扩散模型的策略适配器和奖励模型的MPA,分别解决观测不匹配和奖励不匹配问题;

在nuScenes基准上验证,利用所学奖励模型进行推理阶段scaling,显著提升了闭环性能,尤其在安全关键场景和域外场景中效果突出。

预备知识

端到端自动驾驶的问题建模

我们将闭环端到端(E2E)驾驶建模为部分可观测马尔可夫决策过程,其形式化定义为 ,其中各参数含义如下: 为潜在状态空间, 为动作空间, 为转移动力学, 为奖励函数, 为观测空间, 为折扣因子, 为规划时域。在每个时间步,智能体接收观测 并输出轨迹动作 ;环境根据转移概率 演化,并通过观测模型 生成观测结果。

在实际场景中,状态 包含自车的惯性测量单元(IMU)状态以及周围道路实体的历史位姿和运动意图,但这些信息通常仅能部分观测。动作 表示未来的一系列路径点,需通过线性二次调节器(LQR)控制器转换为底层油门和转向控制序列,该过程遵循现有基准方法的设计。观测 可由真实传感器采集,或在闭环评估中由仿真引擎渲染生成。

值得注意的是,当前开环E2E智能体的训练依赖于参考行为策略 的专家轨迹,由此产生状态分布 并得到有监督模型 。与之不同,闭环智能体的目标是最大化长期累积奖励,即: (注:原文此处公式未完整显示,核心逻辑为闭环目标函数与开环模仿误差最小化的对比)

这一差异导致了固有目标不匹配:开环训练通过专家监督最小化模仿误差,而闭环部署则需在动态演化和部分可观测条件下优化长时域奖励(如图1所示)。弥合这一差距需对式(1)中的三个组件进行精细对齐:

转移模型 :可通过车辆动力学进行一致性近似;

观测模型 :可能与仿真传感器的观测模型 存在偏差;

奖励函数 :需通过学习到的价值模型从部分观测 中推断。

为解决上述不匹配问题,我们利用基于3D高斯溅射(3DGS)的观测模型 生成反事实数据,进而设计策略适配器,将预训练模型 转换为在学习到的Q值模型引导下与奖励对齐的策略 ,具体框架如图1所示。

闭环仿真中的端到端驾驶智能体

近年来,一类研究方向利用视觉生成模型或重建模型,基于状态参数化渲染照片级真实感驾驶场景,其技术基础包括图像扩散建模、神经场渲染和3D高斯溅射(3DGS)等。这类方法本质上是在POMDP框架中学习观测模型 的估计。但关键在于,需验证这些模型输出的视觉质量是否接近真实场景——只有满足这一条件,它们才能作为闭环评估的有效代理。

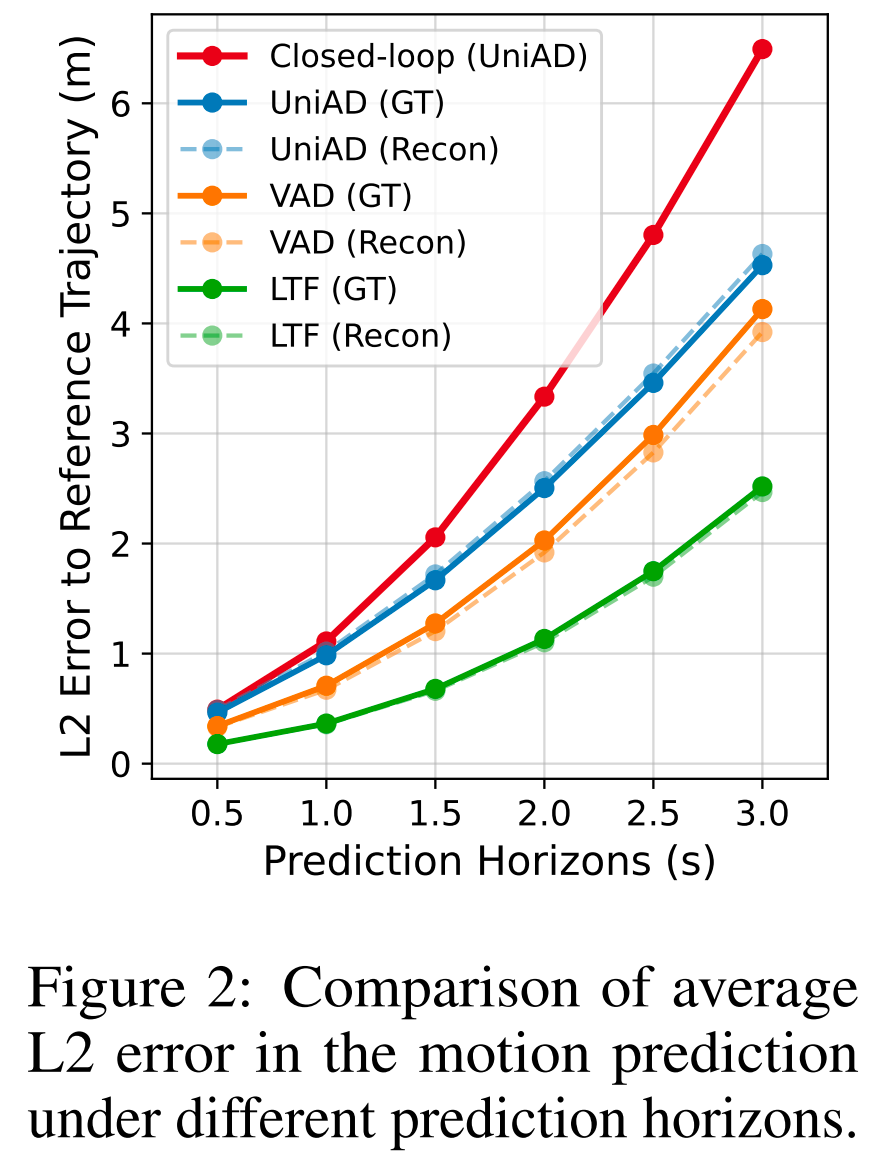

我们通过初步实验分析了闭环仿真器的保真度,并验证了开环与闭环评估之间的性能差距。在图2中,我们系统对比了两种评估设置下运动预测的L2误差:利用3DGS从nuScenes数据集重建场景,并结合真实轨迹(Ground Truth)数据进行性能比较。结果显示,三种E2E策略在开环运动预测中的性能极为接近,这证明了基于3DGS的仿真在场景重建质量上的高保真度。同时,我们还展示了基于UniAD的闭环轨迹推演(rollout)轨迹的L2误差:随着预测时域延长,闭环预测误差较开环预测显著增大。短预测时域内不可忽略的L2误差会导致分布偏移问题,进而引发误差累积;而单纯提高规划频率或缩短规划时域,并不能弥合开环与闭环的性能差距——除非为E2E智能体提供有效的反馈引导。

所提方法:基于模型的策略自适应(MPA)

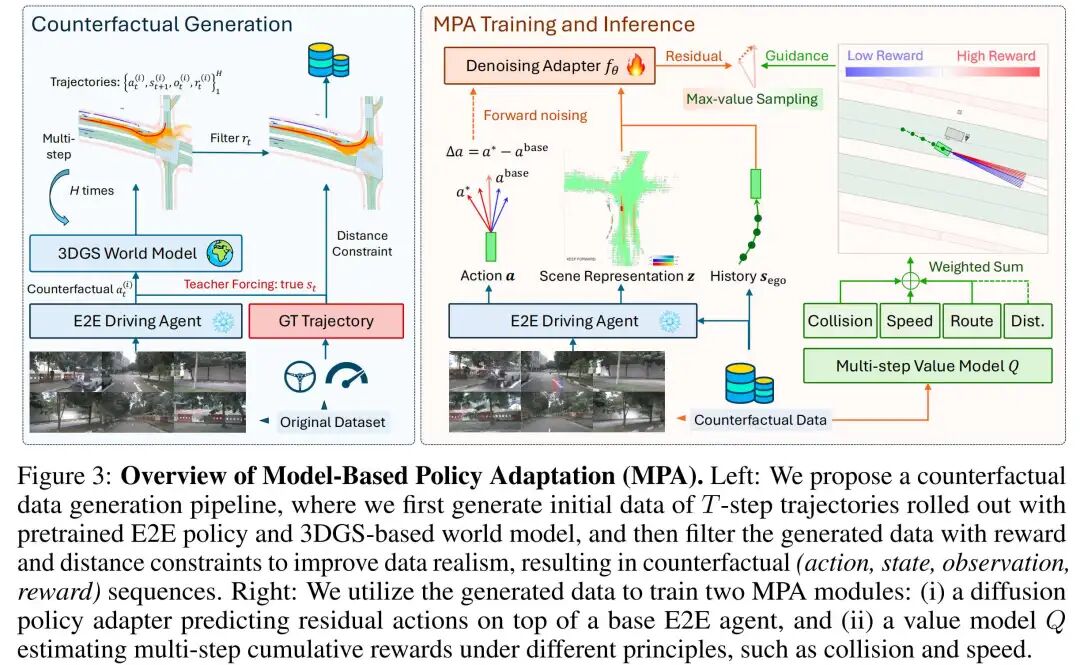

为解决2.1节所述的观测不匹配和目标不匹配问题,我们提出基于模型的策略自适应(Model-Based Policy Adaptation, MPA)——一种用于端到端(E2E)自动驾驶从开环到闭环适配的统一框架,其整体结构如图3所示。

基于世界模型的反事实数据生成

我们利用几何一致的3D高斯溅射(3DGS)仿真器生成反事实样本,该仿真器可根据自车和周围智能体的位姿渲染照片级真实感观测,从而建模观测分布 。如前文所示,只要轨迹推演策略所诱导的状态分布与参考分布接近,该仿真器的渲染结果就能保持高保真度。

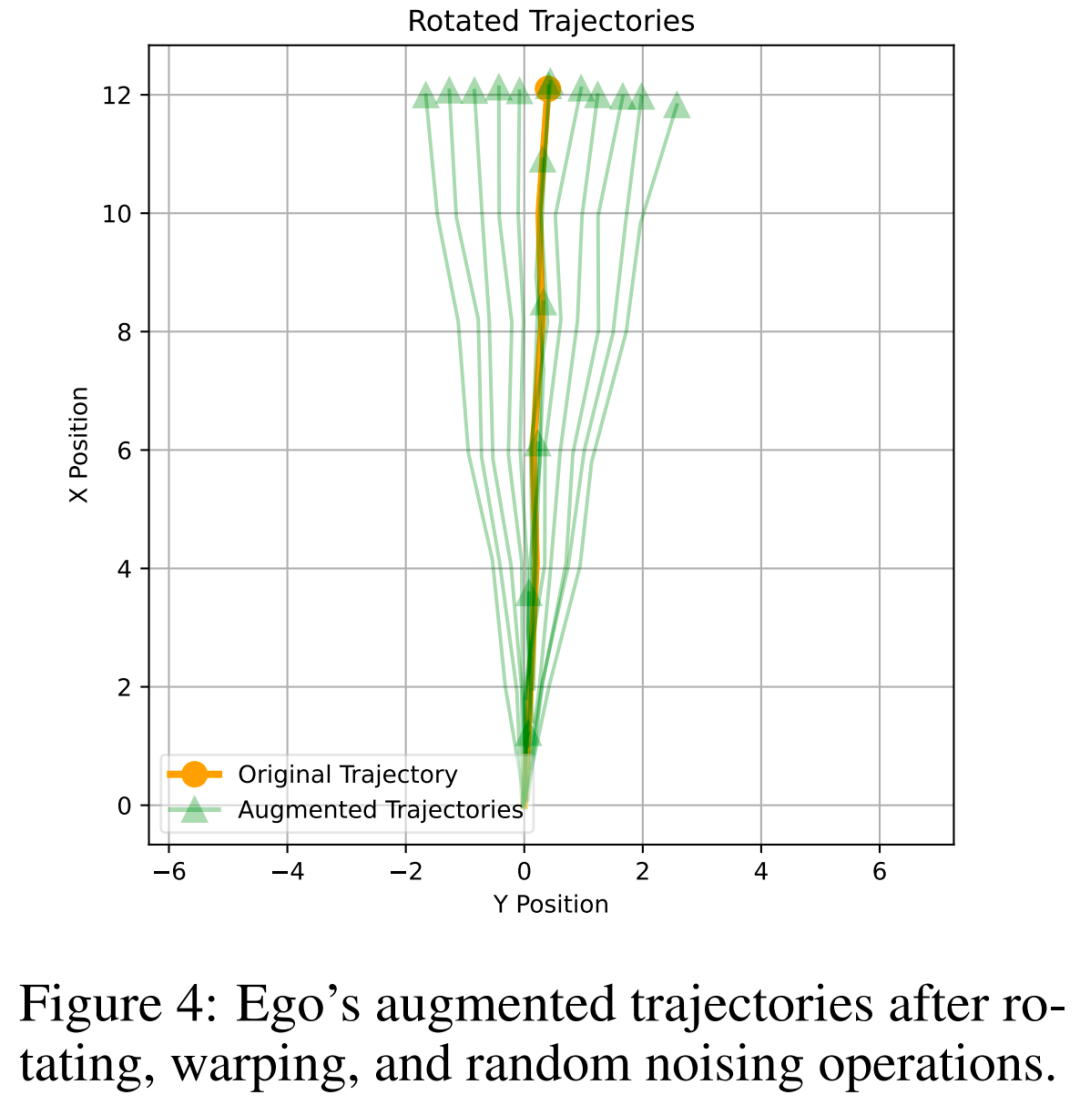

为在保证观测可靠性的同时引入行为多样性,我们对预训练E2E策略 的预测动作进行随机增强(包括旋转、扭曲和随机噪声),得到噪声策略 。增强后行为的分布如图4所示,具体轨迹增强参数设置如下:旋转角度范围为[-10, 10](单位:度),扭曲比例范围为[0.1, 1.0],随机高斯噪声的标准差为0.05。根据旋转角度和扭曲比例的不同,这些增强轨迹会被划分为不同模态,以适配多模态策略适配器。

在教师强制(teacher-forcing) 设置下,我们从每个驾驶场景的原始参考状态初始化轨迹推演,并执行反事实轨迹推演。为缓解随推演时域延长而呈指数级增长的搜索空间,我们借鉴波束搜索算法(beam search algorithm),仅保留仿真器通过规则化启发式计算得到的累积奖励最高的候选轨迹(奖励的具体定义见附录A)。这种“提议-评分-选择”流程在现有研究中也被用于缓解运动规划器的“预测-规划失配”问题。

为避免渲染伪影,我们丢弃两类轨迹:一是偏离参考轨迹距离超过阈值的轨迹,二是奖励低于最小值的轨迹。轨迹推演时域 决定了反事实行为的未来延伸长度——实验表明,更长的时域能为下游学习提供更丰富的监督信号,但也会增加轨迹偏离参考数据的风险。

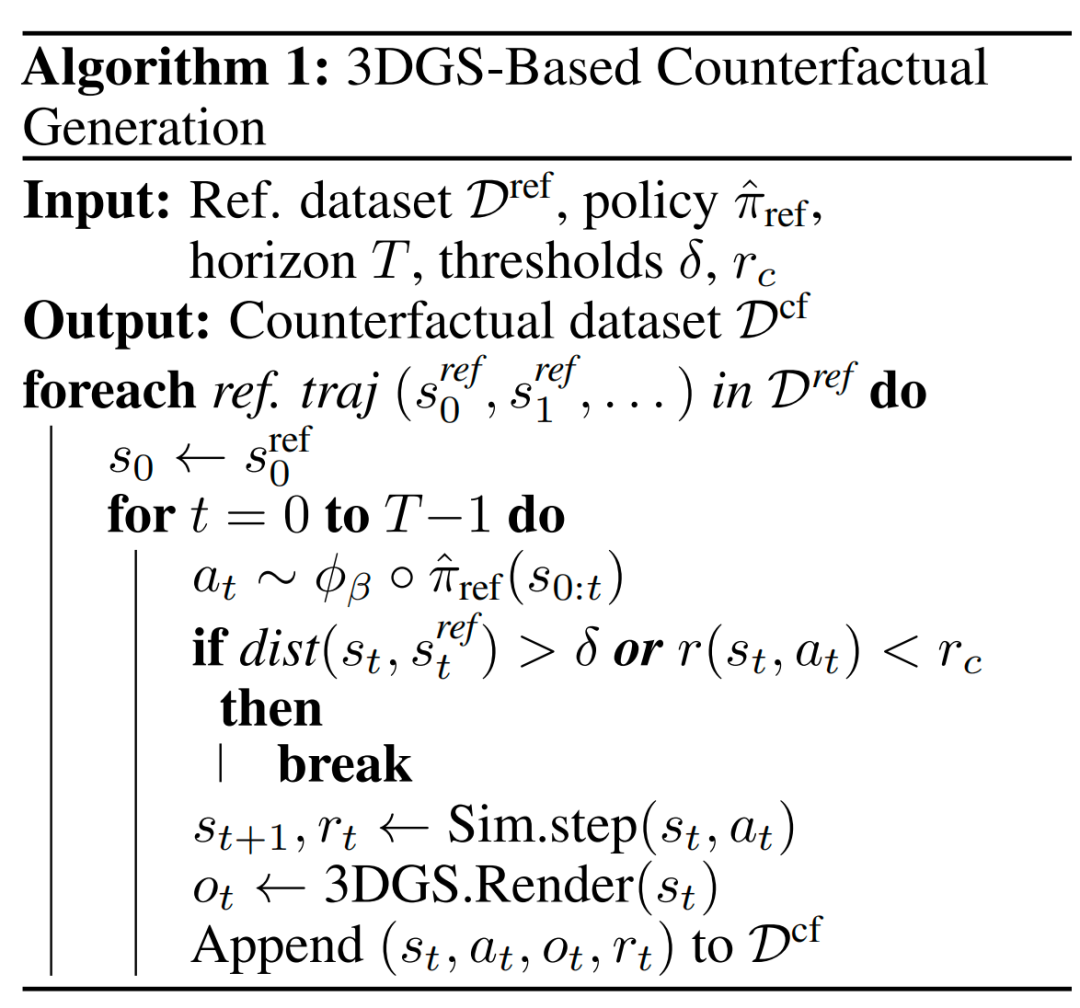

完整的反事实数据生成流程总结于算法1(Algorithm 1)。在获得生成的反事实数据集后,我们将在后续小节中开展策略学习和价值学习。

基于扩散模型的策略自适应

如图4所示,生成的反事实动作呈多模态分布。为捕捉这类动作特征,我们提出基于扩散模型的策略适配器:通过预测残差轨迹 ,对冻结的端到端(E2E)驾驶模型的输出进行优化。其中, 是预训练策略(如UniAD)输出的轨迹, 是从反事实轨迹推演数据集中筛选出的奖励最高的轨迹样本。

训练过程:为建模残差轨迹的分布,我们采用潜扩散过程(latent diffusion process)。前向过程通过 步添加高斯噪声实现:设 (初始残差轨迹), 为累积噪声调度因子,则第 步的带噪残差轨迹为:

其中 是标准高斯噪声。

去噪网络 采用1D U-Net结构,以带噪残差轨迹 为输入,输出多模态的初始残差轨迹 ,其条件输入包括:场景编码 ( 为观测, 为自车状态)、自车历史 ,以及基础预测轨迹 。去噪网络 的输出包含 个模态,第 个模态表示为 。网络训练采用以下损失函数(基于前向过程的噪声预测): (注:原文未完整列出损失函数公式,核心为最小化预测噪声与真实噪声的均方误差,即 )

推理过程:推理阶段采用DDIM(Denoising Diffusion Implicit Models)方法采样初始残差轨迹 ,并恢复适配后的最终轨迹:

该设计通过将预训练基础策略的场景上下文和基础动作作为条件输入,实现了对预训练知识的适配,从而使策略能够泛化到反事实数据域之外的场景。

Q值引导推理时间采样原理

训练过程:尽管在可完整获取状态 的情况下可计算单步奖励,但在部分可观测条件下估计长时域收益仍具挑战性。为此,我们利用生成的反事实数据集,训练多步动作价值模型(即Q值模型),其设计基于四个可解释原则:

:路径跟随(衡量自车沿规划路径的推进程度);

:车道距离(衡量自车与车道边界的距离合规性);

:避撞(衡量自车与周围实体的碰撞风险);

:速度合规(衡量自车速度与限速的匹配程度)。

每个Q函数均独立训练,输入为 ,输出为对应原则下的累积收益。最终综合Q值为各单原则Q值的加权和:

其中权重 的设计参考现有研究。

推理过程:推理阶段,首先按照前文的策略适配器推理流程采样残差动作 ,再通过以下方式选择最优动作提议: (注:原文未完整列出选择公式,核心逻辑为选择综合Q值最高的动作,即 )

与基于分类器的奖励引导相比,我们的Q值引导具有两大优势:一是能纳入更长规划时域的反馈信息,二是避免了奖励模型的梯度不稳定性。

实验结果分析

本章通过实验解答以下研究问题(RQ):

RQ1:与基线模型相比,MPA能否为E2E驾驶智能体在闭环评估中带来具备泛化性的性能提升?

RQ2:MPA在闭环评估的安全关键场景中性能表现如何?

RQ3:MPA中的不同适配器与价值引导模块对整体性能的贡献分别是什么?

RQ4:在数据生成阶段,反事实规划步数的规模如何影响MPA的性能?

实验设置

数据集与仿真引擎:我们采用nuScenes数据集,该数据集包含波士顿和新加坡地区共5.5小时的驾驶数据,每个场景均有20秒的参考轨迹。仿真与评估基准采用HUGSIM,训练过程使用nuScenes训练-验证集中的290个场景,评估分为三类设置:

域内评估:测试集为70个场景,场景中动态实体(车辆、行人)的运动轨迹按离线数据集中参考轨迹的固定比例回放;

未见过的常规场景评估:测试集为70个训练阶段未接触过的场景,动态实体运动轨迹同样按参考轨迹固定比例回放;

安全关键场景评估:测试集为10个场景,场景中包含一个(或少量)干扰性非原生智能体,用于对自车智能体形成对抗性挑战。

仿真频率设为4Hz,闭环仿真终止条件包含以下五种:(1)完成全部路线;(2)驶离道路;(3)发生碰撞;(4)偏离参考轨迹过远;(5)达到最大推演时间限制(50秒,为参考轨迹时长的2.5倍)。

基线模型:我们将MPA与两类E2E驾驶算法基线进行对比:

开环训练的预训练基础策略:对比UniAD、VAD、LTF在HUGSIM数据集上的性能,并基于这些策略构建MPA模型;

基于筛选后反事实数据集训练的E2E智能体:

AD-MLP:以自车速度、加速度、历史轨迹和高层指令为输入,是闭环驾驶任务的基础基线;

BC-Safe:利用反事实数据集中的安全片段训练E2E策略;

Diffusion:参考的场景编码方式,推理阶段采用基于DDIM的采样器(而非截断去噪)。

为保证公平对比,所有方法均采用预训练ResNet作为感知backbone,用于编码6个视角相机的RGB输入;自车状态包含速度、加速度及历史帧中的导航路标信息。

评估指标:评估协议遵循HUGSIM[13](参考NAVSIM[22]的指标设计),具体指标如下(所有指标取值范围为[0.0, 100],数值越高性能越好,表格中均已乘以100):

RC(Route Completion,路线完成率):衡量自车在发生严重失效(碰撞、驶离道路等)前沿规划路线的推进程度;

NC(Non-Collision,无碰撞率):评估自车与周围静态/动态实体无责任碰撞的概率(注:HUGSIM中3DGS模型可能因点云不一致对车辆包围盒进行侵蚀处理,导致部分“近距避让”被误判为碰撞,因此NC值可能被低估);

DAC(Driveable Area Compliance,可行驶区域合规率):若自车位姿落在地面点云内的面积占比<0.3,判定为违规(DAC=0);占比在0.3~0.5之间时DAC=50;占比>0.5时DAC=100;

TTC(Time-To-Collision,碰撞时间合规率):若未来0.5秒内(不同于NAVSIM的0.9秒)自车将发生碰撞,TTC=0;否则TTC=100;

COM(Comfort,舒适性):若纵向/横向加速度、横摆率、横摆加速度及纵向加加速度均低于阈值,COM=100;否则为0;

HDScore(HUGSIM驾驶评分):基于上述指标的加权和,与NAVSIM不同,HDScore采用RC(而非Ego Progress,自车进度)作为核心权重项,具体计算方式见附录B.1。

主要结果与分析(RQ1、RQ2)

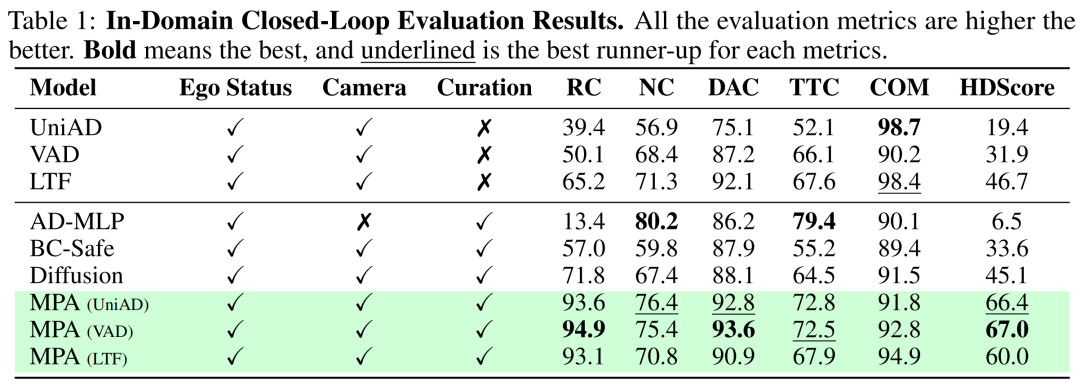

域内与域外场景性能:为解答RQ1,我们首先评估MPA在域内和域外场景的闭环性能(所有MPA模型推理时均采用20个动作样本)。域内场景指新加坡地区用于生成反事实训练数据的场景,定量结果如表1所示。基于MPA的E2E驾驶智能体相较于其预训练版本(如UniAD、VAD、LTF)以及三种基于筛选后反事实数据集训练的基线方法(AD-MLP、BC-Safe、Diffusion),均取得了更优的结果,尤其在关键指标RC和HDScore上提升显著。

其中,基线模型AD-MLP的行驶策略极为保守,虽能维持较低的碰撞风险(NC和TTC指标尚可),但路线完成率极低(RC仅13.4),难以完成复杂E2E场景的导航任务。此外,HUGSIM中的NC值相较于NAVSIM偏低,原因如前所述(3DGS对车辆包围盒的侵蚀导致误判),但多数“误判碰撞”并不会导致闭环仿真episode终止,因此部分模型虽NC值中等,仍能通过合理规避碰撞和驶离道路行为完成路线导航,最终获得较高的HDScore。

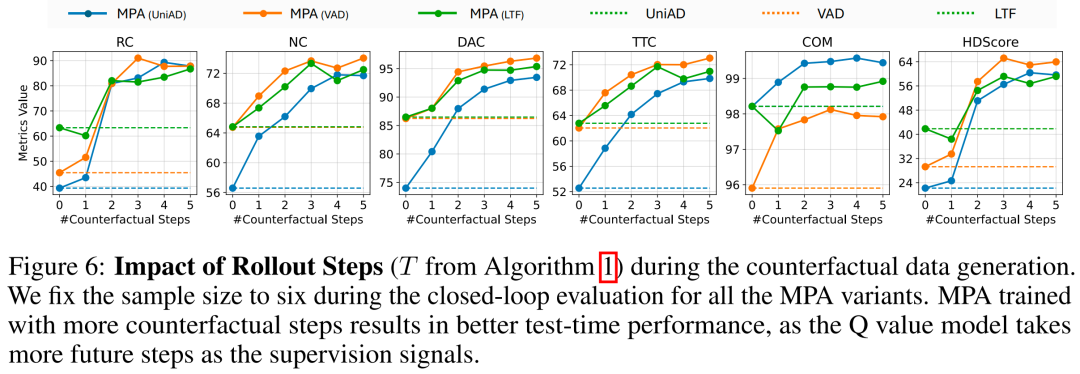

我们进一步在域外场景(波士顿地区未纳入反事实数据集的70个场景)中评估性能,定性结果如图6(左)所示。与表1的域内结果相比,AD-MLP和Diffusion的性能显著下降,而预训练E2E策略在域内与域外场景中的性能表现相近;值得注意的是,基于预训练E2E策略构建的MPA智能体在域外场景中仍保持最优性能,且三类MPA变体(MPA(UniAD)、MPA(VAD)、MPA(LTF))的HDScore与域内评估结果相当,这证明了所提适配器和价值模型在未知场景下的泛化能力。

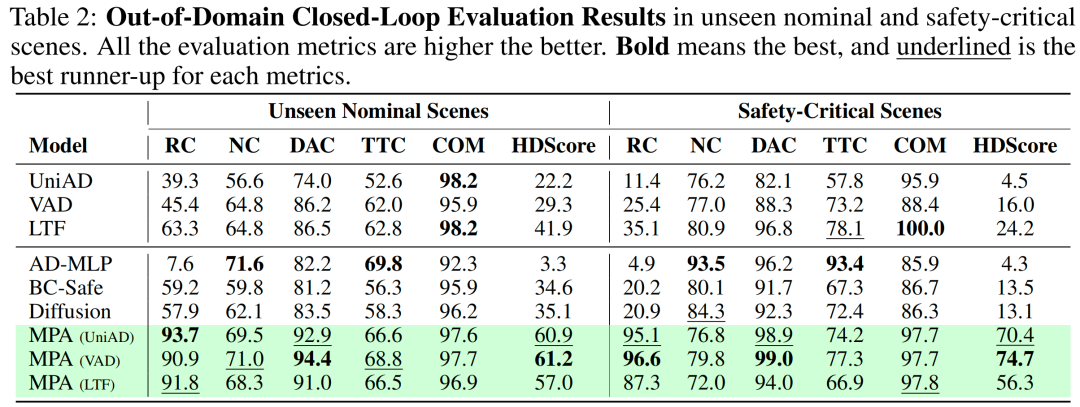

安全关键场景性能:为解答RQ2,我们在包含对抗性干扰智能体的安全关键场景中进行评估,定量结果如表2所示。MPA模型在该场景下的性能提升尤为显著:以MPA(VAD)为例,其RC达到96.6,HDScore高达74.7,远超预训练VAD的RC(25.4)和HDScore(16.0);即使是性能最差的MPA(LTF),其HDScore(56.3)也约为预训练LTF(24.2)的2.3倍。

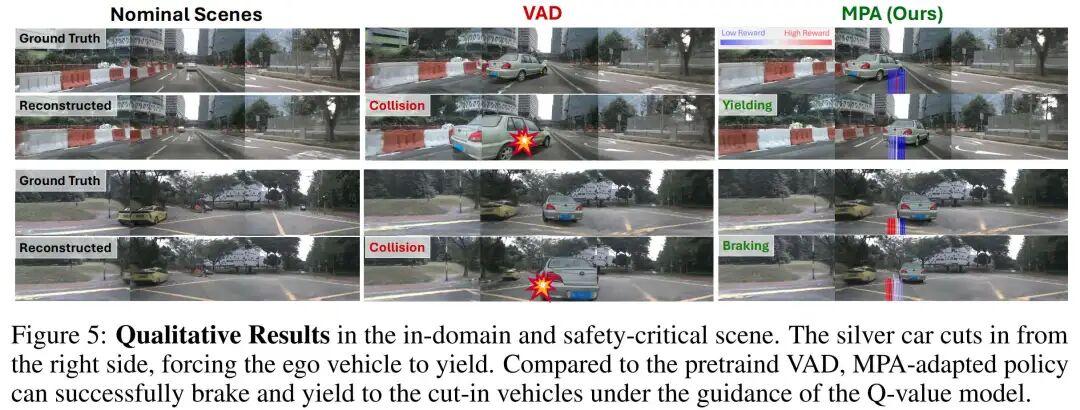

定性结果如图5所示:在“右侧车辆切入”的安全关键场景中,预训练VAD策略无法有效应对,而MPA适配后的策略在Q值模型引导下,能够成功制动并避让切入车辆,验证了MPA在安全关键场景中的有效性。

消融研究(RQ3、RQ4)

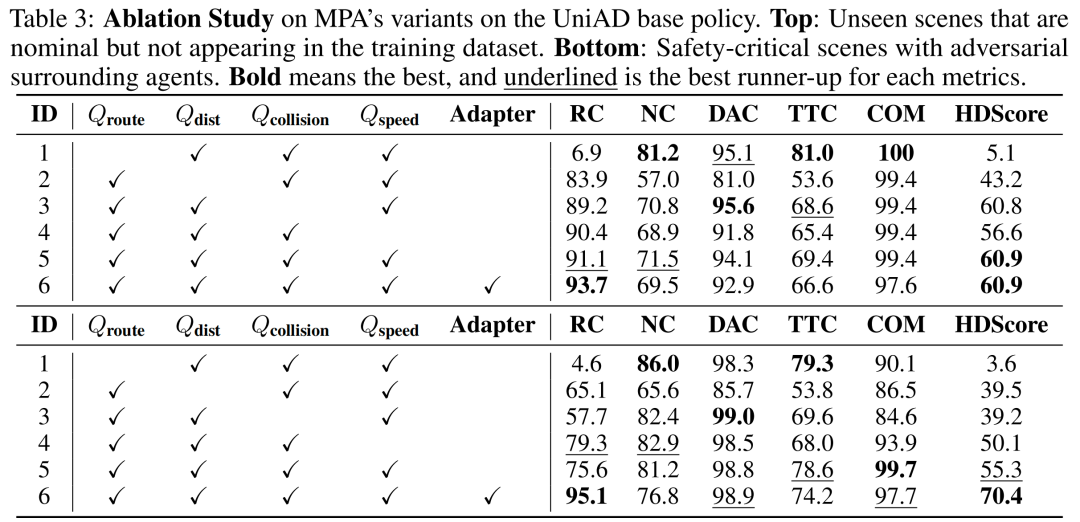

我们通过消融实验分析MPA三大核心模块的贡献:(1)反事实数据集生成;(2)策略适配器;(3)Q值引导。

反事实数据集的影响(RQ4:我们通过消融反事实数据生成过程中的轨迹推演步数(即算法1中的 ),分析其对MPA性能的影响。实验在波士顿域外场景中进行,结果如图6所示:随着反事实推演步数的增加,MPA的各项评估指标(尤其是RC和HDScore)均呈上升趋势。这是因为更长的推演步数能为价值函数训练提供更丰富的未来步监督信号,帮助Q值模型更准确地评估长时域收益。

策略适配器的影响(RQ3):表3展示了基于UniAD基础策略的MPA变体消融结果(VAD和LTF的消融结果见附录B)。对比ID-5(无适配器)与ID-6(有适配器)的结果:在安全关键场景中,适配器使RC提升约20%,HDScore显著提高,证明适配器能有效优化基础策略的动作输出;在域外常规场景中,适配器同样提升了路线完成率(RC从91.1升至93.7)。

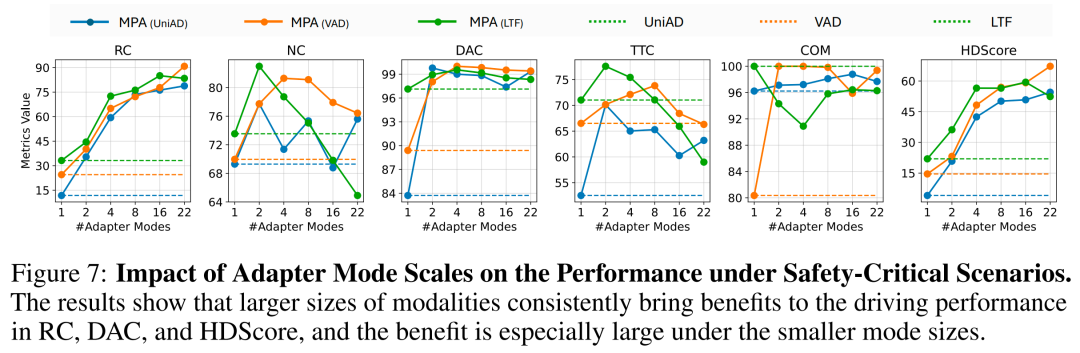

此外,我们还分析了策略适配器的模态数量对安全关键场景性能的影响(图7):模态数量从1增加到8时,RC、DAC和HDScore均显著提升;当模态数量超过8后,性能提升趋于平缓。这表明适当增加模态数量能覆盖更多反事实行为模式,但过量模态并不会带来额外增益。

Q值引导的影响(RQ3):表3中通过移除Q值模型的不同组件( 、 、 、 ),分析各组件的作用:

移除 (ID-1):RC急剧下降(域外场景从91.1降至6.9,安全关键场景从75.6降至4.6),HDScore近乎归零,证明路径跟随是Q值模型的核心组件;

移除 (ID-2):DAC和NC显著下降(域外场景DAC从94.1降至81.0),说明车道距离约束对保证行驶区域合规性至关重要;

移除 (ID-3):安全关键场景中RC下降明显(从75.6降至57.7),原因是智能体易因碰撞提前终止episode;尽管NC值看似较高,但这是由于碰撞前的有效帧长度缩短(分母变小)导致的统计偏差;

移除 (ID-4):COM略有下降,TTC轻微受损,HDScore随之降低,表明速度合规性对驾驶舒适性和安全性有一定影响。

上述结果验证了Q值模型各组件的必要性,且路径跟随和避撞是保障闭环安全与性能的关键原则。

结论

工作总结

本文提出基于模型的策略自适应(MPA) 框架,旨在提升端到端(E2E)自动驾驶智能体的闭环可靠性。MPA的核心流程如下:

反事实数据生成:利用几何一致的3D高斯溅射(3DGS)仿真环境,生成高质量反事实轨迹,在保证视觉保真度的同时扩大数据覆盖范围;

策略与价值模型训练:基于反事实数据集,训练两种核心模块——(1)基于扩散模型的策略适配器,用于优化基础策略的预测结果;(2)多原则价值模型(Q值模型),用于引导推理阶段的决策;

闭环推理:适配器生成多个轨迹候选,价值模型选择长时域收益最优的动作,使预训练智能体能应对复杂闭环场景。

在nuScenes数据集和HUGSIM基准上的实验表明,MPA在域内场景、域外场景及安全关键场景中均显著提升了E2E智能体的性能,验证了其安全性与泛化性。

局限性与未来工作

尽管MPA取得了较好的效果,仍存在以下局限性:

3DGS渲染依赖:MPA假设3DGS在受限轨迹偏差下能提供可靠渲染,但当轨迹严重偏离参考分布时,渲染质量可能下降;

价值与策略分离:当前MPA将价值建模与策略优化解耦,未实现两者的联合优化;

场景覆盖范围:实验仅基于nuScenes数据集,未扩展至更多驾驶场景(如极端天气、复杂路口)。

未来工作将围绕以下方向展开:

数据集扩展:将MPA应用于更多多样化驾驶数据集,验证其跨场景适应性;

在线强化学习集成:探索在3DGS仿真器中引入在线强化学习(RL),实现价值模型与策略适配器的联合训练;

多模态基础模型融合:将MPA部署到多模态基础模型中,增强其对严重分布偏移场景的推理能力,进一步提升闭环鲁棒性。

自动驾驶之心

论文辅导来啦

自驾交流群来啦!

自动驾驶之心创建了近百个技术交流群,涉及大模型、VLA、端到端、数据闭环、自动标注、BEV、Occupancy、多模态融合感知、传感器标定、3DGS、世界模型、在线地图、轨迹预测、规划控制等方向!欢迎添加小助理微信邀请进群。

知识星球交流社区

近4000人的交流社区,近300+自动驾驶公司与科研结构加入!涉及30+自动驾驶技术栈学习路线,从0到一带你入门自动驾驶感知(大模型、端到端自动驾驶、世界模型、仿真闭环、3D检测、车道线、BEV感知、Occupancy、多传感器融合、多传感器标定、目标跟踪)、自动驾驶定位建图(SLAM、高精地图、局部在线地图)、自动驾驶规划控制/轨迹预测等领域技术方案、大模型,更有行业动态和岗位发布!欢迎加入。

独家专业课程

端到端自动驾驶、大模型、VLA、仿真测试、自动驾驶C++、BEV感知、BEV模型部署、BEV目标跟踪、毫米波雷达视觉融合、多传感器标定、多传感器融合、多模态3D目标检测、车道线检测、轨迹预测、在线高精地图、世界模型、点云3D目标检测、目标跟踪、Occupancy、CUDA与TensorRT模型部署、大模型与自动驾驶、NeRF、语义分割、自动驾驶仿真、传感器部署、决策规划、轨迹预测等多个方向学习视频

学习官网:www.zdjszx.com

1万+

1万+

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?