点击下方卡片,关注“自动驾驶之心”公众号

今天自动驾驶之心为大家分享华中科技大学&旷视科技最新的工作!首个统一驾驶世界模型HERMES,BEV+世界查询协同优化3D驾驶场景,生成误差降三成!如果您有相关工作需要分享,请在文末联系我们!

自动驾驶课程学习与技术交流群事宜,也欢迎添加小助理微信AIDriver004做进一步咨询

>>自动驾驶前沿信息获取→自动驾驶之心知识星球

论文作者 | Xin Zhou等

编辑 | 自动驾驶之心

概述

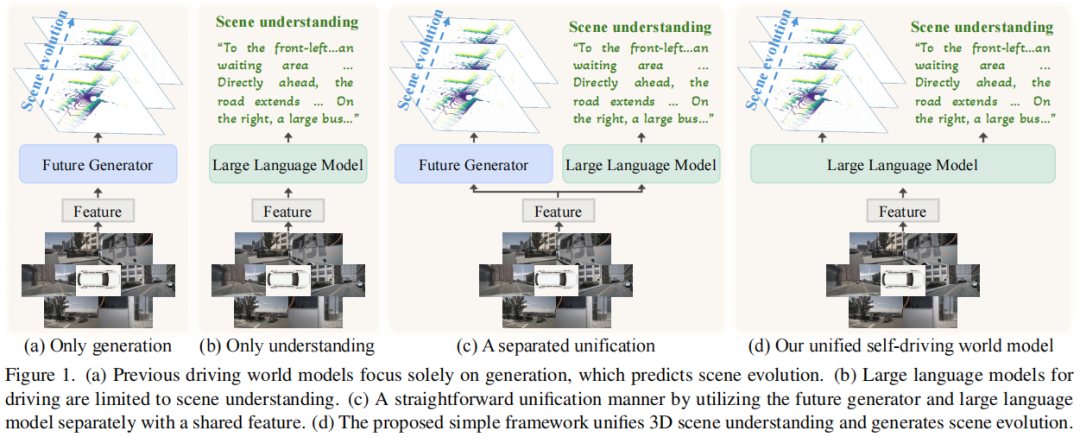

自动驾驶领域中,驾驶世界模型(DWMs)已成为核心工具,但现有模型存在明显割裂:一类专注于场景生成,能预测环境演化(figure 1(a)),却难以解读、描述环境或回答相关问题;另一类以视觉语言模型(VLMs)为代表,擅长场景理解,可处理复杂查询、生成描述(figure 1(b)),但缺乏对未来场景的预测能力。

为打破这种割裂,本文提出HERMES——一个能同时实现3D场景理解与未来场景生成的统一框架(figure 1(d))。其核心创新在于通过BEV表示整合多视图空间信息,并引入“世界查询”机制,将世界知识注入生成过程,实现理解与生成的深度协同。在nuScenes和OmniDrive-nuScenes数据集上,该模型表现显著:生成任务误差较现有最优方法降低32.4%,理解任务中CIDEr指标提升8.0%。

核心挑战与解决方案

多视图的大空间性问题

自动驾驶场景中,多视图图像(如nuScenes的六视图)直接转换为 tokens 会超出大语言模型(LLM)的长度限制,且难以捕捉视图间交互。

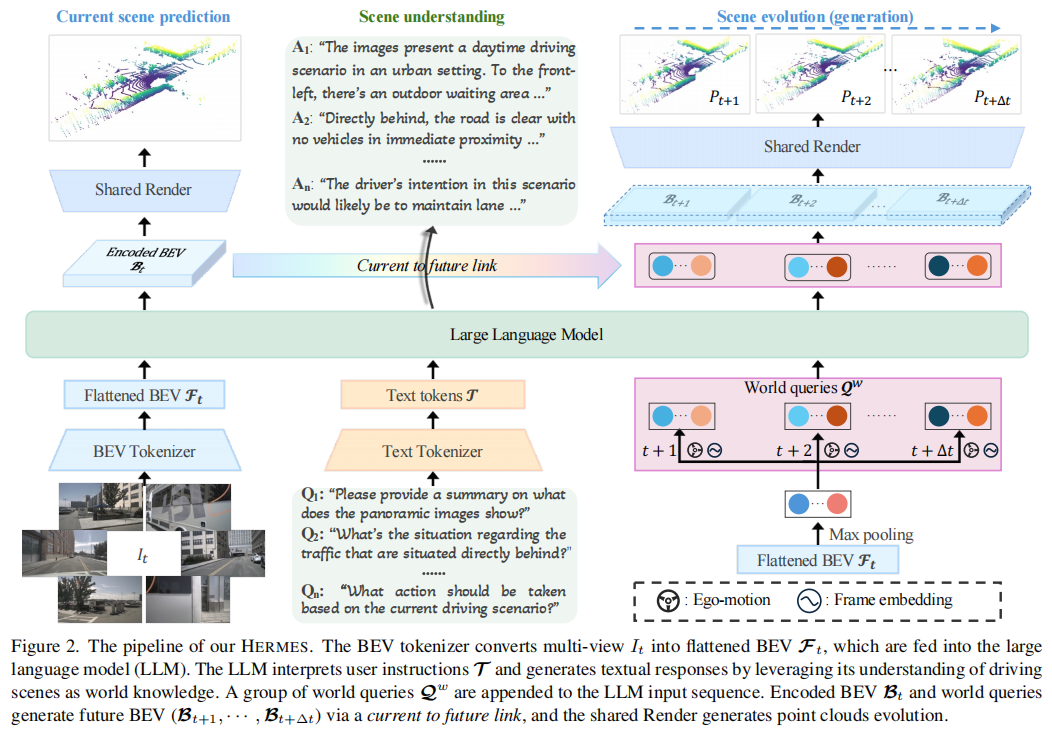

解决方案是采用BEV-based世界分词器:将多视图图像编码为压缩的BEV特征。这一做法有两大优势:一是将多视图信息压缩到统一潜在空间,突破token长度限制的同时保留关键空间信息;二是保留视图间的几何空间关系,便于捕捉跨视角的物体与智能体交互(figure 2)。

理解与生成的整合问题

简单的统一方式(共享BEV特征,分别用LLM和未来生成器处理理解与生成,figure 1(c))无法利用两者间的潜在交互,且会阻碍优化过程。

解决方案引入世界查询:从原始BEV特征初始化一组世界查询,通过LLM中的因果注意力,用文本token的世界知识增强这些查询。再通过“当前到未来链接”模块,让增强后的查询与LLM处理后的BEV特征交互,使生成的场景演化富含世界知识,从而桥接理解与生成(figure 2)。

HERMES框架细节

世界分词器与渲染器

BEV-based世界分词器:将多视图图像编码为连续的BEV表示。具体而言,多视图图像经CLIP图像编码器和BEVFormer处理,得到包含语义和几何信息的BEV特征,再通过下采样块压缩,最终展平为适合LLM输入的特征。

BEV-to-Point渲染器:将压缩的BEV特征转换为场景点云。先通过最近邻插值和卷积将特征上采样,添加高度维度后用3D卷积重建体素特征,再根据数据集的激光雷达设置构建射线,利用可微分体渲染计算每条射线的深度。

可微分体渲染基于隐式符号距离函数(SDF)场,对于射线 ,离散化为采样点 ,通过三线性插值从体素特征中获取局部特征嵌入 ,再用浅层MLP预测SDF值 ,最终渲染深度为:

其中 , 为透射率, 为不透明度(figure 2)。

统一模块

LLM的理解任务:将展平的BEV特征通过两层MLP投影到LLM的特征空间,文本提示被 token 化为文本token,LLM通过自回归下一个token预测,实现场景描述、视觉问答(VQA)等理解任务。

生成任务与世界查询:引入 组世界查询,从BEV特征经最大池化初始化,复制 次后,添加 ego 运动信息和帧嵌入,与展平的BEV特征共享语言空间投影层。经LLM处理后,通过“当前到未来链接”模块(含3个交叉注意力块)生成未来BEV特征,最终由共享渲染器生成未来点云(figure 2)。

训练目标

文本生成损失:采用下一个token预测(NTP),最大化文本token的似然:

点云生成损失:对各射线深度采用L1损失:

总损失为 ,其中 和 为平衡系数。

实验验证

数据集与指标

数据集:采用nuScenes(含700训练场景、150验证场景、150测试场景)、NuInteract(含150万标注)、OmniDrive-nuScenes(含GPT-4标注的VQA数据)。

指标:理解任务用METEOR、CIDEr、ROUGE;生成任务用Chamfer距离(评估点云精度)。

主要结果

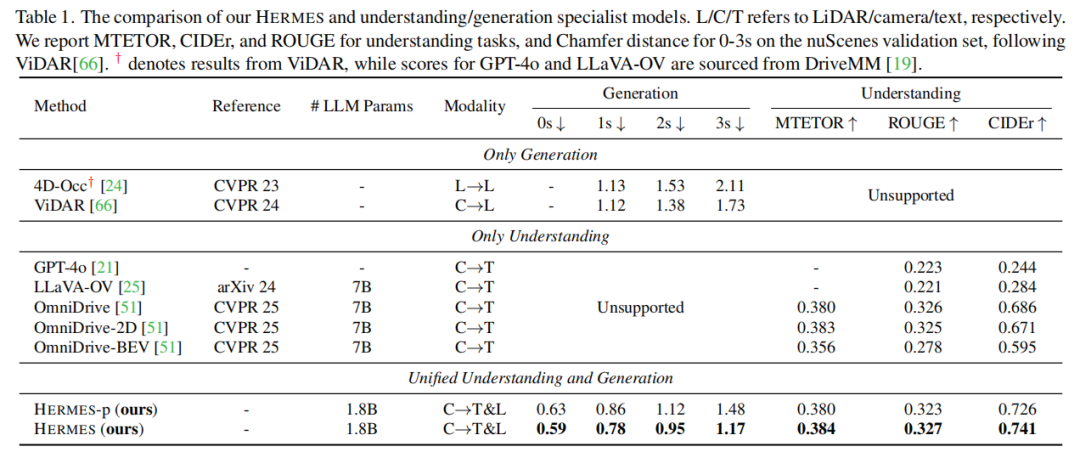

与现有方法对比,HERMES在两任务上均表现优异:生成任务中,3s内的Chamfer距离显著低于4D-Occ和ViDAR;理解任务中,CIDEr指标超过OmniDrive等方法8.0%(table 1)。

消融实验

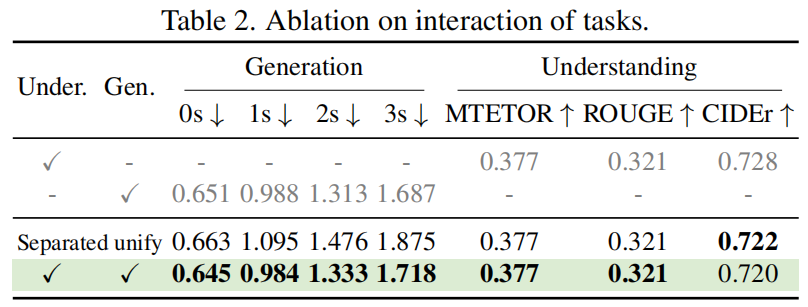

理解与生成交互:统一框架优于单独训练或分离式统一(table 2),证明两者交互的重要性。

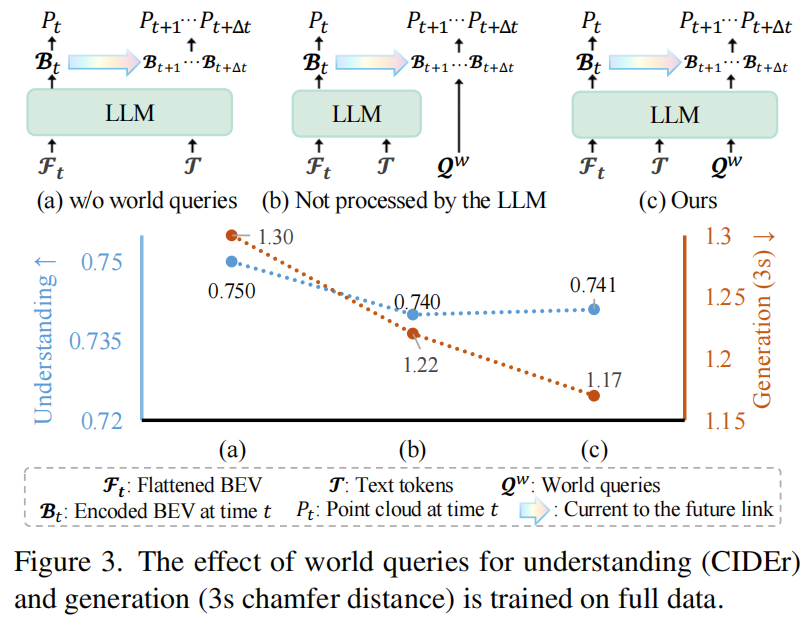

世界查询的作用:引入世界查询使3s点云预测的Chamfer距离降低10%,经LLM处理的查询进一步提升生成性能(figure 3)。

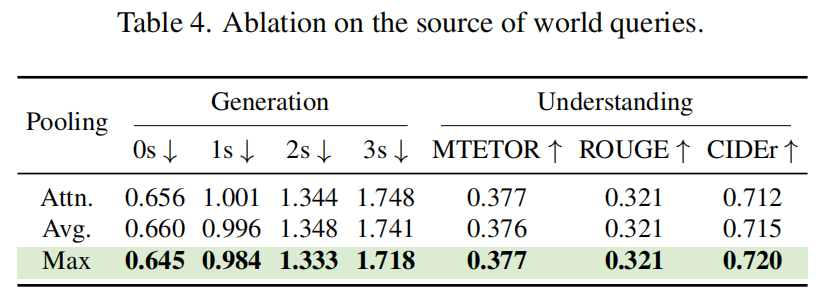

世界查询的来源:从BEV特征经最大池化初始化的查询表现最优,能有效捕捉峰值响应(table 4)。

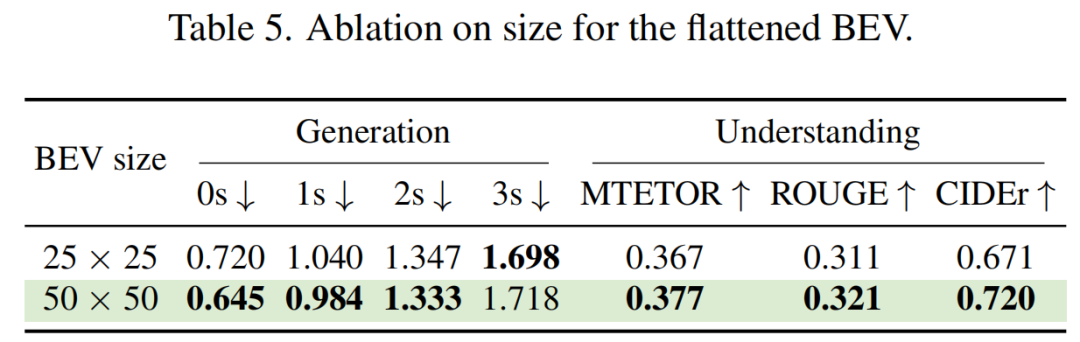

BEV大小:50×50的BEV特征在CIDEr和0s生成上较25×25分别提升7.3%和10%,平衡了信息保留与LLM处理限制(table 5)。

定性结果

在复杂场景中,能准确生成未来点云演化(如跟踪车辆运动),并精准理解场景(如识别“星巴克”等物体),但在复杂转向、遮挡及夜间场景中仍有挑战。

参考

[1]HERMES: A Unified Self-Driving World Model for Simultaneous 3D Scene Understanding and Generation

自动驾驶之心

论文辅导来啦

知识星球交流社区

近4000人的交流社区,近300+自动驾驶公司与科研结构加入!涉及30+自动驾驶技术栈学习路线,从0到一带你入门自动驾驶感知(大模型、端到端自动驾驶、世界模型、仿真闭环、3D检测、车道线、BEV感知、Occupancy、多传感器融合、多传感器标定、目标跟踪)、自动驾驶定位建图(SLAM、高精地图、局部在线地图)、自动驾驶规划控制/轨迹预测等领域技术方案、大模型,更有行业动态和岗位发布!欢迎加入。

独家专业课程

端到端自动驾驶、大模型、VLA、仿真测试、自动驾驶C++、BEV感知、BEV模型部署、BEV目标跟踪、毫米波雷达视觉融合、多传感器标定、多传感器融合、多模态3D目标检测、车道线检测、轨迹预测、在线高精地图、世界模型、点云3D目标检测、目标跟踪、Occupancy、CUDA与TensorRT模型部署、大模型与自动驾驶、NeRF、语义分割、自动驾驶仿真、传感器部署、决策规划、轨迹预测等多个方向学习视频

学习官网:www.zdjszx.com

2494

2494

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?