来源 | 新智元

点击下方卡片,关注“自动驾驶之心”公众号

>>自动驾驶前沿信息获取→自动驾驶之心知识星球

本文只做学术分享,如有侵权,联系删文

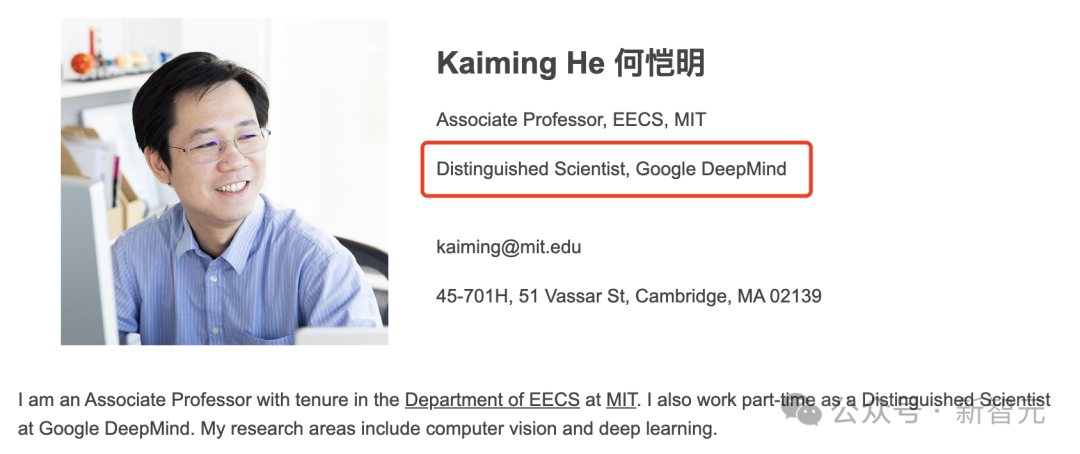

【导读】AI大神何恺明正式入职谷歌DeepMind,担任杰出科学家,同时保留MIT终身副教授身份。从Meta到MIT,再到如今的谷歌,这位「学界+业界」双修的大牛,将为DeepMind的AGI注入一针强心剂。

AI圈炸了!CV大牛何恺明正式官宣入职谷歌。

已更新的个人主页上,明确写着:兼职谷歌DeepMind杰出科学家。

与此同时,他依然保留MIT EECS终身教授的身份。

这位CV领域的传奇人物,因提出ResNet而名震江湖,彻底改变了深度学习的发展轨迹,成为现代AI模型的基石。

如今,这位「学界+业界」双轨并行的跨界大神,再次用行动证明了他的无限可能!

对于谷歌DeepMind而言,何恺明的加入更是如虎添翼。

他的技术专长,涵盖了计算机视觉、深度学习等核心领域,学术影响力在全球范围内有目共睹。

Demis Hassabis曾公开表示,AGI可能在未来5-10年内实现。

何恺明的到来,无疑将助力这一终极目标的加速实现。

欢迎加入国内最大的自动驾驶技术分享、求职交流、行业问答社区 — 『自动驾驶之心知识星球』

新人大额优惠!欢迎加入技术最前沿~

ResNet之父再跨界,DeepMind迎超级大脑

何恺明曾是微软亚研院研究院、Meta「明星实验室」FAIR的研究科学家,专注的研究领域包括深度学习和计算机视觉。

通过计算机视觉问题的视角,致力于开发适用于各种领域的通用方法。

在正式入职此之前,便早有消息传出何恺明要跨入学术界。

尤其是,他于23年3月在MIT进行的Job talks(求职演讲),更加坐实了这一消息。

他目前的研究重点聚焦在建立一个计算机模型,以便从复杂的世界中学习表征并开发智能。

长期目标是,用能力更强的人工智能来增强人类智能。

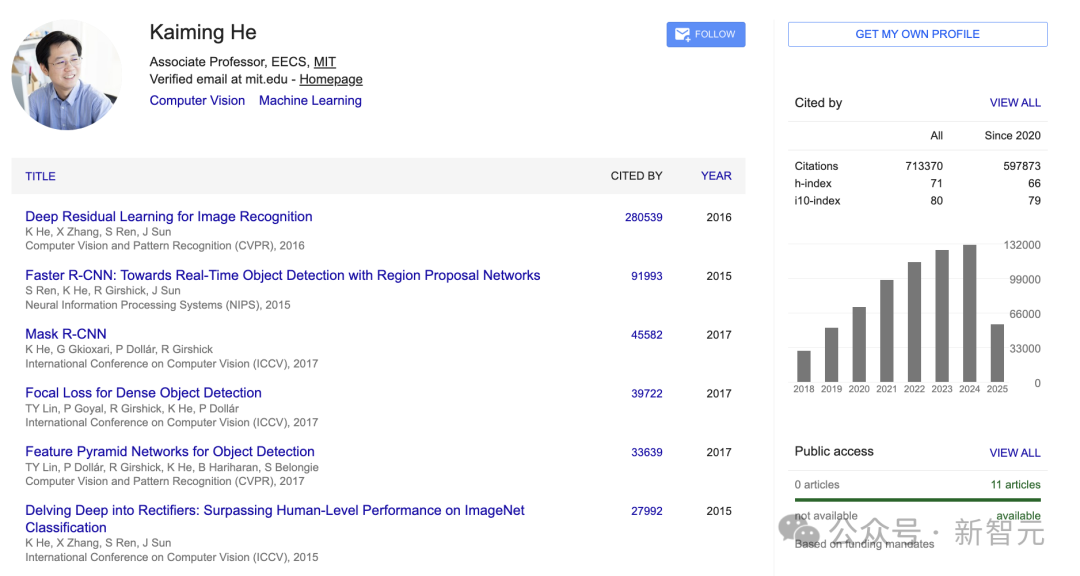

同时,他在计算机视觉和深度学习领域发表了一系列极具影响力的论文。截至目前,他的论文被引用次数超过71万次。

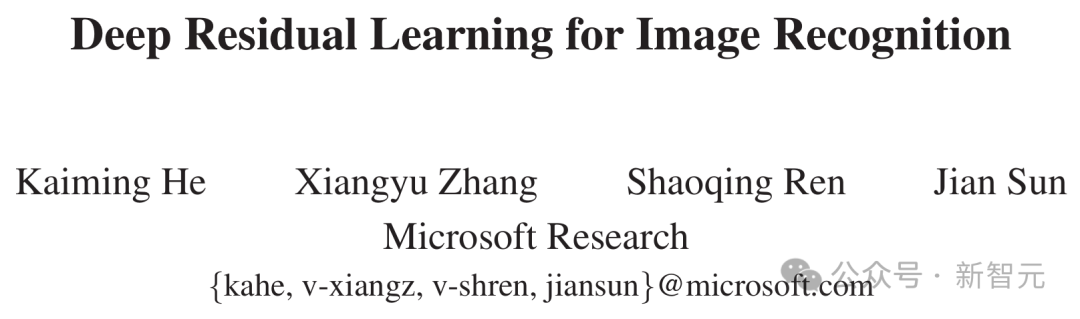

何恺明关于深度残差网络(ResNet)的论文是谷歌学术指标2019年、2020年和2021年,所有研究领域中被引用次数最多的论文。

论文地址:https://openaccess.thecvf.com/content_cvpr_2016/papers/He_Deep_Residual_Learning_CVPR_2016_paper.pdf

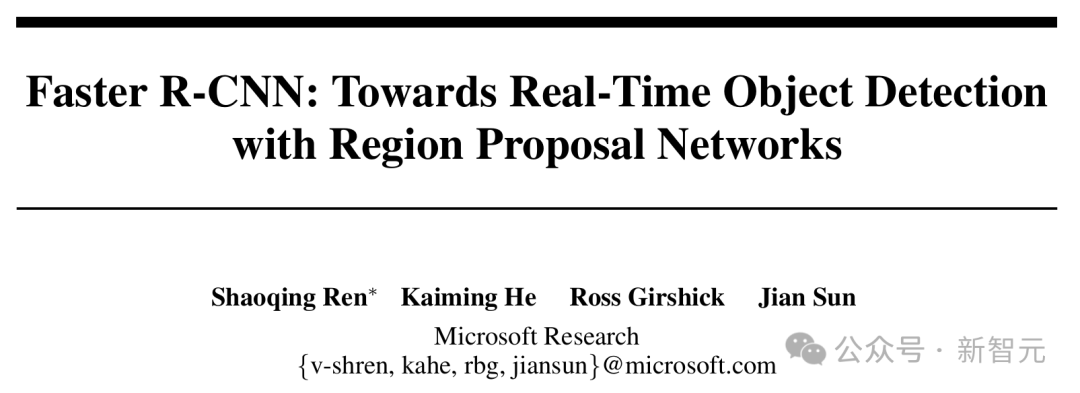

另外,他在视觉物体检测和分割方面的研究成果,包括Faster R-CNN和Mask R-CNN,也都产生了重大影响,同样是这些领域被引用次数最多的论文之一。

论文地址:https://proceedings.neurips.cc/paper_files/paper/2015/file/14bfa6bb14875e45bba028a21ed38046-Paper.pdf

论文地址:https://openaccess.thecvf.com/content_ICCV_2017/papers/He_Mask_R-CNN_ICCV_2017_paper.pdf

2009年,何恺明成为首获计算机视觉领域三大国际会议之一CVPR「最佳论文奖」的中国学者。

作为第一作者,他还获得了CVPR 2009,CVPR 2016和ICCV 2017(Marr Prize)的最佳论文奖,并获得了ICCV 2017最佳学生论文奖。

2017年4月,何恺明曾获选香港中文大学(中大)工程学院杰出校友。

同时,他也是领域内多个著名奖项的获得者,包括2018年PAMI青年研究员奖,2018年ECCV、2021年CVPR最佳论文荣誉奖,以及2021年 ICCV Everingham奖。

从高考状元到业界大神

何恺明是广东人,在广州执信中学读书时曾获得全国物理竞赛和省化学竞赛的一等奖。

2003年5月,何恺明获得保送清华的资格,但是他依然参加了高考并且以满分900分的成绩,成为当年广东省9位满分状元之一。

进入清华大学以后,何恺明放弃保送的机械工程及其自动化专业,进入了基础科学班。

他在本科还没有毕业的时候,就进入了微软亚洲研究院实习。出于对于计算机视觉的兴趣,他选择加入了计算机视觉组。

在2007年获得了清华大学学士学位之后,4年时间就拿到了香港中文大学的博士学位。

在2016年加入FAIR之前,何恺明于2011年至2016年在微软亚洲研究院(MSRA)担任研究员。

他的第一篇CVPR获奖论文就发表于在微软亚洲研究院工作期间。

今年的成果

何恺明在研究界,每隔一段时间就会带来新的成果,更新频率非常快。

前段时间,他还联手Yann LeCun共同发现了一种没有归一化层的Transformer,仅用9行代码就实现了。

值得一提的是,这篇研究还被CVPR 2025录用。

论文地址:https://arxiv.org/abs/2503.10622

项目地址:https://github.com/jiachenzhu/DyT

今年2月,他带队将大自然中的「分形」概念注入AI,提出了「分形生成模型」(fractal generative models)。

并且,在像素级图像生成上,团队验证了新方法的强大——

首次将逐像素建模的精细分辨率的计算效率,提升了4000倍。

论文地址:https://arxiv.org/abs/2502.17437

上个月,何恺明又联手CMU团队,提出了系统且高效的一步生成建模框架MeanFlow,无需预训练就能让AI生图一步到位。

论文地址:https://arxiv.org/abs/2505.13447

他的研究经验的创新能力,将为谷歌DeepMind未来大模型研发注入更多的可能和动力。

参考资料:

https://people.csail.mit.edu/kaiming/

自动驾驶之心

论文辅导来啦

知识星球交流社区

近4000人的交流社区,近300+自动驾驶公司与科研结构加入!涉及30+自动驾驶技术栈学习路线,从0到一带你入门自动驾驶感知(大模型、端到端自动驾驶、世界模型、仿真闭环、3D检测、车道线、BEV感知、Occupancy、多传感器融合、多传感器标定、目标跟踪)、自动驾驶定位建图(SLAM、高精地图、局部在线地图)、自动驾驶规划控制/轨迹预测等领域技术方案、大模型,更有行业动态和岗位发布!欢迎加入。

独家专业课程

端到端自动驾驶、大模型、VLA、仿真测试、自动驾驶C++、BEV感知、BEV模型部署、BEV目标跟踪、毫米波雷达视觉融合、多传感器标定、多传感器融合、多模态3D目标检测、车道线检测、轨迹预测、在线高精地图、世界模型、点云3D目标检测、目标跟踪、Occupancy、CUDA与TensorRT模型部署、大模型与自动驾驶、NeRF、语义分割、自动驾驶仿真、传感器部署、决策规划、轨迹预测等多个方向学习视频

学习官网:www.zdjszx.com

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?