作者 | 山丘 来源 | 焉知汽车

点击下方卡片,关注“自动驾驶之心”公众号

>>点击进入→自动驾驶之心『自动驾驶』技术交流群

本文只做学术分享,如有侵权,联系删文

在如今智能驾驶席卷汽车行业的背景下,大家对“摄像头”这个词早已耳熟能详。很多宣传中甚至暗示,车载摄像头越多,车辆就越智能。事实上,不只是汽车,摄像头几乎已经渗透进我们生活的各个角落:手机、电脑、小区监控、智能门铃……如今要找一个没有摄像头的场景,反而变得越来越难。

然而,尽管我们对摄像头如此熟悉,但若问起它的工作原理,恐怕许多人仍会感到陌生。摄像头究竟是如何“看见”世界的?它输出的是什么信号?在这些数据送入AI模型之前,又经历了哪些处理?本文将带你一起拆解摄像头背后的工作机制,看看它是如何看见东西的。

图1:既熟悉又陌生的摄像头示意图

看得见摸得着的摄像头器件拆解

我们不妨从最直观、最“看得见摸得着”的地方开始看看车载摄像头都有哪些关键组成部分?

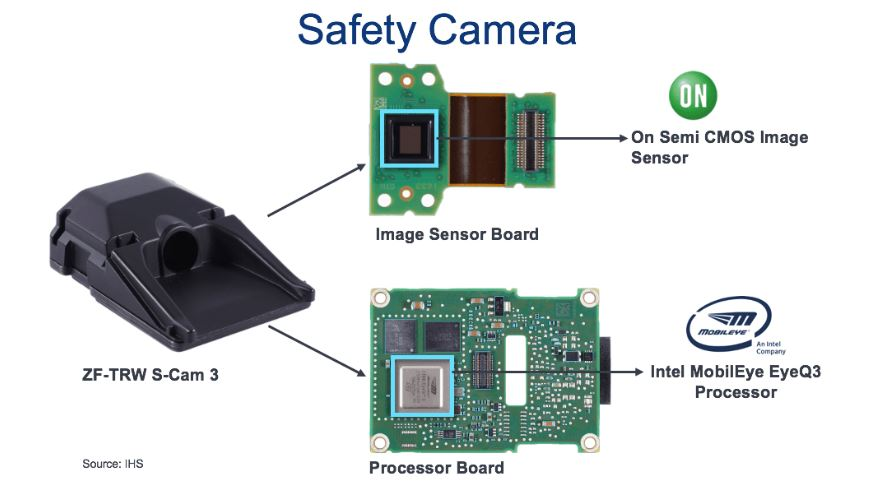

以下图中的ZF车载摄像头为例,其内部结构主要由光学组件和两块核心电路板(PCB)构成。前端是镜头和图像传感器,属于“光学传感本体”;后端则是负责信号处理的ISP模块。

其中,图像传感器的作用是将光信号转换为电信号,属于核心的感知部件。示例中采用的是安森美的CMOS传感器。

后端的信号处理器则承担着“看得清”的任务,对原始图像进行一系列处理和优化。例子中使用的是Mobileye芯片,它不仅具备图像信号处理功能,还集成了目标识别、追踪等功能算法。

图2:车载摄像头示意图

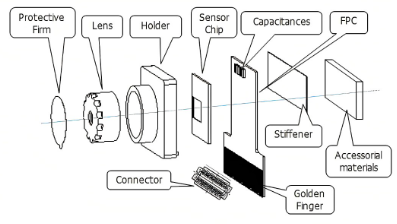

位于图像传感器之上的,是一套精密的光学结构,包括保护片、镜头以及镜头支架等,确保光线经过必要的聚焦和过滤,最终准确地落在图像传感器表面,为后续成像打下基础。

图3:镜头与图像传感器位置关系示意图

图像传感器怎么“看得见”

我们再来看看图像传感器的微观原理结构,这对于我们理解摄像头为什么能看到东西很重要。

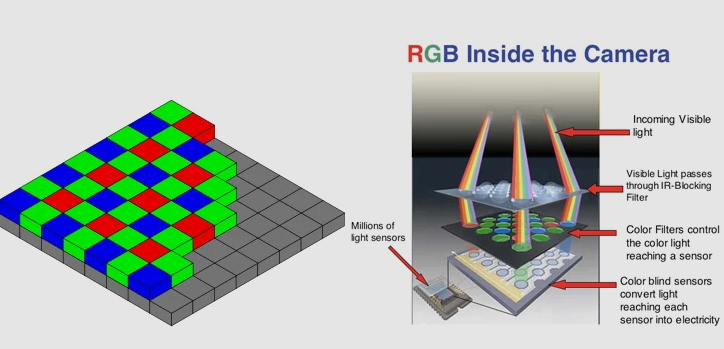

如下图4左侧所示,图像传感器其实像棋盘一样,划分了许多纵横交错的感光单元。每一个微小的感光单元就是我们常说的“像素”。譬如长3264个小单元,高2448个小单元的图像传感器,就有大概800万个像素。我们常说的200万像素、1000万像素摄像头就是指的对应的最小感光单元的数量。当然,像素越多,图像的分辨率就越高。

如下图 4右侧所示,当光子透过镜头进入到传感器时,首先会经过两层滤光层,然后才会到达将光信号转换为电信号的半导体感应层。

为什么需要两层滤光呢?

因为光电传感本质上依靠的是半导体的光电效应,即“光生电”。但这个效应中电的强弱主要由光强决定,对光的波长(对应我们感知的颜色)并不敏感,所以第一层需要把红外线和紫外线等肉眼不感知的光去掉,留下我们感兴趣的光。

而在可见光中,我们知道可以通过红蓝绿等原色来合成各种不同颜色。但是一个像素内的感光元件只能感知一种光强,也就是只有一个通道,那怎么办呢?柯达公司的工程师Bryce Bayer ,也就是拜耳阵列的发明人,想到了一种解决方案(Bayer pattern)。他将田字形的4个像素划为一组,在感光原件之上分别部署1个蓝色,1个红色和2个绿色的滤光片,这样每个像素就能获取到单一原色的光强。基于这个规律的设计,后续在信号处理时就可以通过插值近似还原每个像素点上的三原色分布。那为什么4个格子里,绿色独占一半呢?因为人眼对绿色最为敏感,所以如此“偏心”。而这个花花绿绿的分布,有没有觉得眼熟?没错,就是“马赛克”。

图4:图像传感器工作原理示意图

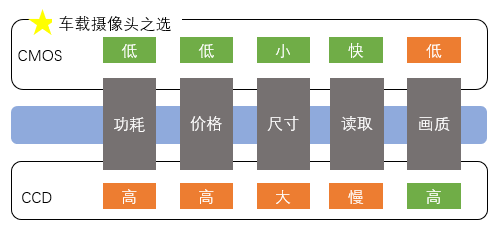

在每个像素里的感光元件,则主要有两种类型:CCD和CMOS。这两者其实都用到MOS技术,CCD的核心元件是MOS电容,而CMOS的核心元件则是MOSFET放大器。二者的主要区别是CCD在每个像素内产生电荷,传递到边缘之后再统一做放大处理,而CMOS则是在每个像素内进行电流放大。

类比一下,CCD就像是每个员工把自己工作做好之后报告给组长,组长再整理成大报告给经理,这样当然内容精炼、格式一致,报告质量较高,但是沟通效率和生产成本就较高。而CMOS就像是每个员工做好工作之后,直接提炼内容汇报给老板,这样会加快读取速度,降低沟通成本,但难免因为员工素质的参差不齐,影响汇报质量。

CCD和CMOS的对比如下图所示,在车载摄像头和手机摄像头等对功耗、尺寸、成本都敏感的使用场景下,CMOS图像传感器成为了主流选择。

图5:CCD和CMOS差异比较

ISP(图像信号处理)的架构拆解

经过图像传感器的光电转换和数模转换,现在图像传感器已经能按像素输出图像的原始信号了,然后每秒传出若干帧图像,就能串成动画,形成视频了。但需知道,这些原始图像有很多“瑕疵”,与我们肉眼所见相距甚远,可以理解为“毛坯”图像。必须经过一系列流水线般的图像信号处理,才能看清图像。接下来,我们就来看看常见的ISP都经历了什么处理。

第 1 步:黑电平校正(Black Level Correction)

本质是传感器“调零”。即使在黑暗中拍照,图像传感器也会输出非零电压(黑电平)。这一步是把“黑设为黑”。就像拍一张漆黑的照片,但画面底色却发灰。我们要先把底色擦干净。

第 2 步:镜头阴影校正(Lens Shading Correction)

镜头中间亮、边缘暗(光学特性导致)。这一步用增益让画面更均匀。就像用手电筒照地面,中间亮四周暗。我们要“补光”四周让画面一致。

第 3 步:坏点修复(Bad Pixel Correction)

图像传感器上不排除有一些像素坏了:一直亮、一直黑或数值异常,需修补。就像修复照片上的“灰尘点”,用周围颜色“抹掉”。

第 4 步:去马赛克(Demosaicing)

上文提到例如Bayer Pattern 用RGGB的阵列滤光形成了颜色马赛克,每个像素只有一个通道的颜色,我们要插值补全另两个颜色。就像拼图只给了红色碎片,我们要推测并拼出完整的彩色图像。

第 5 步:白平衡(Auto White Balance)

不同光源下(如黄光、蓝光)相同物体的颜色会有偏差。白平衡会让白色看起来始终是白的。就像一张白纸,在灯泡光下发黄,在日光下发蓝。白平衡就是纠正这种“偏色”。

第 6 步:颜色校正矩阵(Color Correction Matrix)

图像传感器原始颜色和真实颜色有不一致。用矩阵映射修正颜色偏差。就像图像传感器拍出来的红色可能发紫。颜色校正矩阵能把它拉回真正的“正红色”。

第 7 步:局部色调映射(Local Tone Mapping)

增强画面局部对比度,让暗部/亮部细节更清晰,画面更立体。说白就是暗处拉亮,亮处压低,细节更丰富。

第 8 步:噪声去除(Noise Reduction)

图像尤其在夜间会有颗粒感,需要降低噪声同时保留细节。就像在沙沙作响的录音里降噪,但又不能让声音变得模糊。

第 9 步:高动态范围合成(High Dynamic Range Merge)

为了亮部不过曝,暗部有细节。可以用多张不同曝光的图像融合出更高的动态范围。近年也有从图像传感器端完成动态范围合成的技术。比如车从隧道冲出来:既要看到隧道内黑暗处,又要看到出口的强光。高动态范围合成就能帮我们两全其美。

第 10 步:伽马校正(Gamma Correction)

人眼对亮度不是线性感知的,伽马校正是为了让显示出来的图像更符合人眼视觉。这一步就是做非线性处理,让图片看起来更“自然”。

第 11 步:锐化(Sharpening)

增强边缘细节,提升图像清晰度,让车道线、交通标志更明显。就像模糊照片加描边处理,轮廓更清晰,适合感知模型用。

第 12 步:颜色空间转换(Color Space Conversion)

将 RGB 转换为 YUV 等编码格式,以供视频压缩、显示或感知算法使用。RGB 是“显示友好”,YUV 是“压缩友好”,比如视频编码就常用 YUV420 格式。

当然每个实际产品应用中ISP的步骤都有所不同,会基于传感器型号、目标应用(例如给车机大屏显示还是给AI模型处理等)作相应调整。这些步骤里面,对辅助驾驶尤为重要的主要是下面三个,我们通过效果图进一步感受:

(1)高动态范围合成+局部色调映射。因为隧道、高架逆光场景多,必须同时看到暗部行人、亮部车道。

图6:高动态范围和局部色调映射处理示意图(左:处理前;右:处理后)

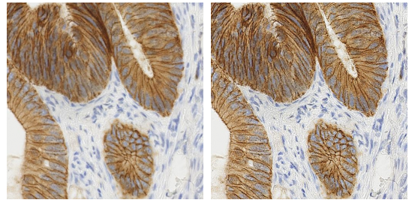

(2)降噪 + 锐化。因为这对夜间图像清晰度至关重要,直接影响夜间车道线识别、物体检测的性能。

图7:降噪和锐化示意图(左:处理前;右:处理后)

(3)白平衡+颜色校正矩阵。因为现在辅助驾驶一般同时使用多路摄像头,这处理可以保证多摄像头标定的一致性,否则会影响立体匹配和感知模型训练。

图8:白平衡和颜色校正示意图(左:处理前;右:处理后)

前端模组和ISP之间的传输

前面我们探讨完图像传感器和ISP,明白了“看得见”和“看得清”两部分。那么问题来了,这两部分之间怎么连接?

最直接的方法就是用一根高速线把它们连接起来。最常用的传输方式就是MIPI CSI-2(Camera Serial Interface 2),这是一种高速串行接口,由MIPI联盟定义。对于智能摄像头系统,前端摄像头模组和ISP处理芯片都集成在一个系统控制器里的方案,这就可以了。

但随着辅助驾驶技术的发展,越来越多的方案采用了多个边缘摄像头模组布置在车身的不同位置,然后再把图像传感器的数据传输到例如后备箱下方的中央控制器再进行处理。这种情况下,前端传感器模组和后端ISP之间的传输距离会多达几米,直接使用MIPI CSI-2线缆传输会让信号衰减严重,无法可靠传输。为此,我们引入 SerDes(串行器/解串器) 进行如下处理:

(1)串行器(Serializer):把来自摄像头模组的MIPI并行或低速串行数据转换成高速串行信号(如 GMSL、FPD-Link)。

(2)高速传输:使用汽车专用长距离高速线缆(如同轴线或屏蔽双绞线)进行远距离传输。

(3)解串器(Deserializer):在ISP端(即域控内部)将高速串行信号还原为MIPI CSI-2格式,供ISP处理。

总的来说,就是如果摄像头离处理器很近(在同一个控制器里),直接用 MIPI;如果摄像头离处理器很远(不在一个控制器里),就需要串行解串技术来传输。

当下行业动态

随着汽车智能化程度不断提升,车载摄像头作为环境感知的核心传感器之一,其装机量与技术要求正同步提升。根据Strategy Analytics 等机构预测,2025年全球车载摄像头出货量将突破6亿颗,中国市场占比超40%,成为全球最大单一市场。

在L2++、DMS、APA 等多场景推动下,中国新车平均摄像头装机量正由6颗迈向10颗以上。摄像头不仅数量增加,类型也从单一的后视演进至全车多点部署,广泛覆盖感知、安全与交互等核心环节。过去行业核心技术长期由日、美企业主导,但近年来中国本土厂商在多个节点上实现快速突破,已经逐步建立起完整自主的供应链体系。

在光学镜头环节,舜宇光学处于全球领先地位,具备完整车规量产与系统能力。其他厂商如联合光电、福晶科技也在加快布局,推动国产渗透率提升。

CMOS图像传感器领域则由豪威科技领衔,其产品在前视、环视、DMS等场景已实现量产,市场占有率已经全球前三。格科微、思特威等新势力正布局中低端细分市场。

ISP芯片环节仍以地平线、黑芝麻、英伟达、高通、安霸等为主,国产尚处追赶阶段,但已经有许多产品上车量产落地。

对我们汽车从业者来说,这无疑是利好。同时我们也要抓住机遇,尤其是多接触理解上下游技术,通过“跨界”来提升自己的竞争力。例如做图像处理的,不仅要调得好,还可以“懂算法”,多学点前端AI处理、视觉增强算法,与感知工程师沟通时就更有话语权。做销售的,也可以从客户的技术痛点出发,讲场景、通技术,做一个方案型销售。中国车载摄像头产业正在经历从“量变”到“质变”的关键阶段。不管你是研发工程师、产品经理,还是关注辅助驾驶的从业者,都别错过这场国产崛起的黄金窗口。

自动驾驶之心

论文辅导来啦

知识星球交流社区

近4000人的交流社区,近300+自动驾驶公司与科研结构加入!涉及30+自动驾驶技术栈学习路线,从0到一带你入门自动驾驶感知(大模型、端到端自动驾驶、世界模型、仿真闭环、3D检测、车道线、BEV感知、Occupancy、多传感器融合、多传感器标定、目标跟踪)、自动驾驶定位建图(SLAM、高精地图、局部在线地图)、自动驾驶规划控制/轨迹预测等领域技术方案、大模型,更有行业动态和岗位发布!欢迎加入。

独家专业课程

端到端自动驾驶、大模型、VLA、仿真测试、自动驾驶C++、BEV感知、BEV模型部署、BEV目标跟踪、毫米波雷达视觉融合、多传感器标定、多传感器融合、多模态3D目标检测、车道线检测、轨迹预测、在线高精地图、世界模型、点云3D目标检测、目标跟踪、Occupancy、CUDA与TensorRT模型部署、大模型与自动驾驶、NeRF、语义分割、自动驾驶仿真、传感器部署、决策规划、轨迹预测等多个方向学习视频

学习官网:www.zdjszx.com

3546

3546

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?