点击下方卡片,关注“自动驾驶之心”公众号

戳我-> 领取自动驾驶近15个方向学习路线

今天自动驾驶之心为大家分享智加科技最新端到端自动驾驶的工作!深入剖析了感知任务在端到端中的必要性。如果您有相关工作需要分享,请在文末联系我们!

自动驾驶课程学习与技术交流群事宜,也欢迎添加小助理微信AIDriver004做进一步咨询

论文作者 | Peidong Li

编辑 | 自动驾驶之心

写在前面 & 笔者的个人理解

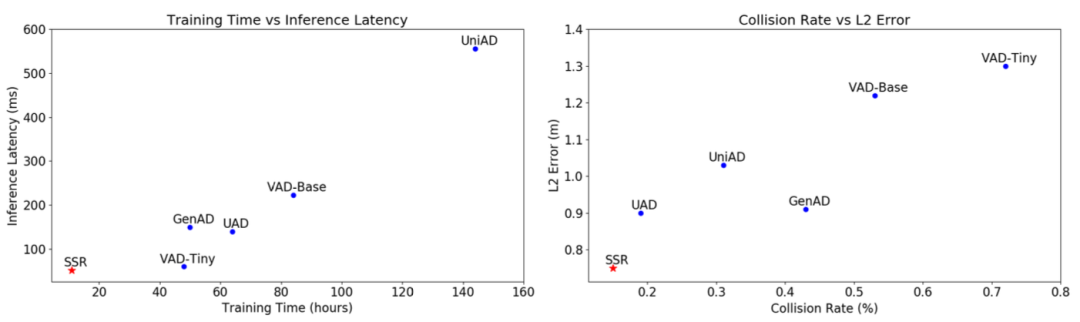

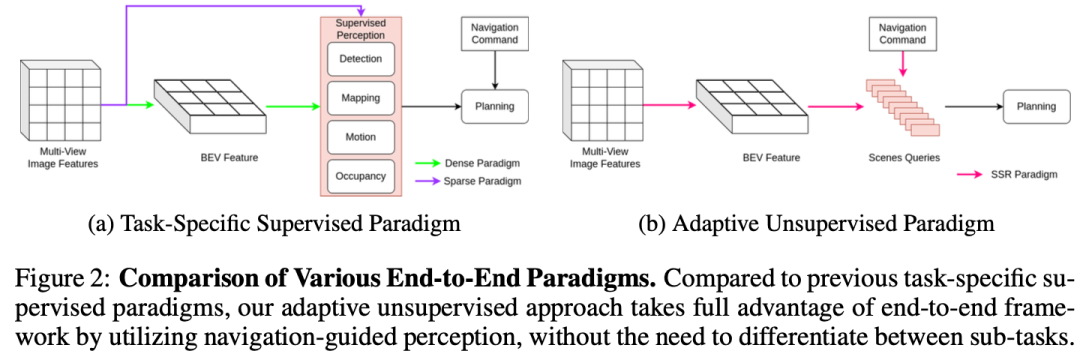

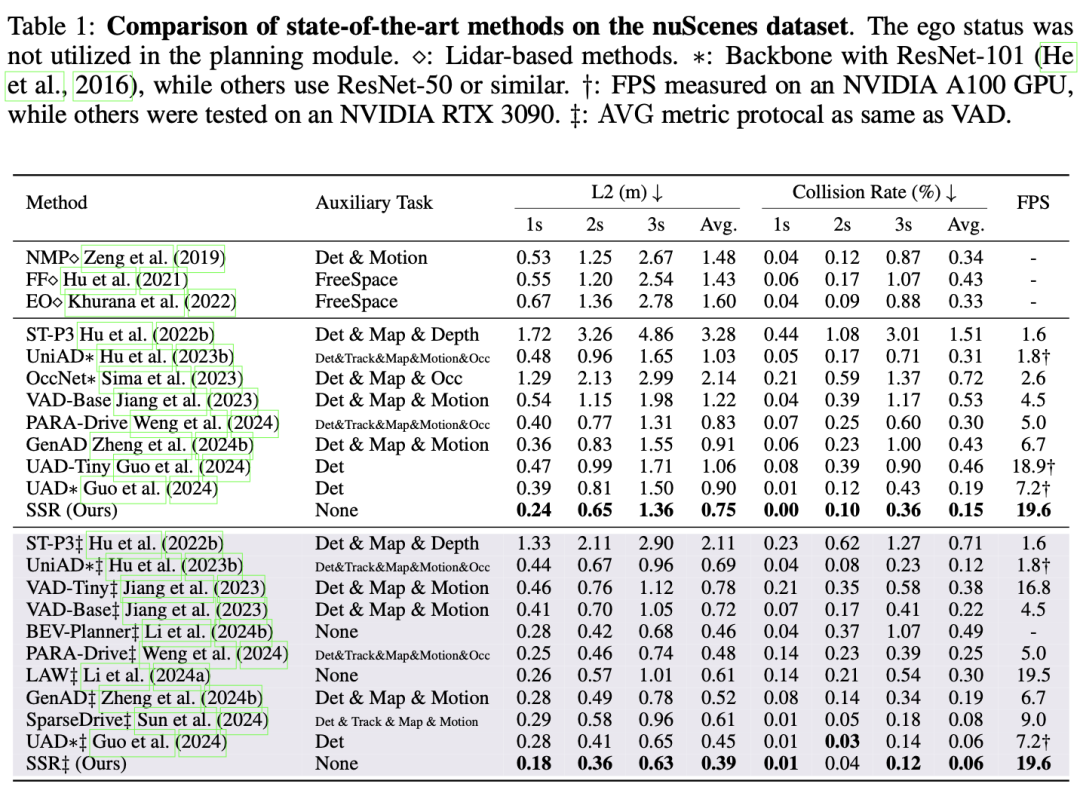

端到端自动驾驶(E2EAD)方法通常依赖于监督感知任务来提取明确的场景信息(例如,动静态目标、在线地图)。而这种依赖性需要昂贵的标注数据,并限制了实车部署和数据可扩展性。为此本文介绍了SSR,这是一种全新的框架,只使用16个导航引导标记作为稀疏场景表示,有效地提取了E2EAD的关键场景信息。本文的方法消除了对监督子任务的需要,允许计算资源集中在与导航意图直接相关的基本元素上。进一步引入了一个时间增强模块,该模块采用鸟瞰图(BEV)世界模型,通过自监督将预测的未来场景与实际的未来场景对齐。SSR在nuScenes数据集上实现了最先进的规划性能,与UniAD相比,L2误差相对降低了27.2%,碰撞率降低了51.6%。此外,SSR推理加速了10.9倍,训练加速了13倍。该框架代表了实时自动驾驶系统的重大飞跃,并为未来的可扩展部署铺平了道路。

开源链接:https://github.com/PeidongLi/SSR

总结来说,本文的主要贡献如下:

我们介绍了一种受人类启发的E2EAD框架,该框架利用由导航命令引导的学习稀疏查询表示,通过自适应地关注场景的基本部分,显著降低了计算成本。

我们通过引入BEV世界模型对动态场景变化进行自监督,消除了对昂贵的感知任务监督的需要,强调了时间背景在自动驾驶中的关键作用。

我们的framework在nuScenes数据集上以最小的训练和推理成本实现了最先进的性能,为实时E2EAD建立了新的基准。

相关工作回顾

基于视觉的端到端方案

端到端自动驾驶的研究可以追溯到1988年的ALVINN(Pomerleau,1988),该研究使用了一个简单的神经网络来生成转向输出。NVIDIA开发了一种基于卷积神经网络(CNN)的原型E2E系统,绕过了手动分解。最近基于视觉的E2EAD的复苏是由BEV感知的快速发展和Transformer等现代架构推动的。

ST-P3引入了感知、预测和规划模块的改进,以增强时空特征学习,整合了深度估计和BEV分割等辅助任务。UniAD基于之前的BEV感知工作,创建了一个具有各种辅助任务的级联框架,包括检测、跟踪、映射、占用和运动估计。VAD试图通过矢量化简化场景表示,减少UniAD中的跟踪和占用任务。GenAD探索了使用生成模型生成轨迹,基于VAD联合优化运动和规划头。PARA Drive进一步研究了辅助任务之间的关系,重新组织它们并行运行,同时在推理过程中停用它们。相比之下,我们的方法消除了所有感知任务,在准确性和效率方面都取得了显著的成绩。

自动驾驶中的场景表示

大多数先前在自动驾驶领域的工作都继承了感知任务的方法,如Li等人利用密集的BEV特征作为主要的场景表示。在这些框架中,特定于任务的查询(例如,用于检测和建图)用于在人工标签的监督下从BEV特征中提取信息。虽然这些方法受益于丰富的场景信息,但它们也引入了显著的模型复杂性,阻碍了实时应用,特别是在基于占用的表示中。

遵循BEV检测中稀疏范式的趋势,最近的稀疏E2EAD方法直接利用特定任务的查询与图像特征进行交互。这些方法试图通过特定任务的查询直接与图像特征交互,从而完全绕过BEV特征生成。然而,尽管BEV处理减少了,但这些模型仍然依赖于数百个查询,这降低了端到端范式所承诺的简单性和效率。LAW提出使用视图潜在查询来用单个查询表示每个相机图像。然而,这种方法会损害信息保真度,导致性能欠佳。UAD试图将BEV特征划分为角度方向的扇区,但仍然依赖于开放集检测器标签进行监督,保持了特定任务查询的复杂性。在这项工作中,我们引入了SSR,这是一种新的方法,通过一组最小的自适应学习查询来表示场景,提高了效率和性能。

自动驾驶中的世界模型

世界模型因其生成能力而在自动驾驶领域受到关注,尤其是近年来。世界模型的重要性在于生成丰富的训练数据,包括罕见的角点情况,正如Hu等人等早期作品所证明的那样。最近,世界模型已被集成到E2EAD框架中,以提高其性能。例如,Drive WM采用扩散模型来预测多视图视频,并将这些预测用于规划。OccWorld同时预测规划轨迹和占用图,而DriveWorld使用占用世界模型进行预训练,需要昂贵的注释。LAW引入了一个潜在世界模型来改进E2EAD训练。在我们的工作中,我们提出了一个为稀疏场景表示量身定制的BEV世界模型,有效地编码时间上下文以提高E2EAD性能。

方法详解

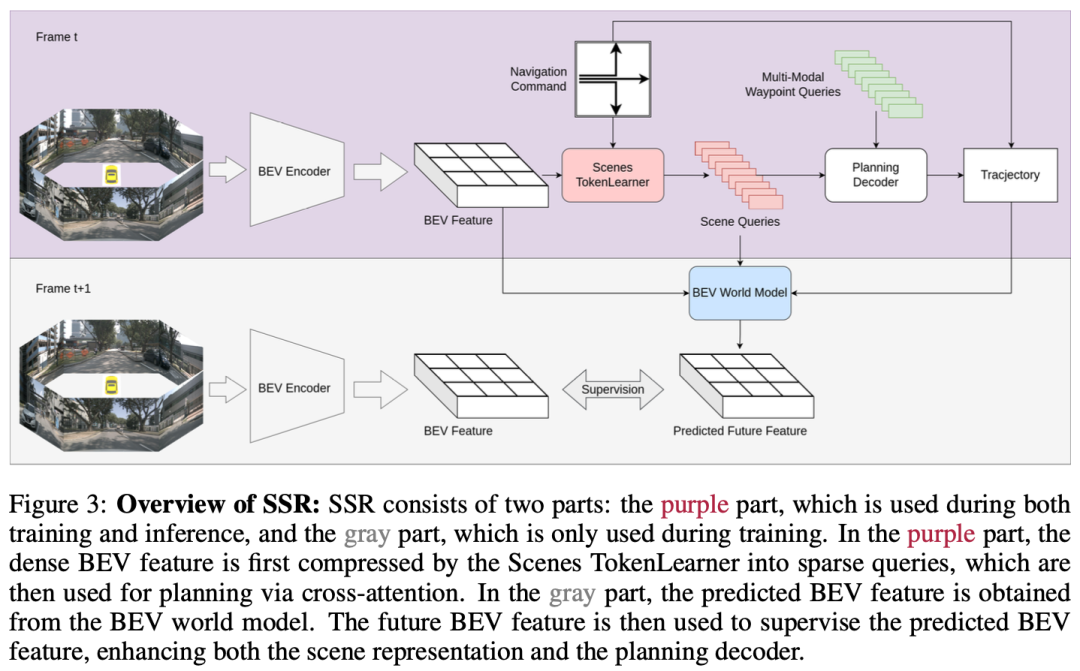

本文提出的方法框架图入下所示:

导航引导下的场景token学习器

BEV特征是一种流行的场景表示,因为它们包含丰富的感知信息。然而,这种密集的表示增加了搜索相关感知元素时的推理时间。为了解决这个问题,我们引入了一种使用自适应空间注意力的稀疏场景表示,在保持高保真场景理解的同时显著降低了计算负荷。

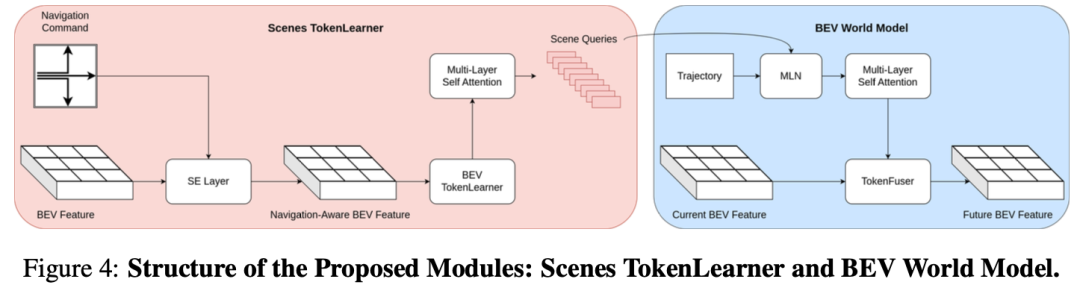

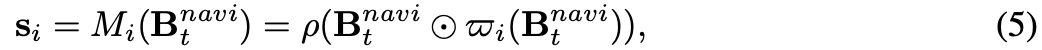

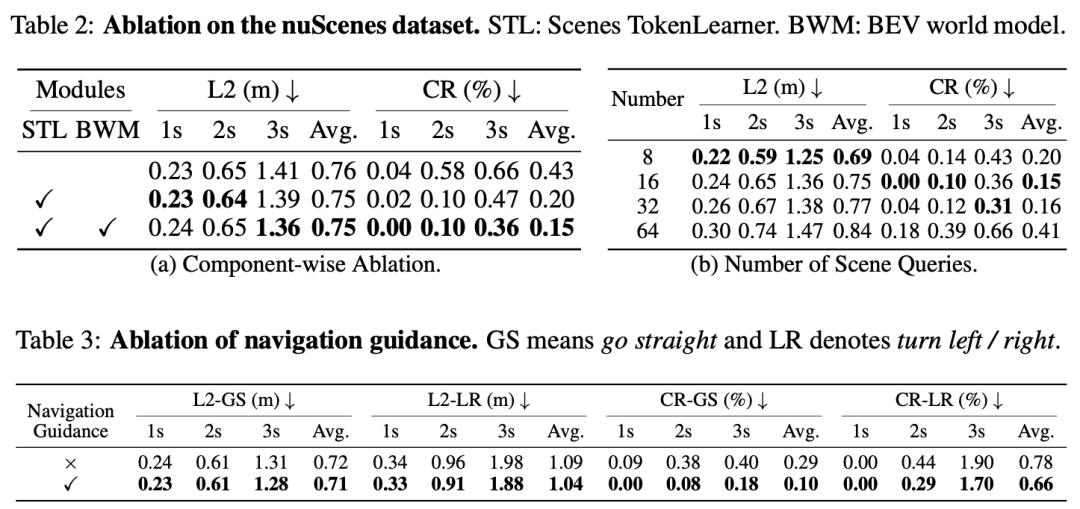

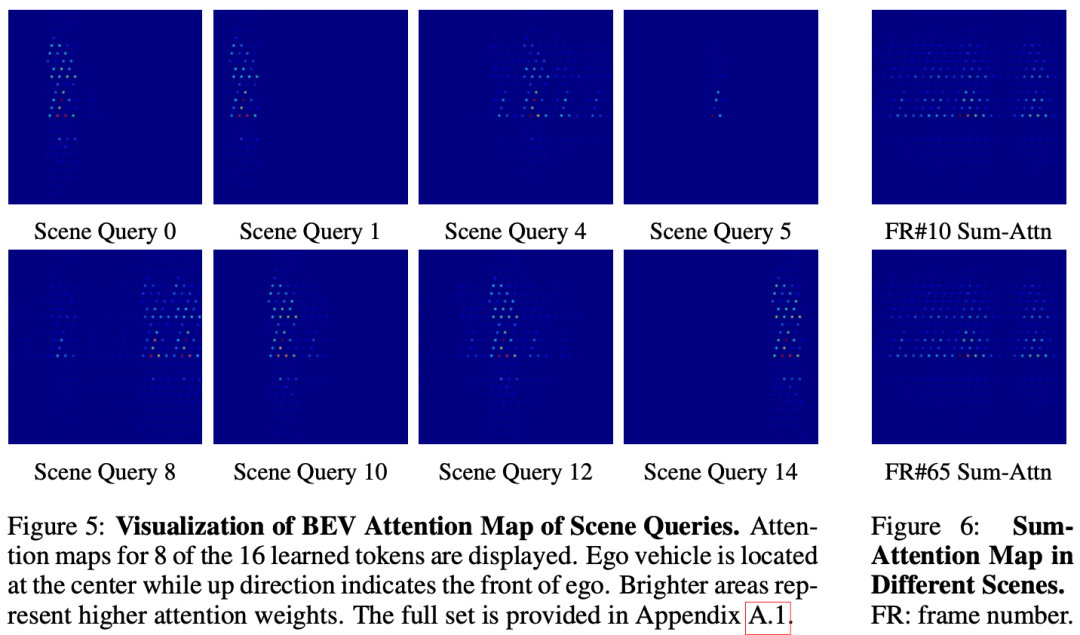

具体来说,我们提出了场景令牌学习器(STL)模块,用于从BEV特征中提取场景查询,以有效地表示场景。Scenes TokenLearner的结构如图4所示。为了更好地关注与导航意图相关的场景信息,我们采用挤压和激励(SE)层将导航命令cmd编码为密集的BEV特征,从而输出导航感知BEV特征:

然后将导航感知BEV特征传递给BEV TokenLearner模块TLBEV,以自适应地关注最重要的信息。与TokenLearner在图像或视频领域的先前应用不同,我们在BEV空间中利用它通过空间注意力来推导稀疏场景表示:

tokenizer预测形状为H×W×1的空间注意力图,学习到的场景标记是通过global average pooling获得的:

使用多层自注意力进一步增强场景查询:

基于稀疏场景表示的规划

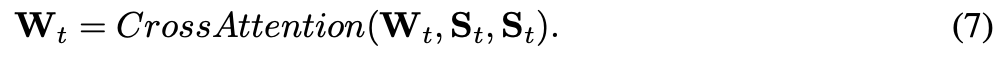

由于St包含所有相关的感知信息,我们使用一组路点查询来提取多模态规划轨迹:

然后使用多层感知器(MLP)从Wt获得预测轨迹,并根据导航命令cmd选择输出轨迹:

输出轨迹由地面真实(GT)轨迹TGT使用L1损失进行监督,L1损失定义为模仿损失:

基于BEV-WORLD模型的时间增强

我们优先考虑时间上下文,通过世界模型而不是感知子任务来增强场景表示。这个模块背后的动机很简单:如果我们预测的动作与实际动作相对应,那么预测的未来场景应该与实际的未来场景非常相似。

如图4所示,我们引入了BEV世界模型(BWM)来预测未来的BEV特征。首先,我们使用输出轨迹T,使用运动感知层归一化(MLN)将当前场景查询转换为未来帧。MLN模块帮助当前场景查询对运动信息进行编码,输出期望的查询Dt:

对于期望的查询Dt,我们应用多层自注意力作为世界模型来预测未来的场景查询:

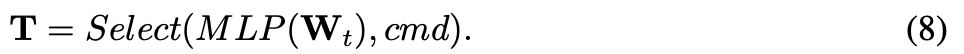

然而,由于自动驾驶系统即使在连续的帧中也可能关注不同的区域,因此我们不会直接用未来的场景查询来监督预测的场景查询。相反,我们使用TokenFuser重建密集的BEV特征:

该过程旨在从预测的场景查询中恢复BEV特征,以进行进一步的自监督。

最后,我们使用L2损失和由未来环视图像生成的真实未来BEV特征Bt+1。这被定义为BEV重建损失Lbev:

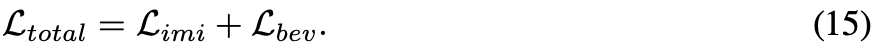

总结来说,我们将模拟损失Limi应用于预测轨迹,将BEV重建损失Lbev应用于预测的BEV特征。SSR的总损失为:

实验结果

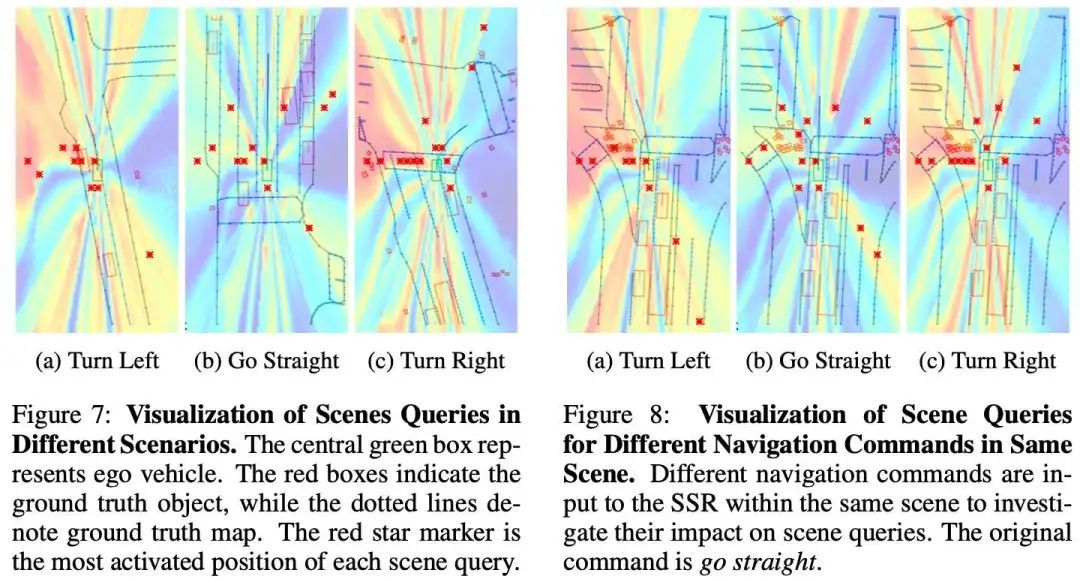

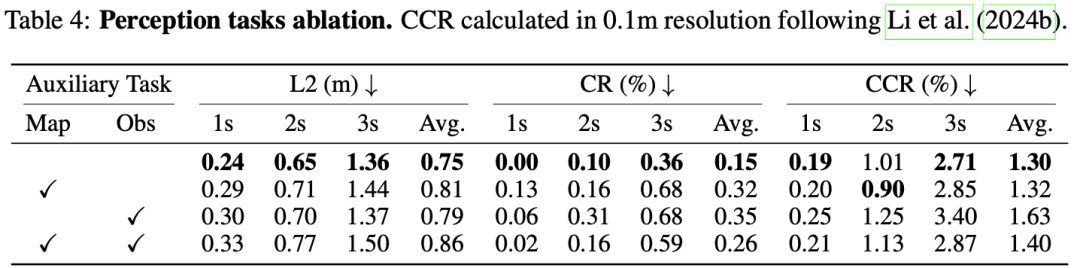

SSR能为AD任务学习足够的感知信息吗?尽管我们的框架消除了对感知注释的需求,但我们在表4中研究了合并感知分支的效果。我们遵循PARA Drive中的方法,将辅助任务集成到SSR中,使用它们与规划任务并行地监督BEV特征。结果表明,即使没有监督目标检测模块,我们的方法也能实现较低的碰撞率。同样,当SSR在没有建图分支的情况下运行时,CCR甚至更低。这些发现表明,SSR可以在没有明确监督的情况下有效地学习自动驾驶任务所需的感知信息,在所有指标上保持高性能。

结论

SSR框架通过挑战传统上对感知任务的依赖,在E2EAD领域取得了重大进展。通过利用导航引导的稀疏令牌和时间自监督,SSR解决了感知繁重架构的局限性,以最低的成本实现了最先进的性能。此外,稀疏标记的可视化增强了SSR导航引导过程的可解释性和透明度。我们希望SSR能够为可扩展、可解释和高效的自动驾驶系统提供坚实的基础。

局限性和未来的工作。尽管取得了这些进展,但目前简单的导航命令可能会限制SSR在更复杂的驾驶场景中的有效性。未来的工作将探索集成更复杂的导航提示,如路线和自然语言。

参考

[1] Does End-to-End Autonomous Driving Really Need Perception Tasks?

『自动驾驶之心知识星球』欢迎加入交流!重磅,自动驾驶之心科研论文辅导来啦,申博、CCF系列、SCI、EI、毕业论文、比赛辅导等多个方向,欢迎联系我们!

① 全网独家视频课程

端到端自动驾驶、仿真测试、自动驾驶C++、BEV感知、BEV模型部署、BEV目标跟踪、毫米波雷达视觉融合、多传感器标定、多传感器融合、多模态3D目标检测、车道线检测、轨迹预测、在线高精地图、世界模型、点云3D目标检测、目标跟踪、Occupancy、CUDA与TensorRT模型部署、大模型与自动驾驶、NeRF、语义分割、自动驾驶仿真、传感器部署、决策规划、轨迹预测等多个方向学习视频(扫码即可学习)

② 国内首个自动驾驶学习社区

国内外最大最专业,近4000人的交流社区,已得到大多数自动驾驶公司的认可!涉及30+自动驾驶技术栈学习路线,从0到一带你入门自动驾驶感知(端到端自动驾驶、世界模型、仿真闭环、2D/3D检测、语义分割、车道线、BEV感知、Occupancy、多传感器融合、多传感器标定、目标跟踪)、自动驾驶定位建图(SLAM、高精地图、局部在线地图)、自动驾驶规划控制/轨迹预测等领域技术方案、大模型,更有行业动态和岗位发布!欢迎扫描下方二维码,加入自动驾驶之心知识星球,这是一个真正有干货的地方,与领域大佬交流入门、学习、工作、跳槽上的各类难题,日常分享论文+代码+视频

③【自动驾驶之心】技术交流群

自动驾驶之心是首个自动驾驶开发者社区,聚焦感知、定位、融合、规控、标定、端到端、仿真、产品经理、自动驾驶开发、自动标注与数据闭环多个方向,目前近60+技术交流群,欢迎加入!扫码添加汽车人助理微信邀请入群,备注:学校/公司+方向+昵称(快速入群方式)

④【自动驾驶之心】全平台矩阵

253

253

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?