点击下方卡片,关注“自动驾驶之心”公众号

戳我-> 领取自动驾驶近15个方向学习路线

今天自动驾驶之心为大家分享清华AIR&梅赛德斯-奔驰中国团队最新的端到端工作Hint-AD!如果您有相关工作需要分享,请在文末联系我们!

自动驾驶课程学习与技术交流群事宜,也欢迎添加小助理微信AIDriver004做进一步咨询

论文作者 | Kairui Ding等

编辑 | 自动驾驶之心

写在前面&出发点

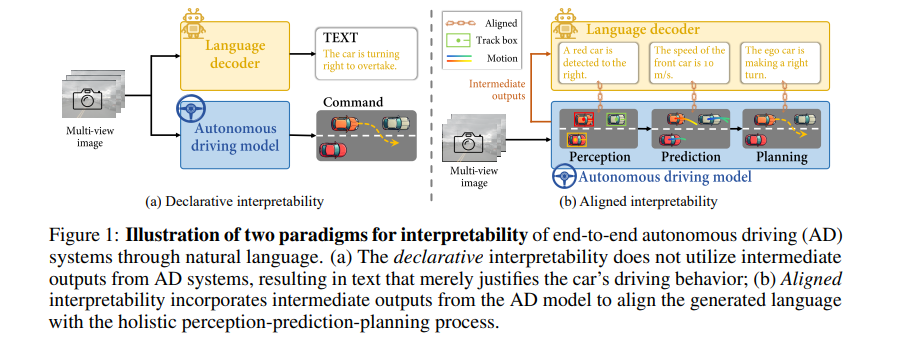

自动驾驶中的端到端架构在可解释性方面面临重大挑战,这阻碍了人机之间的信任。为了执行诸如驾驶解释和3D字幕生成等任务,已探索过了人性化的自然语言。然而,以往的工作主要关注于声明式可解释性的范式,其中自然语言解释并未以自动驾驶系统的中间输出为基础,导致这些解释仅具有声明性质。相比之下,对齐式可解释性在语言与自动驾驶系统的中间输出之间建立了联系。在此,我们介绍了Hint-AD,这是一个集成的自动驾驶-语言系统,能够生成与自动驾驶模型的整体感知-预测-规划输出相对齐的语言。通过整合中间输出和一个用于有效特征适应的整体标记混合子网,Hint-AD实现了理想的准确性,在包括驾驶解释、3D密集字幕生成和指令预测在内的驾驶语言任务中取得了最先进的成果。

为了促进对nuScenes上驾驶解释任务的进一步研究,我们还引入了一个人工标注的数据集Nu-X。代码、数据集和模型均可在网上公开获取,网址为:https://air-discover.github.io/Hint-AD/

背景介绍

端到端的感知规划架构在自动驾驶(AD)和一般具身智能中至关重要,因为它具有利用大量数据进行自监督训练的潜力。然而,这些系统面临着严峻的可解释性挑战,在具身智能问题中,如自动驾驶,可解释性问题尤为突出。当自动驾驶系统直接输出控制信号时,人类乘客很难信任其决策。为了解决这个问题,自然语言作为一种高度用户友好的沟通媒介,已被探索用于通过诸如驾驶解释、3D密集字幕和视觉问答(VQA)等任务来增强可解释性。虽然人类驾驶员认识到BEV轨迹作为解释正在发生什么(WHAT)的价值,但语言提供了为什么发生这种情况(WHY)的补充视角。这些方法可以根据单一标准分为声明式可解释性和对齐式可解释性:即生成的语言是否与自动驾驶系统的中间输出对齐(图1)。

声明式可解释性如近期在驾驶解释、3D密集字幕和视觉问答等方面的研究所示,它直接生成自然语言,而不依赖于自动驾驶系统的中间输入。这种方法经常会产生幻觉,因为语言没有基于全面的中间输出,只是驾驶行为的合理化解释。

对齐式可解释性要求语言与自动驾驶模型的内部状态保持一致。据我们所知,这种方法首先由[14]提出,他们将自动驾驶模型的注意力状态与语言解码器对齐,后来的工作将语言解码器与内部决策状态对齐。

然而,现有研究忽视了语言解码器与自动驾驶流程中的完整感知-预测-规划输出之间的对应关系,导致语言任务与自动驾驶任务之间存在差异。通过自动驾驶流程的中间输出来提高驾驶场景中语言任务准确性的潜力尚未被探索。为此,这里提出了Hint-AD,一个集成的自动驾驶-语言框架,旨在与自动驾驶模型的感知-预测-规划过程进行全面对齐,并生成高精度的语言,以促进自动驾驶的可解释性。

我们开发了两种方法来实现语言与自动驾驶模型之间的全面对齐以及语言输出的准确性:

(a) 开发了一个整体token混合模块,该模块将自动驾驶模型的中间输出token适应于语言解码器,重点在于稳健的特征提取和融合;

(b) 引入了一个对齐任务作为在线数据集,以将语言输出与自动驾驶模型的中间输出对齐,要求语言解码器在整个训练过程中解释自动驾驶模型推理过程中生成的中间token。

在UniAD和VAD这两个最先进的自动驾驶模型上实现了Hint-AD,这两个模型分别采用了光栅化和矢量化表示,以证

最低0.47元/天 解锁文章

最低0.47元/天 解锁文章

1万+

1万+

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?