今年多次霸榜的Mamba,作为一种新的选择性状态空间模型,对主流架构RNN、Transformer提出了挑战,被视为极具潜力的CV基础模型!在自动驾驶领域,Mamba也具有广泛使用场景,比如道路状况分析、车辆轨迹预测!基于Mamba的改进变体,也层出不穷,涉及图像、视频、3D点云、多模态等方向,种类接近一百种,甚至多个杀入最新顶会!

为了帮助大家掌握Mamba架构和性能,研梦非凡于7月10日(周三),邀请了手握多篇SCI一作、精通视觉语言模型的王导师,独家详解核心论文《Mamba: Linear-Time Sequence Modeling with Selective State Spaces》(AI前沿直播课NO.52),通过可视化的图解方式,从Transfomer、RNN原理回顾,再到SSM、Mamba重点解析,并进行全面对比,1节课速通Mamba改进知识点!

👇🏻扫描二维码找助教0元预约直播课!

凡预约即可领取50篇Mamba(改进)论文+116篇Transformer论文+文末还有算力等科研福利

unsetunset直播课内容概览unsetunset

01 Transfomer

Transformer原理

Transformer的优点

Transformer的核心组件

Transformer的推理

02 RNN

RNN介绍

RNN的问题

RNN vs Transformer

03 SSM

什么是状态空间

什么是状态空间模型

从连续信号到离散信号

循环表示

卷积表示

三种表示

04 Mamba(直播课重点)

SSM的局限

Mamba介绍

扫描操作

Mamba vs Transformer vs RNN

05 总结展望

Vision Mamba等

导师介绍

王导师

【学术背景】985硕出身,拥有丰富的深度学习研究、论文发表经验,多篇SCI论文、EI会议论文(一作)

【研究方向】大语言模型、视觉语言模型、多模态学习,以及自然语言处理、进化算法等

直播福利

参加本次直播的同学都将获得1小时导师meeting的福利(助教+导师)!原价2999,限时福利价9.9元!活动时间为7月10日到7月31日。

ps:研梦非凡开设的前沿论文系列直播,旨在帮助大家提升读论文技能,快速抓住重点,掌握有效方法,进而找到创新点,轻松完成论文报告。

👇🏻扫描二维码找助教0元预约直播课!

凡预约即可领取50篇Mamba(改进)论文+116篇Transformer论文+文末还有算力等科研福利!

unsetunset研梦非凡科研论文指导unsetunset

如果你的研究方向/方法/idea是属于CV全方向/NLP全方向/机器学习/深度学习及AI+金融、医疗、交通等方向,如果你需要发CCF A-C、SCI一区-四区、EI会议/EI期刊、毕业大论文、毕业设计等,都可以来研梦非凡,匹配合适的科研指导。

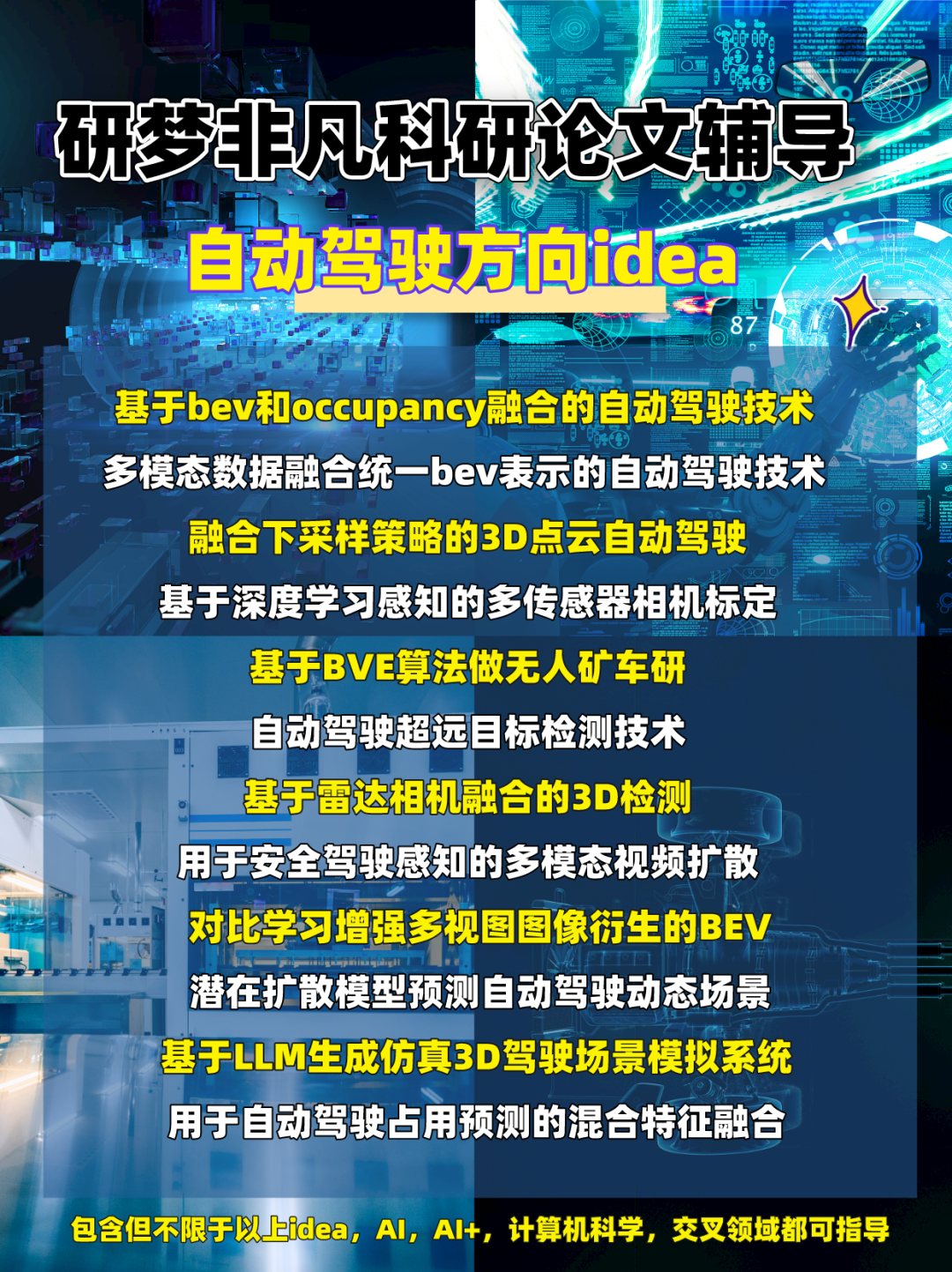

下面是我们根据自动驾驶之心粉丝需求,整理的自动驾驶现有idea!

自动驾驶方向现准备的idea

👇🏻扫码找助教了解更多/验证自己的idea是否可行

unsetunset研梦非凡科研论文指导方案unsetunset

idea并不是直接拍脑门拍出来的,是一遍一遍实验、跑代码、改模型、思路修正的过程中产生的。研梦非凡1V1定制化论文指导,和研梦导师一起找idea,研梦导师指导实验,共同解决数据问题。授之以渔——搭建论文写作框架,增删改查,针对性实验指导!哪里薄弱补哪里!

<<< 左右滑动见更多 >>>

👇🏻扫描二维码咨询助教两种指导方案

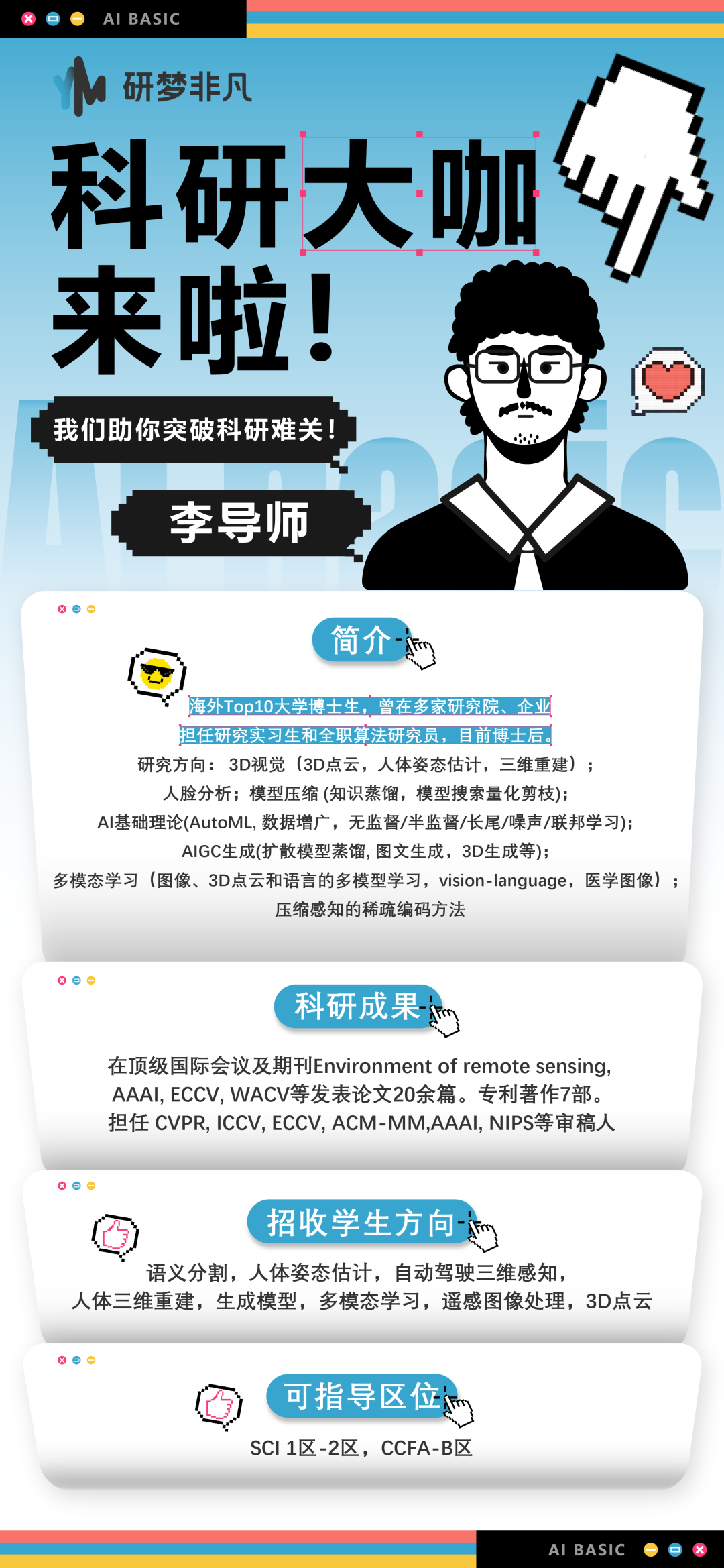

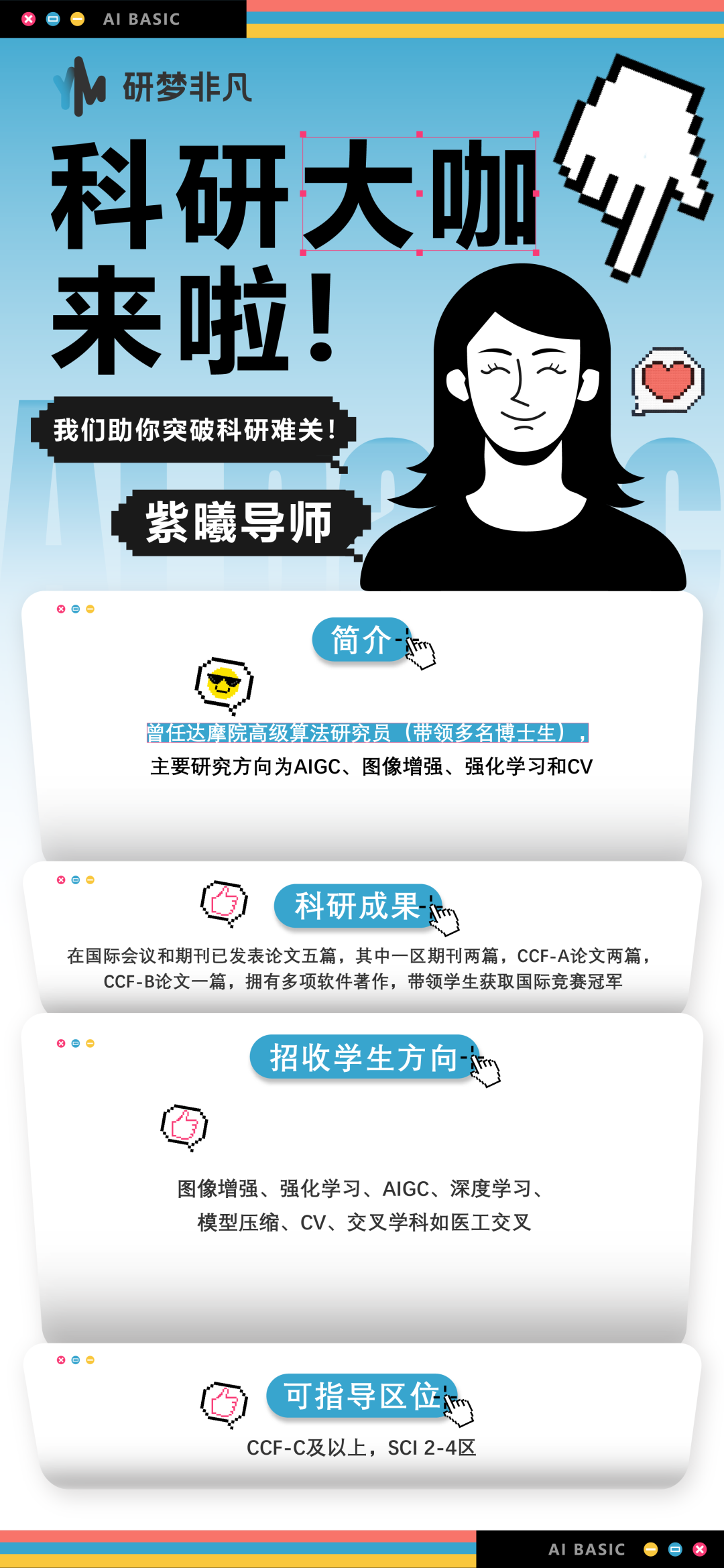

unsetunset研梦非凡部分导师介绍unsetunset

研梦非凡导师团队,来自海外QStop200、国内华五、C9、985高校的教授/博士导师/博士后,以及世界500强公司算法工程师、国内外知名人工智能实验室研究员等。

这是一支实力强大的高学历导师团队,在计算机科学、机器学习、深度学习等领域,积累了丰富的科研经历,研究成果也发表在国际各大顶级会议和期刊上,在指导学员的过程中,全程秉持初心,坚持手把手个性化带教。包括但不限于以下导师~

<<< 左右滑动见更多 >>>

👇🏻扫码加助教为你匹配合适课题的大牛导师

unsetunset研梦非凡科研福利

🌟90分钟人工智能零基础入门课免费领

🌟7小时科研论文写作系列课免费领

🌟数十节前沿论文直播课程免费领

🌟50小时3080GPU算力免费领

🌟百篇6月论文资料大合集免费领

🌟报名本次直播课,9.9元即可享受原价2999元的1小时导师meeting(助教+导师)!

👇🏻扫码领取以上6重粉丝专属科研福利!

5233

5233

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?