点击下方卡片,关注“自动驾驶之心”公众号

ADAS巨卷干货,即可获取

今天自动驾驶之心很荣幸为大家分享上海交通大学、南加州大学和上海AI Lab最新中稿ICLR 2024的工作—HEAL,文章已经授权自动驾驶之心原创!

论文作者 | Yifan Lu、Siheng Chen

编辑 | 自动驾驶之心

协同感知技术能够有效解决自动驾驶车辆单体感知中存在的障碍物遮挡、视角受限、以及远距离感知能力弱等问题。然而,现有的工作都做了一个过分简单的假设,即参与协作的智能体使用相同的传感器,部署相同的感知模型。在现实情况下,发生协作的智能体极有可能异构的,并且传感器模态和感知模型的类别将不断增加。新出现的异构智能体的模态和模型会和已有的智能体存在显著的域差异(domain gap),难以实现协作。

为了解决这一实际挑战,ICLR 2024的最新研究文章 《An Extensible Framework for Open Heterogeneous Collaborative Perception》定义了开放异构协作感知问题(Open Heterogeneous Collaborative Perception):如何将不断出现的新异构智能体类型加入已有协作感知系统,同时确保高感知性能和低加入成本?来自上海交通大学、南加州大学和上海人工智能实验室的研究者们在本文中提出了HEAL(HEterogeneous ALliance):一种可扩展的异构智能体协作框架,有效解决了开放异构协作感知问题的两大痛点。

同时,他们搭建了一个集成了多个协作感知数据集、多个协作感知算法、支持多模态的代码框架,目前已经跟随HEAL完全开源。论文作者表示这是当前最完整的协作感知代码框架,相信能让更多人快速上手多模态、异构的协作感知研究。

论文链接:https://arxiv.org/abs/2401.13964

代码链接:https://github.com/yifanlu0227/HEAL

研究背景和意义

近年来,自动驾驶领域在学术界和工业界都受到了极大的关注。但真实世界中道路情况复杂多变,加上单车传感器可能被周围车辆遮挡,给单车的自动驾驶感知带来极大挑战(如下图)。多智能体之间的协作感知为单体感知存在的这些问题提供了解决方案。随着通信技术的发展,多个智能体之间可以利用通信共享彼此的感知信息,结合自身传感器信息与其他智能体的信息,对周围环境进行感知。通过智能体之间的协作,每个智能体可以获取自身视野盲区与可视距离以外的信息,有助于提升每个智能体的感知以及决策能力。

图 1. 视线遮挡造成的“鬼探头”问题,单车感知受限

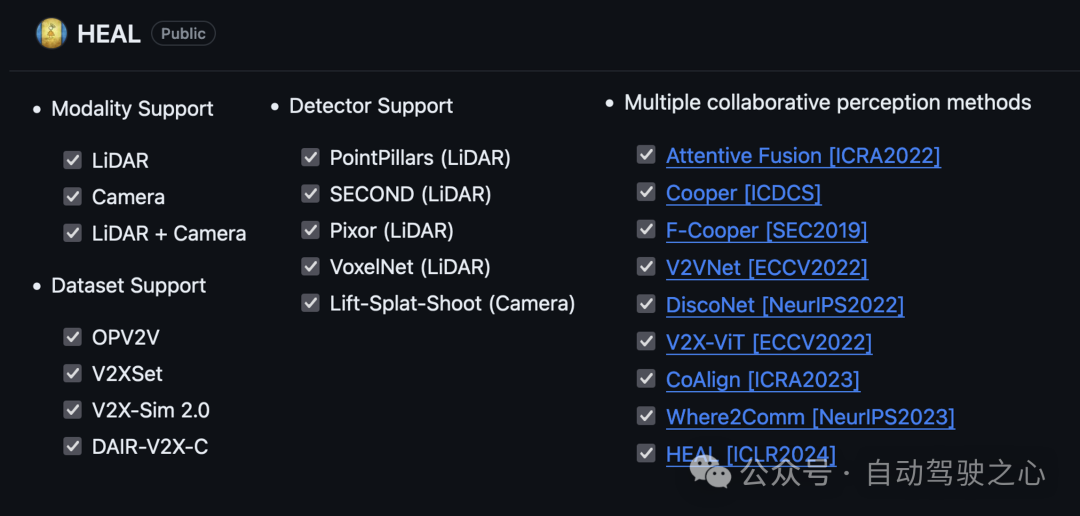

在这一研究领域,大多数当前工作基于一个看似合理但过于简化的假设:所有智能体必须是同构的;即所有智能体的感知系统都使用相同的传感器,并共享相同的检测模型。然而,在现实世界中,不同智能体的模态和模型很可能是异构的,且新的模态、模型可能会不断出现。由于传感器技术和算法的快速迭代,从一开始就确定所有参与协作的智能体类别(包括模态和模型)是不切实际的。当一个从未出现在训练集中的异构智能体希望加入协作时,它不可避免地会遇到与现有智能体之间的域差异(domain gap)。这一差异将阻碍其与现有智能体进行特征融合的能力,并显著限制了协作感知的可扩展性。

因此,开放异构协作感知问题随之而生:如何将不断出现的新智能体类型加入到现有的协作感知系统,同时确保高感知性能和低集成成本?

图 2. (a) 同构协作感知 (b) 异构协作感知 (c) 考虑新异构智能体加入的开放异构协作感知 (d) HEAL在使用最少训练成本的同时达到了最佳的协作感知性能

为了解决这个问题,一个可行的解决方案是后融合。通过融合每个智能体的感知输出(如3D包围框),后融合绕过了新智能体和现有智能体之间的异构性,且训练只需要发生在单智能体类别上。然而,后融合的性能并不理想,并被证明特别容易受到定位噪声和通信延迟等干扰因素等影响。另一种潜在的方法是完全集体培训,它汇总了协作中的所有智能体类型进行协作训练,以克服领域差异。然而,每次引入新的智能体类型时,这种方法都需要重新训练所有模型。随着新异构智能体的不断出现,训练的代价急剧上升。HEAL提出了一个全新的开放异构协作框架,同时具有完全集体训练的高性能和后融合的低训练成本。

问题定义

开放异构协作感知问题考虑如下场景:将具有先前未出现的模态或者模型的异构智能体类别加入到已有的协作系统中。不失一般性的,我们考虑场景初始由个同构的智能体组成,他们配备了相同类别的传感器、部署了相同的检测模型,并且都具有相互通信的能力。这些同构的智能体构成了一个已有的协作系统。随后,场景中从未出现过的模态或感知模型的异构智能体加入到协作系统当中。这种动态特性是在现实世界中部署协作感知的一个显著特征:智能体类别不会在开始时被完全确定,其类型数量可能会随着时间的推移而增加。它与先前的异构协作感知问题(其中异构的类别是提前确定好并固定的)也截然不同。

方法介绍

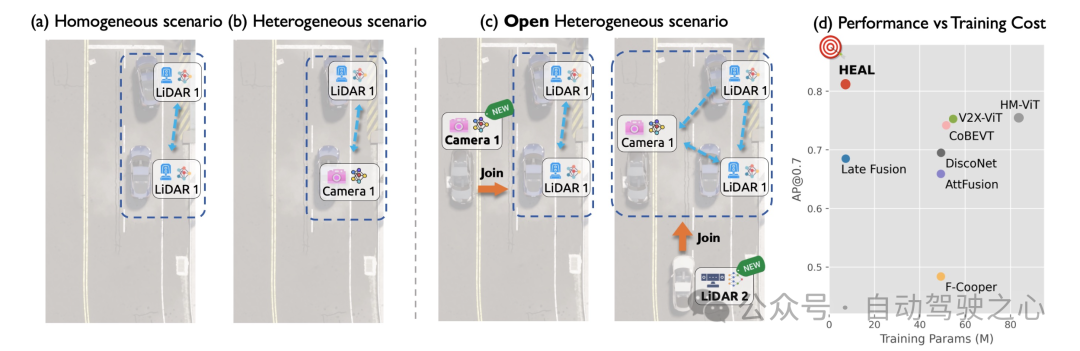

本文提出的开放异构协作感知框架HEAL(HEterogeneous ALliance),设计了两阶段的方法来将新的异构智能体加入到协作中,以实现不断增长的异构联盟:i)协作基类训练,令初始智能体训练一个特征融合协作网络并创建统一的特征空间;ii)新智能体训练,将新智能体的特征与之前建立的统一特征空间对齐,从而允许新智能体和已有智能体进行特征层面的协作。

对于每个新智能体类型加入协作,只需要第二阶段的训练。值得注意的是,第二阶段的训练可以由智能体所有者独立进行,不涉及与已有智能体的集体训练。这允许新智能体的加入有较低的训练成本,同时还能保护新智能体的模型细节不被暴露。

图 3. HEAL的整体框架

一阶段:协作基类训练

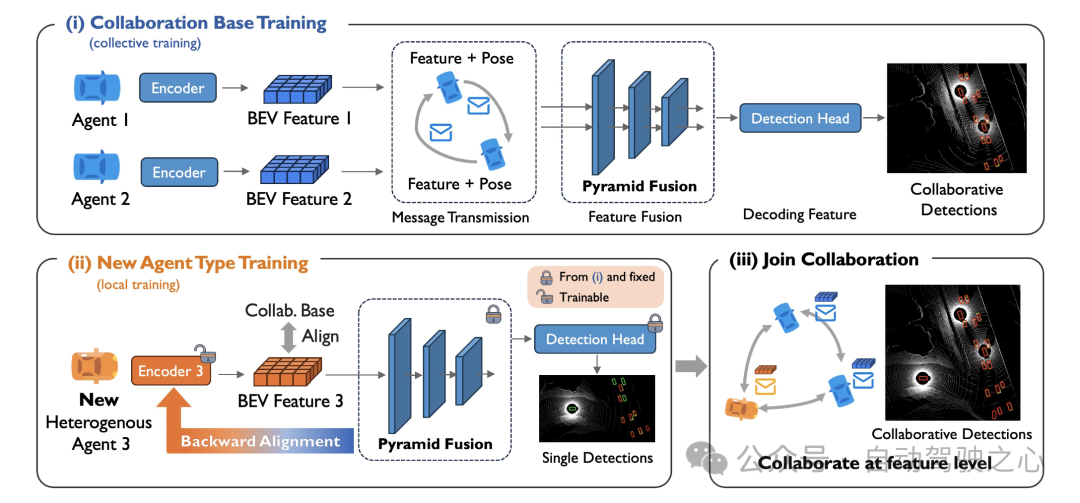

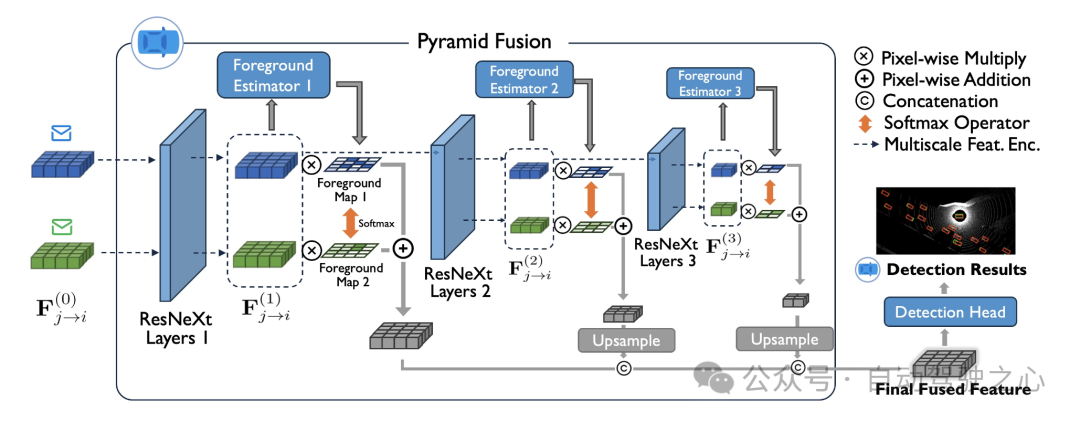

我们将场景中一开始存在的个同构智能体作为协作基类,并且训练一个基于特征融合的协作感知网络。我们提出一个新颖的金字塔融合网络来提取并融合多智能体的特征,具体在于:对于每个同构智能体的编码器编码出来的BEV特征,我们让他经过多层不同尺度的ResNeXt网络,以提取粗粒度和细粒度的特征信息。对于不同尺度的特征图,我们都对其应用前景预测器网络,估计BEV每个特征位置存在车辆等前景的概率。在协作者之间,前景的概率图会被归一化,作为将特征图逐像素加权融合的权重分布。获得不同尺度下的融合特征图以后,我们利用一系列上采样网络,将其转化到相同的特征图尺寸,并且得到最终融合的特征图。

图 4. 金字塔融合网络

融合后的特征图会经过一个检测头,转为最终的协作检测结果。协作检测结果和前景的概率图都受到ground-truth的监督。经过训练后,协作网络(金字塔融合网络)的参数保存了协作基类的相关特征信息,构建了一个共享的特征空间,用于后续新异构智能体的对齐。

二阶段:新智能体训练

我们考虑加入一种新的异构智能体类型。我们提出一种新颖的后向对齐方法。核心想法是利用上一阶段的金字塔融合网络和检测头作为新智能体的检测器后端,并仅更新前端编码器相关的参数。

值得注意的是,我们对新的异构类别的单个智能体进行单体训练,不涉及智能体之间的协作。因此,金字塔融合网络的输入是单张特征图,而不是一阶段中的多智能体特征图。随着预训练的金字塔融合模块和检测头被确立为后端和固定,训练过程演变为让前端编码器适应后端的参数,从而使新智能体编码的特征与统一特征空间保持一致。由于特征和已有智能体的特征对齐,他们能实现高性能的特征层面的协作。

后向对齐还显示了一个独特的优势:训练仅在新的单个智能体上进行。这大大降低了每次新智能体加入的训练成本和时空同步的数据采集成本。此外,它防止新代理的模型细节暴露给他人,并允许新智能体的所有者使用自己的传感器数据训练模型。这将显著解决汽车公司在部署车辆协作感知技术(V2V)时可能存在的许多顾虑。

实验结果

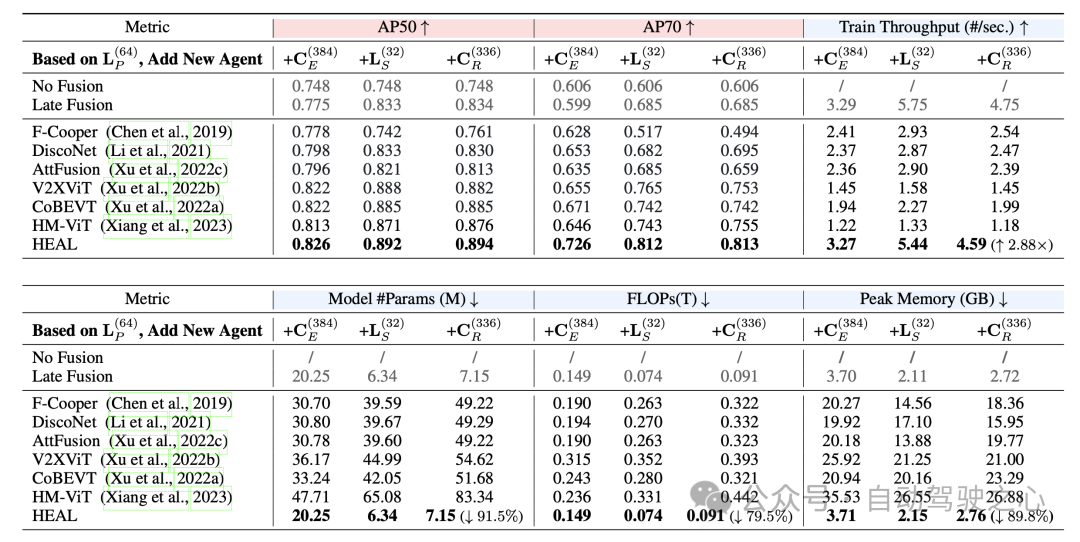

本文在OPV2V数据集的基础上,提出了一个更加数据异构的OPV2V-H数据集,补充了每辆车辆16线和32线的激光雷达数据,以及4个深度摄像头的数据。在OPV2V-H数据集和真实数据集DAIR-V2X上的实验结果表明,HEAL显著地降低了异构智能体加入协作的一系列训练成本(训练参数,FLOPs,训练时间等等),还保持了极高的协作检测性能。

图 5. HEAL同时拥有高性能和低训练成本

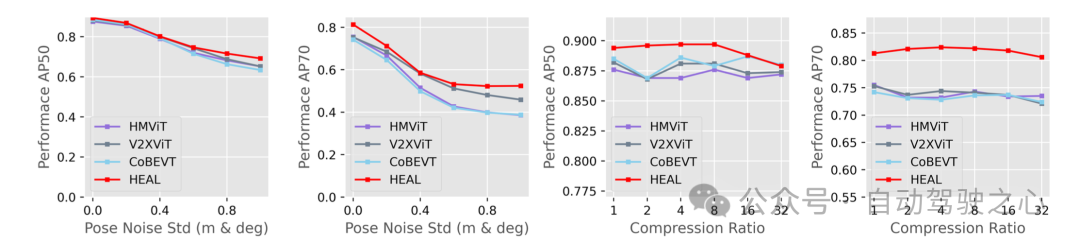

存在定位噪声和特征压缩的情况下,HEAL依然保持了最佳的检测性能,展示了在更加接近现实的设定下,HEAL是目前最有效的协作感知算法。

投稿作者为『自动驾驶之心知识星球』特邀嘉宾,欢迎加入交流!

① 全网独家视频课程

BEV感知、毫米波雷达视觉融合、多传感器标定、多传感器融合、多模态3D目标检测、车道线检测、轨迹预测、在线高精地图、世界模型、点云3D目标检测、目标跟踪、Occupancy、cuda与TensorRT模型部署、大模型与自动驾驶、Nerf、语义分割、自动驾驶仿真、传感器部署、决策规划、轨迹预测等多个方向学习视频(扫码即可学习)

视频官网:www.zdjszx.com

视频官网:www.zdjszx.com

② 国内首个自动驾驶学习社区

近2400人的交流社区,涉及30+自动驾驶技术栈学习路线,想要了解更多自动驾驶感知(2D检测、分割、2D/3D车道线、BEV感知、3D目标检测、Occupancy、多传感器融合、多传感器标定、目标跟踪、光流估计)、自动驾驶定位建图(SLAM、高精地图、局部在线地图)、自动驾驶规划控制/轨迹预测等领域技术方案、AI模型部署落地实战、行业动态、岗位发布,欢迎扫描下方二维码,加入自动驾驶之心知识星球,这是一个真正有干货的地方,与领域大佬交流入门、学习、工作、跳槽上的各类难题,日常分享论文+代码+视频,期待交流!

③【自动驾驶之心】技术交流群

自动驾驶之心是首个自动驾驶开发者社区,聚焦目标检测、语义分割、全景分割、实例分割、关键点检测、车道线、目标跟踪、3D目标检测、BEV感知、多模态感知、Occupancy、多传感器融合、transformer、大模型、点云处理、端到端自动驾驶、SLAM、光流估计、深度估计、轨迹预测、高精地图、NeRF、规划控制、模型部署落地、自动驾驶仿真测试、产品经理、硬件配置、AI求职交流等方向。扫码添加汽车人助理微信邀请入群,备注:学校/公司+方向+昵称(快速入群方式)

④【自动驾驶之心】平台矩阵,欢迎联系我们!

417

417

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?