what is Neural Network?

1、Neural Network Representation

只有一个隐藏层的神经网络:双层神经网络只有一个隐藏层。

隐藏层是第一层(双层神经网络)

2、Computing a Neural Network's Output

神经网络到底在计算什么

第一个节点:

第一步计算z,第二步计算激活函数sigmoid(z)

4.Vectorizing across multiple examples

如何向量化:

如何向量化:

![]()

![]()

5.Explanation for vectorized implementation

6.如何使用不用的激活函数 Activation functions

![]()

![]()

![]()

![]()

![]()

![]()

![]()

会用sigmo函数的场合(1:希望y^的值介于0~1之间。2:使用二分类时)

ReLU函数

![]()

![]()

![]()

![]()

![]()

ReLU的缺点:

![]()

![]()

![]()

![]()

在实践种使用ReLU激活函数很快的原因就是ReLU没有这种函数斜率接近于0时,减慢学习速度的效应。

不同激活函数的优缺点:

7.为什么要使用activation functions

8.Derivatives of activation functions

9.梯度下降算法的具体实现 如何处理单隐层神经网络

Gradient descent for neural networks

![]()

![]()

![]()

10.计算梯度(选看)

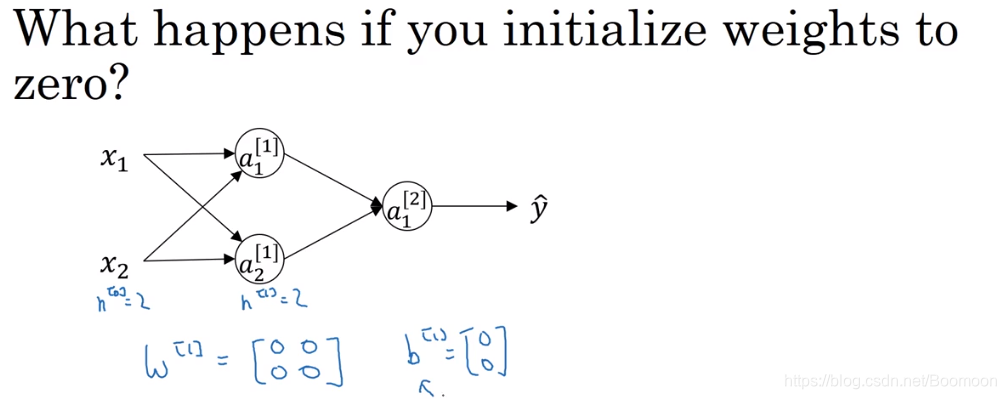

11.随机初始化

![]()

![]()

![]()

![]()

![]()

![]()

![]()

![]()

![]()

![]()

![]()

![]()

![]()

![]()

![]()

![]()

![]()

![]()

![]()

![]()

![]()

![]()

![]()

![]()

![]()

![]()

![]()

![]()

![]()

![]()

![]()

![]()

![]() 0.01可以

0.01可以

![]()

![]()

本文深入讲解神经网络的基本概念,包括单隐藏层神经网络的结构、神经网络的输出计算过程、向量化实现方法及其背后的数学原理。同时探讨了激活函数的作用及不同函数的优缺点,如Sigmoid和ReLU,并解释了梯度下降算法在神经网络中的应用。

本文深入讲解神经网络的基本概念,包括单隐藏层神经网络的结构、神经网络的输出计算过程、向量化实现方法及其背后的数学原理。同时探讨了激活函数的作用及不同函数的优缺点,如Sigmoid和ReLU,并解释了梯度下降算法在神经网络中的应用。

486

486

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?