一、下载Spark安装包

从官网下载:http://spark.apache.org/downloads.html

二、安装准备

以下安装都可以参照以前的环境搭建博客:

1、Java8安装成功

2、zookeeper安装成功

3、hadoop2.6.0 HA安装成功

4、Scala安装成功(不安装进程也可以启动)

三、Spark安装

1、上传并解压缩 spark-2.3.4-bin-hadoop2.6.tgz

2、移动到 /opt/soft/spark234 目录下

[root@zj1 opt]# mv spark-2.3.4-bin-hadoop2.6 soft/spark234

3、进入spark/conf修改配置文件

(1)进入配置文件所在目录

[root@zj1 opt]# cd soft/spark234/conf/

(2)复制spark-env.sh.template并重命名为spark-env.sh,并在文件最后添加配置内容

[root@zj1 conf ]# cp spark-env.sh.template spark-env.sh

export SPARK_MASTER_HOST=192.168.56.137 #主节点IP

export SPARK_MASTER_PORT=7077 #任务提交端口

export SPARK_WORKER_CORES=2 #每个worker使用2核

export SPARK_WORKER_MEMORY=3g #每个worker使用3g内存

export SPARK_MASTER_WEBUI_PORT=7979 #修改spark监视窗口的端口默认8080

(3)复制slaves.template成slaves (配置worker节点)

[root@zj1 conf]# cp slaves.template slaves

加入两个workder节点名,如果搭建伪分布式的,这里写localhost 即可

hadoop1

hadoop2

hadoop3

(4)修改sbin下spark-config.sh

export JAVA_HOME=/opt/soft/jdk180

# 这是我jdk的路径

(5)将安装包分发给其他节点

[root@zj1 conf]# scp -r /opt/soft/spark234/ root@zj2:/opt/soft/

[root@zj1 conf]# scp -r /opt/soft/spark234/ root@zj3:/opt/soft/

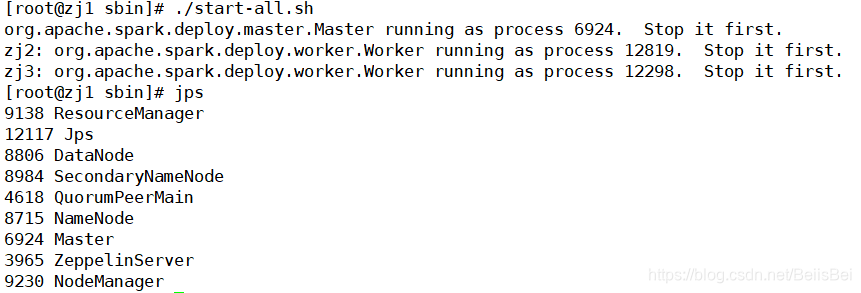

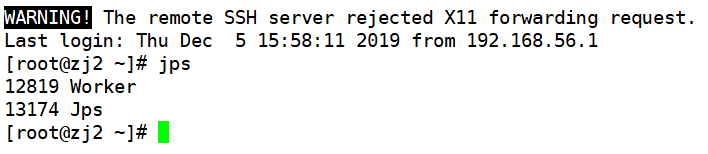

四、启动Spark

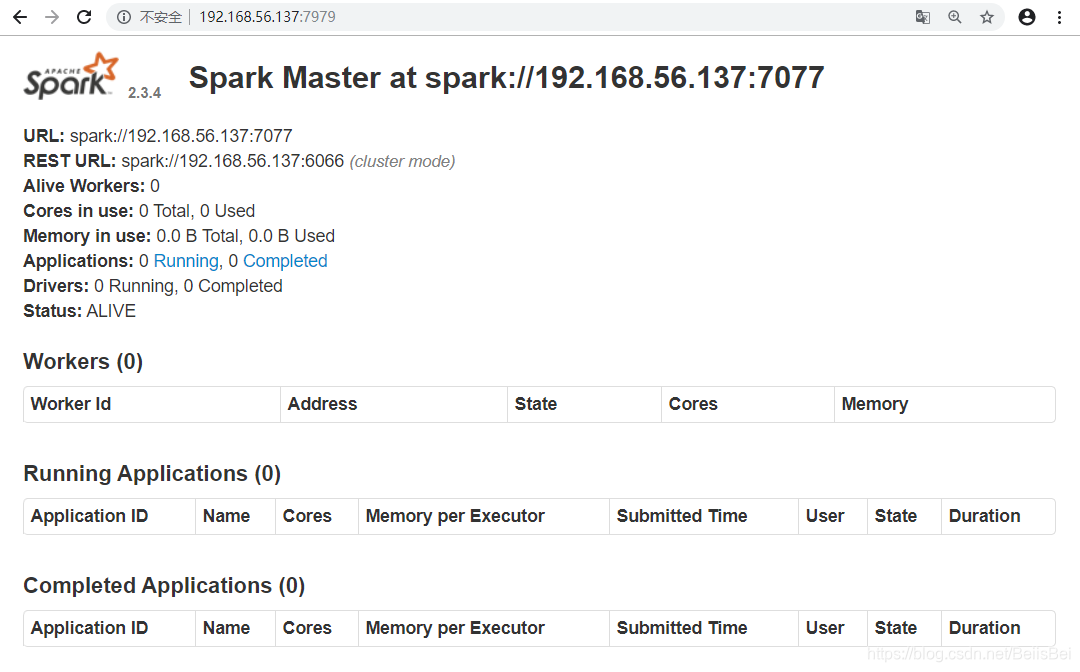

五、验证

查看Web界面Master状态

541

541

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?