什么是Prompt Engineering?

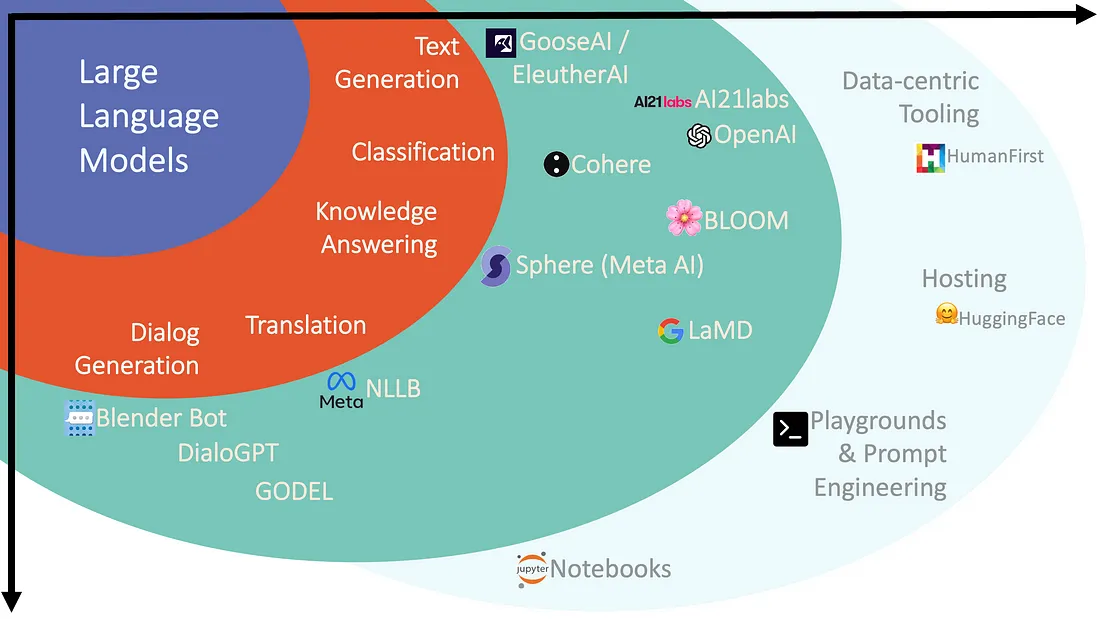

近年来,大语言模型(LLM)发展迅速,成为自然语言处理领域的重要技术。除了OpenAI的GPT系列、Google的PaLM(Pathways Language Model)和Bard,国内也涌现出多款领先的模型,如百度的文心一言、阿里的通义千问、华为的盘古大模型。此外,Meta的LLaMA和Anthropic的Claude也在全球范围内产生了广泛影响。谷歌今年推出的Gemini系列被认为是其继Bard之后的又一重大突破。

随着各国在AI领域的投入不断增加,越来越多的企业和研究机构开始参与到LLM的开发中,推动了技术的创新和应用的多样化。大语言模型不仅在机器翻译、自动写作、信息提取等领域取得了显著进展,也在教育、医疗、金融等行业展现出巨大的应用潜力。随着大模型的不断发展,如何更有效地与这些模型互动、引导其输出,成为了一个重要的研究方向,这也促使了Prompt Engineering的兴起。

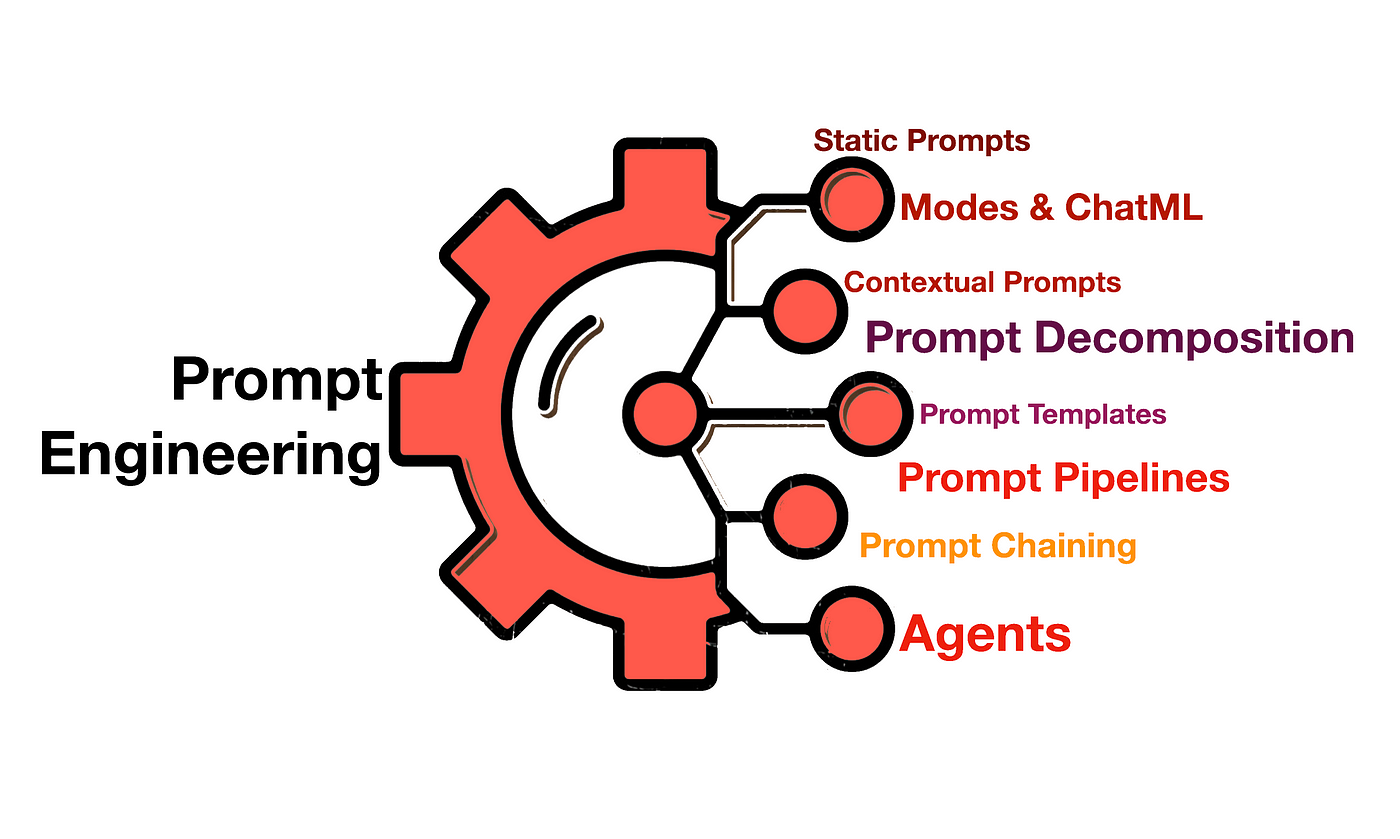

Prompt Engineering 是设计和优化输入给语言模型(如 GPT 或其他大型语言模型)的问题或指令的过程。这个过程的核心目标是通过精确地设计输入提示,使得模型能够提供更准确、有效的输出。设计好的 Prompt 可以帮助使用者利用语言模型完成各种任务,包括文本生成、摘要、分类、翻译等。

Prompt Engineering 的核心目标是提高语言模型的效果,使其能够更好地完成如问答、推理、文本生成等各种任务。开发者和研究者通过优化提示语,不仅可以提升模型的准确性,还能使模型在更多复杂任务中表现优异。

Prompt Engineering的重要性

1. 增强语言模型的能力

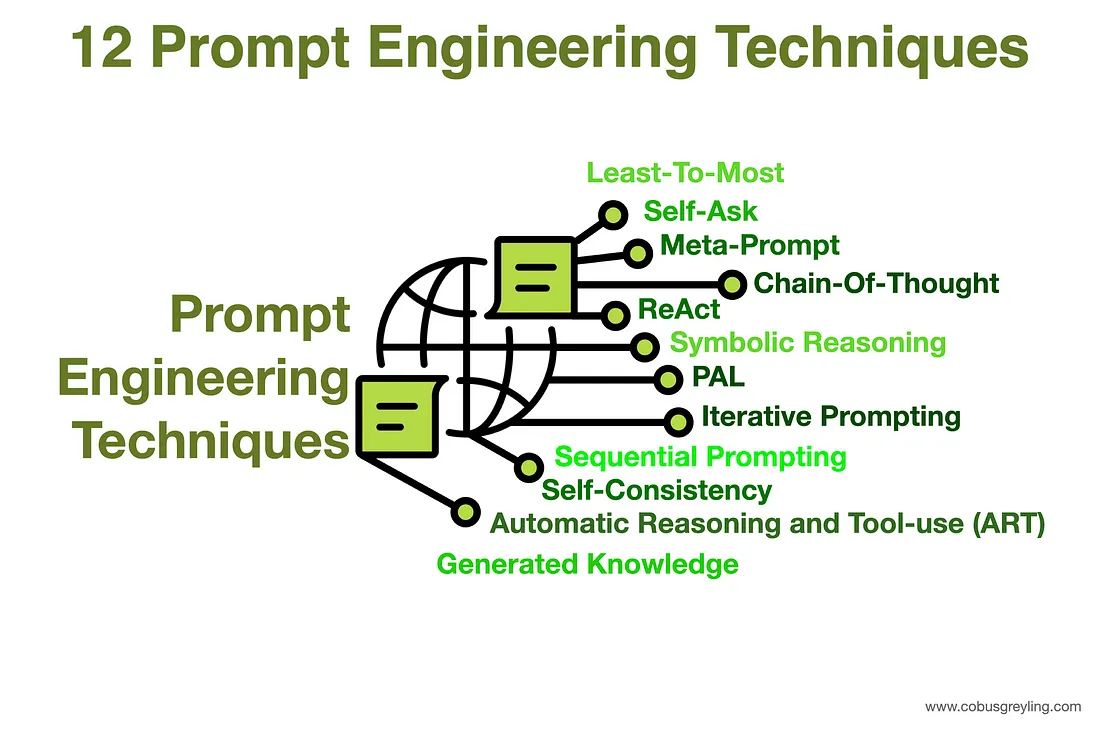

研究人员通过提示工程,提升语言模型在多种任务中的表现,包括常见的问答、算术推理等复杂任务。例如,优化提示语可以让模型回答更准确,或者更好地理解上下文。

2. 设计有效的提示语

开发者使用提示工程来设计鲁棒、有效的提示技巧,使模型能够与其他工具进行有效交互。通过精心设计的提示语,开发者可以更好地控制生成的结果,从而提升应用程序的功能。

3. 提升模型的安全性和能力

提示工程不仅仅是设计提示语,它还涵盖了一系列技术,能够帮助我们更好地理解并使用LLM。通过优化提示,我们可以增强模型的安全性,并通过添加领域知识或外部工具,增强新的功能。

提示工程的核心技术

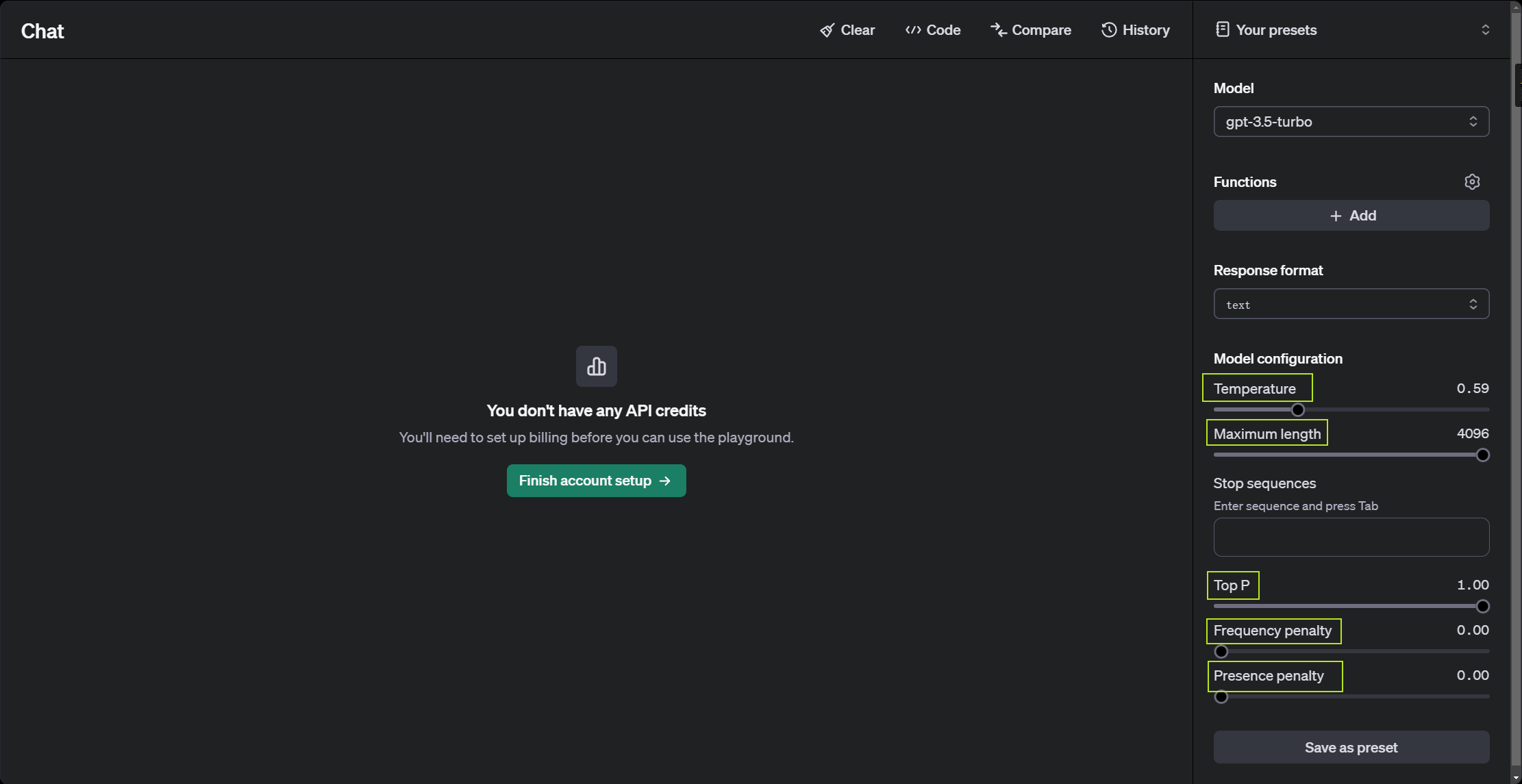

提示工程不仅仅是单纯的编写提示语。它是一个包含了多种技能和技术的领域,旨在帮助我们更好地与大型语言模型互动。以下是一些核心技巧和概念,下图是Openai的playground页面,用于模型调试。

LLM的设置参数(针对研究人员)

LLM的参数设计通常是研究人员进行设置的,我们日常在于大模型交互时并不设置这些参数,但是了解这些参数有助于我们更好地理解大模型工作的原理,从而知道我们与大模型交互式的思路。在设计和测试提示时,我们通常通过API与语言模型进行交互。我们可以配置一些参数来获得不同的输出。调整这些设置对于提高响应的可靠性和符合需求的输出非常重要。以下是一些常见的设置参数:

1. 温度(Temperature)

-

低温度:输出结果较为确定,总是选择概率最高的下一个词汇,适用于事实性问题或需要精确回答的场景。

-

高温度:增加随机性,鼓励生成更多样化或创造性的输出,适用于诗歌生成或其他创造性任务。

2. Top P(核采样)

-

Top P 控制了输出的随机性。如果您需要更具多样性的回答,可以提高Top P值;如果想要更确定的回答,可以保持较低值。Top P会限制模型只考虑前P比例的词汇。

3. 最大长度(Max Length)

-

设置生成的最大token数。通过控制这个参数,可以避免模型输出过长或无关的答案。

4. 停止序列(Stop Sequences)

-

停止序列是一个字符串,当模型生成该字符串时,停止生成更多token。例如,我们可以设置“10”作为停止序列,来控制生成的列表不超过10个项目。

最低0.47元/天 解锁文章

最低0.47元/天 解锁文章

9988

9988

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?