ISR中所有的副本在任意时刻都与leader的数据是一致的,这是Kafka提供的数据可靠性保证之一

当生产者向Kafka发送消息时,只有当消息被ISR列表中的所有副本都成功地写入后,才会向生产者返回成功的响应。这意味着ISR列表中的所有副本都已经成功地复制了消息,因此它们的数据是一致的。当消费者从ISR副本中读取消息时,它们也可以保证读取到与leader副本相同的数据

每个broker节点的topic数据是否一致就看isr列表即可,只要是在isr列表中的broker节点,数据都是一致的

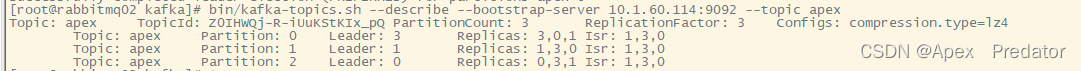

查看apex主题的详细信息,其中包含topic id、isr列表、partition分区等信息

bin/kafka-topics.sh --describe --bootstrap-server 10.1.60.114:9092 --topic apex

ISR列表是指与leader副本保持同步的副本列表。当分区的某个副本与leader副本同步时,它就会被添加到ISR列表中。当分区的某个副本与leader副本失去同步时,它就会从ISR列表中删除

在Kafka中,ISR副本是与leader副本保持同步的副本,它们的数据是一致的。当一个ISR副本被选举为新的leader时,它会从上一个leader副本处继续消费消息,因此不会出现重复消费的情况

Kafka通过ISR(In-SyncReplicas)确保数据一致性,只有当消息被ISR中的所有副本写入后才向生产者确认。ISR列表包含与leader保持同步的副本,当副本失去同步则从列表中移除。这样保证了消费者从ISR读取的数据与leader一致,且在副本间切换时避免数据丢失。

Kafka通过ISR(In-SyncReplicas)确保数据一致性,只有当消息被ISR中的所有副本写入后才向生产者确认。ISR列表包含与leader保持同步的副本,当副本失去同步则从列表中移除。这样保证了消费者从ISR读取的数据与leader一致,且在副本间切换时避免数据丢失。

313

313

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?