背景

论文作者以Agentic RAG为切入点,我通篇读下来,个人认为更像web/search agent,所以后续就以web agent视角进行叙述。

简单来说,web agent指的是llm agent在生成response时能够自主决定何时调用search engine从外部(主要是互联网)获取信息,然后结合内部知识生成更高质量的response。

问题是,web agent真的有那么好用吗?会不会有的query,llm明明知道答案却还是从互联网检索结果返回了一些噪声/垃圾文档,反而生成错误的答案?这个问题可以称之为over-search。还有一类query,llm内部知识明显无法回答,它却很自信,不去search而是幻觉生成,这个问题可以称之为under-search。

可以看到,llm agent何时应该去search是个很难的问题,并且即使是search的时机准确,如何生成合理的search query也不容易(这个问题超过本文探讨的范畴了)。再回顾下,目前训练web agent的主流做法是outcom-based RLVR,论文作者认为缺乏细粒度的reward进行指导,让llm 自己去充分探索最佳搜索时间是不行的,或者说效率太低。

为此,作者引入了process-based reward,提出了HiPRAG:Hierarchical Process Rewards for Efficient agentic RAG。

一、HiPRAG简介

1.step的定义

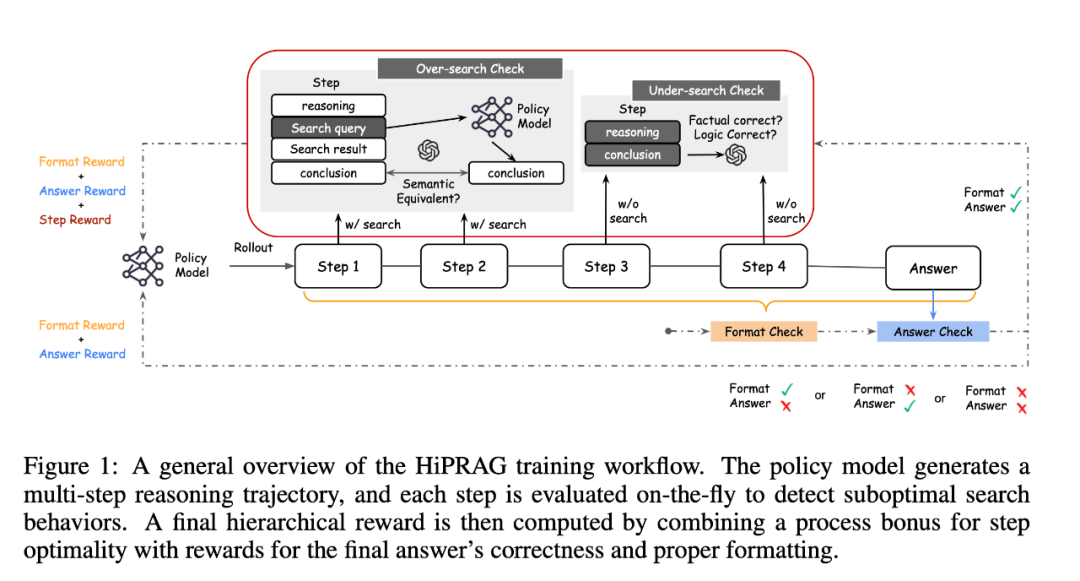

简单来说,就是在outcom-based RLVR基础上设计一种process-based reward,希望能让web agent更加合理地调用 search engine tool.

所以重点是如何设计process reward function? 从哪里获取process reward 值,总不能人工标注训练集吧。

对于llm agent的一条response, 因为我们从RLVR去看,所以下文把它称为reasoning trajectory,一般来说process reward是step level的,第一个问题就来了,如何将一条reasoning trajectory划分成多个step,step的粒度是?

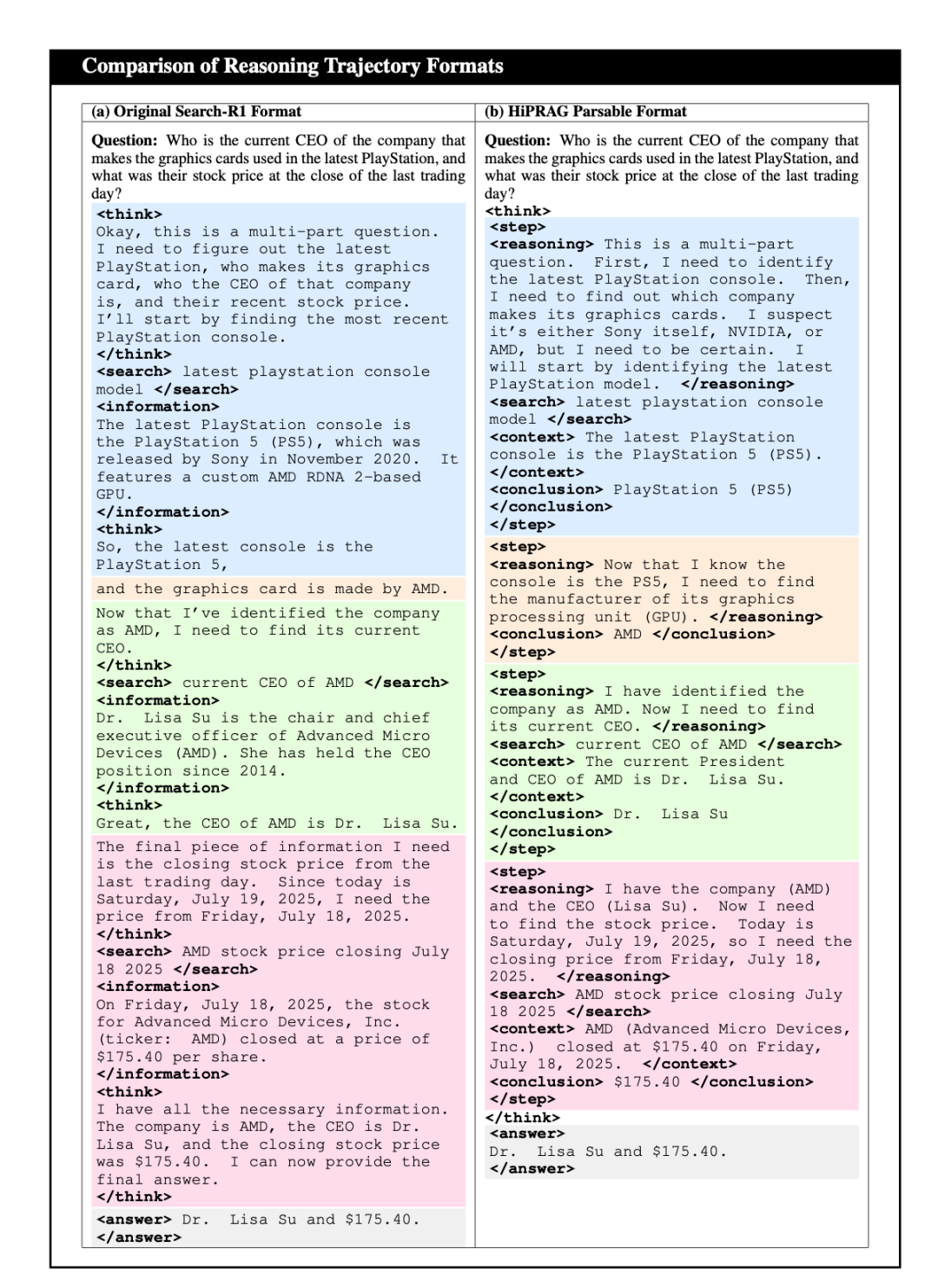

论文用的方法是设计一个prompt template,让llm生成的reasoning trajectory 自己带上 tag。

首先,step分为 search step和 thinking(non-search) step两类,前者格式是(r, q, c, o),后者格式是(r, o),r是llm thinking的内容,q是生成的search query, c是search feedback, o是summary或者部分conclusion。

这样看,一条完整的reasoning trajectory可以表示为{step_1, step_2, …, step_N, answer}。

读到这里,再结合下图基本就能看懂。

2.step-level reward

有了step数据了,如何确定step reward呢?

对于search step, 将(r, q, c, o)中的q (search query)取出来,让llm直接生成一个response o’,再用另一个llm评估o和o’,如果o和o‘相同,那么显然这次 search行为是多余的,判定为over-search。

对于non-search step,用另一个llm评估 (r, o)中r和o的关联(逻辑+事实准确性),如果o不准确,认为llm内部知识不足以生成o,应该去search,判定为under-search。

3.reward function设计

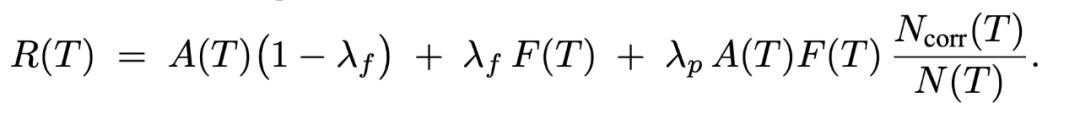

answer reward A(T)和reasoning trajectory format reward F(T)还是继续保留的,最终reward function如下:

N(T)是trajectory中step数量,N_corr(T)是既没有over-search也没有under-search的step数量,lambda_p是process reward的权重,lambda_f是format reward权重,如果令lambda_p=0,就是主流的outcome-based RLVR形式。

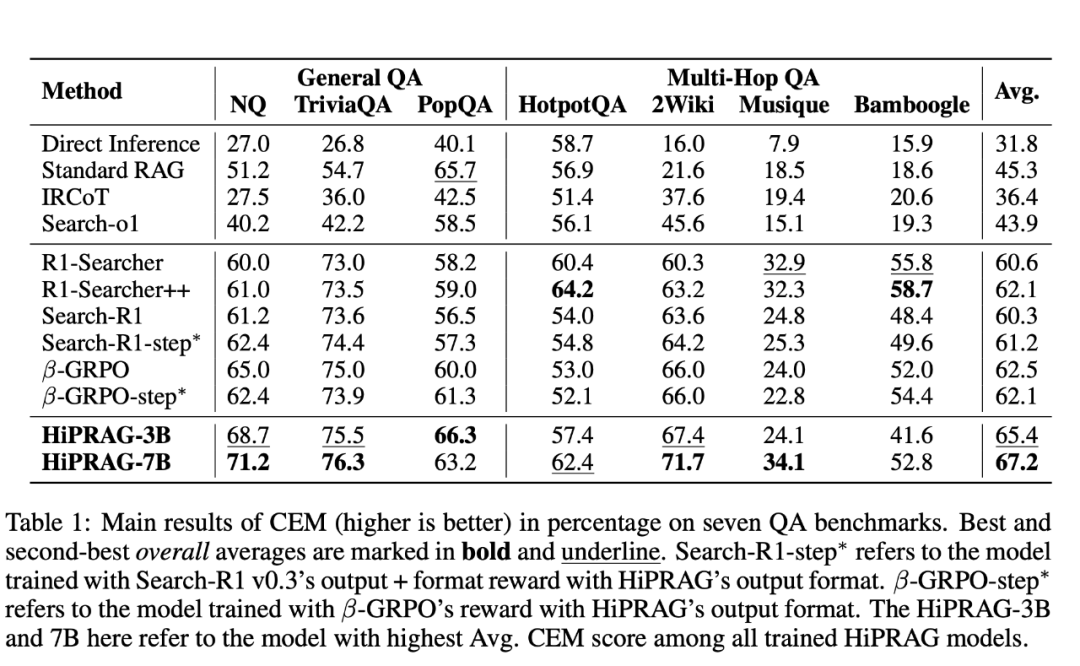

二、实验

实验部分就不细讲了,实验结论中有一条很有应用价值,那就是训练后的search效率极大提升,减少了不少的over search行为。毕竟search 很贵又耗时。

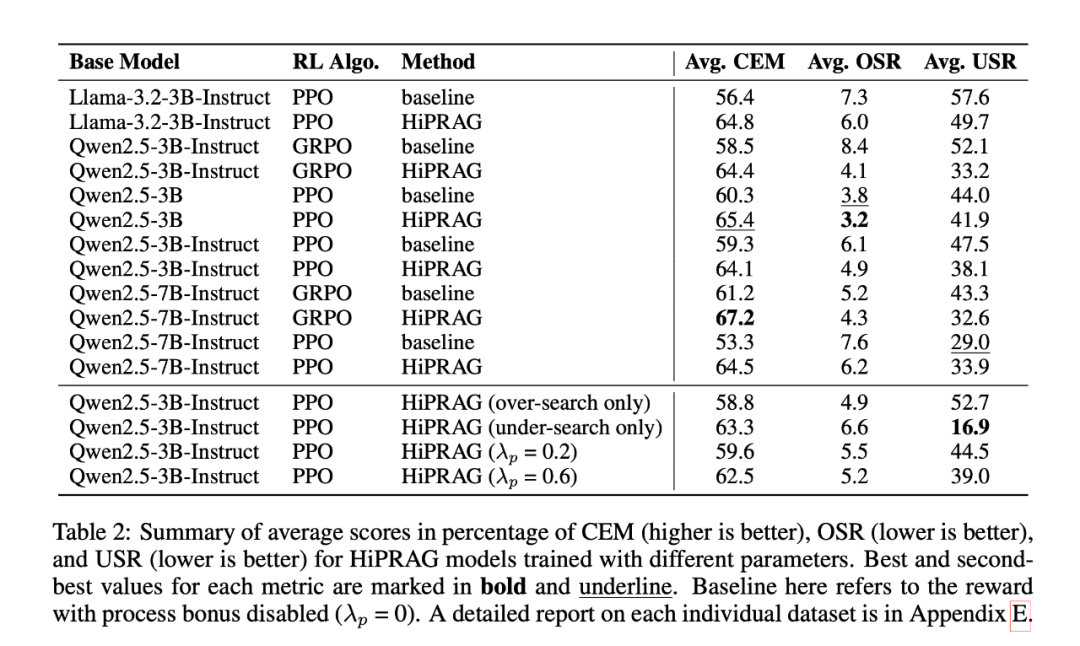

直接看表格吧:

三、总结

论文设计了一种step-level的process reward,结合outcome-based RLVR训练 search agent,能否提升agent的 search 效率,减少over-search和under-search。

search engine是非常非常重要的一类tool,如果llm能合理使用,对web agent/deep research agent类应用意义重大。

那么,如何系统的去学习大模型LLM?

作为一名深耕行业的资深大模型算法工程师,我经常会收到一些评论和私信,我是小白,学习大模型该从哪里入手呢?我自学没有方向怎么办?这个地方我不会啊。如果你也有类似的经历,一定要继续看下去!这些问题啊,也不是三言两语啊就能讲明白的。

所以我综合了大模型的所有知识点,给大家带来一套全网最全最细的大模型零基础教程。在做这套教程之前呢,我就曾放空大脑,以一个大模型小白的角度去重新解析它,采用基础知识和实战项目相结合的教学方式,历时3个月,终于完成了这样的课程,让你真正体会到什么是每一秒都在疯狂输出知识点。

由于篇幅有限,⚡️ 朋友们如果有需要全套 《2025全新制作的大模型全套资料》,扫码获取~

👉大模型学习指南+路线汇总👈

我们这套大模型资料呢,会从基础篇、进阶篇和项目实战篇等三大方面来讲解。

👉①.基础篇👈

基础篇里面包括了Python快速入门、AI开发环境搭建及提示词工程,带你学习大模型核心原理、prompt使用技巧、Transformer架构和预训练、SFT、RLHF等一些基础概念,用最易懂的方式带你入门大模型。

👉②.进阶篇👈

接下来是进阶篇,你将掌握RAG、Agent、Langchain、大模型微调和私有化部署,学习如何构建外挂知识库并和自己的企业相结合,学习如何使用langchain框架提高开发效率和代码质量、学习如何选择合适的基座模型并进行数据集的收集预处理以及具体的模型微调等等。

👉③.实战篇👈

实战篇会手把手带着大家练习企业级的落地项目(已脱敏),比如RAG医疗问答系统、Agent智能电商客服系统、数字人项目实战、教育行业智能助教等等,从而帮助大家更好的应对大模型时代的挑战。

👉④.福利篇👈

最后呢,会给大家一个小福利,课程视频中的所有素材,有搭建AI开发环境资料包,还有学习计划表,几十上百G素材、电子书和课件等等,只要你能想到的素材,我这里几乎都有。我已经全部上传到优快云,朋友们如果需要可以微信扫描下方优快云官方认证二维码免费领取【保证100%免费】

相信我,这套大模型系统教程将会是全网最齐全 最易懂的小白专用课!!

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?