《大规模语言模型:从理论到实践》是一本由复旦大学计算机科学技术学院张奇教授领衔的团队编写的书籍,该书于2024年1月由电子工业出版社出版。 这本书不仅基于作者团队在自然语言处理领域的深厚研究经验,还融合了分布式系统和并行计算的教学经验,旨在帮助读者深入理解大语言模型的原理,并提供实际操作的指导和案例。

有需要这本

《大规模语言模型:从理论到实践》书籍PDF文档,可以微信扫描下方优快云官方认证二维码,免费领取

一、本书主要内容

本书围绕大语言模型构建的四个主要阶段——预训练、有监督微调、奖励建模和强化学习展开,详细介绍各阶段使用的算法、数据、难点及实践经验。

-

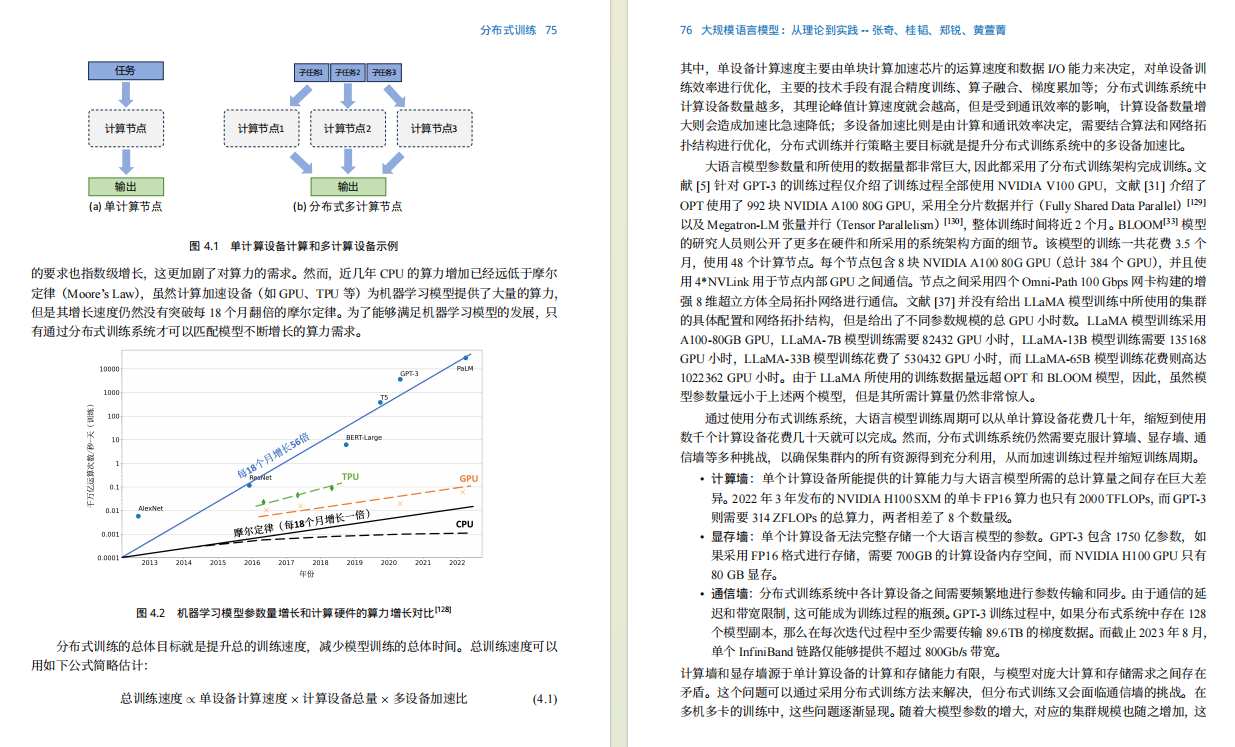

预训练阶段 需要利用包含数千亿甚至数万亿单词的训练数据,并借助由数千块高性能GPU 和高速网络组成的超级计算机,花费数十天完成深度神经网络参数的训练。这一阶段的难点在于如何构建训练数据,以及如何高效地进行分布式训练。

-

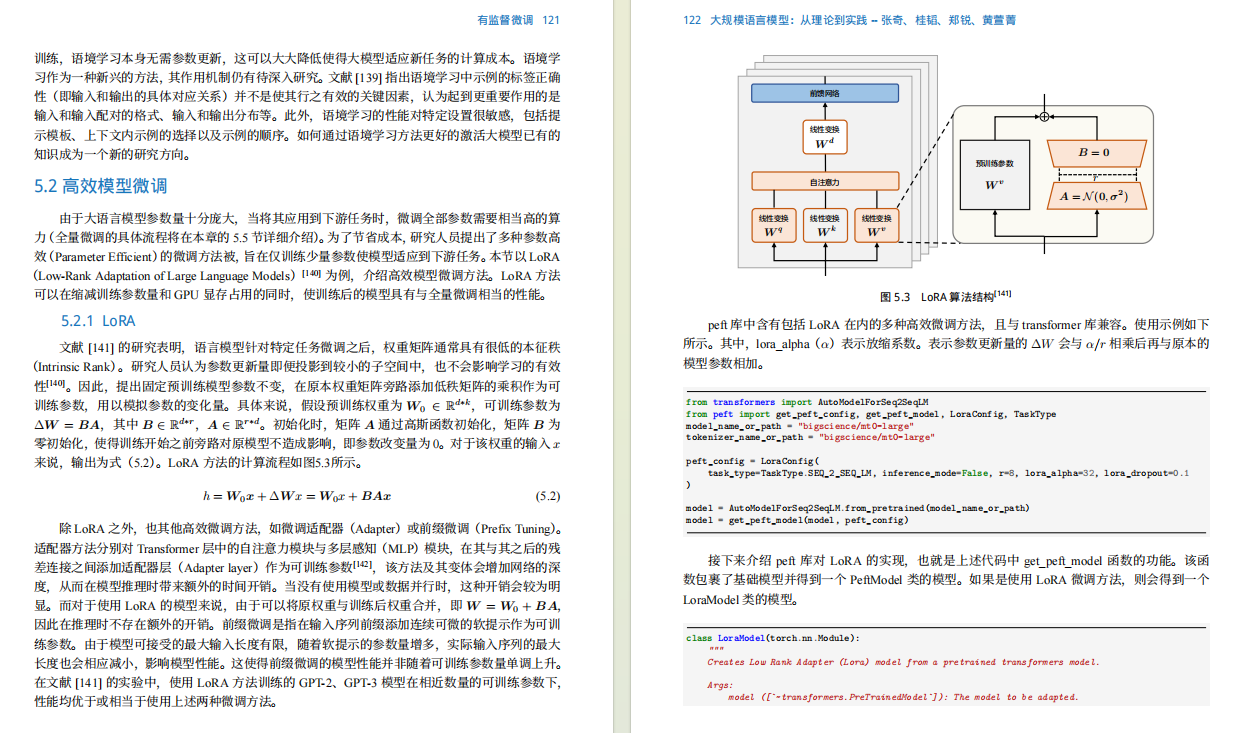

有监督微调阶段 利用少量高质量的数据集,其中包含用户输入的提示词和对应的理想输出结果。提示词可以是问题、闲聊对话、任务指令等多种形式和任务。这个阶段是从语言模型向对话模型转变的关键,其核心难点在于如何构建训练数据,包括训练数据内部多个任务之间的关系、训练数据与预训练之间的关系及训练数据的规模。

-

奖励建模阶段的目标是构建一个文本质量对比模型,用于对有监督微调模型对于同一个提示词给出的多个不同输出结果进行质量排序。这一阶段的难点在于如何限定奖励模型的应用范围及如何构建训练数据。

-

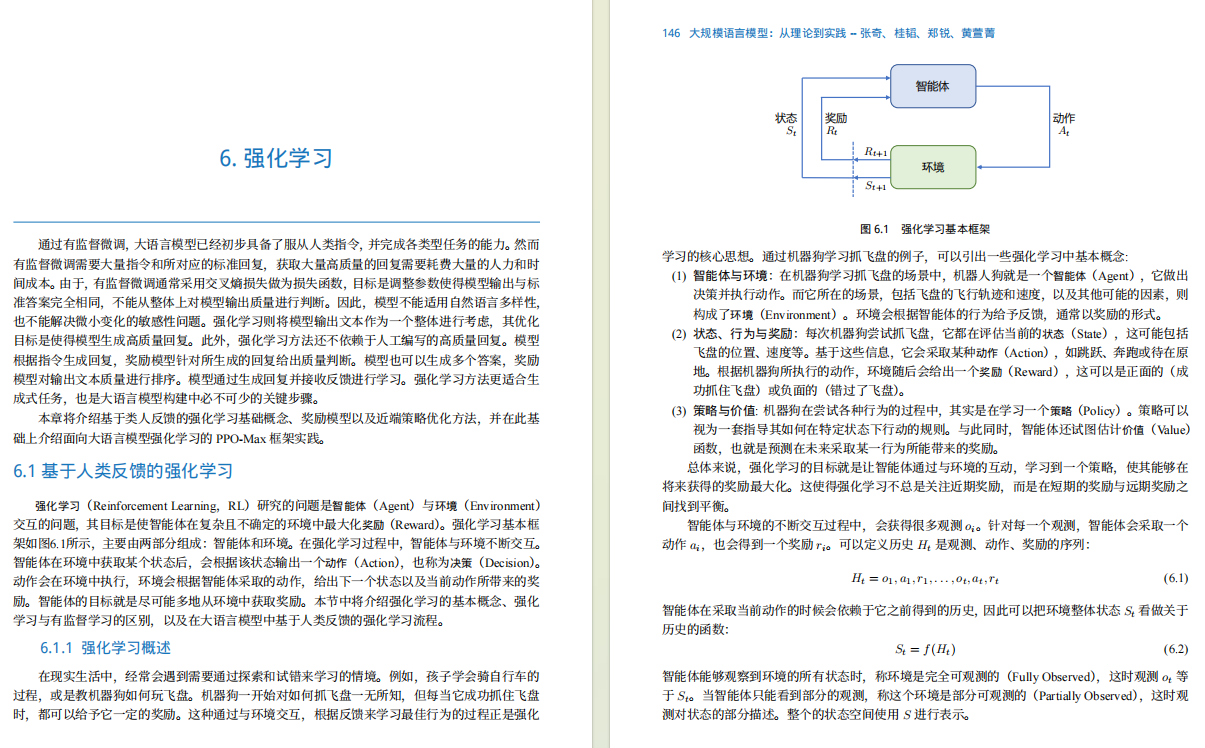

强化学习阶段,根据数十万提示词,利用前一阶段训练的奖励模型,对有监督微调模型对用户提示词补全结果的质量进行评估,与语言模型建模目标综合得到更好的效果。这一阶段的难点在于解决强化学习方法稳定性不高、超参数众多及模型收敛困难等问题。

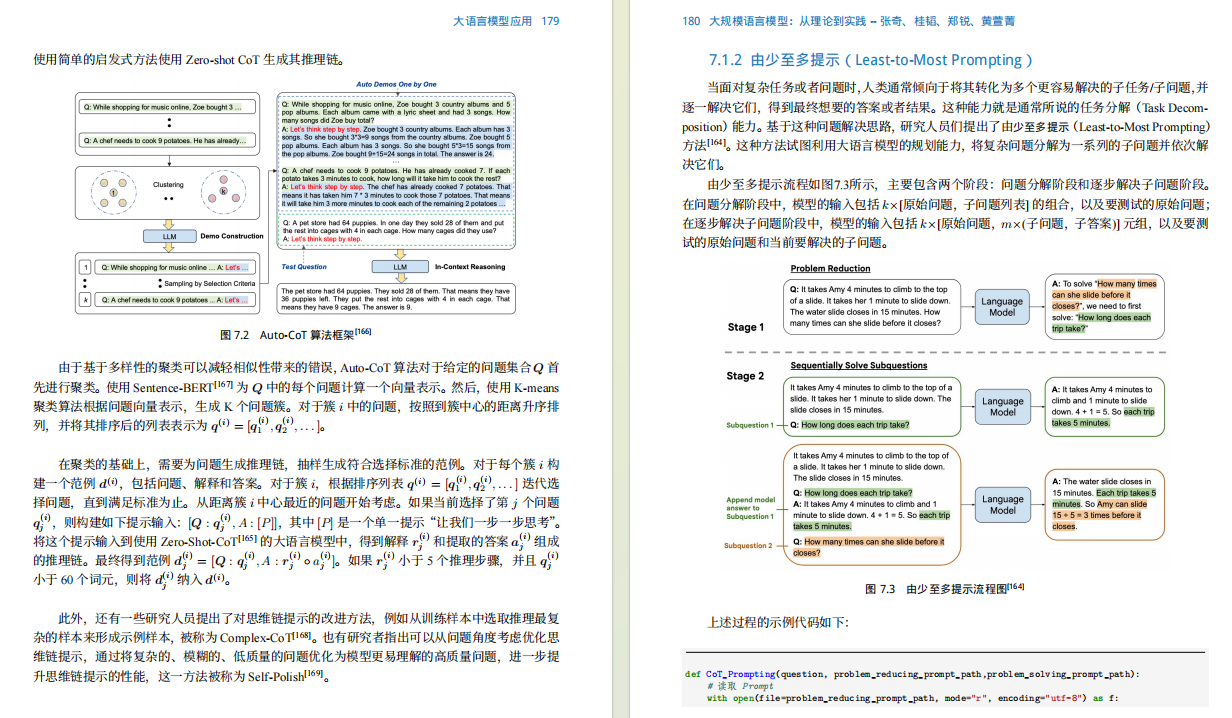

除了大语言模型的构建,本书还介绍了大语言模型的应用和评估方法,主要内容包括如何将大语言模型与外部工具和知识源进行连接、如何利用大语言模型进行自动规划,完成复杂任务,以及针对大语言模型的各类评估方法。

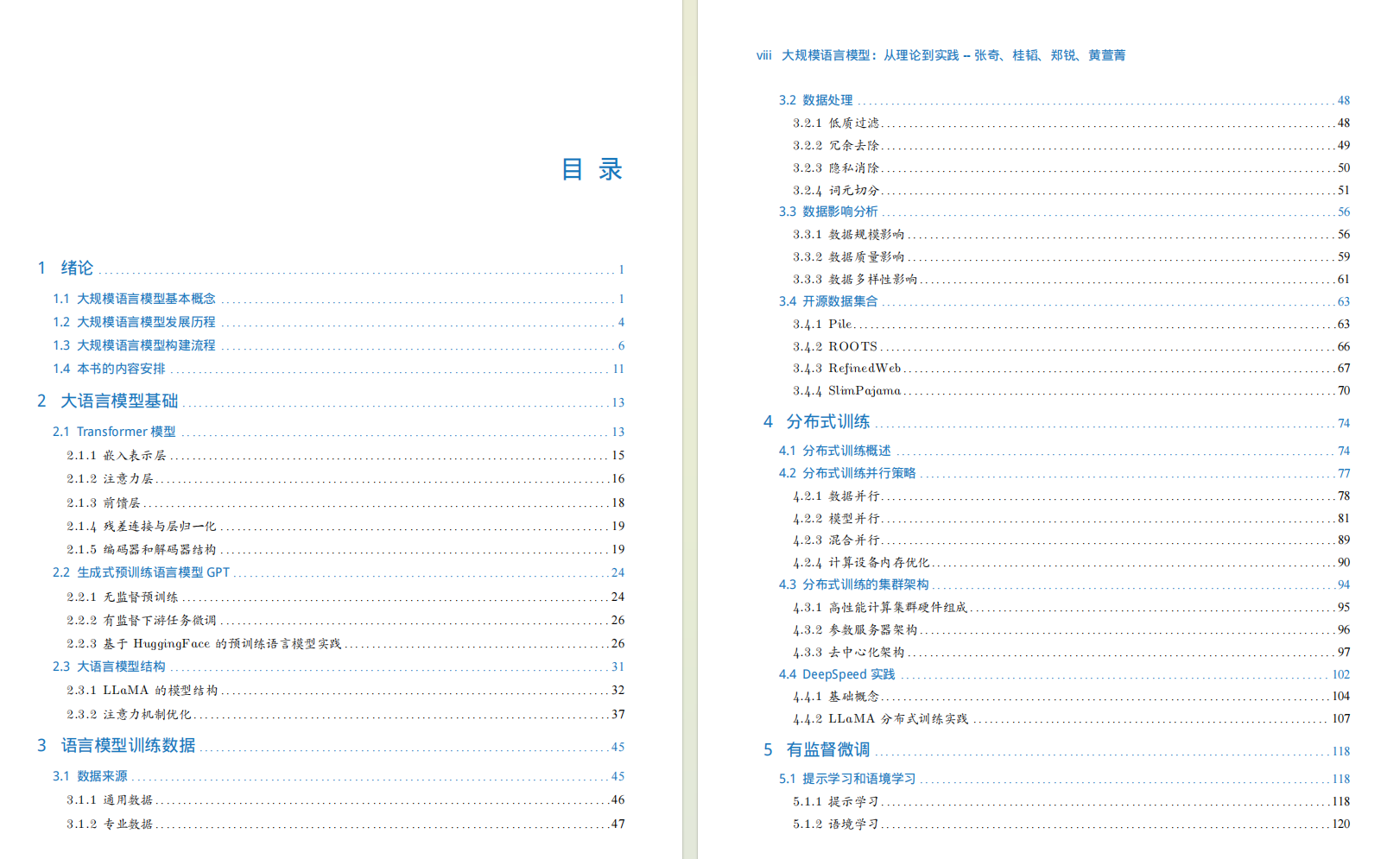

二、书籍目录

第一章 绪论

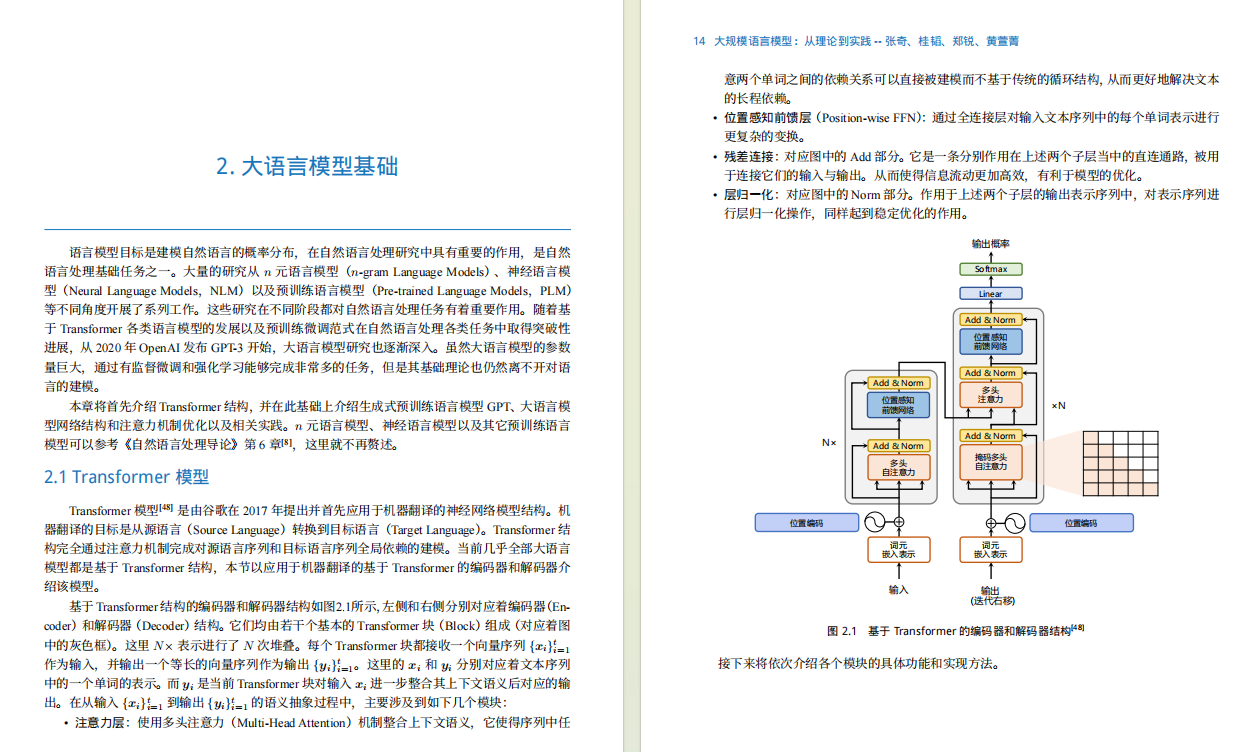

第二章 大语言模型基础

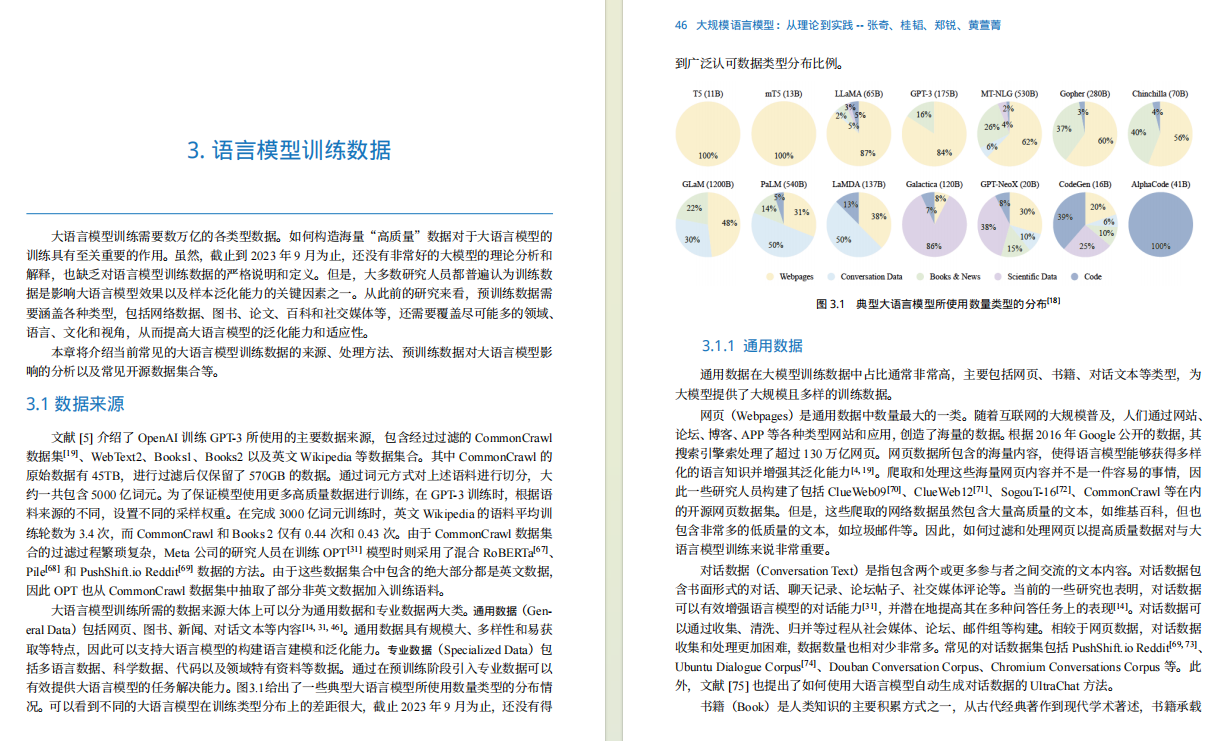

第三章 大语言模型预训练数据

第四章 分布式模型训练

第五章 有监督微调

第六章 强化学习

第七章 大语言模型应用

第八章 大语言模型评估

有需要这本

《大规模语言模型:从理论到实践》书籍PDF文档,可以微信扫描下方优快云官方认证二维码,免费领取

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?