阅读本文你将收获什么?

🔍 深入理解 Transformer 架构和注意力机制

📚 掌握 预训练语言模型的基本原理

🧠 了解 现有大模型的基本结构

🚀 实战学习 RAG、Agent 等前沿技术

内容介绍

| 章节 | 关键内容 | 状态 |

|---|---|---|

| 第一章 NLP基础概念 | 什么是NLP、发展历程、任务分类、文本表示演进 | ✅ |

| 第二章 Transformer架构 | 注意力机制、Encoder-Decoder | loading |

| 第三章 预训练语言模型 | Encoder-only、Encoder-Decoder、Decoder-Only模型对比 | loading |

| 第四章 大语言模型 | LLM 定义、训练策略、涌现能力分析 | loading |

| 第五章 大模型应用 | 模型评测、RAG 检索增强、Agent 智能体 | loading |

第一章:NLP基础概念

1.1 什么是 NLP

核心定义:

自然语言处理(NLP)是人工智能的重要分支,旨在使计算机能够理解、解释和生成人类语言,实现人机自然交互。它结合了计算机科学、人工智能、语言学和心理学等多学科知识,目标是打破人机语言障碍。

关键任务与应用:

-

- 基础任务:

- • 中文分词、子词切分、词性标注

- • 文本分类、实体识别、关系抽取

- • 文本摘要、机器翻译、自动问答

-

- 深层目标:

不仅处理语言的表层结构,还需理解语义、语境、情感和文化等复杂因素。

技术演进与挑战:

- • 技术进步:

深度学习通过大规模数据训练,使模型在多项任务上达到或超越人类水平(如机器翻译、情感分析)。 - • 现存挑战:

语言歧义性、抽象概念理解(如隐喻、讽刺)仍是难点,需通过更先进的算法和大规模数据解决。

1.2 NLP 发展历程

1. 早期探索(1940s-1960s)

- • 起源:

二战后机器翻译需求兴起,1950年图灵提出图灵测试(机器能否通过对话模仿人类)。 - • 理论基础:

诺姆·乔姆斯基提出生成语法理论,影响早期机器翻译设计。 - • 局限:

依赖简单词序规则和词典,翻译效果不佳。

2. 符号主义与统计方法(1970s-1990s)

- • 两大阵营:

- • 符号主义:基于形式语法和手写规则。

- • 统计方法:引入概率模型,利用语料库统计规律。

- • 技术突破:

1980年代算力提升,统计模型(如隐马尔可夫模型)逐步取代复杂规则系统。

3. 机器学习与深度学习(2000s至今)

- • 关键里程碑:

- • 2000s:循环神经网络(RNN)、长短时记忆网络(LSTM)处理序列数据。

- • 2013:Word2Vec 提出词向量表示,解决词汇语义关联问题。

- • 2018:BERT 模型引领预训练语言模型浪潮,支持上下文感知。

- • 近年:Transformer架构(如GPT-3)生成高质量文本,接近人类写作水平。

- • 影响:

深度学习推动NLP在翻译、摘要、问答等任务上实现突破性进展。

NLP发展关键转折表

| 阶段 | 核心技术 | 代表模型 | 能力特点 |

|---|---|---|---|

| 早期探索(1950s) | 规则系统 | Georgetown-IBM | 词对词翻译 |

| 统计方法(1990s) | HMM/概率模型 | IBM Candide | 基于语料库的翻译 |

| 深度学习(2010s) | Word2Vec/LSTM | Seq2Seq, ELMo | 动态语义表示 |

| 预训练模型(2018) | Transformer | BERT, GPT-2 | 通用文本理解 |

| LLM时代(2022+) | 千亿参数+RLHF | GPT-4, LLaMA-3 | 通用人工智能雏形 |

总结

- • 规律:从规则驱动 → 数据驱动 → 预训练通用化 → 规模智能化。

- • 当前挑战:幻觉问题(生成不实内容)、长文本处理、多模态对齐。

- • 未来方向:更低成本训练(MoE架构)、具身智能(机器人交互)、可解释性

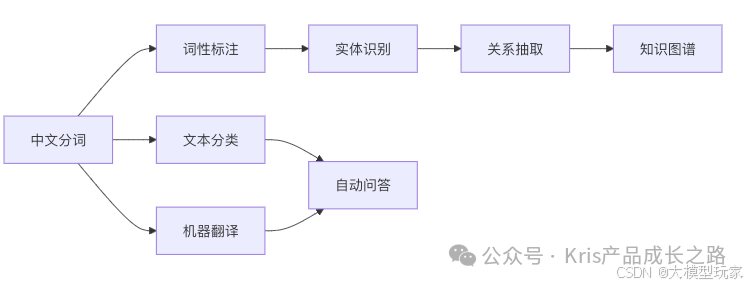

1.3 NLP 核心任务总览

在NLP的广阔研究领域中,有几个核心任务构成了NLP领域的基础,它们涵盖了从文本的基本处理到复杂的语义理解和生成的各个方面。这些任务包括但不限于中文分词、子词切分、词性标注、文本分类、实体识别、关系抽取、文本摘要、机器翻译以及自动问答系统的开发。每一项任务都有其特定的挑战和应用场景,它们共同推动了语言技术的发展,为处理和分析日益增长的文本数据提供了强大的工具。

目标:将原始文本转化为结构化信息,支撑高级语言理解与应用。

任务层级:从基础文本处理 → 语义理解 → 生成与交互。

1.3.1 九大任务详解

1. 中文分词(Chinese Word Segmentation)

-

• 问题:中文无空格分隔,需划分连续字符为有意义的词

示例:输入:"今天天气真好" → 输出:["今天", "天气", "真", "好"] 错误案例:"雍和宫"误切为["雍", "和宫"](破坏地名实体) -

• 挑战:歧义切分(如"研究生命"→[“研究”,“生命”] vs [“研究生”,“命”])、未登录词识别

-

• 重要性:后续所有任务(如词性标注、实体识别)的基础

2. 子词切分(Subword Segmentation)

- • 目标:将单词分解为更小子词单位,解决罕见词处理问题

- • 方法:

- • BPE:合并高频字符对(如

un + happi + ness = unhappiness) - • WordPiece:基于概率合并子词(BERT 采用)

- • SentencePiece:跨语言统一处理

- • BPE:合并高频字符对(如

- • 价值:

✅ 缓解词汇稀疏问题(OOV词分解为已知子词)

✅ 支撑 BERT/GPT 等预训练模型

3. 词性标注(Part-of-Speech Tagging)

-

• 任务:为每个词标注语法类别(名词/动词/形容词等)

示例:"She/PRP is/VBZ playing/VBG" # PRP=代词, VBZ=动词第三人称, VBG=动名词 -

• 方法:

- • 传统:HMM(隐马尔可夫模型)、CRF(条件随机场)

- • 现代:BiLSTM + CRF

-

• 意义:句法分析的基础,帮助识别歧义(如"book"可为名词或动词)

4. 文本分类(Text Classification)

-

• 目标:将文本映射到预定义类别

-

• 典型场景:

应用领域 输入示例 类别输出 新闻分类 “湖人勇士季后赛对决” 体育 情感分析 “这部电影太糟糕了” 负面 垃圾邮件检测 “限时优惠!点击领取奖金” 垃圾邮件 -

• 技术演进:TF-IDF + SVM → 深度学习(CNN、LSTM、Transformer)

5. 实体识别(Named Entity Recognition, NER)

-

• 任务:识别文本中特定意义的实体并分类

-

• 实体类型:人名、地点、组织、日期、时间等

示例:输入:"李雷2024年去北京大学" → 输出: [("李雷", "PERSON"), ("2024年", "DATE"), ("北京大学", "ORG")] -

• 标注方法:BIO 体系(Begin, Inside, Outside)

-

• 难点:实体歧义(如"苹果"指公司还是水果?)

6. 关系抽取(Relation Extraction)

-

• 目标:识别实体间的语义关系

-

• 关系类型:创始人-公司、地理位置、亲属关系等

示例:输入:"马云创立阿里巴巴" → 输出:("马云", "创始人", "阿里巴巴") -

• 意义:构建知识图谱的核心技术(实体 + 关系 = 知识三元组)

7. 文本摘要(Text Summarization)

| 类型 | 原理 | 示例(原文:火星探测器着陆新闻) |

|---|---|---|

| 抽取式摘要 | 直接选取原文关键句 | “我国火星探测器成功着陆,标志深空探测重大进展” |

| 生成式摘要 | 理解语义后重新生成新句子 | “天问一号着陆火星,中国深空探测迈出关键一步” |

- • 技术:抽取式(TextRank算法)→ 生成式(Seq2Seq+Attention)

8. 机器翻译(Machine Translation)

- • 核心挑战:

- • 语言结构差异(如中文省略主语,英文需补全)

- • 文化隐喻处理(如"雨后春笋"需意译而非直译)

- • 技术演进:

- • 早期:基于规则 → 统计翻译(SMT)

- • 现代:神经机器翻译(NMT)如 Transformer

9. 自动问答(Automatic Question Answering)

-

• 系统类型:

类型 数据源 示例场景 检索式问答 文档库(如维基百科) 搜索引擎答案 知识库问答 结构化知识图谱 “姚明的妻子是谁?” 社区问答 用户生成内容(论坛/QA) 知乎式问答 -

• 流程:问题解析 → 信息检索 → 答案生成

1.3.2 任务关联与应用

说明:

- • 基础任务(分词、词性标注)是上游基石

- • 语义任务(实体识别、关系抽取)支撑知识构建

- • 生成任务(摘要、翻译、问答)直接服务应用场景

1.4 文本表示的核心目标

文本表示的目的是将人类语言的自然形式转化为计算机可以处理的形式,也就是将文本数据数字化,使计算机能够对文本进行有效的分析和处理。文本表示是 NLP 领域中的一项基础性和必要性工作,它直接影响甚至决定着 NLP 系统的质量和性能。

解决根本问题:将人类语言转化为机器可计算的数值形式,同时保留语义信息。

关键需求:

- • 保留语义和结构信息

- • 平衡计算效率与表达能力

- • 适应下游任务(分类、翻译、问答等)

1.4.1 向量空间模型(Vector Space Model, VSM)

| 维度 | 核心说明 |

|---|---|

| 核心原理 | - One-Hot编码:词表大小 → 维向量(词对应位置为1,其余为0) - 加权扩展:TF-IDF计算词权重 文档总数包含该词的文档数 |

| 典型示例 | 句子:“雍和宫的荷花很美”(词表大小16,384维) 向量表示:[0,0,...,1(雍和宫),0,...,1(的),...,1(美)](仅5个非零值) |

| 突破性贡献 | ✅ 首次实现文本数值化 ✅ 支撑文本相似度计算(余弦相似度) ✅ 应用于早期搜索引擎(如倒排索引) |

| 致命缺陷 | ❌ 稀疏性:99.97%元素为0(存储/计算浪费) ❌ 语义缺失:无法表达词间关系(如"汽车"与"车辆"无关) ❌ 维度灾难:词表增长导致维度爆炸 |

优化方向:特征选择(卡方检验)+ 权重优化(TF-IDF变体)

1.4.2 N-gram语言模型

| 维度 | 核心说明 |

|---|---|

| 核心原理 | 马尔可夫假设:第 个词概率仅依赖前 个词() - |

| 常见类型 | - Unigram ():今天天气 - Bigram ():天气今天好天气 - Trigram ():好今天天气 |

| 训练方式 | 统计语料库中词序列频次: |

| 核心价值 | ✅ 捕捉局部词序(如"强烈推荐"≠"推荐强烈") ✅ 支撑概率型任务(语音识别、输入法) |

| 本质缺陷 | ❌ 数据稀疏:长序列频次≈0(如4-gram在10亿语料中仅覆盖2.5%) ❌ 泛化无能:无法处理未出现组合(如"量子计算"未在训练集出现) ❌ 上下文盲区:忽略窗口外依赖(如句首词影响句尾) |

典型应用:Google搜索纠错(“you"输错为"tou” → 用bigram修正为"you")

1.4.3 Word2Vec(2013里程碑)

| 维度 | 核心说明 |

|---|---|

| 革命性创新 | 将 高维稀疏 → 低维稠密 向量(通常200-500维) |

| 两大架构 | - CBOW (Continuous Bag-of-Words):上下文预测中心词- Skip-gram:中心词预测上下文(更擅长罕见词) |

| 语义奇迹 | 向量空间捕获语义规律: - 国王男人女人王后 - 北京中国法国巴黎 |

| 显著优势 | ✅ 解决稀疏性问题(密集向量) ✅ 相似词聚类(cos(“汽车”,“车辆”)≈0.92) ✅ 计算高效(负采样加速训练) |

| 遗留挑战 | ❌ 静态向量:忽略上下文("苹果"公司 vs 水果同一向量) ❌ 局部窗口:无法建模长文本依赖 |

数学本质:神经网络隐层权重矩阵 (=词表大小,=嵌入维度)

1.4.4 ELMo(2018动态词向量革命)

| 维度 | 核心说明 |

|---|---|

| 核心突破 | 首次实现 一词多义动态表示: - "银行"在句子中含义不同 → 生成不同向量 |

| 技术架构 | 双向LSTM语言模型1. *预训练*:用大规模语料训练双向语言模型 2. *下游适配*:提取各层向量加权组合 |

| 上下文感知 | 融合左右双向信息: - 前向LSTM: - 后向LSTM: |

| 多任务优势 | ✅ 一词多义精准区分("bank"财务/河岸) ✅ 显著提升NER、问答等任务效果 ✅ 开启预训练+微调范式 |

| 性能代价 | ❌ 训练成本极高(双向LSTM串行计算) ❌ 长文本处理效率低(LSTM记忆衰减) |

直接遗产:为Transformer/BERT提供技术铺垫(动态编码+预训练思想)

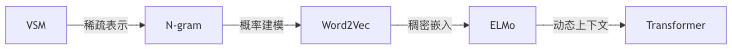

1.4.5 技术演进关键对比

| 能力 | VSM | N-gram | Word2Vec | ELMo |

|---|---|---|---|---|

| 语义相似度 | ❌ | ❌ | ✅ | ✅⭐ |

| 一词多义处理 | ❌ | ❌ | ❌ | ✅ |

| 长距离依赖建模 | ❌ | ❌(窗口小) | ❌ | ⚠️(LSTM受限) |

| 计算效率 | ✅(检索快) | ✅(统计快) | ✅(负采样) | ❌(LSTM慢) |

| 下游任务泛化能力 | ❌ | ⚠️ | ✅ | ✅⭐ |

核心范式转变:

- • 2013前:人工特征工程(TF-IDF/N-gram)

- • 2013后:数据驱动表示学习(Word2Vec→ELMo→BERT)

- • 关键转折:ELMo证明上下文感知是语义理解的核心钥匙

普通人如何抓住AI大模型的风口?

领取方式在文末

为什么要学习大模型?

目前AI大模型的技术岗位与能力培养随着人工智能技术的迅速发展和应用 , 大模型作为其中的重要组成部分 , 正逐渐成为推动人工智能发展的重要引擎 。大模型以其强大的数据处理和模式识别能力, 广泛应用于自然语言处理 、计算机视觉 、 智能推荐等领域 ,为各行各业带来了革命性的改变和机遇 。

目前,开源人工智能大模型已应用于医疗、政务、法律、汽车、娱乐、金融、互联网、教育、制造业、企业服务等多个场景,其中,应用于金融、企业服务、制造业和法律领域的大模型在本次调研中占比超过 30%。

随着AI大模型技术的迅速发展,相关岗位的需求也日益增加。大模型产业链催生了一批高薪新职业:

人工智能大潮已来,不加入就可能被淘汰。如果你是技术人,尤其是互联网从业者,现在就开始学习AI大模型技术,真的是给你的人生一个重要建议!

最后

只要你真心想学习AI大模型技术,这份精心整理的学习资料我愿意无偿分享给你,但是想学技术去乱搞的人别来找我!

在当前这个人工智能高速发展的时代,AI大模型正在深刻改变各行各业。我国对高水平AI人才的需求也日益增长,真正懂技术、能落地的人才依旧紧缺。我也希望通过这份资料,能够帮助更多有志于AI领域的朋友入门并深入学习。

真诚无偿分享!!!

vx扫描下方二维码即可

加上后会一个个给大家发

大模型全套学习资料展示

自我们与MoPaaS魔泊云合作以来,我们不断打磨课程体系与技术内容,在细节上精益求精,同时在技术层面也新增了许多前沿且实用的内容,力求为大家带来更系统、更实战、更落地的大模型学习体验。

希望这份系统、实用的大模型学习路径,能够帮助你从零入门,进阶到实战,真正掌握AI时代的核心技能!

01 教学内容

-

从零到精通完整闭环:【基础理论 →RAG开发 → Agent设计 → 模型微调与私有化部署调→热门技术】5大模块,内容比传统教材更贴近企业实战!

-

大量真实项目案例: 带你亲自上手搞数据清洗、模型调优这些硬核操作,把课本知识变成真本事!

02适学人群

应届毕业生: 无工作经验但想要系统学习AI大模型技术,期待通过实战项目掌握核心技术。

零基础转型: 非技术背景但关注AI应用场景,计划通过低代码工具实现“AI+行业”跨界。

业务赋能突破瓶颈: 传统开发者(Java/前端等)学习Transformer架构与LangChain框架,向AI全栈工程师转型。

vx扫描下方二维码即可

本教程比较珍贵,仅限大家自行学习,不要传播!更严禁商用!

03 入门到进阶学习路线图

大模型学习路线图,整体分为5个大的阶段:

04 视频和书籍PDF合集

从0到掌握主流大模型技术视频教程(涵盖模型训练、微调、RAG、LangChain、Agent开发等实战方向)

新手必备的大模型学习PDF书单来了!全是硬核知识,帮你少走弯路(不吹牛,真有用)

05 行业报告+白皮书合集

收集70+报告与白皮书,了解行业最新动态!

06 90+份面试题/经验

AI大模型岗位面试经验总结(谁学技术不是为了赚$呢,找个好的岗位很重要)

07 deepseek部署包+技巧大全

由于篇幅有限

只展示部分资料

并且还在持续更新中…

真诚无偿分享!!!

vx扫描下方二维码即可

加上后会一个个给大家发

3578

3578

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?