今天跟大家聊一下大模型的底层原理,文章会分三个层级介绍语言大模型,从小白的极简角度,到入门,到初级逐渐深入。

极简级

上面是deepseek的对话界面,我们现在肯定都经常使用,当我们输入一段话给的deepseek之后,它是如何回答我们的呢?

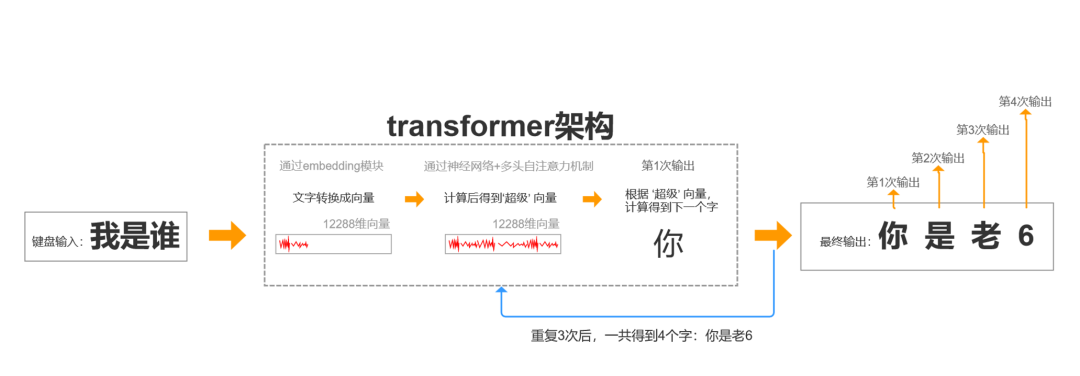

这个就是它的底层原理,我们输入一个一段对话,大模型会思考如何回答我们,最终给我们输出一个答案。

它的思考框架就是transformer,可以简单理解为一个概率,你输入的内容,比如“我是谁”,它本质上会有好些答案“比如“你是张三”,“你是李四”,“你是老6”,它会计算哪个跟你输入的内容更匹配,然后会把这个答案给你。

入门级

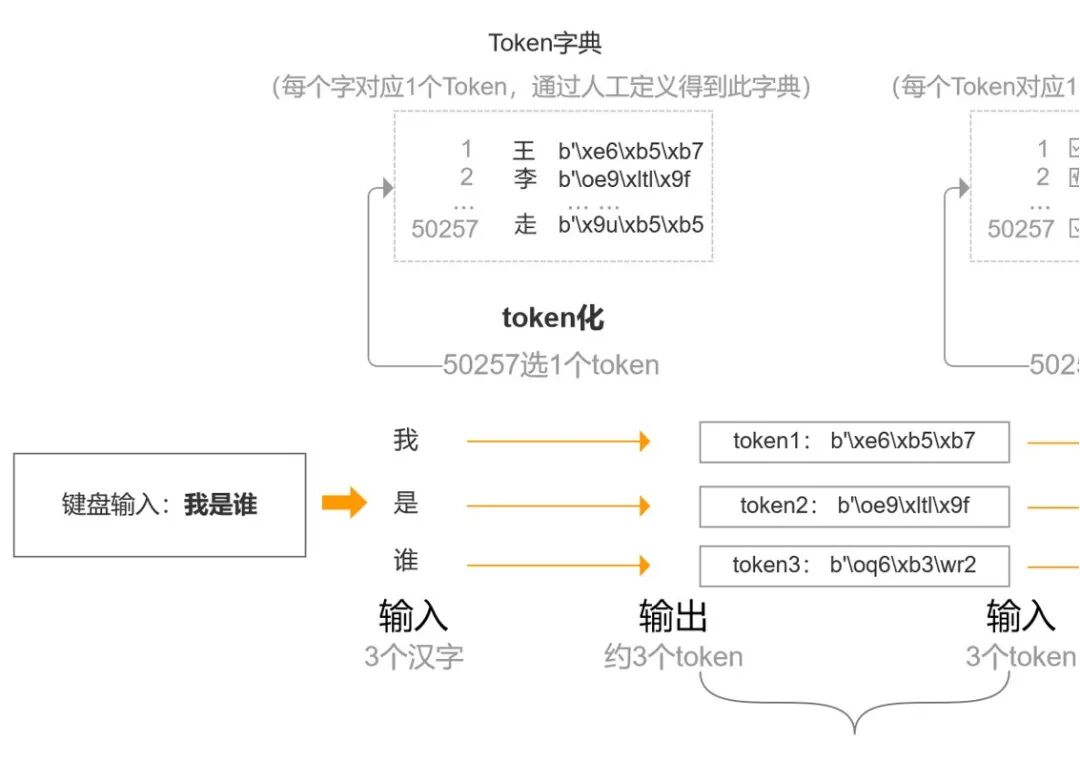

当我们向大模型输入“我是谁”之后,会先把这几个字转化成为token,这个token可以接单理解为字典中的字及字代表的含义,至于怎么输入的内容要怎么拆,计算机科学家有一个共识,就是相当于出了一本字典。

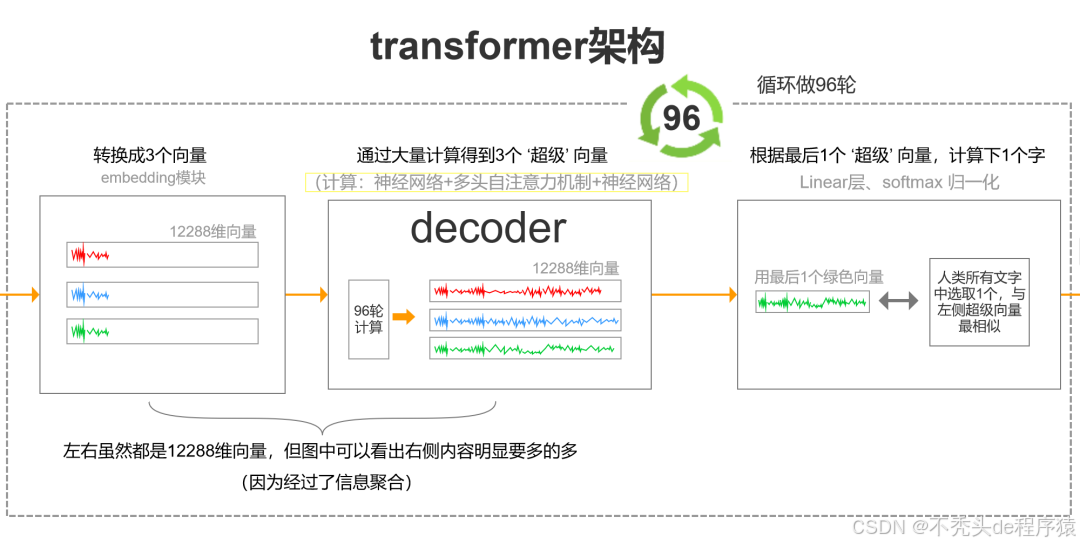

每个拆分的token,再转化成一个数学向量,计算机讲究的是万物可计算,把文字内容转为为数学向量之后,向量与向量之间就可以进行计算了。

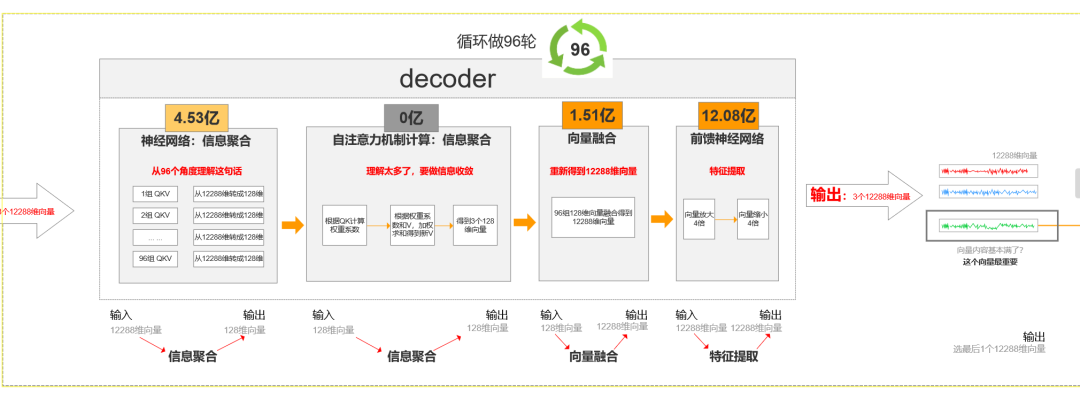

这个计算过程要用到神经网络,然后再加上多头自注意力机制——可以简单理解为一个团队同时做事。

- 成员1:快速浏览全文,抓取主旨(如“这篇文章讲AI”);

- 成员2:细读关键段落,理解细节(如“AI如何改变医疗”);

- 成员3:标记关键词关系(如“AI”与“算法”的关联)。

- 每个“头”独立工作,最终汇总所有视角,形成全面理解,得出一个答案

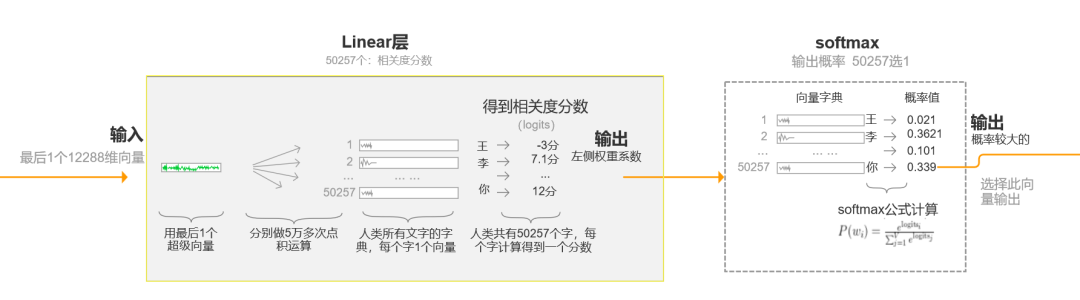

每一层神经网络就走一次,然后这样就有多个答案,最终再计算每个答案的概率,选择概率最高的输出给用户。

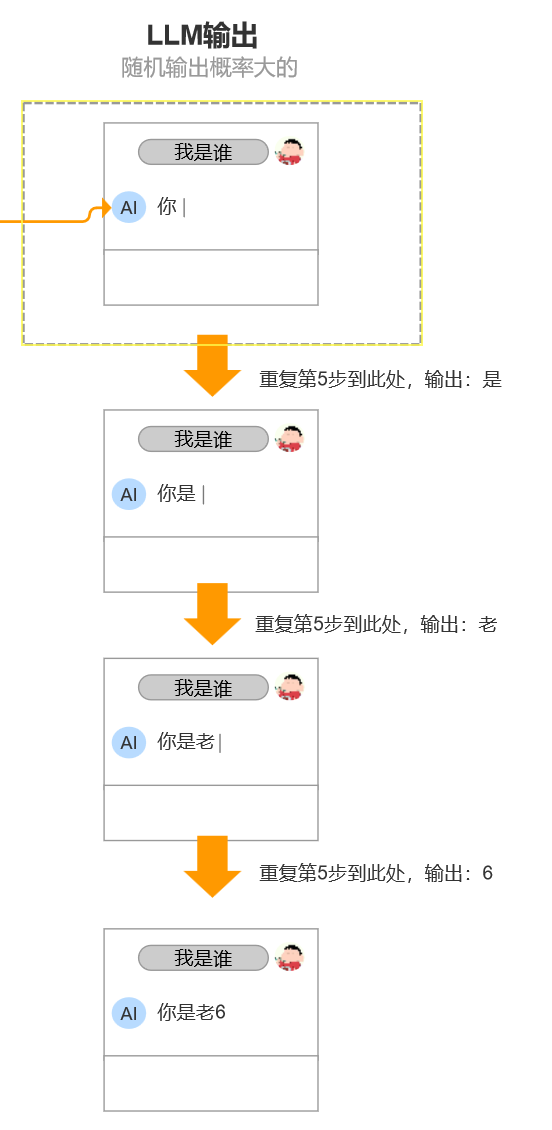

输出给用户的答案不是一下子给全部内容,而是一个字一个字的输出。如果有些大模型输出的比较慢,就可以很清晰的看到它是一个字一个字的蹦出来

初级

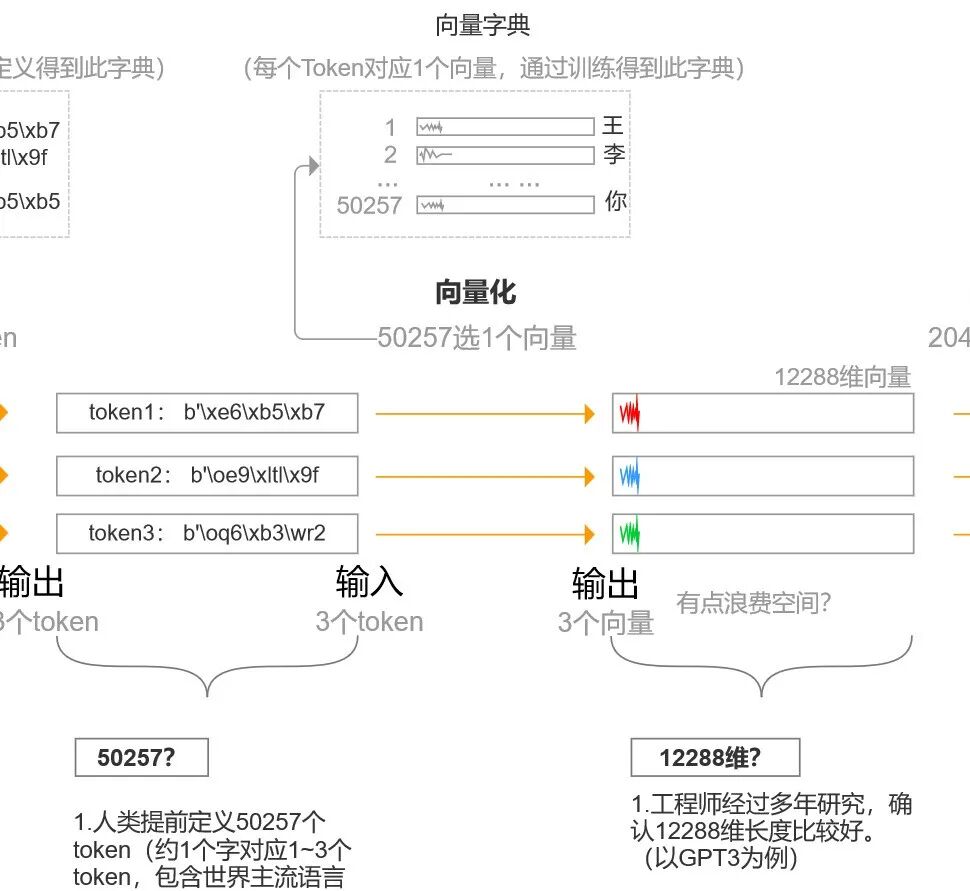

我们从这张图中可以进一步看出,计算机科学家编辑的字典有50257个token,我们输入的内容对比字典进行拆分,然后对应相应的token,每个token有对应的编码。

然后我们将token进行向量化,也就是将每个token对应一个向量,目前是一个向量有12288个维度。也就是我们可以从12288个维度来解读这个token,从12288个方面来解读,维度越多,我们对一个事物的解读就越准确。

比如,我们面前站了1个人,我们只从性别看,就只有男女(LGBT别来)。如果我们再加一个年龄,我们就不光说是男是女,还可以说多大,然后我们再加学历,再加国家等。我们加的维度越多,我们对这个人的认知就越多,我们对这个人就越了解,我们心里就能逐步把这个人的画像描述的越清楚。

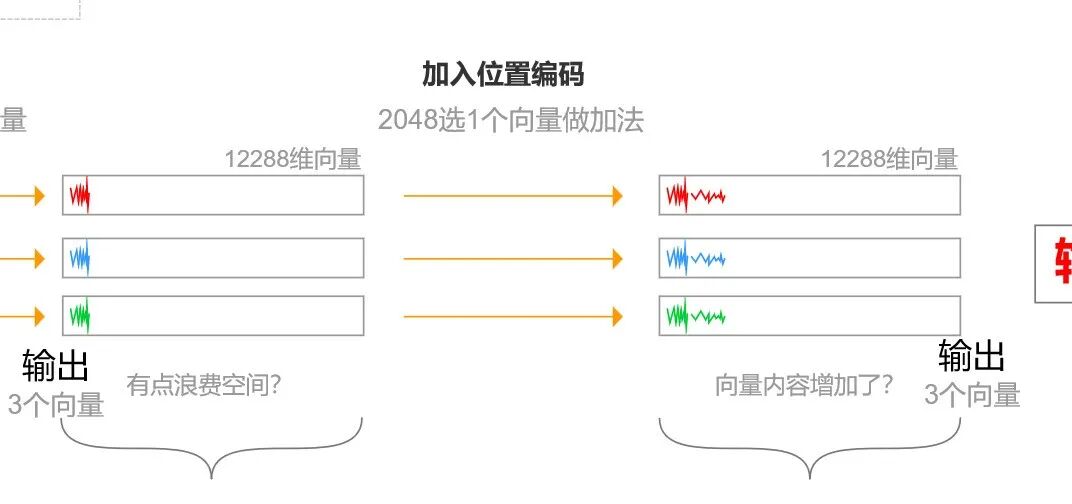

通过将token进行向量化,我们能够能够进行token之间的计算了。但是我们的原始文本内容是有顺序的,所以我们也要把token的位置表示出来,所以我们要加一个位置编码进去。

这样我们不仅仅能够知道token的信息,还能知道它在整个内容中的位置,我们知道位置,才知道进行计算的先后顺序。

接下来我们就要进行token向量化之后的计算,整个计算过程如下:

然后我们将所有计算出来的可能的答案赋予一个权重,进一步计算每个答案的概率,最终选择一个概率最大的字作为输出。

最终的输出如下所示,我们输出第一个字之后,这个字又会成为我们第一次输入的内容其它的新的内容一并输入给大模型。也就是每次新输出的内容都会当做下一轮除原始输入内容其它的输入内容来作为大模型的输入资料。

总结

LLM语言大模型的原理就是它根据我们的输入,经过计算,得出一个概率最大的结果。

想象你正在玩一个超级智能的“文字接龙”游戏

输入一句话(比如“今天天气”),模型会像预测下一个词一样,疯狂计算“好”“真”“很”等词出现的概率,最终选最可能的一个(比如“好”)

不断重复:把“好”拼回去,变成“今天天气好”,再预测下一个词(比如“啊”),直到生成完整句子

为什么它能“像人一样说话”?

海量数据训练:模型像读完了2600年人类写的书,学会了“猫吃鱼”比“鱼吃猫”更常见

数学函数:它本质是一个巨型“概率计算器”,维度越多,预测越准

**没有“思考”**:只是根据统计规律拼词,但人类会误以为它有智慧

位置编码:像给每个词贴“座位号”,否则模型分不清“我打你”和“你打我”

普通人如何抓住AI大模型的风口?

领取方式在文末

为什么要学习大模型?

目前AI大模型的技术岗位与能力培养随着人工智能技术的迅速发展和应用 , 大模型作为其中的重要组成部分 , 正逐渐成为推动人工智能发展的重要引擎 。大模型以其强大的数据处理和模式识别能力, 广泛应用于自然语言处理 、计算机视觉 、 智能推荐等领域 ,为各行各业带来了革命性的改变和机遇 。

目前,开源人工智能大模型已应用于医疗、政务、法律、汽车、娱乐、金融、互联网、教育、制造业、企业服务等多个场景,其中,应用于金融、企业服务、制造业和法律领域的大模型在本次调研中占比超过 30%。

随着AI大模型技术的迅速发展,相关岗位的需求也日益增加。大模型产业链催生了一批高薪新职业:

人工智能大潮已来,不加入就可能被淘汰。如果你是技术人,尤其是互联网从业者,现在就开始学习AI大模型技术,真的是给你的人生一个重要建议!

最后

只要你真心想学习AI大模型技术,这份精心整理的学习资料我愿意无偿分享给你,但是想学技术去乱搞的人别来找我!

在当前这个人工智能高速发展的时代,AI大模型正在深刻改变各行各业。我国对高水平AI人才的需求也日益增长,真正懂技术、能落地的人才依旧紧缺。我也希望通过这份资料,能够帮助更多有志于AI领域的朋友入门并深入学习。

真诚无偿分享!!!

vx扫描下方二维码即可

加上后会一个个给大家发

大模型全套学习资料展示

自我们与MoPaaS魔泊云合作以来,我们不断打磨课程体系与技术内容,在细节上精益求精,同时在技术层面也新增了许多前沿且实用的内容,力求为大家带来更系统、更实战、更落地的大模型学习体验。

希望这份系统、实用的大模型学习路径,能够帮助你从零入门,进阶到实战,真正掌握AI时代的核心技能!

01 教学内容

-

从零到精通完整闭环:【基础理论 →RAG开发 → Agent设计 → 模型微调与私有化部署调→热门技术】5大模块,内容比传统教材更贴近企业实战!

-

大量真实项目案例: 带你亲自上手搞数据清洗、模型调优这些硬核操作,把课本知识变成真本事!

02适学人群

应届毕业生: 无工作经验但想要系统学习AI大模型技术,期待通过实战项目掌握核心技术。

零基础转型: 非技术背景但关注AI应用场景,计划通过低代码工具实现“AI+行业”跨界。

业务赋能突破瓶颈: 传统开发者(Java/前端等)学习Transformer架构与LangChain框架,向AI全栈工程师转型。

vx扫描下方二维码即可

本教程比较珍贵,仅限大家自行学习,不要传播!更严禁商用!

03 入门到进阶学习路线图

大模型学习路线图,整体分为5个大的阶段:

04 视频和书籍PDF合集

从0到掌握主流大模型技术视频教程(涵盖模型训练、微调、RAG、LangChain、Agent开发等实战方向)

新手必备的大模型学习PDF书单来了!全是硬核知识,帮你少走弯路(不吹牛,真有用)

05 行业报告+白皮书合集

收集70+报告与白皮书,了解行业最新动态!

06 90+份面试题/经验

AI大模型岗位面试经验总结(谁学技术不是为了赚$呢,找个好的岗位很重要)

07 deepseek部署包+技巧大全

由于篇幅有限

只展示部分资料

并且还在持续更新中…

真诚无偿分享!!!

vx扫描下方二维码即可

加上后会一个个给大家发

1069

1069

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?