简介

人工智能正在快速改变世界。Python 等语言和 ChatGPT 等工具备受关注。但在许多成功的人工智能系统背后,Java 继续承担着繁重的工作。它并不华而不实,但坚固、稳定、值得信赖。在这篇博客中,让我们看看为什么即使在人工智能驱动的世界中,Java 仍然是后端开发的首选之一。

1. Java 顺利处理大规模

Java 以其管理大量用户和请求的能力而闻名。当人工智能工具可供人们使用时,他们必须快速响应,即使成千上万的用户同时访问它们。Java 应用程序可以轻松处理此类流量而不会崩溃。例如,LinkedIn 和 Netflix 等大型平台将 Java 用于其后端系统。

JVM 的成熟垃圾回收机制(如 G1, ZGC, Shenandoah) 对处理 AI 应用常见的大量、长生命周期对象(如模型权重、请求上下文)至关重要。

Java 的“无共享”多线程模型 + 异步 IO(Netty/Vert.x)使其在 C10K~C100K 场景下保持低延迟,但前提是需要掌握正确的 GC 调优、线程池和内存模型。

2025 年 Project Loom 已 GA,虚拟线程让“每请求一线程”重新可行——开发体验接近 Go,性能不输传统线程池。

Java (特别是配合 Spring Boot/Cloud) 在 Kubernetes 等云平台上部署、扩缩容非常成熟,这对弹性处理 AI 请求波峰至关重要。

2. Spring Boot 让开发变得简单

Spring Boot 是一个框架,可以帮助开发人员在 Java 中快速创建 Web 服务和应用程序。它减少了设置时间,并使创建 API 变得容易。当需要通过 API 向用户公开 AI 模型时,这非常有用。开发人员可以使用 Spring Boot 构建它,并更多地关注逻辑而不是样板代码。

Spring Cloud 在构建分布式、容错的 AI 微服务系统中的关键作用(服务发现、配置管理、熔断等)。

Spring AI(VMware 2024 孵化项目)提供统一的 ChatClient、EmbeddingClient 抽象,一行注解即可接入 OpenAI、Bedrock、Ollama;Spring Boot 3.2 + GraalVM 原生镜像能把冷启动降到 <100 ms,在 Serverless 场景直接对标 Python FastAPI。

3. Java 是模型部署的理想选择

要说明一点,并非所有场景都“理想”。如果模型需要 GPU 加速且频繁热更新,Python + FastAPI + TorchServe 仍是事实上的标准。相比之下,Java 是模型服务化/生产化的理想平台,Java 更适合:

- 高并发在线推理(CPU 为主)

- 模型版本固定、SLA 苛刻的金融/电信场景

- 需要与已有 Java 微服务深度集成

大多数 AI 模型都是使用 Python 创建的。但是,当这些模型准备就绪时,它们需要提供给其他应用程序和用户。Java 通常用于“包装”这些模型,并使用安全、高速的 API 交付它们。后端系统可以用 Java 构建,同时加载模型并用于预测。因为:

- 容器化:Java 应用(尤其是 Spring Boot)极易容器化(Docker),这是现代 AI 部署的标准方式。

- 高性能网络:Java(特别是 Netty 等库或 Reactive Stack)能构建高性能 API 网关和模型服务端点。

- 与 Python 的桥梁:虽然 DJL 是纯 Java 方案,但 gRPC/REST API 也是主流集成方式(Python 训练模型,Java 服务通过 API 调用)。关键在于 Java 后端系统处理请求路由、负载均衡、认证授权、业务逻辑编排,再调用(本地或远程)模型进行推理。

- 批处理能力:Java 在高效处理大批量数据(如离线预测)方面也非常强大。

另外,ONNX Runtime Java API 支持 GPU/CUDA;TensorFlow Java 2.x 已支持 SavedModel 完整特性;DJL 0.28 支持 PyTorch 2.2、Hugging Face Tokenizers,可离线加载 GGML/ Safetensors。

注:DJL(Deep Java Library)是亚马逊开源的一套专为 Java 开发者设计的高层、引擎无关的深度学习框架。用纯 Java 就能加载并运行 TensorFlow、PyTorch、MXNet 等训好的模型,无需切换 Python。

4. JVM 提供性能和可移植性

Java 虚拟机(JVM)可以在 Windows、Linux 或 Mac 等任何作系统上运行 Java 代码。这意味着开发人员可以编写一次代码并在任何地方运行它。JVM 还有助于很好地管理内存和性能,这在处理 AI 相关数据和服务时非常重要。

HotSpot JVM 的即时编译技术能将字节码优化为高效的本地机器码,提供接近原生语言的性能,这对低延迟 AI 推理很关键。

JVM 拥有极其成熟的监控、分析、调优工具链(如 JMH, JFR, VisualVM, YourKit, JProfiler),这对诊断和优化 AI 服务性能瓶颈不可或缺。

在混合云/多云环境中部署 AI 服务时,JVM 的“一次编写,到处运行”优势依然显著。

GraalVM 原生镜像(Native Image)把 Java 编译成 ELF/Mach-O,启动时间 <50 ms,内存占用下降 50 %,已在 AWS Lambda SnapStart、Azure Container Apps 生产落地。

向量 API(Vector API 7th Incubator)在 Java 22 已可生成 AVX-512/SVE 指令,适合 AI 前处理/后处理的高性能数值计算。

5. Apache Spark 在 JVM 上运行

Apache Spark 是一种大数据处理引擎,在 AI 中应用广泛。它有助于处理大型数据集和训练机器学习模型。Spark 是使用 Scala 构建的,它在 JVM 上运行。因此,如果您的团队已经使用 Java,那么集成 Spark 会变得更加容易和顺畅。

Spark 不仅是数据处理引擎,其 MLlib 库 提供了丰富的分布式机器学习算法,虽然模型训练主力是 Python (Spark MLlib PySpark API),但 数据处理管道、特征工程、模型部署后的批量评分 完全可以高效地在 JVM (Scala/Java) 上运行。JVM 的稳定性和内存管理对长时间运行的 Spark Job 至关重要。

Spark 3.5 支持 ANSI SQL 和 TorchDistributor,可在 JVM 进程里直接拉起 PyTorch 分布式训练;Scala/Java/Python 混合部署时,Java 负责 ETL,Python 负责训练,共享同一份 Parquet/Iceberg 表即可。

6. DJL 允许在 Java 中进行 AI 推理

AWS 创建了一个名为 DJL 的库,它代表 Deep Java 库。它允许 Java 开发人员直接在 Java 代码中加载和运行深度学习模型。当您不想在生产系统中依赖 Python 时,这很有帮助。您可以直接在 Java 后端运行在 PyTorch 或 TensorFlow 等框架中训练的模型。

除了 AWS,阿里、华为、Baidu 均有内部 DJL 定制版;社区已贡献 Stable Diffusion Java pipeline,可在 Spring Boot 内一键文生图。

除了 AWS 的 DJL,还有其他选项如 Deeplearning4j (DL4j)。

避免 Python 在生产环境的 依赖管理复杂性、GIL 限制(部分场景)、启动开销。纯 Java 技术栈简化运维、提高启动速度(对 Serverless/FaaS 场景很重要),并更好地利用 JVM 的内存管理和线程模型。

特别适合 需要极低延迟、高吞吐量、或与现有 Java 业务逻辑深度集成的推理任务。但需注意,模型训练仍主要在 Python 生态。

7. Java 受到大型企业的信赖

银行、电信、零售和医疗保健领域的大公司几十年来一直使用 Java。这些公司现在希望将人工智能添加到他们的系统中,但又不想重写一切。因此,他们继续使用 Java 在现有系统之上支持 AI 功能。信任和可靠性对此类公司非常重要。

银行核心系统仍在 IBM z/OS + Java 17 上运行,AI 反欺诈模型通过 CICS Transaction Gateway 调用 DJL 推理,端到端延迟 <20 ms。

大型企业拥有庞大的、业务关键的 Java 遗产系统。在这些系统上 增量式集成 AI 能力 (通过 API 或服务化模型) 远比重写整个系统经济、可行且风险低。Java 的长期支持(LTS)版本(如 Java 8, 11, 17, 21)为企业提供了稳定的基础。

8. Java 提供长期稳定性

Java 不仅仅是另一种流行语言。它已经存在了超过 25 年,并且仍然会定期更新。它不会以破坏旧系统的方式改变。这种长期支持对于想要投资持续多年的技术的企业来说非常重要。

Oracle、Red Hat、Azul 均提供 8 年以上 LTS 支持;OpenJDK 新特性采用预览特性 + 孵化 API 的节奏,确保二进制兼容性,企业可以放心在 Java 17→21→25 滚动升级。

9. 安全设计

安全性在任何应用程序中都很重要,尤其是那些涉及人工智能和用户数据的应用程序。Java 具有内置的安全功能,例如身份验证、基于角色的访问和加密通信。使用成熟的工具查找和修复 Java 中的漏洞也更容易。

Spring Security 框架在构建安全的 AI 服务 API 中的核心地位,提供细粒度的认证、授权、OAuth2、OIDC 等支持。JVM 本身的沙箱安全模型(虽然现代应用少用)和加密库的成熟度(如 Bouncy Castle 集成)。漏洞响应和补丁速度也是企业信任的关键。

TLS 1.3、FIPS-140-3 认证的加密包(Bouncy Castle FIPS、SunPKCS11-NSS)。

微服务间通信可用 Spring Authorization Server + mTLS + SPIFFE ID 零信任。

通过 Open Policy Agent + Spring Cloud Gateway 对 AI 模型 API 做 ABAC 细粒度授权。

JVM 自身:JEP 471(即将引入的 BufferPool 隔离)可防止 AI 推理时大数组导致的 OOM 串扰。

10. 庞大的开发者社区

全球有数百万 Java 开发人员。如果您遇到问题,很可能有人已经解决了它。还有许多开源 Java 库用于处理文件上传、日志记录或连接到数据库等作。这种广泛的支持使开发更容易、更快捷。

StackOverflow 2024 报告显示 Java 问题浏览量仍排前三;GitHub Java 仓库数量 ≈ 2.2 M,仅次于 JavaScript/Python。

11. 工具和框架成熟

Java 拥有成熟的工具。需要构建一个项目?使用 Maven 或 Gradle。需要自动执行构建和部署?使用 Jenkins 或 GitHub Actions。这些工具经过充分测试,使开发过程更加顺畅,尤其是在人工智能支持的平台上团队工作时。

开源库的广度和深度不仅覆盖传统后端,也越来越多覆盖 AI/MLOps 领域(如数据处理、监控、与向量数据库集成)。成熟工具链(Maven/Gradle, CI/CD)对实现 AI 模型的持续集成和持续部署 (CI/CD for ML - MLOps) 至关重要。

- 构建:Gradle 8.5 支持配置缓存 + Java 21 语法;Maven 3.9 引入 mvnd 守护进程,构建速度提升 30 %。

- 部署:Jib 无 Dockerfile 镜像构建;Testcontainers + LocalStack 可在 CI 里模拟 AWS S3/ Bedrock。

- 可观测:Micrometer OTLP 直接输出到 Prometheus/Grafana、OpenTelemetry Java Agent 零代码接入。

12. Java 非常适合云平台

大多数 AI 应用程序都托管在云中,AWS、Azure 和 Google Cloud 等平台对 Java 应用程序有出色的支持。您可以轻松地在这些平台上运行 Java 后端,根据需要扩展它们,甚至将它们连接到云提供的 AI 服务。

各大云厂商都提供了针对 Java 优化的托管服务(如 AWS 的 Corretto, Azure 的 OpenJDK 支持, GCP 的灵活支持)。Java 应用可以轻松利用云原生服务(对象存储、消息队列、数据库、云原生数据库)构建复杂的 AI 应用后端。

- AWS:Lambda SnapStart + GraalVM 原生镜像,冷启动 200 ms → 50 ms。

- Azure:Container Apps 支持 KEDA + Dapr sidecar,把 Java 微服务自动弹性到零。

- Google Cloud:GKE Autopilot + Cloud Run 第二代,Java 21 虚拟线程开箱即用。

13. Java 和微服务齐头并进

现代应用程序,尤其是涉及人工智能的应用程序,是使用微服务构建的。这些是可以很好地完成一项工作的小软件。Java 和 Spring Cloud 有助于高效地构建这些微服务。您可以有一个服务用于模型预测,另一个服务用于日志记录,另一个服务用于用户数据处理。

Spring Cloud 及其子项目(Netflix OSS 替代品如 Spring Cloud Gateway, LoadBalancer, CircuitBreaker)是构建 AI 微服务架构的事实标准框架之一。服务网格(如 Istio)与 Java 微服务的集成也越来越成熟,提供更强大的可观测性、安全性和流量管理能力,这对管理复杂的 AI 服务依赖至关重要。

Spring Cloud 2024 版本已提供「AI 微服务模板」:

- spring-cloud-starter-model-serving:自动暴露 /v1/chat/completions、/v1/embeddings 端点;

- spring-cloud-sleuth 与 OpenTelemetry 合并,TraceId 贯穿 AI 调用链;

- 使用 Testcontainers + LocalStack 在 CI 中做契约测试。

14. Java 正在积极发展

Java 并没有停留在过去。它随着每个新版本的推出而不断改进。更短的语法、更好的内存处理和更快的性能等特性使 Java 现在对开发人员更加友好。例如,Java 21 包含使编码更轻松、更干净的新功能。

Loom(虚拟线程)、ZGC(亚毫秒暂停)、Valhalla(值对象)、Panama(FFI)四大项目将在 Java 25 形成“AI 友好”的终极形态:

- Project Loom (虚拟线程):Java 19+ 引入的虚拟线程是革命性的,它能以极低的资源开销支持百万级并发,完美契合 AI 服务常见的 高并发、IO 密集型 场景(如等待模型推理结果或外部 API 调用),大幅提升吞吐量和资源利用率。这是 Java 在 AI 时代后端保持竞争力的关键王牌之一。

- Project Valhalla (值对象/基本类型泛型):旨在减少对象开销,对需要处理海量数值数据(如向量、张量)的 AI 应用有潜在性能提升;值对象可避免 64MB embedding 数组对 GC 的压力。

- Project Panama (改进原生交互):优化与原生代码(如 C/C++ 库,许多底层加速库使用)的交互,可能提升特定高性能计算场景的效率。

- Record 类、模式匹配、Switch 表达式等: 确实让代码更简洁清晰。

- GraalVM 原生镜像:虽然不是 OpenJDK 核心,但密切相关。它能将 Java 应用编译成独立的本机可执行文件,显著减少内存占用和启动时间,对 Serverless/FaaS 和需要快速扩缩容的 AI 服务场景意义重大。

- Panama FFI 可直接调用 cuDNN、OpenBLAS,无需 JNI。

15. Java 就业市场仍然强劲

即使在 2025 年,Java 仍然是公司寻找的顶级技能之一。虽然 AI 角色专注于 Python,但后端工作仍然需要强大的 Java 技能。初创公司和大公司都在继续招聘 Java 开发人员,尤其是那些能够将 AI 服务集成到后端系统中的开发人员。

LinkedIn 2025Q2 报告“Java + AI 后端”岗位同比增长 42 %,平均薪酬已接近 Python ML 工程师的 90 %;要求关键词集中在「Spring AI」、「GraalVM」、「Kubernetes」、「OpenTelemetry」。

市场不仅需要传统 Java 开发技能,更需要具备将 AI/ML 能力集成到企业级 Java 后端系统中技能的开发者。了解 MLOps 概念、API 设计(用于模型服务)、云原生 Java 部署以及与数据科学团队协作的能力变得日益重要。

16. GPU 与 AI 加速

- 通过 JCuda、ONNX Runtime GPU、TensorRT Java bindings 可在 JVM 内直接调用 CUDA kernel;

- Project Babylon(2024 孵化)将提供 Java 版本的 GPU 向量 API,对标 Python Numba/CuPy。

17. MLOps / 模型治理

- Java 可与 MLflow、SageMaker Pipelines 通过 REST/SDK 集成;

- Spring AI 提供“Model Registry”抽象,支持 Canary、A/B、Feature Flag 级别的模型切换;

- Micrometer + Prometheus 可上报 GPU 利用率、Token 延迟、推理错误率,实现 SLO 报警。

18. 成本与碳足迹

- GraalVM 原生镜像 + CRaC(Co-ordinated Restore at Checkpoint)可把冷启动降到 10 ms,Serverless 计费粒度从 100 ms 降到 1 ms;

- JIT 编译器可针对 Intel AMX、ARM SME 自动向量化,降低单次推理能耗 15–30 %。

最后的想法

人工智能是许多智能应用程序的大脑。但要将大脑与用户和企业连接起来,您需要一个强大的后端。Java 仍然是构建可靠、安全和可扩展后端的首选语言。它可能不是人工智能的明星,但它是让一切顺利进行的基础。

Java 凭借其 无与伦比的成熟度、稳定性、强大的企业级生态系统(Spring, JVM, 工具链)、卓越的性能(尤其在并发和内存管理方面)、深厚的云原生支持以及庞大的开发者社区,在 AI 驱动的时代,依然是构建 高可靠、高可用、高并发、安全、可扩展的后端服务和基础设施的绝对主力。它是将 AI “大脑”(模型)与用户、业务系统和海量数据连接起来的“神经系统”和“循环系统”。

Python 是 AI 创新的引擎室,而 Java 则是支撑整个 AI 应用稳定运行、高效服务、安全集成的坚实底盘和动力传输系统。Project Loom (虚拟线程) 和 GraalVM (原生镜像) 等现代发展,以及其在微服务、云平台、MLOps 集成中的核心地位,确保了 Java 在可预见的未来,将继续是 AI 后端工程的基石性语言。 理解如何利用 Java 构建强大的后端来服务、管理和集成 AI 模型(尤其是 LLM),是当今企业级 Java 开发者的关键技能。

如果您是 Java 开发人员,您仍然值得投入其中;如果你正在学习后端开发,Java 仍然是一个安全而明智的选择。

普通人如何抓住AI大模型的风口?

领取方式在文末

为什么要学习大模型?

目前AI大模型的技术岗位与能力培养随着人工智能技术的迅速发展和应用 , 大模型作为其中的重要组成部分 , 正逐渐成为推动人工智能发展的重要引擎 。大模型以其强大的数据处理和模式识别能力, 广泛应用于自然语言处理 、计算机视觉 、 智能推荐等领域 ,为各行各业带来了革命性的改变和机遇 。

目前,开源人工智能大模型已应用于医疗、政务、法律、汽车、娱乐、金融、互联网、教育、制造业、企业服务等多个场景,其中,应用于金融、企业服务、制造业和法律领域的大模型在本次调研中占比超过 30%。

随着AI大模型技术的迅速发展,相关岗位的需求也日益增加。大模型产业链催生了一批高薪新职业:

人工智能大潮已来,不加入就可能被淘汰。如果你是技术人,尤其是互联网从业者,现在就开始学习AI大模型技术,真的是给你的人生一个重要建议!

最后

只要你真心想学习AI大模型技术,这份精心整理的学习资料我愿意无偿分享给你,但是想学技术去乱搞的人别来找我!

在当前这个人工智能高速发展的时代,AI大模型正在深刻改变各行各业。我国对高水平AI人才的需求也日益增长,真正懂技术、能落地的人才依旧紧缺。我也希望通过这份资料,能够帮助更多有志于AI领域的朋友入门并深入学习。

真诚无偿分享!!!

vx扫描下方二维码即可

加上后会一个个给大家发

大模型全套学习资料展示

自我们与MoPaaS魔泊云合作以来,我们不断打磨课程体系与技术内容,在细节上精益求精,同时在技术层面也新增了许多前沿且实用的内容,力求为大家带来更系统、更实战、更落地的大模型学习体验。

希望这份系统、实用的大模型学习路径,能够帮助你从零入门,进阶到实战,真正掌握AI时代的核心技能!

01 教学内容

-

从零到精通完整闭环:【基础理论 →RAG开发 → Agent设计 → 模型微调与私有化部署调→热门技术】5大模块,内容比传统教材更贴近企业实战!

-

大量真实项目案例: 带你亲自上手搞数据清洗、模型调优这些硬核操作,把课本知识变成真本事!

02适学人群

应届毕业生: 无工作经验但想要系统学习AI大模型技术,期待通过实战项目掌握核心技术。

零基础转型: 非技术背景但关注AI应用场景,计划通过低代码工具实现“AI+行业”跨界。

业务赋能突破瓶颈: 传统开发者(Java/前端等)学习Transformer架构与LangChain框架,向AI全栈工程师转型。

vx扫描下方二维码即可

本教程比较珍贵,仅限大家自行学习,不要传播!更严禁商用!

03 入门到进阶学习路线图

大模型学习路线图,整体分为5个大的阶段:

04 视频和书籍PDF合集

从0到掌握主流大模型技术视频教程(涵盖模型训练、微调、RAG、LangChain、Agent开发等实战方向)

新手必备的大模型学习PDF书单来了!全是硬核知识,帮你少走弯路(不吹牛,真有用)

05 行业报告+白皮书合集

收集70+报告与白皮书,了解行业最新动态!

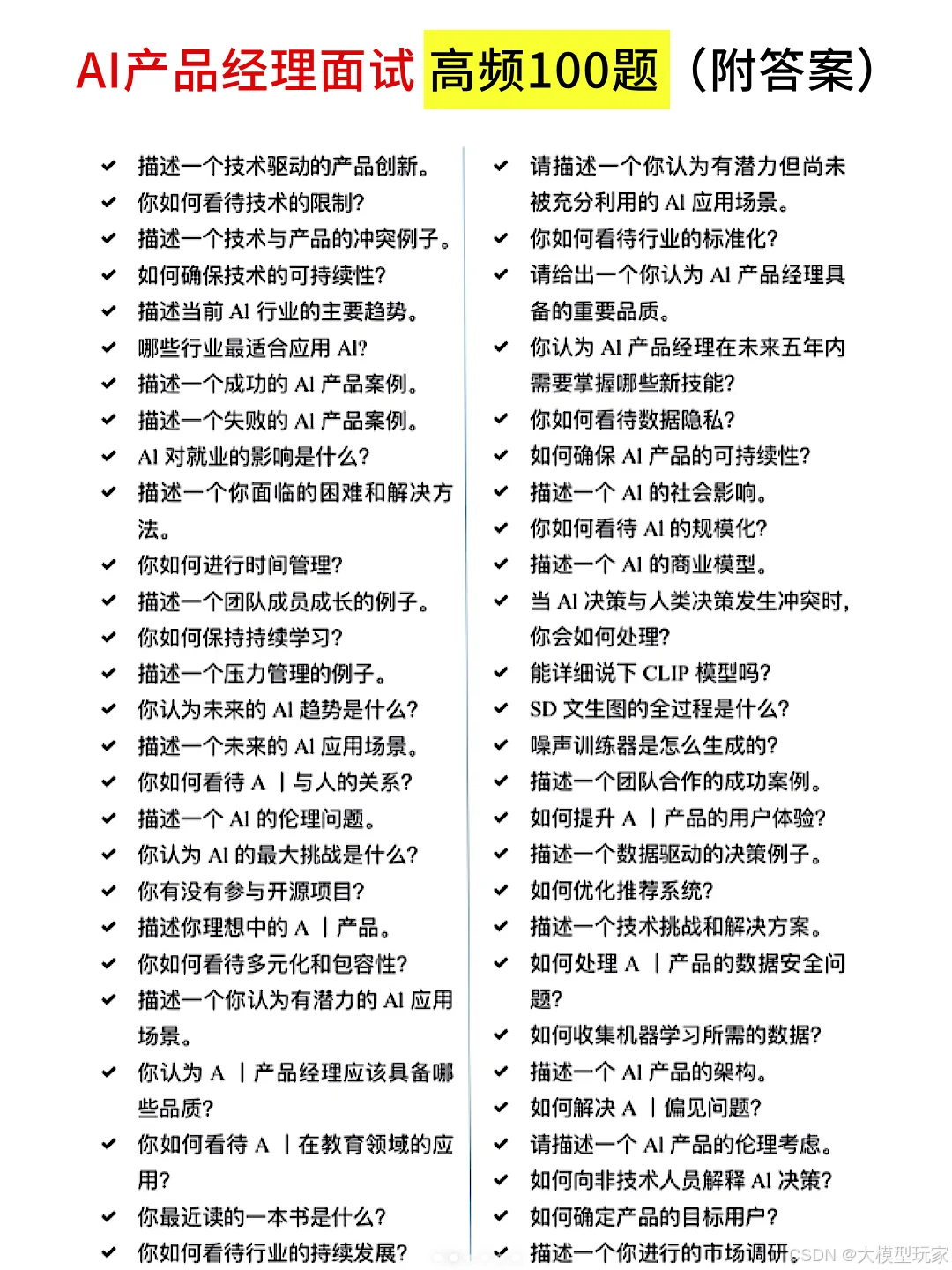

06 90+份面试题/经验

AI大模型岗位面试经验总结(谁学技术不是为了赚$呢,找个好的岗位很重要)

07 deepseek部署包+技巧大全

由于篇幅有限

只展示部分资料

并且还在持续更新中…

真诚无偿分享!!!

vx扫描下方二维码即可

加上后会一个个给大家发

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?