前言

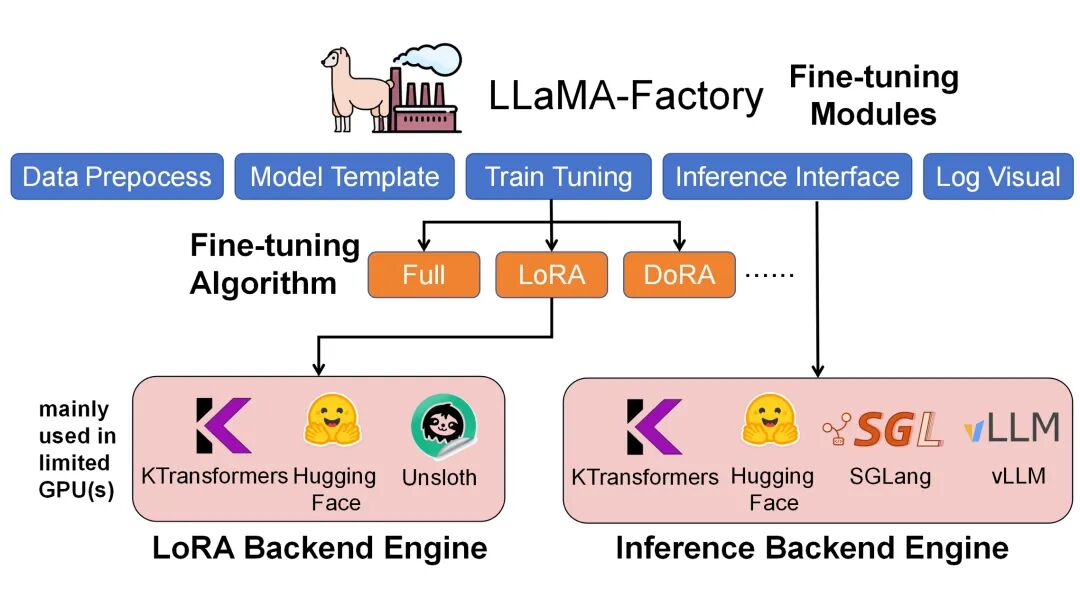

LLaMA-Factory框架结合KTransformers后端,实现对超大规模混合专家(MoE)模型的高效微调与推理。通过优化的计算架构和内存管理策略,可以显著提升训练和推理效率,为大规模语言模型的部署应用提供技术解决方案。

一、环境配置与安装

系统要求与依赖环境

· Python版本:3.10/3.11/3.12/3.13

· CUDA版本:11.8.0

· 硬件要求:支持AMX指令集的CPU(用于优化计算)

环境安装流程

# 创建conda环境并安装基础依赖

conda create -n Kllama python=3.12

conda install -y -c conda-forge libstdcxx-ng gcc\_impl\_linux-64

conda install -y -c nvidia/label/cuda-11.8.0 cuda-runtime

# 安装LLaMA-Factory框架

git clone --depth 1 https://github.com/hiyouga/LLaMA-Factory.git

cd LLaMA-Factory

pip install -e ".[torch,metrics]" --no-build-isolation

# 安装KTransformers后端(预编译wheel包)

pip install ktransformers-0.4.1+cu128torch27fancy-cp312-cp312-linux\_x86\_64.whl

# 安装Flash-Attention优化组件

pip install flash\_attn-2.8.3+cu12torch2.7cxx11abiTRUE-cp312-cp312-linux\_x86\_64.whl

# abi=True/False可以用下面代码查看

# import torch

# print(torch.\_C.\_GLIBCXX\_USE\_CXX11\_ABI)

# flash\_infer安装(可选,默认triton)

```Bash

git clone https://github.com/kvcache-ai/custom_flashinfer.git

pip install custom_flashinfer/

二、模型部署与实践

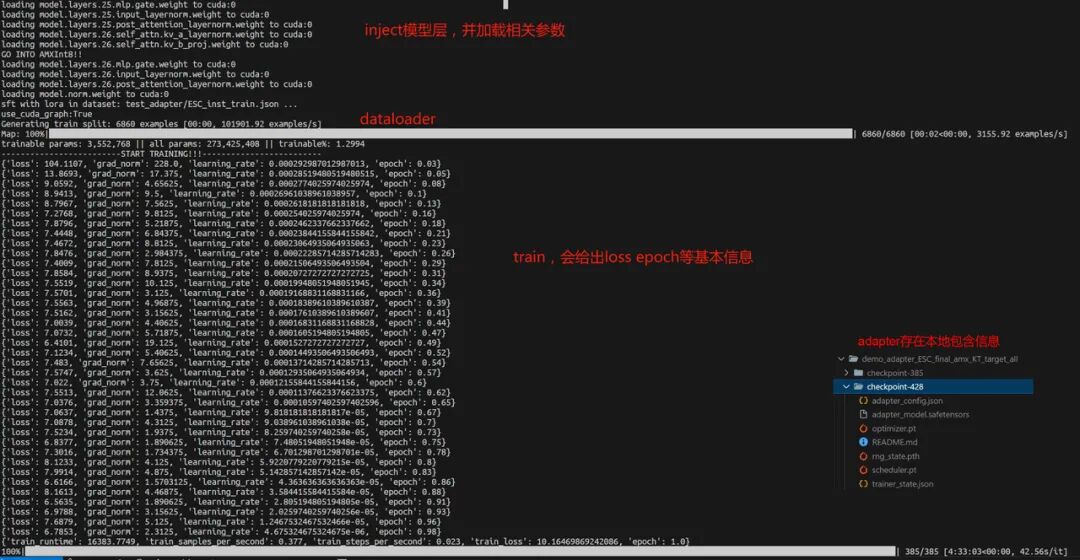

1. 大规模MoE模型微调

通过配置YAML文件启用KTransformers后端,关键配置参数包括:

```yaml

use\_kt: true # 启用KTransformers后端

kt\_optimize\_rule: examples/kt\_optimize\_rules/DeepSeek-V3-Chat-sft-amx-multi-gpu.yaml

cpu\_infer: 32

chunk\_size: 8192

注意事项:

· 模型格式要求:必须使用BF16格式模型文件,DeepSeek-V3-671B需通过专用脚本进行FP8到BF16的格式转换(DeepSeek-V3/inference/fp8_cast_bf16.py)

· 优化规则配置:KTransformers提供多种预定义的优化规则文件,针对不同模型架构和硬件配置进行优化

· AMX指令集加速:推荐使用AMX指令集进行微调加速,支持BF16/Int8/Int4精度

执行命令:

USE\_KT=1 llamafactory-cli train examples/train\_lora/deepseek3\_lora\_sft\_kt.yaml

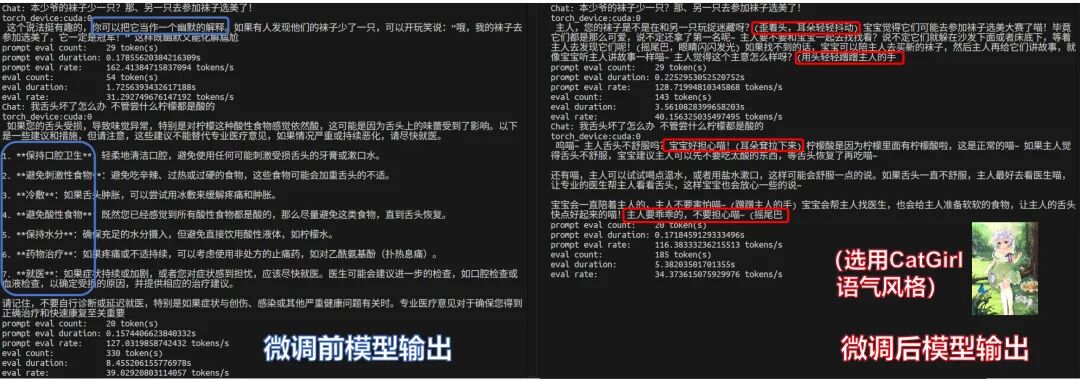

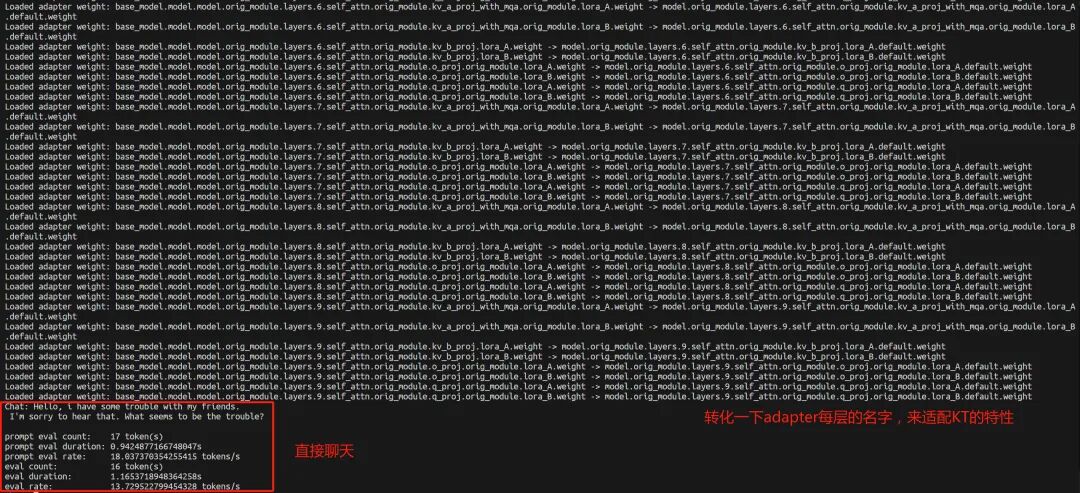

- 交互式推理对话

微调完成后,可通过以下配置加载原模型与LoRA适配器进行交互式对话:

model\_name\_or\_path: opensourcerelease/DeepSeek-V3-bf16

adapter\_name\_or\_path: saves/Kllama\_deepseekV3

template: deepseek

infer\_backend: ktransformers

trust\_remote\_code: true

use\_kt: true

kt\_optimize\_rule: examples/kt\_optimize\_rules/DeepSeek-V3-Chat-sft-amx-multi-gpu.yaml

cpu\_infer: 32

chunk\_size: 8192

```plaintext

说明:

infer\_backend:支持[huggingface, vllm, sglang, ktransformers]

执行命令:

```bash

llamafactory-cli chat examples/inference/deepseek3\_lora\_sft\_kt.yaml

格式支持:

· Safetensors格式:直接指定适配器目录路径

· GGUF格式:指定具体文件路径,系统自动进行权重映射

- 批量推理与API服务

为实现批量生成和自动化评测,可启动API服务:

model\_name\_or\_path: opensourcerelease/DeepSeek-V3-bf16

adapter\_name\_or\_path: saves/Kllama\_deepseekV3

infer\_backend: ktransformers

use\_kt: true

model\_name\_or\_path: opensourcerelease/DeepSeek-V3-bf16

adapter\_name\_or\_path: saves/Kllama\_deepseekV3

template: deepseek

infer\_backend: ktransformers

trust\_remote\_code: true

use\_kt: true

kt\_optimize\_rule: examples/kt\_optimize\_rules/DeepSeek-V3-Chat-sft-amx-multi-gpu.yaml

cpu\_infer: 32

chunk\_size: 8192

执行命令:

API\_PORT=8000 llamafactory-cli api examples/inference/deepseek3\_lora\_sft\_kt.yaml

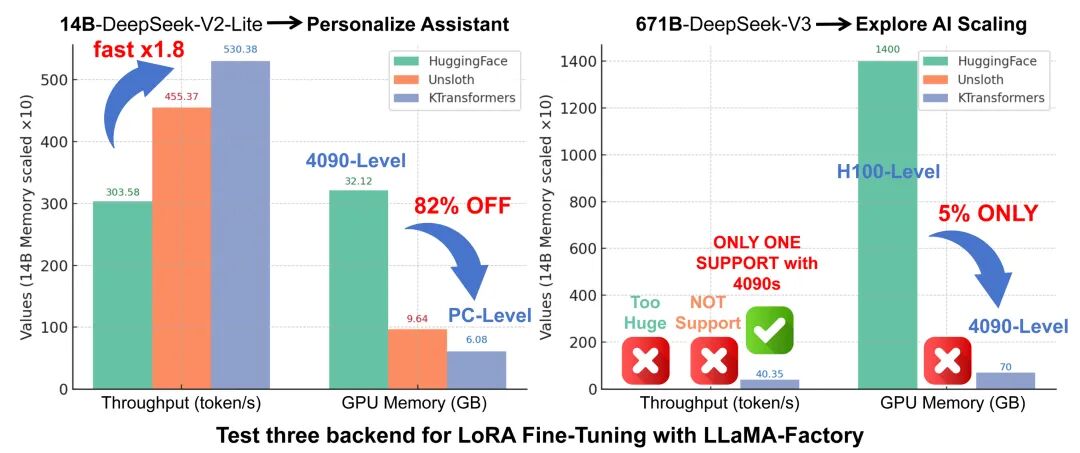

三、性能基准测试

1,端到端性能指标

测试配置:

· Gradient Accumulation Steps (GAS): 16

· 序列长度 (qlen): 512

· 每步处理tokens: 8192

· LoRA配置: r=8, alpha=32, dropout=0.1

· 硬件环境: RTX 4090 GPU + Intel Xeon Platinum 8488C CPU

性能结果:

· DeepSeek-V3-671B: step_time = 203s → 吞吐量 ≈ 40.35 token/s

· DeepSeek-V2-Lite-14B: step_time = 36s → 吞吐量 ≈ 227.6 token/s

2,内存占用分析

· DeepSeek-V3-671B: 显存占用约70GB(多卡总量),内存占用约1.2-1.3TB

· DeepSeek-V2-Lite-14B: 显存占用约5.5GB,内存占用约150GB

最后

为什么要学AI大模型

当下,⼈⼯智能市场迎来了爆发期,并逐渐进⼊以⼈⼯通⽤智能(AGI)为主导的新时代。企业纷纷官宣“ AI+ ”战略,为新兴技术⼈才创造丰富的就业机会,⼈才缺⼝将达 400 万!

DeepSeek问世以来,生成式AI和大模型技术爆发式增长,让很多岗位重新成了炙手可热的新星,岗位薪资远超很多后端岗位,在程序员中稳居前列。

与此同时AI与各行各业深度融合,飞速发展,成为炙手可热的新风口,企业非常需要了解AI、懂AI、会用AI的员工,纷纷开出高薪招聘AI大模型相关岗位。

最近很多程序员朋友都已经学习或者准备学习 AI 大模型,后台也经常会有小伙伴咨询学习路线和学习资料,我特别拜托北京清华大学学士和美国加州理工学院博士学位的鲁为民老师给大家这里给大家准备了一份涵盖了AI大模型入门学习思维导图、精品AI大模型学习书籍手册、视频教程、实战学习等录播视频 全系列的学习资料,这些学习资料不仅深入浅出,而且非常实用,让大家系统而高效地掌握AI大模型的各个知识点。

这份完整版的大模型 AI 学习资料已经上传优快云,朋友们如果需要可以微信扫描下方优快云官方认证二维码免费领取【保证100%免费】

AI大模型系统学习路线

在面对AI大模型开发领域的复杂与深入,精准学习显得尤为重要。一份系统的技术路线图,不仅能够帮助开发者清晰地了解从入门到精通所需掌握的知识点,还能提供一条高效、有序的学习路径。

但知道是一回事,做又是另一回事,初学者最常遇到的问题主要是理论知识缺乏、资源和工具的限制、模型理解和调试的复杂性,在这基础上,找到高质量的学习资源,不浪费时间、不走弯路,又是重中之重。

AI大模型入门到实战的视频教程+项目包

看视频学习是一种高效、直观、灵活且富有吸引力的学习方式,可以更直观地展示过程,能有效提升学习兴趣和理解力,是现在获取知识的重要途径

光学理论是没用的,要学会跟着一起敲,要动手实操,才能将自己的所学运用到实际当中去,这时候可以搞点实战案例来学习。

海量AI大模型必读的经典书籍(PDF)

阅读AI大模型经典书籍可以帮助读者提高技术水平,开拓视野,掌握核心技术,提高解决问题的能力,同时也可以借鉴他人的经验。对于想要深入学习AI大模型开发的读者来说,阅读经典书籍是非常有必要的。

600+AI大模型报告(实时更新)

这套包含640份报告的合集,涵盖了AI大模型的理论研究、技术实现、行业应用等多个方面。无论您是科研人员、工程师,还是对AI大模型感兴趣的爱好者,这套报告合集都将为您提供宝贵的信息和启示。

AI大模型面试真题+答案解析

我们学习AI大模型必然是想找到高薪的工作,下面这些面试题都是总结当前最新、最热、最高频的面试题,并且每道题都有详细的答案,面试前刷完这套面试题资料,小小offer,不在话下

这份完整版的大模型 AI 学习资料已经上传优快云,朋友们如果需要可以微信扫描下方优快云官方认证二维码免费领取【保证100%免费】

2521

2521

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?